热门标签

热门文章

- 1ZYNQ第六章-PS与PL数据交互第一篇_zynq ps与pl之间传输

- 2python 读取图像(cv2,PIL,subplot)_python cv2读取图片

- 3【Effective Objective - C】—— 熟悉Objective-C_effective objective-c

- 4线性表链表表相关习题及详解(选择题) ——数据结构_线性表的链式存储选择相关例题

- 5「优选算法刷题」:二分查找

- 6ddos攻击原理_golang 正向代理 伪造来源

- 72024年安卓最全Android 串口开发(一) 串口读写操作,2024年最新java jvm面试

- 8STM32下的FreeRTOS任务程序_基于freertos的stm32项目

- 9零基础小白如何入门HarmonyOS鸿蒙应用开发学习?_纯血harmony学习(1)_鸿蒙开发自学

- 10java Web学习笔记(二)

当前位置: article > 正文

【JetsonNano】onnxruntime-gpu 环境编译和安装,支持 Python 和 C++ 开发_onnxruntime linux gpu c++

作者:码创造者 | 2024-07-19 07:05:32

赞

踩

onnxruntime linux gpu c++

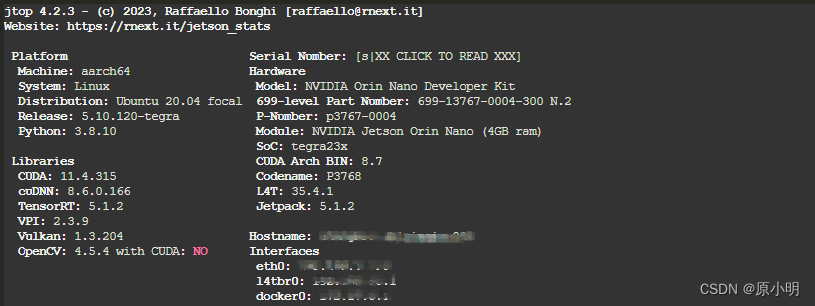

1. 设备

2. 环境

sudo apt-get install protobuf-compiler libprotoc-dev

export PATH=/usr/local/cuda/bin:${PATH}

export CUDA_PATH=/usr/local/cuda

export cuDNN_PATH=/usr/lib/aarch64-linux-gnu

export CMAKE_ARGS="-DONNX_CUSTOM_PROTOC_EXECUTABLE=/usr/bin/protoc"

- 1

- 2

- 3

- 4

- 5

- 6

3.源码

mkdir /code

cd /code

git clone --recursive https://github.com/Microsoft/onnxruntime.git

# 从 tag v1.16.0 切换分支进行编译

git checkout -b v1.16.0 v1.16.0

git submodule update --init --recursive --progress

cd /code/onnxruntime

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

4.编译

# --parallel 2 使用 2 个 cpu 进行编译,防止内存和CPU性能不足导致编译识别

./build.sh --config Release --update --build --parallel 2 --build_wheel \

--use_tensorrt --cuda_home /usr/local/cuda --cudnn_home /usr/lib/aarch64-linux-gnu \

--tensorrt_home /usr/lib/aarch64-linux-gnu

- 1

- 2

- 3

- 4

若编译识别,内存不足,可进行扩大交换内存

https://labelnet.blog.csdn.net/article/details/136538479

编译完成标识

...

build complate!

- 1

- 2

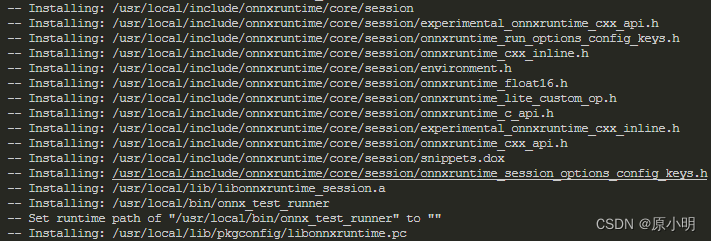

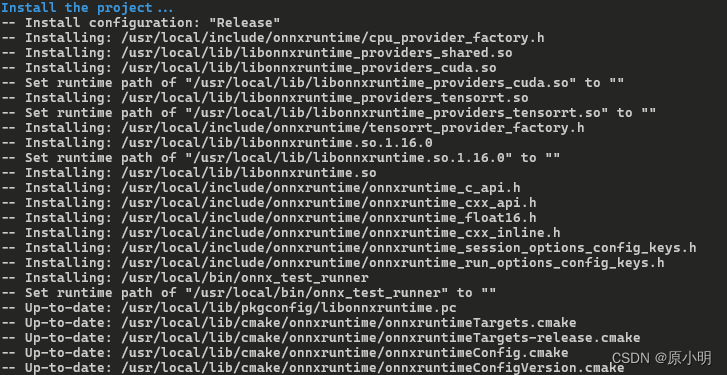

5. 安装

cd /build/Linux/Release

sudo make install

- 1

- 2

6.查看

/usr/lcoal 查看安装

- 1

7.下载

(1) 整个 build 目录,包含 build/Linux/Relase

https://download.csdn.net/download/LABLENET/88943160

(2) 仅 Python3.8 安装文件,onnxruntime-gpu-1.16.0-cp38-cp38-linux-aarch64.whl

https://download.csdn.net/download/LABLENET/88943155

8. 静态库编译安装

1)编译

添加 l --build_shared_lib

./build.sh --config Release --update --build --parallel --build_shared_lib --build_wheel \

--use_tensorrt --cuda_home /usr/local/cuda --cudnn_home /usr/lib/aarch64-linux-gnu \

--tensorrt_home /usr/lib/aarch64-linux-gnu

- 1

- 2

- 3

2)安装

sudo cmake install

- 1

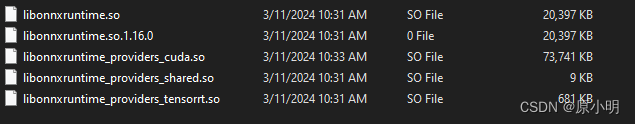

9. 静态库下载使用

C++, 见文件 https://download.csdn.net/download/LABLENET/88943411

10 C++ 开发

CMakeList.txt 中配置使用

...

# onnxruntime

find_package(onnxruntime REQUIRED)

message(onnxruntime_dir: ${onnxruntime_DIR})

target_link_libraries (

${MODULE_NAME} PUBLIC

onnxruntime::onnxruntime

)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

C++ 代码

#include <onnxruntime_cxx_api.h>

int main()

{

auto providers = Ort::GetAvailableProviders();

cout << Ort::GetVersionString() << endl;

for (auto provider : providers)

{

cout << provider << endl;

}

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

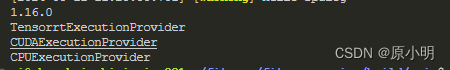

11. Python 开发

安装依赖包

pip3 install onnxruntime_gpu-1.16.0-cp38-cp38-linux_aarch64.whl -i https://pypi.tuna.tsinghua.edu.cn/simple/

- 1

开发

import onnxruntime

print("OnnxRuntime Provider : ", onnxruntime.get_available_providers())

- 1

- 2

- 3

- 4

输出

OnnxRuntime Provider : ['TensorrtExecutionProvider', 'CUDAExecutionProvider', 'CPUExecutionProvider']

- 1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/码创造者/article/detail/850035

推荐阅读

相关标签