- 1Java中高级核心知识_java高级包括哪些知识

- 2无人机侦察:无人机雷达探测设备技术详解_ku波段雷达探测无人机器的作用

- 3android14 录屏权限改动_android 录屏权限

- 4硬件安全模块 (HSM)、硬件安全引擎 (HSE) 和安全硬件扩展 (SHE)的区别_hse硬件安全扩展

- 5UWP与WPF:微软两大UI框架_uwp wpf

- 6细说PyCharm的安装和配置_pycharm专业版2024打开的页面不一样

- 7Git与Github两者区别_git 和git hub的区别

- 82024年Python最全python模块pymysql对数据库进行增删改查_python操作数据库实现增删改查

- 9ElasticSearch---es之Post Filter,聚合后过滤_es的aggs后再过滤

- 10ES过滤总结_es 过滤

Ollama在Windows11部署与使用QWen2模型_ollama在windows11上部署qwen2 webui

赞

踩

0,Ollama介绍

Ollama是一个开源项目,旨在让用户能够轻松地在其本地计算机上运行大型语言模型(LLM),是一个开源的大型语言模型服务。它支持各种LLM,包括Llama 3、Mistral和Gemma。提供了类似OpenAI的API接口和聊天界面,可以非常方便地部署最新版本的GPT模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

Ollama官网:https://ollama.com/

模型库:https://ollama.com/library

GIthub地址:https://github.com/ollama/ollama

1,下载与安装

访问Ollama官网,点击【Download】按钮进入下载页面,选择Windows版本下载

下载后直接运行安装包,进行安装

软件本身是没有图形化界面的,需要用终端运行,以Windows PowerShell为例,运行下面的指令进行测试

ollama list

其他常用命令:

- ollama serve 启动ollama

- ollama create 从模型文件创建模型

- ollama show 显示模型信息

- ollama run 运行模型

- ollama pull 从注册表中拉取模型

- ollama push 将模型推送到注册表

- ollama list 列出模型

- ollama cp 复制模型

- ollama rm 删除模型

- ollama help 获取有关任何命令的帮助信息

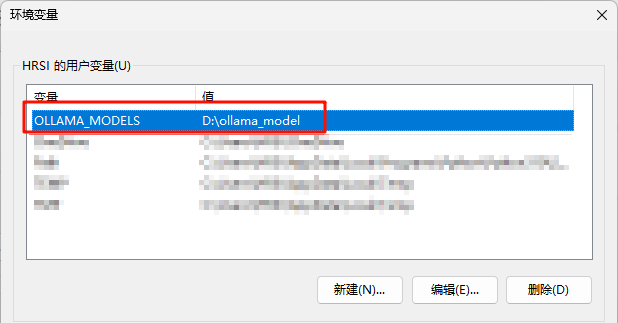

2,更改模型保存路径

默认的模型保存路径位于C盘,(C:\Users<username>.ollama\models),可以通过设置OLLAMA_MODELS进行修改,然后重启终端,重启ollama服务(需要去状态栏里关掉程序)

setx OLLAMA_MODELS "D:\ollama_model"

我们可以去电脑环境变量中查看是否改变成功

3,下载大模型

访问模型库,找到需要的模型,比如我打算使用qwen2,点进去可以选择参数量,以及查看模型介绍

比如我要下载qwen2的0.5B参数模型,在终端运行

ollama run qwen2:0.5b即可自动开始下载和加载

4,测试模型

直接在终端交流

至此,在Windows本地部署Ollama并运行qwen2模型已经完成,如果需要Web或者客户端支持,可以查看GitHub里的推荐

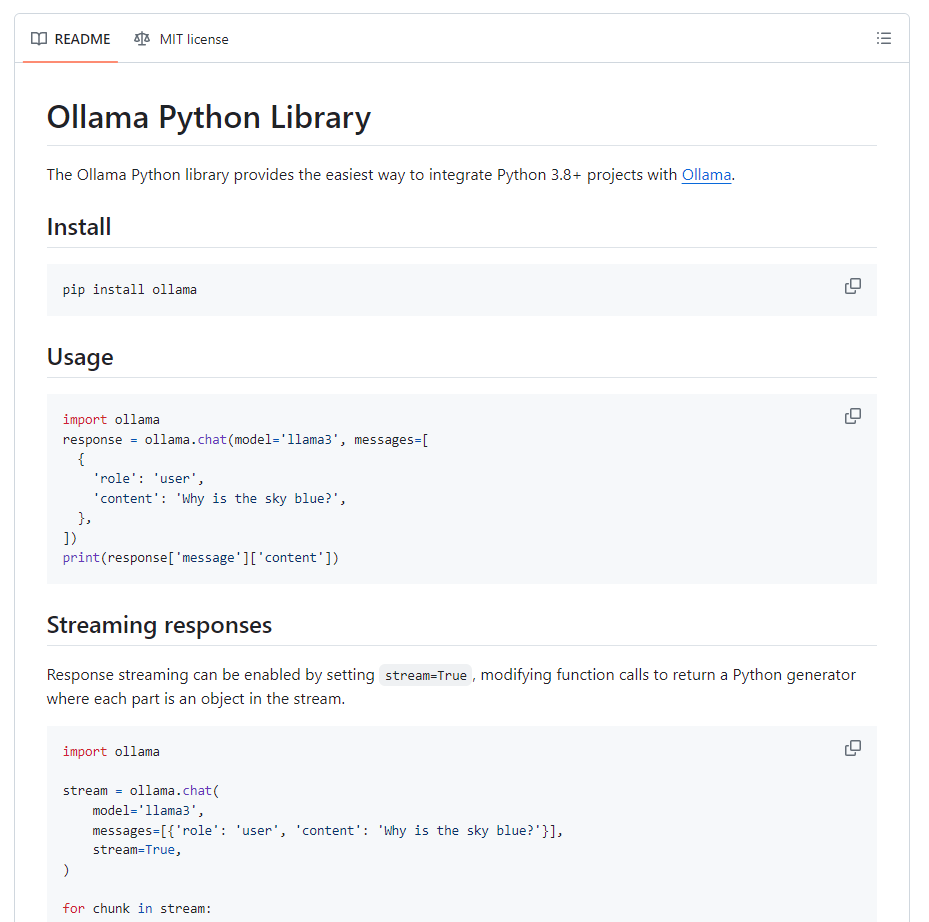

5,Ollama Python库

访问GitHub:GitHub - ollama/ollama-python: Ollama Python library

有详细的教程,关于如何用Python调用本地的Ollama