2024 年值得关注的 9 个最佳开源大语言模型

赞

踩

一、简述

开源模型在提供创新方面发挥着至关重要的作用,同时为开发人员、爱好者和开发人员提供了深入研究其复杂之处并对其进行微调以执行特定任务的机会。

我们将探讨一些正在开拓新市场前景并带来其独特能力和优势的顶级开源 LLM。

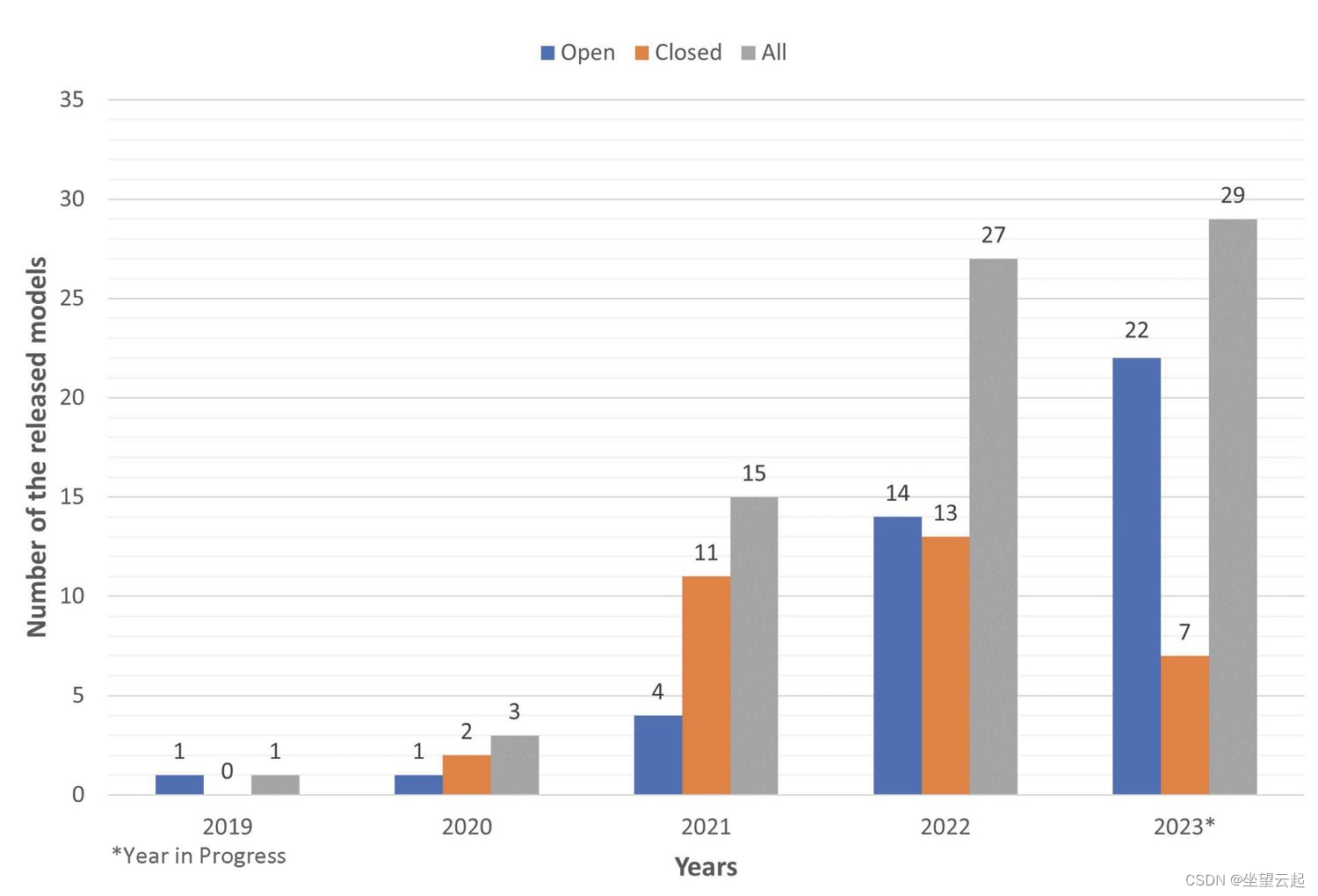

二、开源模型清单

1.GPT-NeoX-20B

GPT—NeoX-20B 是 EleutherAI 开发的开源大型语言模型。除了少数显著例外,其架构基本遵循 GPT-3,使其成为一个自回归 Transformer 解码器模型。

它使用 GPT-NeoX 库进行训练,使用来自 The Eye 托管的 800GB 开源数据集 The Pile 的信息。

GPT-NeoX-20B 是适合需要生成高级内容的中型或大型企业(如营销机构和媒体公司)的完美模型。

该模型已对 200 亿个参数进行了训练,正如其名称中的“20B”所示。由于参数数量庞大,该模型可以理解和生成高度复杂和细微的文本。

由于其完全开源的特性以及与同等质量和尺寸的同类模型相比更低的拥有成本,GPT-NeoX-20B 更易于研究人员、技术创始人和开发人员使用。

主要特点

- 在性能调整的基础上,GPT-NeoX-20B 的实施成本比 GPT-3 更低。

- GPT-NeoX-20B 模型属于 GPT 系列,以其复杂的自然语言处理能力而闻名。

- 用户可以调整模型来生成符合特定规范或风格偏好的文本输出。

- 该模型利用上下文信息来生成连贯且与上下文相关的文本。

- GPT-NeoX-20B 在情感分析、文本分类、问答和语言翻译等自然语言任务方面表现出色。

- GPT-NeoX-20B 兼容各种编程语言和框架,可轻松集成到项目中。

2.GPT-J-6b

EleutherAI 还开发了 GPT-J-6b 模型。这是一个生成式预训练 Transformer 模型,可创建类似人类的提示文本。它使用具有 60 亿个可训练参数的 GPT-J 模型。

然而,该模型不适合翻译或生成非英语语言的文本,因为它是专门针对英语数据进行训练的。

GPT-J-6b 体积相对较小,使用简单,是寻求资源消耗和性能之间适当平衡的初创企业和中型企业的完美选择。

主要特点

- GPT-J-6B 擅长自然语言理解,可以执行文本分类、情感分析、问答和语言翻译等任务。

- 由于 GPT-J-6B 与各种编程语言和框架兼容,因此将其集成到项目中非常容易。

- 与其他语言模型一样,GPT-J-6B 能够根据提示生成文本。

- GPT-J-6B 使用序列到序列训练来根据先前的序列生成文本。

3. LLaMA 2

LLaMA 2 是 Large Language Model Meta AI 的缩写,是微软与 Meta AI 联合开发的先进 AI 模型。

LLaMA 2 还可以通过理解图像来理解和生成文本,因此非常适合多模态任务。该 LLM 有三种不同的大小,分别针对 70 亿、130 亿和 700 亿个参数进行了训练。

它是在各种图像数据和有趣的文本上进行训练的,其架构融合了 LLaMA 1 的概念。

对于想要利用广泛语言模型的教育开发人员和研究人员来说,LLaMA 2 是一个绝佳的选择。它可以在消费级计算机上运行。

主要特点

- LLaMA 2 能够熟练地理解上下文中的对话细微差别,从而提供准确的回答。

- 该模型可以根据用户的喜好调整其风格和基调。

- LLaMA 2 针对不同主题提供了经过深入研究的见解,并通过轻松获取多样化资源丰富了互动。

- 该模型将文本与其他媒体无缝集成,以跨多种模式描述、解释和创建内容。

- LLM 通过最大限度地减少有害或有偏见的输出来促进安全的内容开发。

4.Bard Nano

谷歌开发了Bard Nano LLM,该模型重量轻,在本地设备上运行,适合边缘计算场景。

谷歌的人工智能聊天机器人 Bard 最初于 2023 年发布,但在 2024 年更名为 Gemini,可能是为了转移人们对其绰号的注意力并将重点放在 Gemini (LLM) 的成功上。

Bard Nano 使用深度学习算法来理解和创建自然语言。该模型可以在各种文本数据上进行训练。

Bard nano 包含针对多种语言的预训练模型,并且可以轻松针对特定任务进行微调。该模型可用于各种应用,例如语音助手、翻译工具和聊天机器人。

主要特点

- Gemini-Bard 集成的一个显著增强是,它允许 Bard 更清楚地理解用户意图,从而产生更高质量、更准确的响应。

- 由于 Gemini 的多模式性,Bard 可以轻松处理所有类型的媒体,包括音频、视频和图像,从而提升了用户体验。

- 由于 Gemini 与 Bard 的整合,未来人机交互将会更加丰富和细致入微。

5. Mistral

Mistral AI 是一个基础模型,使用定制技术进行数据处理、训练和调整。它是一种高性能、高效的开源模型,可根据 Apache 2.0 许可证在实际应用中使用。

其基础是Transformer架构,一种擅长机器翻译和文本摘要的神经网络。

该模型在数学、推理和代码生成等各种基准上都表现出色。

Mistral 提供了几种模型,并附有完全许可的免费使用许可。最复杂的是 Mistral 7B 变压器模型、Mistral 8x7B 开放模型,以及一个较小的英语版本,内容容量为 8K。

Mistral AI 非常适合寻求卓越能力和更高 LLM 效率的初创企业和中型企业。

主要特点

- 它以对话风格提供最新、准确的信息而闻名,这使其成为保持内容准确性和质量的重要工具。

- 其先进的人工智能模型使用户能够解决复杂的挑战。

- Mistral AI 的突出特点之一是它为用户提供更高程度的定制化。

- Mistral AI 是克服语言障碍和促进不同语言交流的有益工具。

- Mistral AI 能够通过使用智能聊天机器人来改善和简化互动。

6.MPT-7B

MPT-7B 是 MosaicML 预训练变压器模型,是一种 GPT 风格的、仅用于解码器的变压器模型。该模型提供了架构修改,可提高训练稳定性,并针对性能进行了优化。

MPT-7B 是一款适用于商业应用的开源工具。它可以对预测分析以及企业和组织的决策程序产生重大影响。

主要特点

- 由于它拥有商业许可证,因此对于公司来说它是一个非常宝贵的工具。

- 该模型拥有一万亿个标记,拥有庞大的训练数据集。

- 快速训练和推理是该模型的关键特征,可保证快速输出。

- MPT-7B 的质量可与 LLaMA-7B 相媲美,并且已被证明优于 7B-20B 系列中的其他开源模型。

- MPT-7B的开源训练代码有效、透明,更易于使用。

- MPT-7B 旨在处理极长的输入,同时不影响性能。

7. BLOOM

BLOOM 拥有令人印象深刻的 1760亿 个参数,是一个仅限于解码器的转换 LLM。它可以调整以执行特定任务,例如摘要、文本创建、语义搜索、分类和嵌入。最初,它被设计用于根据提示生成文本。

该模型的训练集包含 46 种不同语言的数百个来源,这使其成为多语言输出和语言翻译的绝佳选择。

BLOOM LLM 非常适合面向需要多语言支持的全球受众的大型企业。

8.OPT-175B

OPT-175B 是 Meta AI 研究创建的第一个具有 1750 亿个参数的 LLM。

使用 1800 亿个标记的数据集,该 LLM 在训练期间所需的碳足迹仅为 GPT-3 的 1/7,并且表现出与 GPT-3 相当的性能。

主要特点

- 安全功能是 OPT-175B 不可或缺的一部分,可确保安全、无风险的操作。

- 由于体积小,OPT-175B 易于在不同环境中安装和操作。

- OPT-175B 的坚固结构即使在苛刻的环境下也能保证可靠性和耐用性。

- 它利用尖端技术来保证平稳高效的运行,从而跟上行业的最新创新。

- 该模型旨在捕捉 GPT-3 类模型的性能和规模。

9.XGen-7B

XGen-7B LLM 模型包含 70 亿个参数,这意味着它是一个大型模型。具有更多参数的模型(例如具有 130 亿个标记的模型)需要高端 CPU、GPU、RAM 和存储空间。

XGen-7 B 的主要功能之一是其 8K 上下文窗口。更大的上下文窗口意味着您可以在从模型生成输出时提供更多上下文。

这允许更长的响应。8K 上下文窗口是您提供给模型的输入和输出文本的总大小。

主要特点

- XGen-7B 具有大规模多任务语言理解功能,可以回答不同领域的多项选择题。

- XGen-7B 最多可处理 8,000 个令牌,非常适合需要更深入地理解较长叙述的任务。

- 该模型已经在包括教学内容在内的多种数据集上进行了训练,从而提供了对教学的细致入微的理解。

三、如何选择开源 LLM?

1.成本

成本是需要考虑的最重要的因素之一。由于 LLM 是开放的,你不必为模型本身付费,但你需要考虑与之相关的其他成本,例如所需的资源、托管和培训。所选的 LLM 越复杂,花费就越大。

2. 性能

LLM 的表现以连贯性、上下文理解和语言流畅性等参数来衡量。因此,如果这些参数表现良好,那么所选的 LLM 将会更好、更有效。

3.准确性

评估准确性是关键因素之一。您必须比较不同的 LLM 以了解它们需要执行的任务,并根据准确性评估选择一个。

4. 通用与特定任务

在决定之前,请分析您是否需要仅解决特定用例的 LLM 或涵盖全面任务范围的 LLM。

5.数据安全

数据安全是关键方面之一。在评估这一点时,RAG 会很有用,因为它允许您使用文档级安全性控制数据访问,并将权限限制到特定数据。

6.训练数据质量

确实,如果训练数据的质量受到影响,结果也会受到影响。因此,需要评估每个 LLM 使用的数据,并选择具有良好数据训练质量的数据。