热门标签

热门文章

- 1vue3+vite+axios:解决跨域问题_vue3.0 vite跨域代理axios无法替换主路径

- 2“深入探讨Java中的对象拷贝:浅拷贝与深拷贝的差异与应用“_深拷贝和浅拷贝的应用场景 java

- 3同步gitee和github_github page无法同步gitee page

- 4顺序主子式

- 5使用eve-ng模拟器进入山石防火墙的web界面_eve默认账号密码

- 6【数据结构】二叉树(C语言)

- 7python封装前端接口_Python实现封装打包自己写的代码,被python import

- 8(4)jenkins配置gitee令牌详细操作_jenkins使用令牌连接gitee

- 9C++ Reference: Standard C++ Library reference: Containers: queue: queue: emplace_queue c++ referece

- 10Python 微信自动化工具开发系列04_所有微信群的群文件自动同步拷贝到群名对应的新文件夹中(2024年2月可用 支持3.9最新微信)_wxauto

当前位置: article > 正文

Transformer模型-权重矩阵Wq,Wk,Wv的简明介绍_transformer权重矩阵

作者:空白诗007 | 2024-06-27 16:51:39

赞

踩

transformer权重矩阵

背景:

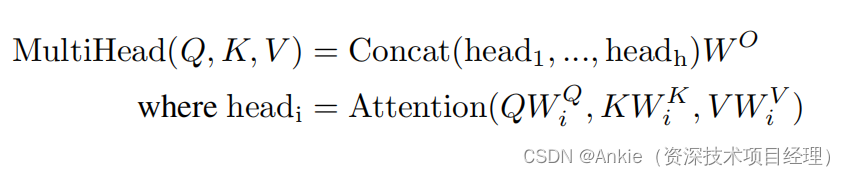

学习transformer模型,计算multiHead attention的时候,权重矩阵Wq,Wk,Wv给我造成了很大的困扰:

1,为啥要需要W*?

2,这个W*是从哪里来的?

结论:

搜索了各种信息,消化理解如下:

1,W*权重矩阵就是训练的目的,就是要找到合适的W*(weights)。

2,W* 是函数nn.Linear初始化的,默认为随机数。经过不断地训练,更新,最终获得比较好的结果

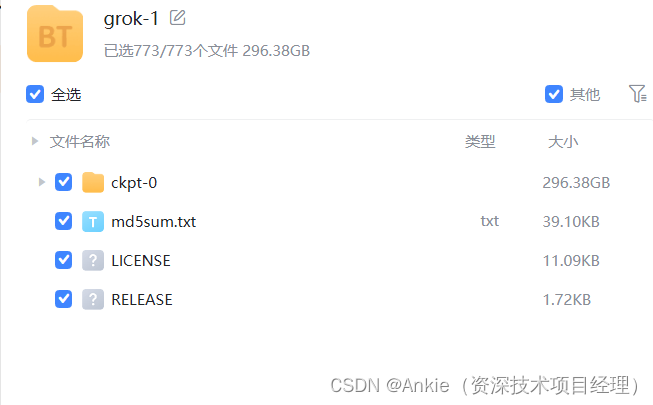

举例:300G的权重weights文件

还记得马斯克的Grok-1吗?那个权重weights文件300G。

完整计算Multi-Head attention图示

训练W*过程举例:

在PyTorch中,训练一个包含nn.Linear层的神经网络涉及几个关键步骤。以下是一个基本的训练流程:

1. 定义模型结构

首先,你需要定义你的神经网络模型,这包括使用nn.Linear来创建全连接层。

import torch | |

import torch.nn as nn | |

class MyModel(nn.Module): | |

def __init__(self, input_size, hidden_size, output_size): | |

super(MyModel, self).__init__() | |

self.fc1 = nn.Linear(input_size, hidden_size) # 第一个全连接层 | |

self.relu = nn.ReLU() # 激活函数 | |

self.fc2 = nn.Linear(hidden_size, output_size) # 第二个全连接层(输出层) | |

def forward(self, x): | |

x = self.fc1(x) | |

x = self.relu(x) | |

x = self.fc2(x) | |

return x | |

# 实例化模型 | |

input_size = 784 # 假设输入是28x28的图像,展平后为784维 | |

hidden_size = 128 # 隐藏层的大小 | |

output_size = 10 # 假设有10个分类 | |

model = MyModel(input_size, hidden_size, output_size) |

2. 定义损失函数和优化器

接下来,你需要选择一个合适的损失函数和优化器。损失函数用于衡量模型预测与真实标签之间的差异,而优化器则用于根据损失函数的梯度更新模型的权重。

criterion = nn.CrossEntropyLoss() # 多分类问题常用的损失函数 | |

optimizer = torch.optim.Adam(model.parameters(), lr=0.001) # 使用Adam优化器,学习率设为0.001 |

3. 准备数据集

你需要准备训练数据集和验证数据集(如果有的话)。这些数据集应该被转换为PyTorch张量,并且通常会被划分为小批量以便进行迭代训练。

# 假设你已经有了训练数据和标签 | |

train_data = ... | |

train_labels = ... | |

# 转换为张量 | |

train_data = torch.tensor(train_data, dtype=torch.float32) | |

train_labels = torch.tensor(train_labels, dtype=torch.long) |

4. 训练循环

现在你可以开始训练循环了。在每个epoch中,你会遍历整个数据集(或其一个子集),进行前向传播、计算损失、反向传播和参数更新。

num_epochs = 10 # 训练轮数 | |

for epoch in range(num_epochs): | |

# 将梯度清零,否则梯度会累积 | |

optimizer.zero_grad() | |

# 前向传播 | |

outputs = model(train_data) | |

# 计算损失 | |

loss = criterion(outputs, train_labels) | |

# 反向传播 | |

loss.backward() | |

# 更新参数 | |

optimizer.step() | |

# 打印统计信息(可选) | |

if (epoch+1) % 10 == 0: | |

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}') |

5. 验证和测试

在训练过程中或训练结束后,你可能还希望验证模型的性能。这通常通过在验证集或测试集上运行模型并计算相关指标(如准确率)来完成。

# 假设你也有一个验证集 | |

val_data = ... | |

val_labels = ... | |

# 转换为张量 | |

val_data = torch.tensor(val_data, dtype=torch.float32) | |

val_labels = torch.tensor(val_labels, dtype=torch.long) | |

# 不需要计算梯度 | |

with torch.no_grad(): | |

val_outputs = model(val_data) | |

val_loss = criterion(val_outputs, val_labels) | |

_, predicted = torch.max(val_outputs, 1) | |

correct = (predicted == val_labels).sum().item() | |

accuracy = correct / val_labels.size(0) | |

print(f'Validation Loss: {val_loss.item():.4f}, Accuracy: {accuracy:.4f}') |

这就是训练包含nn.Linear层的神经网络的基本流程。在实际应用中,你可能还需要添加其他组件,如数据加载器、学习率调度器、模型保存

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/空白诗007/article/detail/763102

推荐阅读

相关标签