热门标签

热门文章

- 1Kafka:什么是kafka? ①_kafka kafka

- 2【Redis篇】什么是缓存雪崩、缓存穿透、缓存击穿?如何解决?_什么是缓存穿透,什么是缓存雪崩,如何防止

- 3深度学习环境搭建(pytorch环境)适用于win10/11系统下_pytorch环境搭建

- 4python从小白到大师-第一章Python应用(七)应用领域与常见包-自动化办公PPT

- 5鸿蒙开源!OpenHarmony——手机的CPU信息应用

- 6keras开发文档 4:内置方法的训练和评估_(x_train, y_train), (x_test, y_test), min_pixel_va

- 7matlab 时延,求助 怎么加时延

- 8python加速方法:纯CPU多进程加速(joblib库)_joblib可以加速吗

- 9SQL盲注篇之布尔盲注_sql布尔盲注

- 10网络安全应急响应(文末附应急工具)_网络安全应急响应方法论

当前位置: article > 正文

LangChain 本地化方案 - 使用 ChatYuan-large-v2 作为 LLM 大语言模型_langchain加载本地llm

作者:笔触狂放9 | 2024-02-17 05:24:25

赞

踩

langchain加载本地llm

一、ChatYuan-large-v2 模型

ChatYuan-large-v2是一个开源的支持中英双语的功能型对话语言大模型,与其他 LLM 不同的是模型十分轻量化,并且在轻量化的同时效果相对还不错,仅仅通过0.7B参数量就可以实现10B模型的基础效果,正是其如此的轻量级,使其可以在普通显卡、 CPU、甚至手机上进行推理,而且 INT4 量化后的最低只需 400M 。

v2 版本相对于以前的 v1 版本,是使用了相同的技术方案,但在指令微调、人类反馈强化学习、思维链等方面进行了优化,主要优化点如下所示:

- 增强了基础能力。原有上下文问答、创意性写作能力明显提升。

- 新增了拒答能力。对于一些危险、有害的问题,学会了拒答处理。

- 新增了代码生成功能。对于基础代码生成进行了一定程度优化。

- 新增了表格生成功能。使生成的表格内容和格式更适配。

- 增强了基础数学运算能力。

- 最大长度

token数从1024扩展到4096。 - 增强了模拟情景能力。

- 新增了中英双语对话能力。

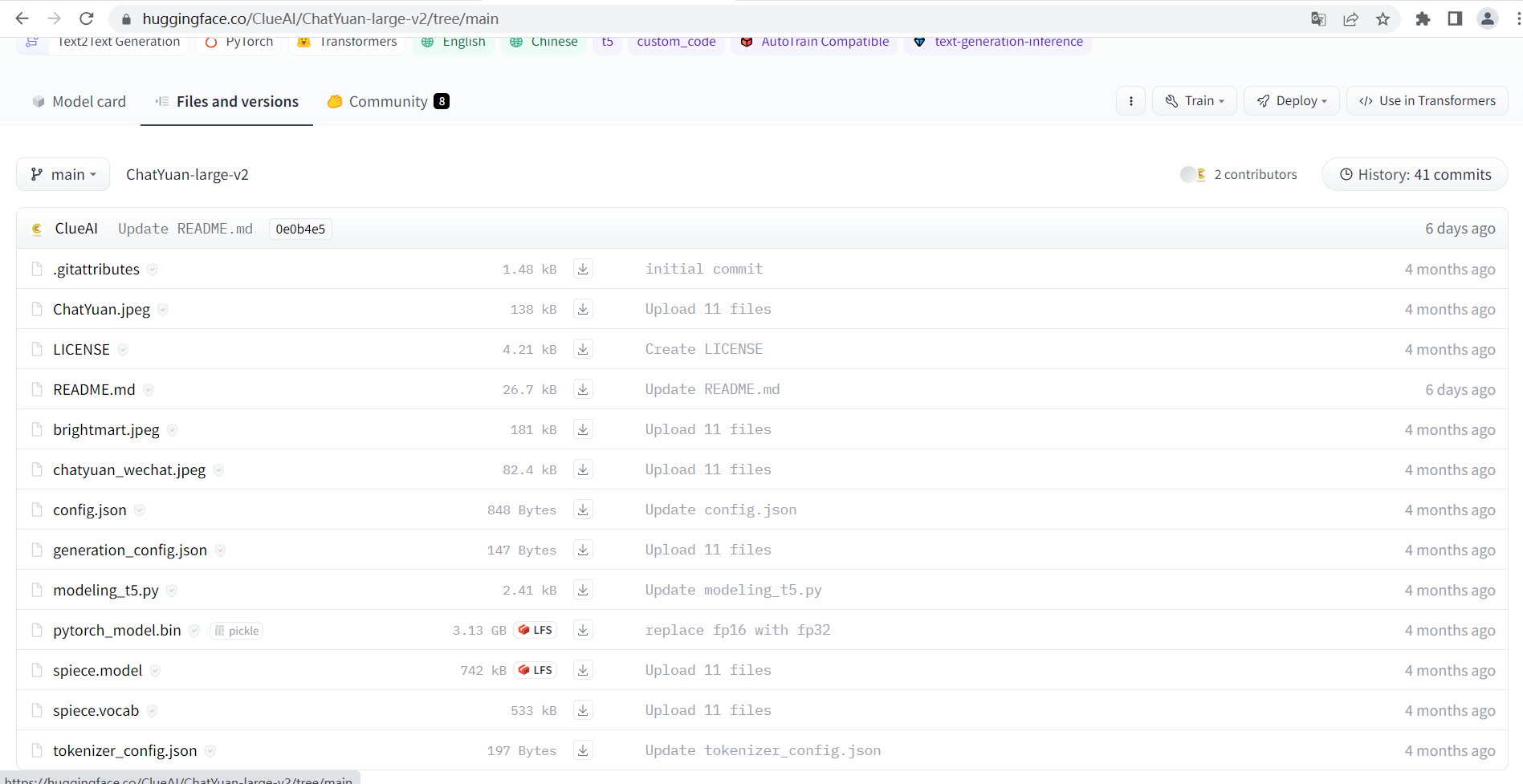

ChatYuan-large-v2 模型已经发布到了 huggingface 中:

开源项目地址:

二、AutoModel 调用示例

由于ChatYuan-large-v2 已经发布到 huggingface 中 ,因此在可以先使用 transformers 中的 AutoTokenizer 和 AutoModel 进行调用体验。

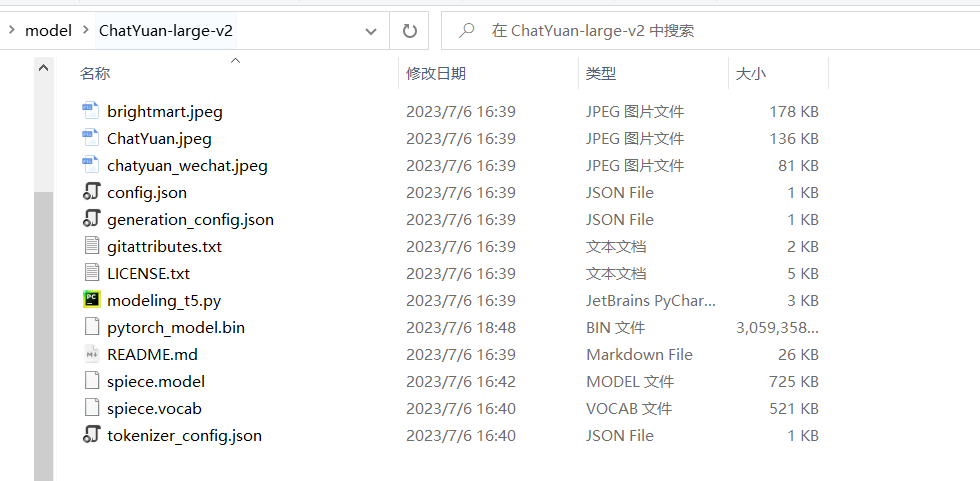

首先将下面链接中的文件下载到本地磁盘中:

调用实例:

# -*- coding: utf-8 -*-

from transformers import AutoTokenizer, AutoModel

import os

# 这里是模型下载的位置

model_dir = 'D:\\AIGC\\model\\ChatYuan-large-v2'

tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

model = AutoModel.from_pretrained(model_dir, trust_remote_code=True)

history = []

while True:

query = input("\n用户:")

if query == "stop":

break

if query == "clear":

history = []

os.system('clear')

continue

response, history = model.chat(tokenizer, query, history=history)

print(f"小元:{response}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

测试:

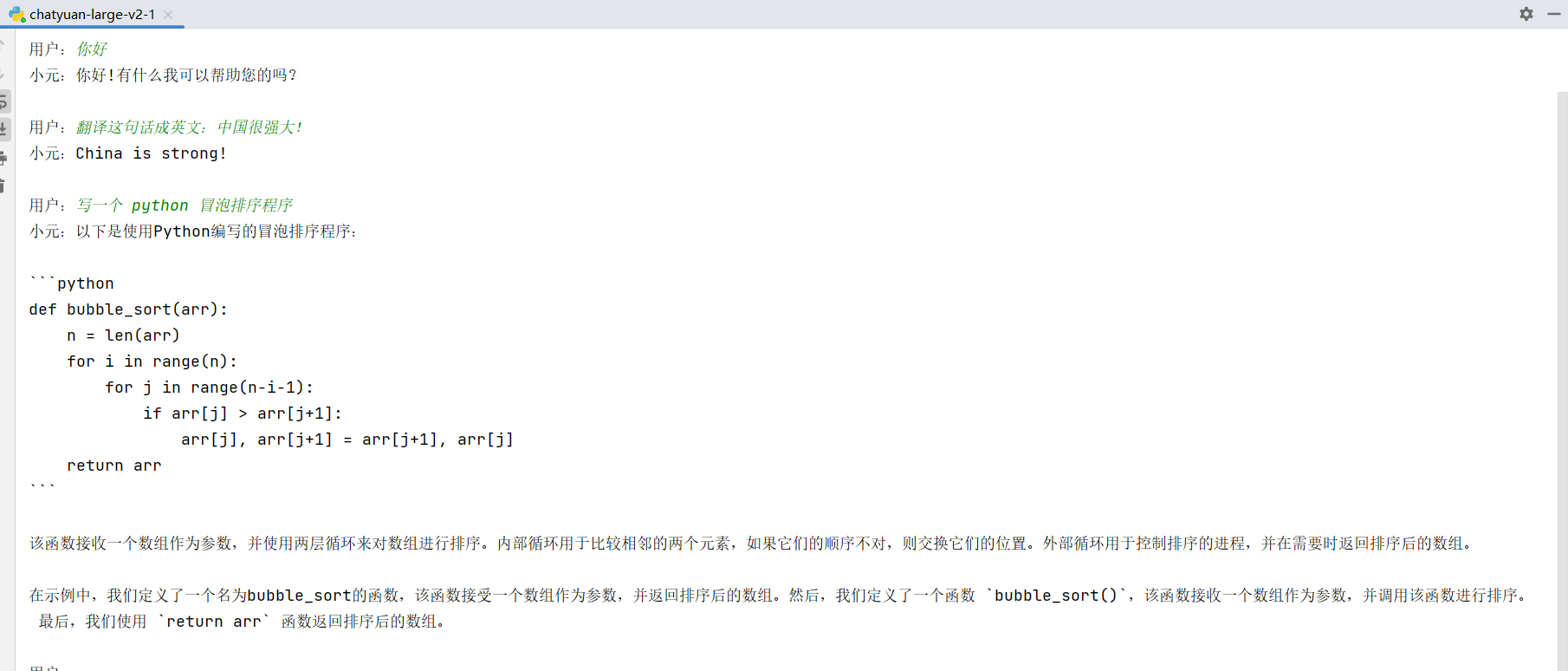

从上面的演示可以看到一些常见的对话都是OK的,也可以为我们写一些代码,下面将上面的程序转化为 Langchain 中的 LLM 进行使用。

三、LangChain 集成

在 LangChain 中为我们提供了一个 HuggingFacePipeline 工具,可以轻松的将 HuggingFace 中的 pipeline 转为 langchain 中的 LLM,下面是调用实例:

# -*- coding: utf-8 -*-

from transformers import AutoTokenizer, AutoModel, pipeline

from langchain import HuggingFacePipeline

from langchain import PromptTemplate

import os

model_dir = 'D:\\AIGC\\model\\ChatYuan-large-v2'

tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

model = AutoModel.from_pretrained(model_dir, trust_remote_code=True)

pipe = pipeline(

"text2text-generation",

model=model,

tokenizer=tokenizer,

max_length=512,

temperature=0.8,

top_p=1,

repetition_penalty=1.15

)

llm = HuggingFacePipeline(pipeline=pipe)

template = "用户:{query} \n 小元:"

prompt = PromptTemplate(

input_variables=["query"],

template=template,

)

while True:

query = input("\n用户:")

if query == "stop":

break

if query == "clear":

os.system('clear')

continue

response = llm(prompt.format(query=query))

print(f"小元:{response}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

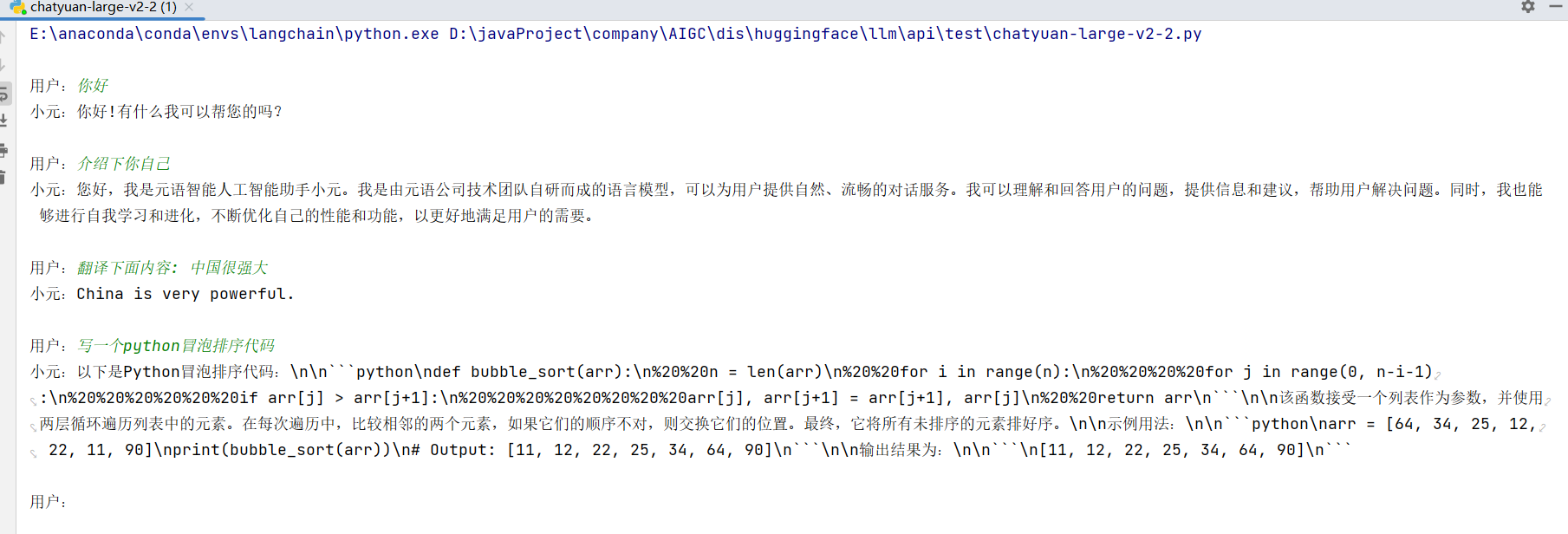

测试效果:

四、场景使用探索

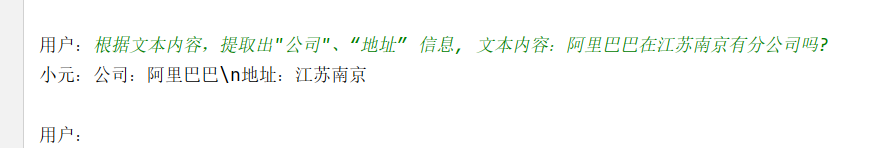

4.1 实体识别

提取文本中的 企业 和 地址 实体:

根据文本内容,提取出"公司"、“地址” 信息, 文本内容:阿里巴巴在江苏南京有分公司吗?

- 1

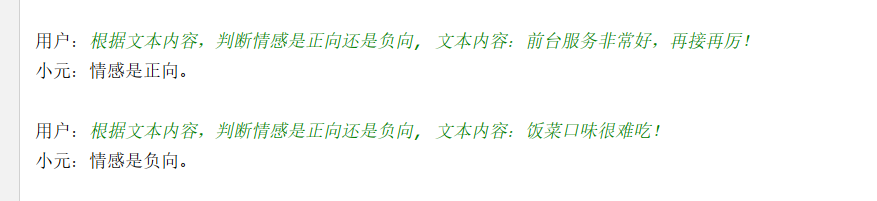

4.2 情感分析

根据文本内容,判断情感是正向还是负向, 文本内容:前台服务非常好,再接再厉!

根据文本内容,判断情感是正向还是负向, 文本内容:饭菜口味很难吃!

- 1

- 2

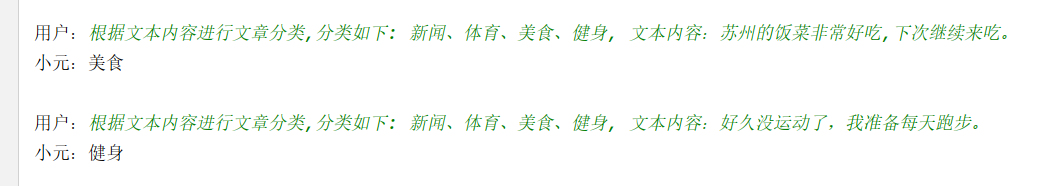

4.3 文章分类

根据文本内容进行文章分类,分类如下: 新闻、体育、美食、健身, 文本内容:苏州的饭菜非常好吃,下次继续来吃。

根据文本内容进行文章分类,分类如下: 新闻、体育、美食、健身, 文本内容:好久没运动了,我准备每天跑步。

- 1

- 2

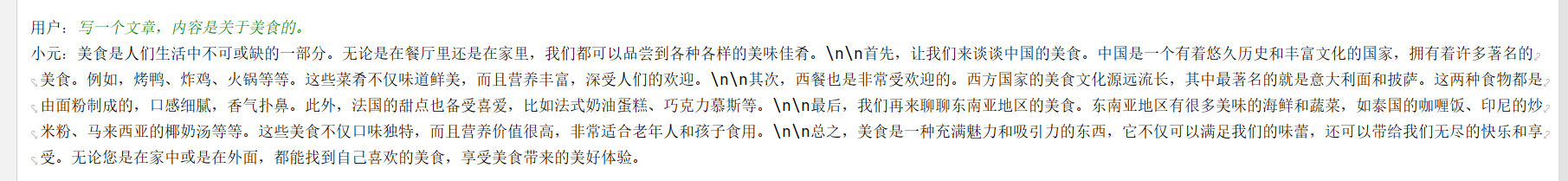

4.4 文章生成

写一个文章,内容是关于美食的。

- 1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/100443

推荐阅读

相关标签