- 1docker运行jar包加载外部配置文件_docker部署jar包读取外部配置文件

- 2Android---Jetpack之Paging_android pagekeyeddatasource

- 3RabbitMQ从0到1完整学习笔记一:《基础篇》_mq从0开始学

- 423. DICOM图像显示-DCMTK-image转dicom_dcmtk中dcmgpdir

- 5pkpm板按弹性计算还是塑性_浅谈PKPM结构设计软件学习与应用

- 6uni-app 面容、指纹识别插件(uni-face-login)_uni-app中ios调用面容识别

- 7分享下产品运营中几款好用的软件工具_经营蓝图 什么工具好用

- 8IJCAI 2021 医药AI必读论文推荐

- 9全球首个AI程序员诞生,码农饭碗一夜被砸!10块IOI金牌华人团队震撼打造,996写代码训练模型...

- 10代码随想录day50| 123.买卖股票的最佳时机III、 188.买卖股票的最佳时机IV

AI视频生成:Google发布时空扩散大模型Lumiere_视频生成大模型

赞

踩

“神说:‘要有光!’ 于是就有了光。”,这句话来自《圣经》旧约《创世纪》的第一章。

Google新发布的这个AI视频模型取名为Lumiere,这是一个法语词,本意就是光。由此可见Google对这个模型是赋予了很多期望的,当然我们这些围观群众也很期待。

效果展示

废话不多说,先看效果吧。

是不是效果很炸裂,Lumiere现在能生成5秒共80帧的视频,比我之前使用的Stable Video Diffusion多一秒,而且画面看起来更加稳定,动作比较连贯。

对于网络比较强大的同学,可以到Github这里看下完整的效果演示:Lumiere

Lumiere介绍

Google Lumiere是一种基于文本到视频的扩散模型,旨在实现从文字描述直接生成展现真实、多样且连贯动作的高质量视频。告别传统的绿幕技术和繁琐的手动动画过程,Lumiere让你只需通过文字描绘场景与动态,就能创造出流畅自然、引人入胜的视频内容。这款智能模型经由海量文本和视频数据训练而成,使得文字创意能够迅速转化为视觉盛宴。

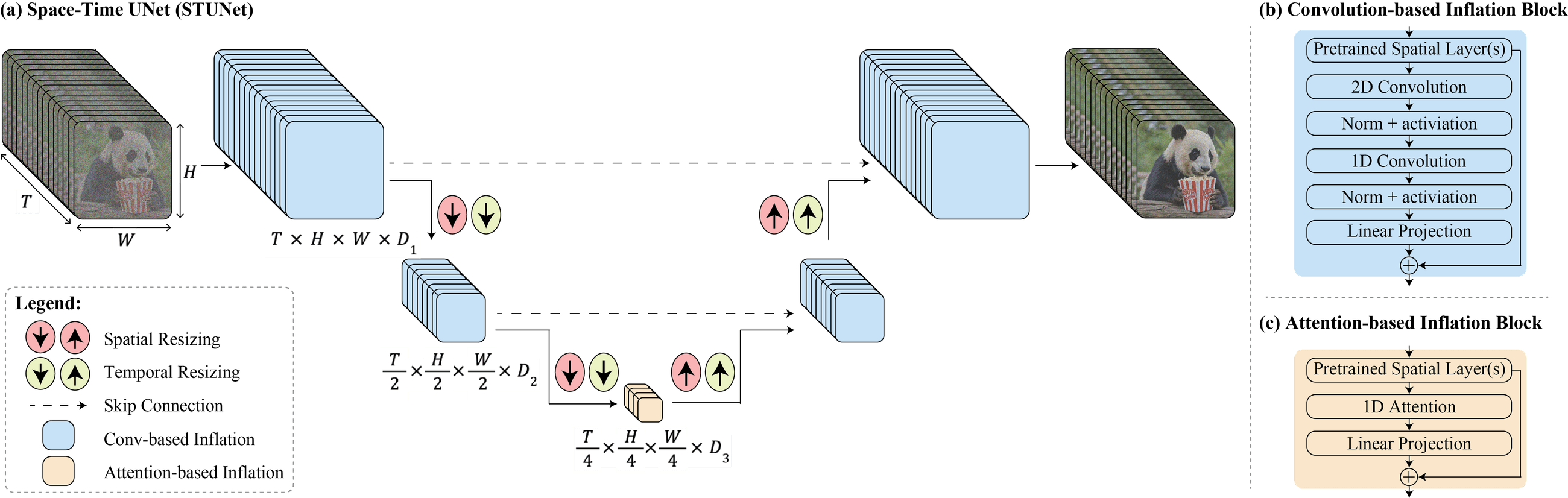

时空U-Net架构是Lumiere的核心技术亮点。不同于现有的逐帧或关键帧合成后进行时间分辨率提升的视频模型,Lumiere一次性处理即可生成整个视频的时间长度,确保了全局时间上的连续性和一致性。这一创新极大地提高了视频合成的质量,消除了过渡不自然的问题,为用户带来前所未有的创作体验。

使用Google Lumiere的好处多方面体现:

- 释放无尽想象:无论是幻想中的奇幻世界还是历史事件的再现,只要用文字描绘出来,Lumiere都有能力将之生动呈现出来,让想象力插上翅膀飞翔。

- 强化叙事表达:不论是教育演示、社交媒体分享还是个人短片制作,Lumiere所生成的精美绝伦的AI视频画面都能显著提升作品的表现力与吸引力。

- 全民参与创作:消除复杂视频剪辑技术的难度,Lumiere让没有专业影视背景的人也能涉足视频创作领域,尽情探索视觉故事的无限可能。

Lumiere的能力

那么Lumiere具体有哪些能力呢?

文生视频

用户通过文字描述(也就是提示词)指示Limiere生成视频。我之前介绍过的Runway也支持这种方式。

图生视频

上传一张图片,再加上提示词,然后生成视频。这个能力很强,目前开源的Stable Video Diffusion只能根据图片生成视频,不能附加提示词,全靠模型猜测。虽然Runway也支持图片加提示词生成视频,但是感觉效果一般。

多种风格视频

这个有点像SDXL的多种风格图片生成能力,但是Lumiere可以生成视频。用户可以从“贴纸”、“线条”、“平面卡通”、“水彩”、“荧光”、“3D金属质感”以及“3D渲染”这七种不同的素材风格中进行选择,并根据自身需求进行灵活调整。

影图效果(Cinemagraphs)

用户可以圈定一小块区域,只让这一部分的内容动起来。比如只让火堆燃烧而天上的云不动。

Cinemagraphs 是一种视觉艺术形式,它巧妙地融合了静态图片和动态元素,创造出介于照片与视频之间的独特视觉体验。Cinemagraphs 在时尚界尤其受到青睐,常被用于广告宣传、社交媒体内容创作以及各类艺术表达之中,成为现代数字媒体中引人注目的创新交流工具。

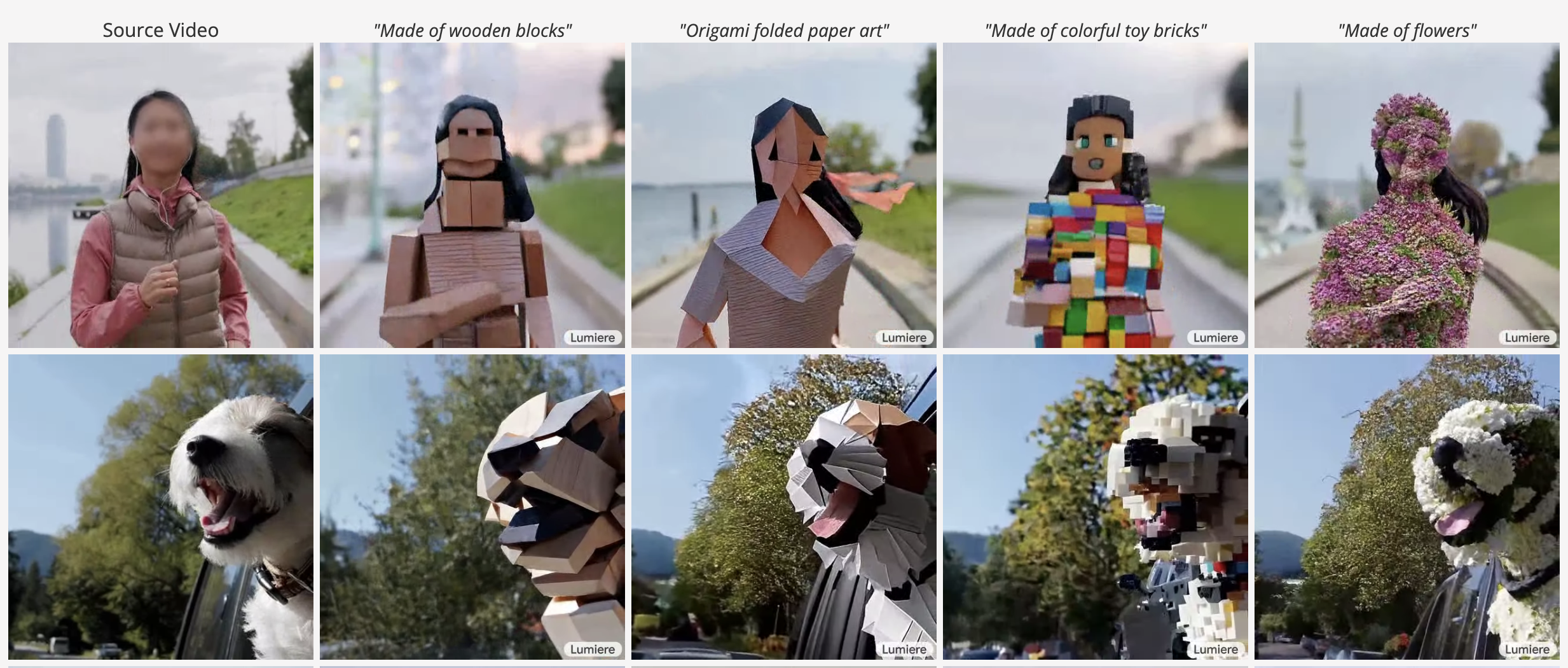

视频风格化

用户能够改变运动中物体的材质,以实现某些风格化的效果。

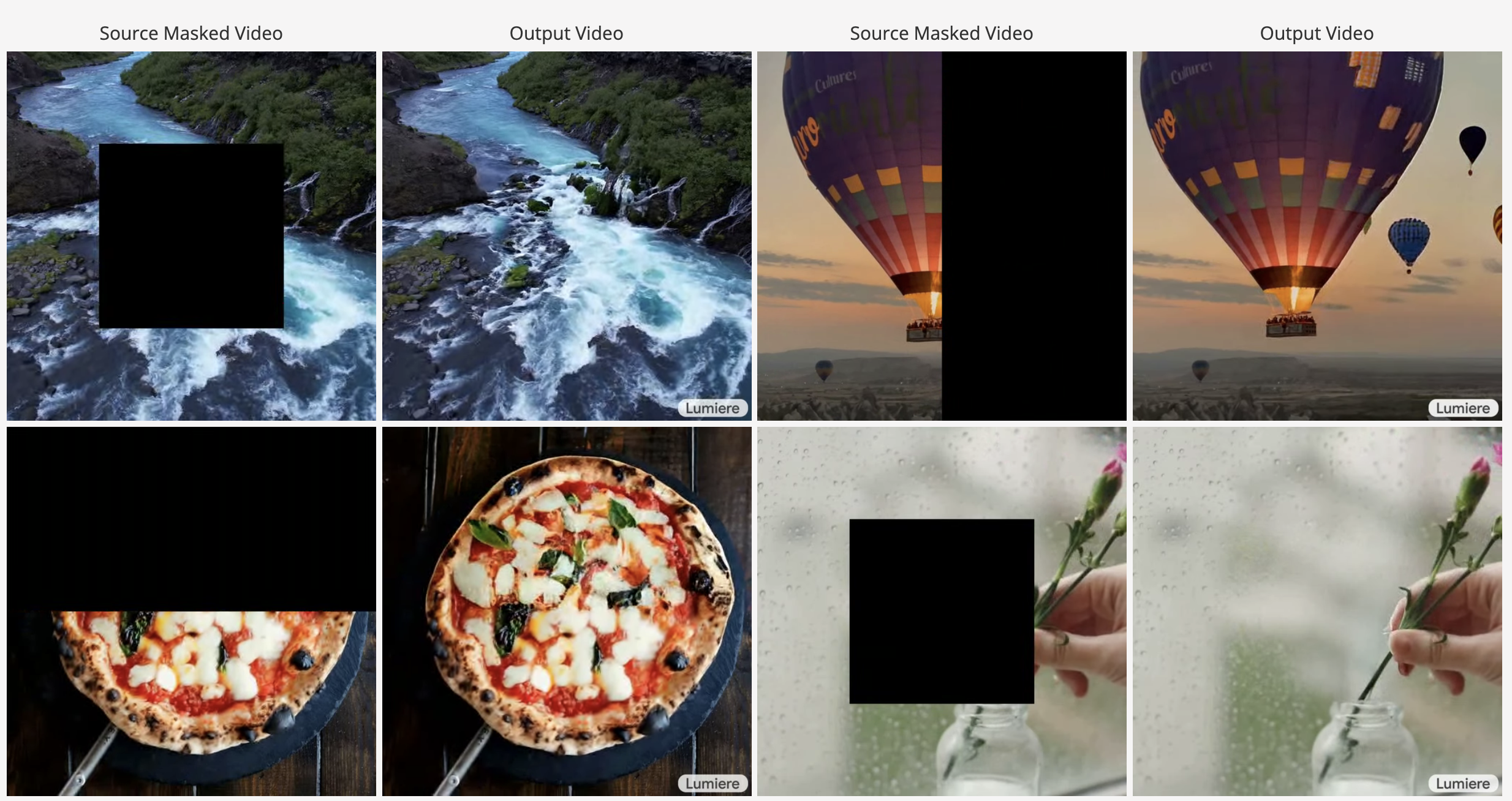

视频局部重绘

用户可以使用蒙版盖住一部分视频区域,然后Lumiere会重新绘制这部分,并与周围的画面很好的融合。

怎么使用Lumiere

目前,Google Lumiere尚处于研发阶段,并未面向公众开放。但研究团队正紧锣密鼓地对模型进行测试和优化,期待未来能有更多用户接触到这款前沿的AI工具。

请持续关注后续文章以获取最新进展,并把握可能出现的beta测试机会,共同见证这场由Google Lumiere引领的视频创作革命。

很多大佬预测2024年将迎来AI视频领域的大爆发,手机制作电影或许不再遥远,关注“萤火遛AI”,让我们一起拥抱这个伟大的AI时代!