- 1初识基于鸿蒙系统(HarmonyOS)的App开发_鸿蒙系统 app开发 js开发

- 2Flash(JTAG)烧录总结_jtag烧录

- 3Capture One 23:光影魔术师,细节掌控者mac/win版

- 4Unity3D实现UI的单击、双击、拖动状态判断_unity ui 按下

- 5csvtk:表格处理神器-美化、统计、头表、合并、转置、筛选、取样、去冗余 、分列、分类汇总和简单绘图...

- 6飞思卡尔仿真,MC9S08DZ60,MC9S12XEP100RMV1_飞思卡尔单片机如何仿真

- 7Mac 搭建本地SVN,并使用Cornerstone管理svn_ios cornerstone add repository 很慢

- 8基于Python爬虫甘肃天水酒店宾馆数据可视化系统设计与实现(Django框架) 研究背景与意义、国内外研究现状

- 9mybatis使用truncate清除表数据的问题_mybatis中无法执行truncate

- 10嵌入式面试收到了两个offer,一个单片机开发,一个Linux开发,不知道如何选择?

稳定扩散AI 纹理生成器_stable diffusion纹理

赞

踩

推荐基于稳定扩散(stable diffusion) AI 模型开发的自动纹理工具: DreamTexture.js自动纹理化开发包 - NSDT

什么是稳定扩散?

从技术上讲,Stable Diffusion 是一种用于机器学习的潜在扩散模型 (LDM)。这种类型的专用深度学习模型使用概率分布来生成在统计上与模型训练数据相似的输出。

除了生成新图像外,Stable Diffusion 还可用于修复或修复现有图像中的元素,以及图像到图像的转换。

- 修复是填充图像中缺失或损坏部分的过程。它是图像恢复和编辑中的常见任务,可用于从图像中删除对象、修复损坏的照片或完成不完整的图像。

- Outpainting 是将图像扩展到其原始边界之外的过程。它可用于创建更大的图像、向图像添加新元素或更改图像的纵横比。

- 图像到图像转换是将输入图像映射到输出图像的过程。它可用于更改图像的艺术风格、更改图像中对象的外观或通过增加对比度或颜色密度来提高图像质量。

稳定扩散如何工作?

Stable Diffusion 最初是在从互联网上抓取的人类标记图像上训练的。该模型学会了如何通过使用一种称为人类反馈强化学习 (RLHF) 的技术来改进其输出。

在初始训练阶段,基础模型的任务是分析标记训练数据中潜在变量的概率分布。潜在变量捕获训练图像的底层结构和细节,并允许模型了解特定图像与人类创建的文本标签匹配的可能性。

Stable Diffusion 的工作原理是将扩散滤波器应用于随机像素的图像,该图像对相邻像素的值进行平均。在深度学习过程的每次迭代期间,过滤器都会从图像中去除更多噪点,直到剩余像素在统计上与提供的文本描述匹配。

基础模型的最新版本 SDXL 1.0 于 2023 年 3 月发布。据说它已经用 5 亿个参数和数千个超参数进行了训练。根据 Stability AI 网站的说法,该模型之所以运行得如此之好,是因为它在发布前进行了大规模测试,有超过 10,000 名 beta 测试人员平均每天创建 1 万张图像。

下面是使用文本提示“灰松鼠嗅黄花”创建的稳定扩散图像的示例。

来源:DreamStudio.ai

下面是使用文本提示“折纸灰松鼠嗅黄色花朵”创建的稳定扩散图像示例。

来源:DreamStudio.ai

稳定扩散与 DALL-E,Midjourney 相比

Stable Diffusion 经常被拿来与 DALL-E 相提并论,DALL-E 是由 ChatGPT 的创造者 Open AI 开发的专有生成式 AI 图像应用程序。

虽然这两个 AI 模型都是在大量图像数据上训练的,并且都能够生成有用的图像,但 DALL-E 是一种条件扩散模型,它使用外部信息来指导图像生成过程。用户的提示为模型提供了有关生成的图像应类似于或包含的内容的具体指导。

相比之下,Stable Diffusion 是一种开源的潜在扩散模型,它使用文本或图像提示对所需图像的潜在表示进行编码。潜在表示指导扩散过程,以确保生成的图像在统计上与用户的提示相似。

Midjourney 是一种专有的潜在扩散模型,用于生成图像。它只能通过付费订阅获得。没有免费或免费增值版本可供个人使用。

历史

Stable Diffusion 于 2022 年首次发布,由一家相对较新的研发 (R&D) 公司 Stability AI 资助。

该公司与 Amazon Web Services (AWS) 的合作使开发人员能够访问 Ezra-1 UltraCluster 超级计算机,并为 Stability AI 提供了开发用于图像、音乐和代码生成的复杂人工智能 (AI) 模型所需的处理能力。

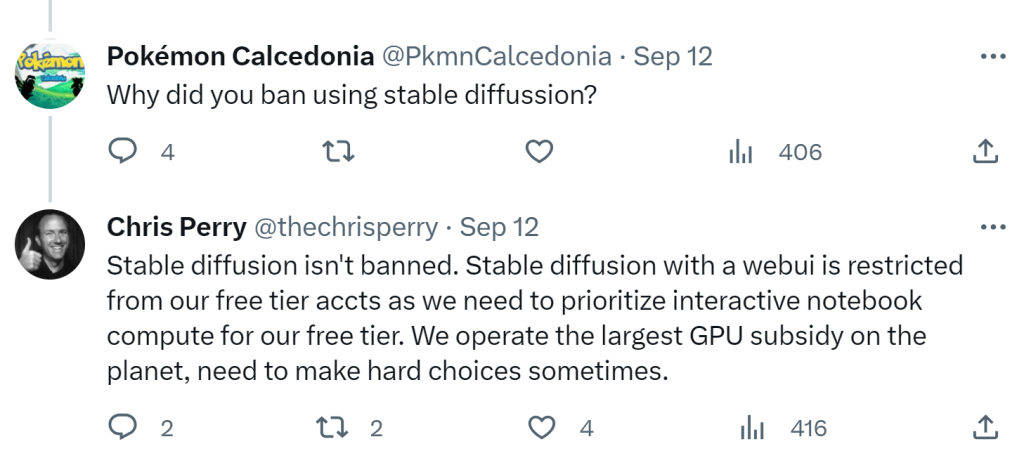

Stability AI 的既定使命是“让 AI 更易于访问和包容”。然而,在 2023 年 <> 月,一些媒体报道称,用户被禁止在 Google Cloud Platform (GCP) 上运行 Stable Diffusion。

谷歌集团产品经理克里斯·佩里(Chris Perry)在推特上回应说,该公司没有禁止生成式人工智能应用程序,但他们确实对免费账户进行了限制,因为Stable Diffusion已经变得如此受欢迎。Stability AI创始人穆罕默德·埃马德·莫斯塔克(Mohammad Emad Mostaque)在推特上表示,他认为这一决定是公平的。

如何使用稳定扩散

可以通过访问 Stability AI 网站或使用 DreamStudio 或 Clipdrop 免费访问和试用 Stable Diffusion。DreamTexture.js自动纹理化开发包 使用 Stable Diffusion 应用程序编程接口 (API)可用于webGL应用3D模型AI自动纹理化工具。

要使用 Stable Diffusion,请按照下列步骤操作:

- 打开 Stable Diffusion 用户界面。

- 输入描述图像的文本提示,或上传图像并输入有关如何更改图像的文本提示。

- 单击“生成”按钮,根据文本提示生成少量图像。

- 如果需要,可以调整文本提示和模型的潜在变量,以控制输出的各个方面,例如样式、内容或主题。

- 模型生成所需结果后,将其保存在本地以备将来使用。

使用稳定扩散的 3 个技巧

- 创建文本提示时要具体。这可以说是使用Stable Diffusion最困难的方面。文本提示越具体,输出效果越好。如果模型的初始输出不是最优的,请考虑使用更具体的提示再次启动该过程。

- 使用否定提示从模型的输出中排除特定元素。例如,要生成不戴帽子的牛仔图像,请使用否定提示“不戴帽子”。

- 如果模型在本地运行,请考虑使用较小的数据集对其进行微调,以满足特定的创意需求。

在本地运行稳定的扩散

为了避免为大规模使用 Stable Diffusion 付费,同意 Stability AI 可接受使用政策 (AUP) 的技术娴熟用户可以在具有至少 7GB 视频随机存取内存 (VRAM) 的显卡的商用台式计算机上本地安装 LDM 模型。

在不久的将来,Stability AI 预计将发布其 LDM 模型的优化版本,以提高模型性能和输出质量。他们还计划发布一些版本,使 Stable Diffusion 能够在 AMD、Macbook M1/M2 和其他芯片组上运行。(目前,建议使用NVIDIA芯片。

对于想要大规模生成免费图像、离线生成图像、保持图像私密性或微调 Stable Diffusion 输出以满足特定用例的用户来说,在本地运行 Stable Diffusion 是一个不错的选择。

例如,开发人员可以在本地运行 Stable Diffusion,为他们正在开发的游戏生成纹理和图像。

如何安装稳定扩散

在用户访问 Stability.ai 网站并验证其计算机满足最新的最低要求后,他们将需要下载并安装 Python 和 Git。他们还需要在 Hugging Face 创建一个免费帐户以获取模型重量,然后按照以下步骤操作:

步骤1: 要获取 Stable Diffusion 项目文件,请访问此项目的 GitHub 页面。在右上角,找到并单击绿色的“代码”按钮。从下拉菜单中,选择“下载 ZIP”。下载后,解压缩ZIP文件内容。此操作将创建一个名为“stable-diffusion-webui-master”的文件夹。若要简化安装,请将整个文件夹(以及所有提取的文件)复制到主机的 C: 驱动器的根目录。

步骤2:访问 Hugging Face 网站并搜索或浏览“768-v-ema.ckpt”文件的下载链接。此文件非常大,因此在下载过程中预计会有很多等待时间。下载完成后,导航到以下位置:“C:\stable-diffusion-webui-master\models\Stable-diffusion”。在此文件夹中,找到一个名为“在此处放置稳定扩散检查点 .txt”的文件并插入“768-v-ema.ckpt”文件。

第 3 步:在从 GitHub 下载的 ZIP 文件中找到配置 YAML 文件。导航到“C:\stable-diffusion-webui-master\models\Stable-diffusion”文件夹并将 YAML 文件保存在那里。将文件名更改为“768-v-ema.yaml”,同时保留“.yaml”扩展名。

第 4 步:移动到“stable-diffusion-webui-master”文件夹并运行“webui-user.bat”文件。等待几分钟。命令窗口最终应显示一条消息,内容为:“在本地 URL 上运行”,后跟包含本地计算机的 IP 地址和端口号的 URL。将整个 URL(包括端口号)复制并粘贴到 Web 浏览器中。此操作将打开 Stable Diffusion 应用程序。

第 5 步:出现提示时输入所需图像的描述。(可选)在“否定提示”框中指定要排除的任何文本。调整参数,根据需要修改批次计数和大小,然后单击“生成”按钮。然后,应用程序将根据提供的输入显示请求的图像数量。

许可

Stable Diffusion 根据 CreativeML Open RAIL-M 许可证获得许可,该许可证允许将模型及其输出用于商业和非商业用途。

需要注意的是,该许可证不涵盖可用于生成具有 Stable Diffusion 的图像的任何基础材料的版权。

这意味着,如果通过添加或替换图像中的元素(上漆)、扩展以使图像变大(上漆)或使其类似于梵高的画作(图像到图像的翻译)来更改受版权保护的照片,则新生成的图像的版权仍属于原始照片的版权所有者。