- 1导数与微分_可微函数,导数不等于0,δx趋向于0时候δy一定趋向于0吗

- 2teamviewer连接不上的原因及解决方法有哪些

- 3数据结构之优先级队列(堆)_优先队列

- 4leetcode 540. Single Element in a Sorted Array_java给定一个从小到大有序整数序列(可以是正整数,也可以是负整数)nums数组,

- 5如何用MATLAB写欧氏看涨看跌期权(B-S模型)的代码_matlab期权定价代码

- 6JVM 调优实战 - 知识点归纳

- 7conda配置镜像源_conda镜像配置

- 8面试官:SpringBoot 该如何预防 XSS 攻击 ?

- 9为什么java需要配置环境,而c/c++不需要_为什么c语言不用配置环境

- 10mysql事务隔离级别

七月论文审稿GPT第5版:拿我司七月的早期paper-7方面review数据集微调LLama 3_llama3微调数据集

赞

踩

前言

llama 3出来后,为了通过paper-review的数据集微调3,有以下各种方式

- 不用任何框架 工具 技术,直接微调原生的llama 3,毕竟也有8k长度了

效果不期望有多高,纯作为baseline - 通过PI,把llama 3的8K长度扩展到12k,但需要什么样的机器资源,待查

apple为主,不染为辅 - 阿里云百练大模型服务平台、百度智能云千帆大模型平台对llama 3的支持

文弱zu - 通过llama factory微调3,但等他们适配3(除非我们改factory),类似

llama factory + pi

llama factory + longlora/longqlora - 我们自行改造longqlora(longlora也行,但所需机器资源更大),以适配3

类似之前的经典组合:longqlora(PI + s2-Attn + qlora) + flash attention + zero3 - 基于xtuner微调llama 3

三太子则在与70b微调工作不冲突的前提下,试下这个xtuner

第一部分 拿我司的paper-review数据集通过PI微调LLama 3

1.1 使用PI微调llama3-8b

- 直接用的longlora的代码「至于什么是longlora,请参见此文:《从LongLoRA到LongQLoRA(含源码剖析):大模型上下文长度的超强扩展》」

- 因为longlora的代码实现了PI + S2-attn,故把S2-attn相关的部分注释掉后,即相当于通过PI微调llama 3了

// 待更

1.2 通过百度智能云的千帆大模型平台微调Llama 3

// 待更

第二部分 基于llama factory和paper-review数据集微调LLama3

LLaMA Factory 现已支持 Llama 3 模型,提供了在 Colab 免费 T4 算力上微调 Llama 3 模型的详细实战教程:https://colab.research.google.com/drive/1d5KQtbemerlSDSxZIfAaWXhKr30QypiK?usp=sharing

同时社区已经公开了两款利用本框架微调的中文版 LLaMA3 模型,分别为:

- Llama3-8B-Chinese-Chat,首个使用 ORPO 算法微调的中文 Llama3 模型,文章介绍:https://zhuanlan.zhihu.com/p/693905042

- Llama3-Chinese,首个使用 DoRA 和 LoRA+ 算法微调的中文 Llama3 模型,仓库地址:https://github.com/seanzhang-zhichen/llama3-chinese

// 待更

第三部分 不用PI和S2-attn,调通Llama-3-8B-Instruct-262k

3.1 基于15K的「情况1:晚4数据」微调Llama 3 8B Instruct 262k

3.1.1 基于1.5K的「情况1:晚4数据」微调Llama 3 8B Instruct 262k

24年5.25日,我司审稿项目组的青睐同学,通过我司的paper-review数据集(先只取了此文情况1中晚期paper-4方面review数据中的1.5K的规模,另,本3.1.1节和3.1.2节都统一用的情况1中的晚期paper-4方面review数据),把llama3调通了

至于llama3的版本具体用的Llama-3-8B-Instruct-262k,这个模型不是量化的版本,其他很多版本虽然扩展长度了,但基本都传的量化后的,这个模型的精度是半精的(当然,还有比较重要的一点是这个模型的下载量比较高)

以下是关于本次微调的部分细节,如青睐所说

- 一开始用A40 + 1.5K数据微调时,用了可以节省所需显存资源的s2atten(S2-attention + flash attention),且由于用了 26k 长度扩展的那个模型,便不用插值PI了

但48g的A40在保存模型的时候显存会超过48g(训练过程中不会出现),而zero3模型保存时会报oom,后来经验证发现原因是:per_eval_device_batch size设置太大导致了oom

总之,用A40 训练时其具有的48g显存是可以训练超过 12k上下文数据的,不一定非得用s2atten(毕竟上面也说了,过程中微调llama3出现oom是因为per_eval_device_batch size设置太大照成的,与训练没啥关系,一个很重要的原因是llama3的词汇表比较大,从32K拓展到了128K,压缩率比较高,导致论文的长度比llama2短,所以A40也放的下) - 后来改成了用A100训练(数据规模还是1.5K),由于用了A100,故关闭了s2atten,直接拿12K的长度开训,且用上了flash atten v2,得到下图这个结果

3.1.2 用5K-15K的「情况1:晚4数据」微调Llama-3

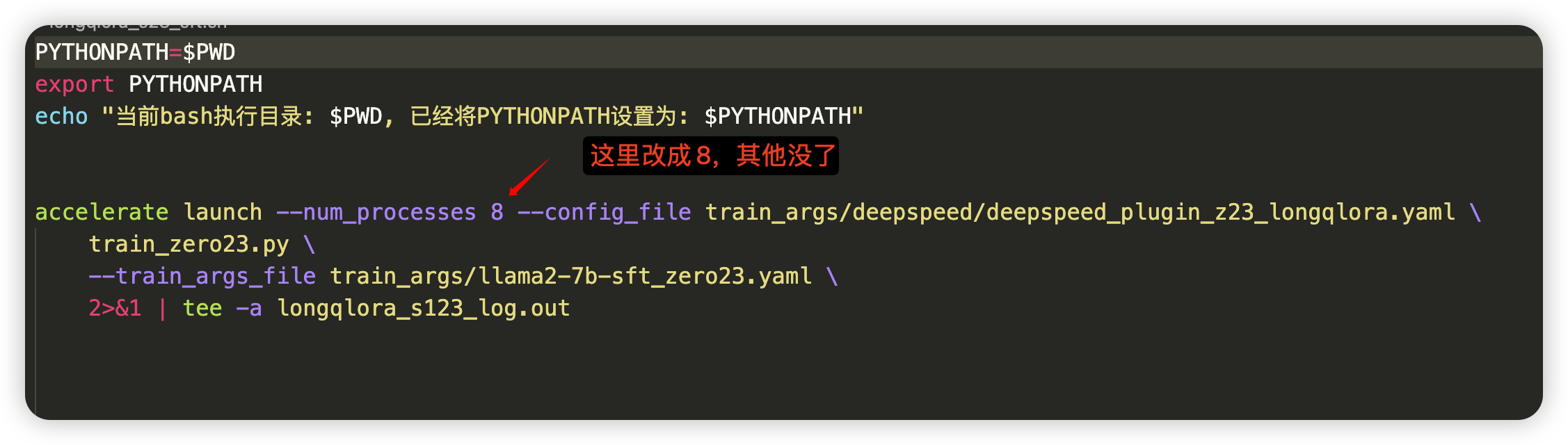

再后来用8卡A40对5K或15K数据微调时,便也都没有用S2-attention(关闭了),使用12K长度 + flash attention v2 微调

代码和上面跑1.5K的数据一样,也还是用的「七月大模型线上营那套longqlora代码」,但把单卡设置成多卡

且直接租2台「8卡的A40」,一台5K的数据,一台15K的数据,直接一块跑

以下是15K数据(晚期paper-4方面review)微调后针对YaRN那篇论文得到的推理结果

接下来,青睐先推理下测试集中的晚期paper,输出4方面review

最后,文弱测评一下,让GPT4-1106、情况1的llama2(也是晚期paper-4方面review),都统一跟人工4方面review做下匹配

// 待更

3.2 基于15K的「情况3:早4数据」微调Llama 3 8B Instruct 262k

3.2.1 llama3版本的情况3 PK 上两节llama3版本的情况1

上两节用了晚期paper-4方面的review微调llama3-262k,类似于此文开头总结的情况1:用晚期paper-4方面review微调llama2

本节咱们将基于15K的早期paper-4方面review,类似于此文开头总结的情况3:用早期paper-4方面review微调llama2

本节微调完之后,自然便可以与以下模型PK(针对哪个情况,则用那个情况的paper,所以评估llama3-262k版本的情况3时,则都统一早期paper)

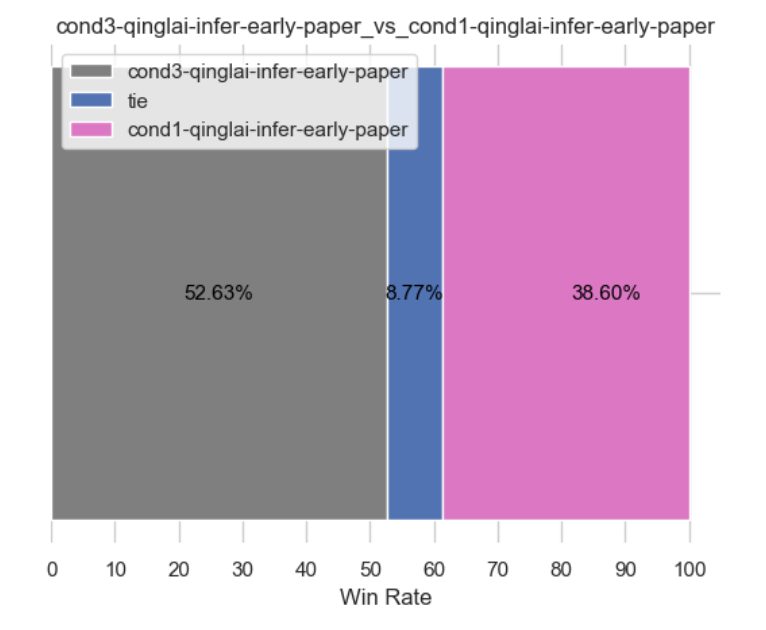

llama3版本的情况3 当PK 上两节的llama3版本的情况1,情况如下(当然,按理得胜,毕竟情况3的数据更强,相当于都是llama3,但数据质量不一样,当然,无论是llama2 还是llama3,按道理情况3就得好过情况1,毕竟情况3 早4,情况1 晚4,情况3-早4的数据质量是更高的)

当llama3版本的情况3 PK llama2版本的情况3,按理得胜,毕竟llama3更强

当llama3版本的情况3 PK llama2版本的情况1(以阿荀微调的longqlora 7B做为情况1的基准),按理更得胜,毕竟llama3更强且情况3的数据更强,但目前得到的结果有些奇怪(如下图所示),没达预期,正在找原因中,待后续更新..

// 更多细节暂见我司的:大模型商用项目之审稿微调实战营

3.2.2 llama3情况1 PK llama2情况1——评估微调llama3-8b-instruct-262k基座性能

之后,我们发现使用 15k 情况1样本仅flash attention v2直接微调 llama3-8b-instruct-262k效果不佳,具体可以下面评估结果

- 左图:情况1样本仅flash attention v2直接微调 llama3-8b-instruct-262k

- 右图:情况1样本微调 llama2-7b-chat + PI 扩展长度

可以看到两者性能相当,这个阶段,并没有得到微调llama3性能超过微调llama2的结论,推断可能是llama3-8b-262k原始微调数据集与审稿12k数据集长度分布不太匹配,请看下文第四部分将使用llama-3-8B-Instruct-8k + PI 重新微调,最后获得大幅度性能提升

第四部分 使用PI和flash atten v2 微调llama-3-8B-Instruct-8k

下面训练的数据集皆为15k样本(样本长度普遍9k左右,最长不超过12k),评估方法为基于groud truth 命中数pk,模型取验证集loss最低的模型

此阶段将评估微调llama3-8b-8k与微调llama3-8b-262k&llama2性能差距

4.1 情况3早4数据下的:llama3-8b-instruct-8k + PI 与llama3-8b-instruct-262k 性能pk

经过评估发现,llama3-8b-8k + PI 性能较大幅度领先llama3-8b-262k的性能,如下所示

- 左图:情况3样本仅flash attention v2微调 llama3-8b-8k + PI 扩展长度

- 右图:情况3样本仅flash attention v2直接微调 llama3-8b-instruct-262k

4.2 llama3-8b-instruct-8k + PI 与 llama2-7b-chat 性能pk

4.2.1 llama3下的情况3 强于llama2下的情况3

且经过测试,llama3 在论文审稿场景下的性能确实领先 llama2

- 左图:情况3样本仅flash attention v2微调 llama3-8b-8k + PI 扩展长度

- 右图:情况3样本微调 llama2-7b-chat + PI 扩展长度

4.2.2 llama3下的情况3 更强于llama2下的情况1

此外,下面的这个实验,也无疑再次证明llama3 性能领先 llama2

- 左图:情况3样本仅flash attention v2微调 llama3-8b-8k + PI 扩展长度

- 右图:情况1样本微调 llama2-7b-chat + PI 扩展长度

第五部分 论文审稿GPT第5版:通过15K的早期paper-7方面review数据集(情况4)微调llama3

5.1 针对情况4早7数据的llama3-b-8b-8k的微调

5.1.1 情况4微调较情况3改动:微调参数、情况4的微调system prompt

一方面是微调参数(主要)

- 为了保证与情况1、情况3更公平的性能对比,选择与前两者相同的迭代次数,情况4推理选择的checkpoint迭代次数为1800,大约1.95个epoch

- 情况3的多次参数组合实验并没有得到较好的效果提升,因此本次情况4的参数基本都是原来的默认值

| 参数 | 说明 |

| batch size=16 | 梯度累计总batch size=16 |

| lr=1e-4 | 学习率的大小 |

| max_prompt_length=11138 | paper 最长的大小,超过将被截取 |

| max_response_length=1150 | review 最长的大小,超过将被截取 |

| save_steps=100 | 迭代100次保存一次模型 |

| num_train_epoch=3 | 迭代3个epoch |

二方面是情况4 微调system prompt

青睐微调的system prompt 采用与阿荀v4版prompt摘要出来的7方面review的大项对齐(详见此文《七月论文审稿GPT第4.5版、第4.6版、第4.8版:提升大模型数据质量的三大要素》的1.2.5节通过7要点摘要prompt第4版重新摘要整理7方面review数据)

比如微调prompt中的Potential项,便与7review中的Potential项对齐,具体为

- SYSTEM_PROMPT = """Below is an "Instruction" that describes a task, paired with an input that provides further context. Write a response that appropriately completes the request.

- Instruction:

- You are a professional machine learning conference reviewer who reviews a given paper and considers 7 criteria:

- ** How to evaluate the idea of the paper **

- ** Compared to previous similar works, what are the essential differences, such as any fundamental differences, improvements, innovations **

- ** How to evaluate the experimental results in the paper **

- ** Potential reasons for acceptance **

- ** Potential reasons for rejection **

- ** Other suggestions for further improving the quality of the paper **

- ** Other important review comments **

- The given paper is as follows."""

5.1.2 情况4推理结果分析

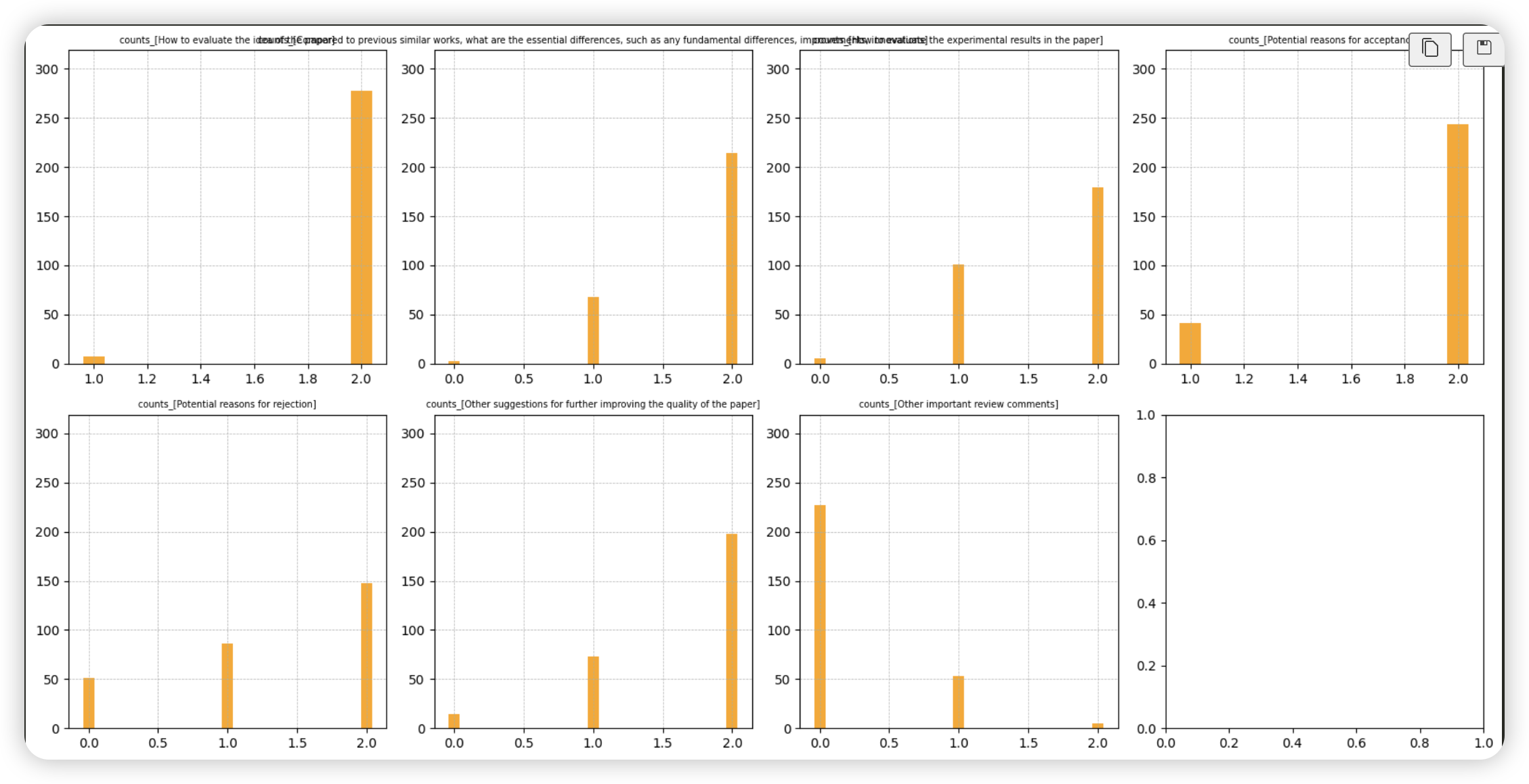

- a) 推理样本的总数为285条

- b) 推理结果中平均子项项数:10.3894

- c) 推理结果中子项总数分布情况(下图左侧),可以看到12条子项的样本占绝大数

- d) 空项数分布情况(下图右侧),可以看到大多数样本含有一个空项(“空项”代表着“拒答”的意思,也就是模型没有给出大项相关的理由),约占50%

- e) 各大项子项数分布情况(下图)

- 1. 可以看到上述d) 空项数分布中的“大多数样本含有一个空项”数据主要集中于最后一项(第二排最后一个图),这是由于训练集存在较多最后大项为空项的数据

- 2. 除了上述最后一大项外,“拒绝理由”(第二排第一个)的大项存在少量的空项,而其他大项中空项的数量较少

5.1.3 微调情况4性能评估

下面训练的数据集皆为15k样本(样本长度普遍9k左右,最长不超过12k),评估方法为基于groud truth 命中数pk

5.1.3.1 情况4数据下:llama3-8b-8k vs llama2-7b-chat

- 下图左侧:情况4 7review仅flash attention v2 微调llama3-8b-instruct-8k

- 下图右侧:情况4 7review微调llama2-7b-chat

结论:同样为情况4 7review数据下,llama3的效果较llama2有较大提升

5.1.3.2 情况4 摘要7方面review vs 情况3 摘要4review

为了保证评估的公平性,对于微调llama3-8b-instruct-8k来说情况3与情况4仅数据不同,微调的策略完全一致

- 下图左侧:情况4 7review仅flash attention v2 微调llama3-8b-instruct-8k

- 下图右侧:情况3 4review仅flash attention v2 微调llama3-8b-instruct-8k

结论:微调策略一致的前提下,摘要7review微调的性能相对于4review有大幅度提升

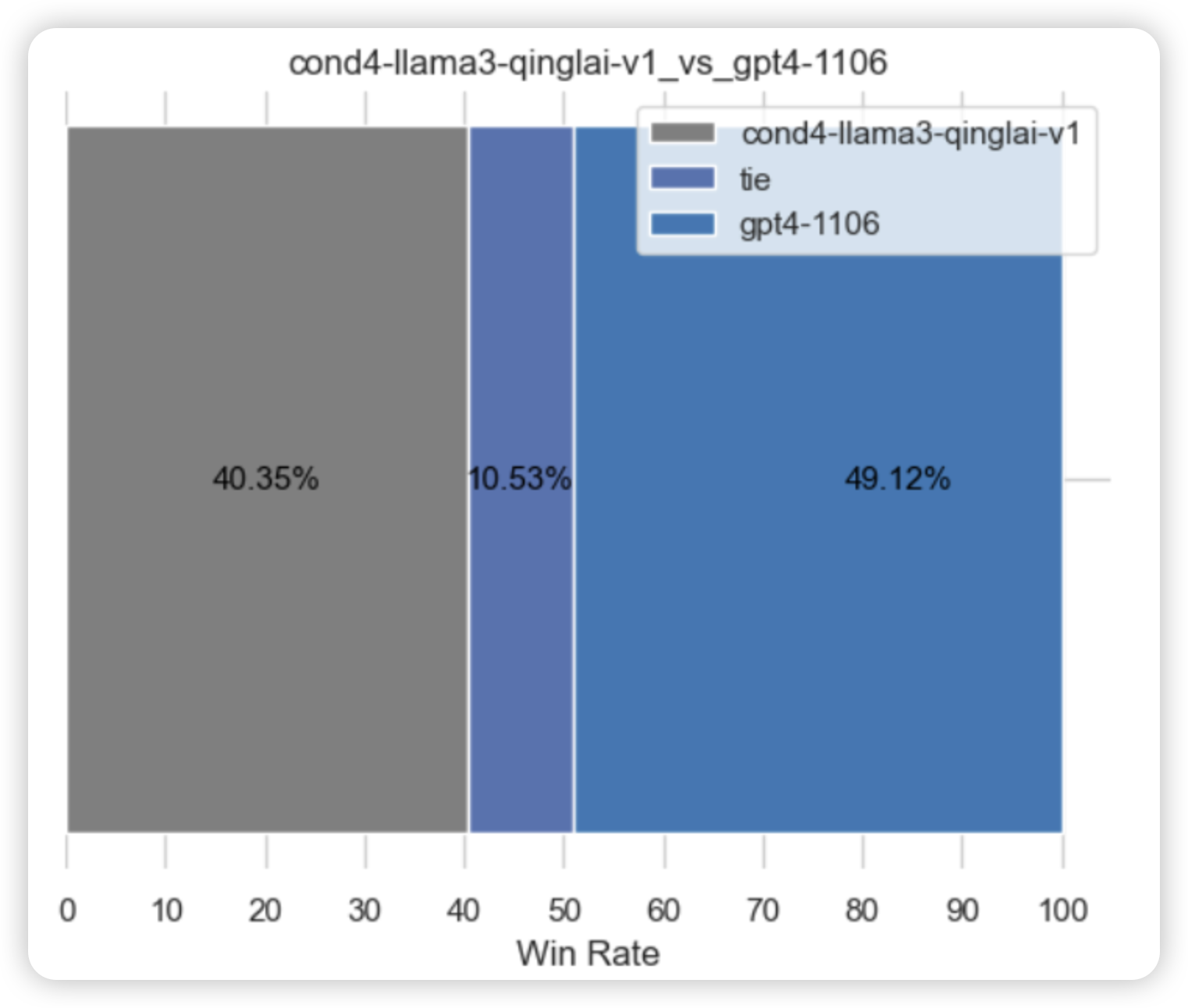

5.1.3.3 情况4 llama3-8b-8k vs gpt4-1106

- 下图左侧:情况4 7review仅flash attention v2 微调llama3-8b-instruct-8k

- 下图右侧:情况4 paper使用7大项提示工程gpt4-1106的结果

结论:gpt4-1106基于7 大项提示工程生成的观点数相比于基于4 大项提示工程的观点数要多很多,gpt4展现出了“话痨”的特点,虽说其观点的精确率不高,但基于命中数的评估方式还是让gpt4占尽了优势,从1.3节“情况4推理结果分析”可知,llama3推理过程中有不少项存在着“拒答”的现象,这在pk中是处于劣势的

因此,尝试是否可以通过对空项序列也就是“<No related terms>”略加惩罚的方式,合理地降低其采样的概率,减少模型拒答的概率,提升模型的推理性能呢,具体见下文

// 待更

5.2 针对情况4早七数据微调后的模型做推理策略优化——序列抑制

上文提到,llama3推理过程中有不少项存在着“拒答”的现象,推测的原因之一是在训练集中空项序列<No related terms>比较频繁出现导致其采样概率较高,而恰好采样到空项序列后,模型在该大项就不会生成其他的子项了,这也导致模型输出不是很稳定

下面将实现一种对固定序列的采样概率进行惩罚的实现代码

5.2.1 Huggingface generate 实现

下述代码的逻辑是当前文生成的结果与被抑制序列部分匹配时,降低抑制序列下个token生成的概率从而减低了整个抑制序列采样的概率

- class HuggingFacePenaltySequenceLogitsProcessor():

- def __init__(self,

- tokenizer,

- target_sequences = [],

- penalty_factor=0.5, # 0.0 - 1.0 之间, 1.0 表示不惩罚, use_multiplicative 为False时, penalty_factor 输入整数

- use_multiplicative=True

- ):

- """

- Hugging Face 初始化抑制某些目标序列的处理器。

- 参数:

- - tokenizer: 分词器对象,用于将目标序列转换为token ID

- - target_sequences: 需要抑制的目标序列列表

- - penalty_factor: 惩罚因子,1. 用于调整目标序列的生成概率float 2. 用于控制抑制的强度int

- - use_multiplicative: 是否使用乘法方式应用惩罚(True为乘法,False为减法)

- """

-

- # 详细代码见七月官网首页的《大模型项目开发线上营2期》

5.2.2 加入序列惩罚推理性能

本小节评估序列惩罚系数设置为0.7,以下llama3 penalty评估结果均使用上文中微调的模型,仅在推理策略中加入空项序列抑制

最终,加入空项序列抑制后pk评估提升14个点

- 上图左侧:上文llama3-8b-8k + 空项序列抑制

- 上图右侧:上文llama3-8b-8k

且对比gpt4-1106 pk评估差距缩减5.5个点

- 上图左侧:上文llama3-8b-8k + 空项序列抑制

- 上图右侧:上文gpt4-1106

至于加入序列惩罚后推理结果分析,详见七月官网首页( julyedu.com )的:大模型项目开发线上营2