热门标签

热门文章

- 1基于Python爬虫宁夏银川天气预报数据可视化系统设计与实现(Django框架) 研究背景与意义、国内外研究现状_python的arima天气预测的研究背景

- 2linux open firmware,Firmware/Open

- 3微信小程序--小程序框架_微信小程序框架

- 4HTML常用标签总结_html标签大全

- 5flex布局详解

- 605、Kafka ------ 各个功能的作用解释(主题和分区 详解,用命令行和图形界面创建主题和查看主题)_cmak查看主题内容消息

- 7Android-桌面小组件RemoteViews播放动画_android桌面小组件动画

- 8宝塔安装mayfly-go

- 9王小川的大模型打造秘籍首次曝光:五步走,两个月炼成

- 10JAVA单机五子棋小游戏(双人对战版)

当前位置: article > 正文

深度学习-神经网络_单隐藏层神经网络优缺点

作者:繁依Fanyi0 | 2024-03-26 03:14:34

赞

踩

单隐藏层神经网络优缺点

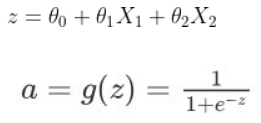

逻辑回归的目标函数如下:以网络表达就是感知器

神经网络的层数中输入层不算,从隐藏层开始到输出层,有几层就代表着是几层的神经网络,

如上图就是一个三层结构的神经网络。

- 多隐藏层的神经网络比 单隐藏层的神经网络工程效果好很多。

- 提升隐层层数或者隐层神经元个数,神经网络“容量”会变大,空间表达力会变强。

- 过多的隐层和神经元节点,会带来过拟合问题。

- 不要试图通过降低神经网络参数量来减缓过拟合,用正则化或者dropout。

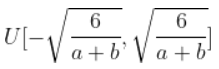

神经网络参数的初始化方法:

-

采用正态分布的随机初始化方法。

-

Xavier初始化方法:假设某全连接层的输入个数为a,输出个数为b,Xavier随机初始化将使该层中权重参数的每个元素都随机采样于均匀分布:

初始化后,每层输出的方差不会受该层输入个数的影响,且每层梯度的方差也不受该层输出个数的影响。

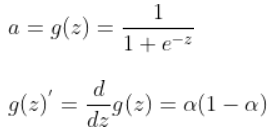

激活函数:

sigmoid:

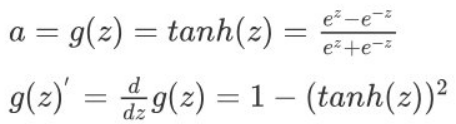

tanh:是 sigmoid 的向下平移和伸缩后的结果。

sigmoid函数和tanh函数两者共同的缺点是,在

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/314305

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。