热门标签

热门文章

- 1Oracle11 创建表空间、用户、权限、导入数据_dba_directories表的用户权限

- 2SpringBoot与布隆过滤器的完美邂逅:高效防护大规模数据的奇妙结合【实战】

- 3在Python中,f格式化字符串_python f格式化

- 4如何理解Mysql的索引及他们的原理--------二叉查找树和平衡二叉树和B树和B+树_mysql 二叉树搜索原理详解

- 5VHDL学习(一)_vhdl代码乘法表示

- 6ffmpeg硬件编解码Nvidia GPU_h264_cuvid

- 72022年Android面试题及答案汇总,每天20题【四】持续更新中...(从面试官角度帮你审视问题)_安卓面试题

- 8前端三剑客 —— JavaScript (第四节)

- 9Oracle,Sql Server,Mysql 三者的5方面区别:_oraclemysqlsqlserver三者的区别

- 10使用Matter-SDK快速搭建Matter环境 (Linux)

当前位置: article > 正文

Spark读取文件系统的数据_spark读取文件系统的数据 (1)在pyspark中读取linux系统本地文件“/home/had

作者:繁依Fanyi0 | 2024-04-27 22:28:45

赞

踩

spark读取文件系统的数据 (1)在pyspark中读取linux系统本地文件“/home/hadoop/te

(1)在pyspark中读取Linux系统本地文件“/home/hadoop/test.txt”(如果该文件不存在,请创建并自由添加内容),然后统计出文件的行数;

- cat /home/hadoop/test.txt

- pyspark

- lines = sc.textFile("file:///home/hadoop/test.txt")

- line_count = lines.count()

- print("Line count:", line_count)

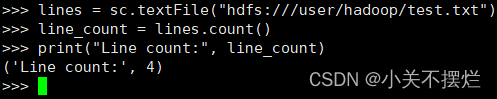

(2)在pyspark中读取HDFS系统文件“/user/hadoop/test.txt”(如果该文件不存在,请创建并自由添加内容),然后统计出文件的行数;

- hadoop fs -cat /user/hadoop/test.txt

- pyspark

- lines = sc.textFile("hdfs:///user/hadoop/test.txt")

- line_count = lines.count()

- print("Line count:", line_count)

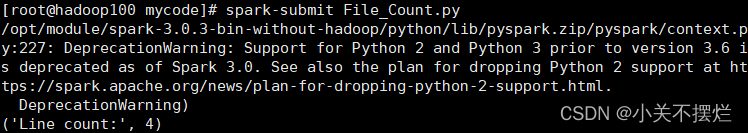

(3)编写独立应用程序,读取HDFS系统文件“/user/hadoop/test.txt”(如果该文件不存在,请创建并自由添加内容),然后统计出文件的行数;通过 spark-submit 提交到 Spark 中运行程序。

- cd /opt/module/spark-3.0.3-bin-without-hadoop/mycode/

- touch File_Count.py

- vim File_Count.py

- from pyspark import SparkConf,SparkContext

- conf = SparkConf().setMaster("local").setAppName("File Count")

- sc = SparkContext(conf = conf)

- lines = sc.textFile("hdfs:///user/hadoop/test.txt")

- line_count = lines.count()

- print("Line count:", line_count)

- sc.stop()

- spark-submit File_Count.py

总结

- 通过比较在pyspark中读取文件的代码和编写独立应用程序读取文件的代码,了解了在启动pyspark的时候,会自动创建一个SparkContext对象,不需要再创建,而在编写独立应用程序读取文件时需要先导入相关模块再创建SparkContext对象。

- 编程中也遇到很多问题,如:通过spark-sumbit运行程序时,会产生很多其他信息,执行结果会与其他信息混合在一起显示。可以通过修改log4j的日志显示级别,设置不显示INFO级别的信息,只输出自己的控制台输出的信息。在尝试使用python运行程序时,显示no moudle named pyspark,这时需要vim ~/.bashrc配置环境变量,配置PYTHONPATH环境变量用来在python中引入pyspark库,PYSPARK_PYTHON变量用来设置pyspark运行的python版本,要特别注意/opt/module/spark-3.0.3-bin-without-hadoop/python/lib目录下的py4j-0.10.9-src.zip文件名,在PYTHONPATH的设置中需要使用。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/499003

推荐阅读

相关标签