- 1鸿蒙ArkTS声明式组件:【DataPanel】

- 2【声源定位】广义互相关声源定位【含Matlab源码 548期】_声源广义互相关

- 3Python中使用opencv-python进行人脸检测_python opencv人脸识别

- 4C语言算法之CART决策树算法_决策树的c语言代码

- 5【Docker】docker 镜像如何push到私有docker仓库_docker push 到私有仓库

- 61024程序员节快乐!_1024 程序员节 有趣

- 7Java知识体系只这一篇就够了!

- 8Nacos惊现安全漏洞修复后问题仍旧存在_warn invalid server identity value for nacos

- 9微软服务器dda,实战DDA硬件直通:Hyper-V虚拟机直通NVMe固态硬盘

- 10植物大战僵尸的背后技术_慧编程植物大战僵尸

【机器学习】——续上:卷积神经网络(CNN)与参数训练_cnn训练

赞

踩

目录

引入

卷积神经网络(CNN)是一种有监督深度模型框架,尤其适合处理二维数据问题,如行人检测、人脸识别、信号处理等领域,是带有卷积结构的深度神经网络,也是首个真正意义上成功训练多层网络的算法。CNN与传统的神经网络的主要区别在于权值共享与非全连接。权值共享能够避免算法过拟合,通过拓补结构建立层与层间非全连接空间关系来降低训练参数的数目,这也是卷积神经网络的基本思想。

CNN经过反馈训练学习多个能够提取输入数据特征的卷积核,这些卷积核与输入数据进行逐层卷积并池化,来逐级提取隐藏在数据中拓补结构的特征。随着网络结构层层深入,提取的特征也逐渐变得抽象,最终获得输入数据的平移、旋转及缩放不变性的特征表示。相比传统神经网络,CNN将特征提取与分类过程同时进行,避免了两者在算法匹配上的难点。

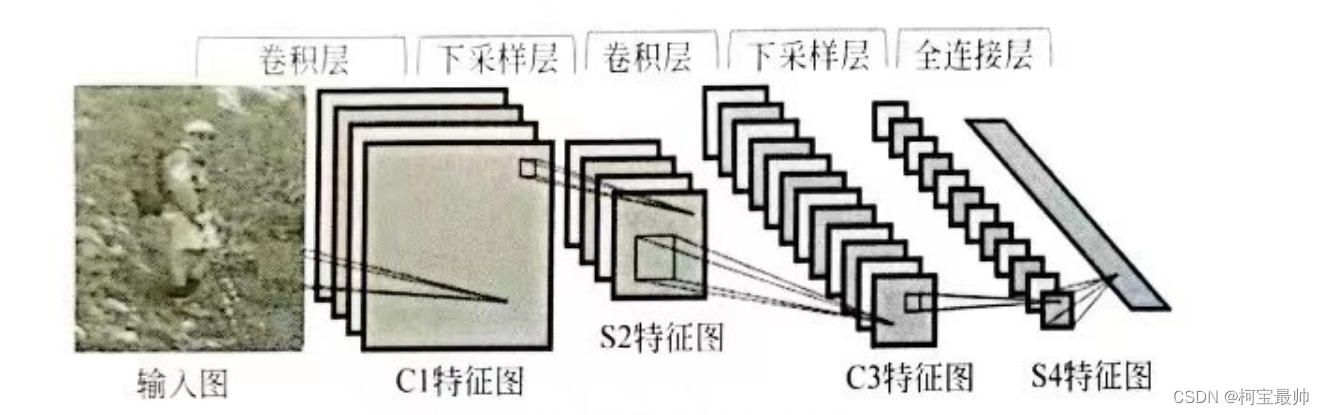

一、CNN基本结构

CNN主要由卷积层与下采样层

交替重复出现来构建网络结构,卷积层用来提取输入神经元数据的局部特征,不但可以增强特征信息,还会降低图像中的噪声;下采样层用来对其上一层提取的数据进行缩放映射以减小训练数据量,同时也使得提取的特征具有一定的缩放不变性。一般来说,可选不同尺寸的卷积核来提取多尺度特征,获得不同大小的局部信息。

例如,用于图像识别的CNN基本框架如图所示,两层卷积、两层下采样、一层全连接,然后输出分类:

1、卷积层

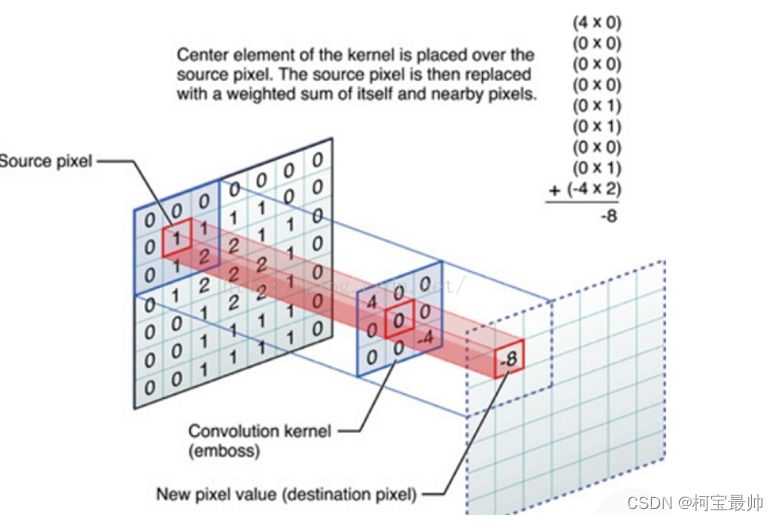

对图像和滤波矩阵做内积(逐个元素相乘再求和)即为卷积。图像即一个数据窗口,滤波矩阵可理解成权重层/卷积核,如下图:

上图卷积核为3x3,所以做卷积后9个数变为1个数,每计算完一个数据窗口内的局部数据后,数据窗口不断平移滑动,直到计算完所有数据,涉及几个参数:①深度depth:神经元的个数,决定输出的depth厚度,也代表滤波器的个数;②步长stride:滑动多少步可到边缘,如3x3的卷积核一次滑移2步;③填充值zero-pading:在外围补充多少圈0,方便从初始位置以步长为单位可以刚好滑移到末尾位置——总长可以被步长整除。

滑移时数距窗口的数据一直在变化,每次滤波器(卷积核)都是对某一局部的数据窗口(一个特征图)进行卷积,这就是所谓的CNN的局部感知机制;但是权重值没变,这就是CNN的参数(权重)共享机制。

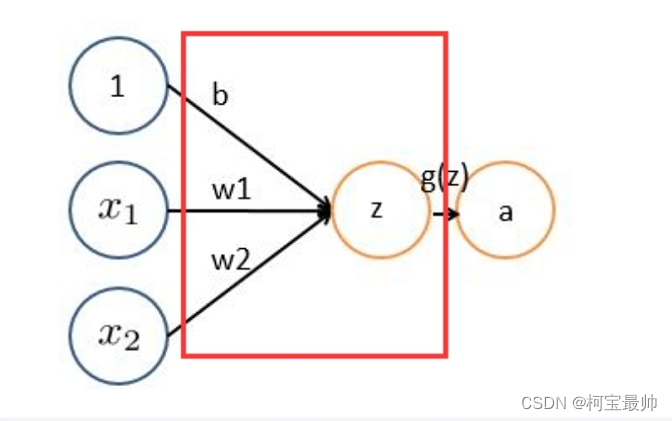

输入图像与可学习的核进行卷积操作,经过激活函数得到C1的特征图,卷积层的计算公式如下: