热门标签

热门文章

- 1设计模式学习笔记 - 开源实战二(中):从Unix开源开发学习应对大型复杂项目开发

- 22023年亚太杯数学建模C题新能源汽车(思路模型代码)_城市中新能源电动汽车(包括电动公交车)电气化对生态环境的影响

- 3书名终于确定了:Elasticsearch从原理到实践_elasticsearch 最新书

- 4python能写数据库吗_用 Python 写一个 NoSQL 数据库

- 52021年华中科技大学计算机学院考研指南_华科计科报考指南

- 6Java | 字节流与字符流的区别_java字节流和字符流的区别

- 7【PostgreSQL内核学习(二)—— 查询分析】_postgresql 查询

- 8树莓派Pico开发板扩展ESP01S无线WiFi模块通信实践_esp01s pico

- 9SpringCloud整合ElasticSearch搜索使用

- 10浅谈pygame.sprite的精灵碰撞_pygame中sprite

当前位置: article > 正文

TensorRT从入门到了解(2)-学习笔记

作者:羊村懒王 | 2024-04-18 13:45:07

赞

踩

TensorRT从入门到了解(2)-学习笔记

1.TensorRT的高性能部署简介

tensorRT,nvidia发布的dnn推理引擎,是针对nvidia系列硬件进行优化加速,实现最大程度的利用GPU资源,提升推理性能

tensorRT是业内nvidia系列产品部署落地时的最佳选择

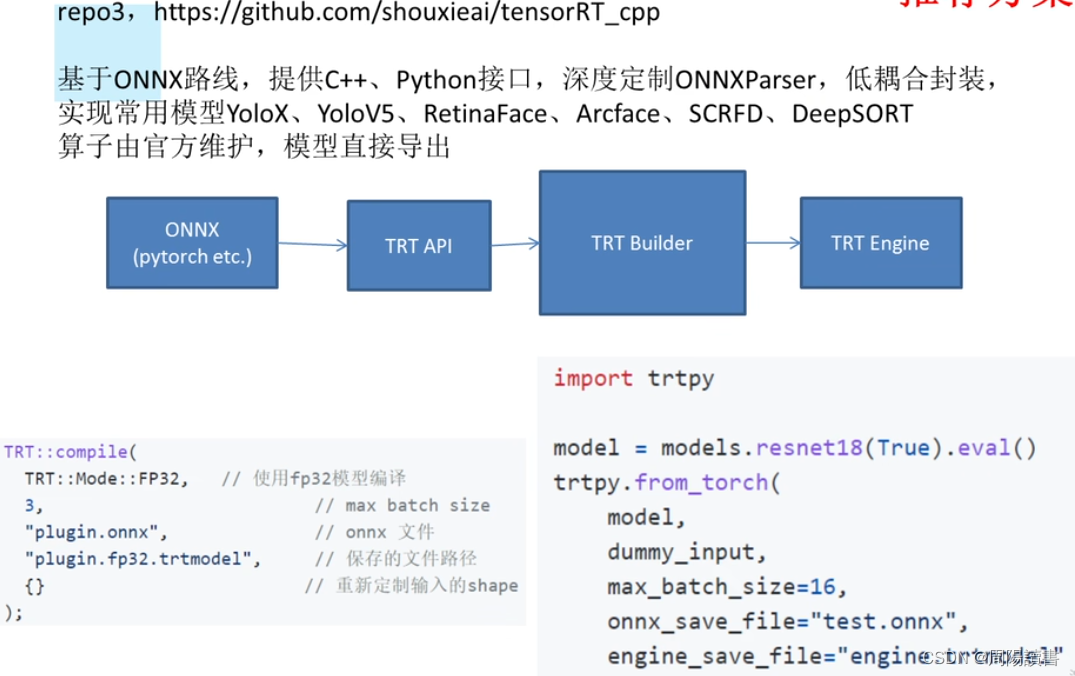

这里主要是围绕https://github.com/shouxieai/learning-cuda-trt

https://github.com/shouxieai/tensorRT_cpp提供的方案开展讨论,使得能够使用、部署起来。

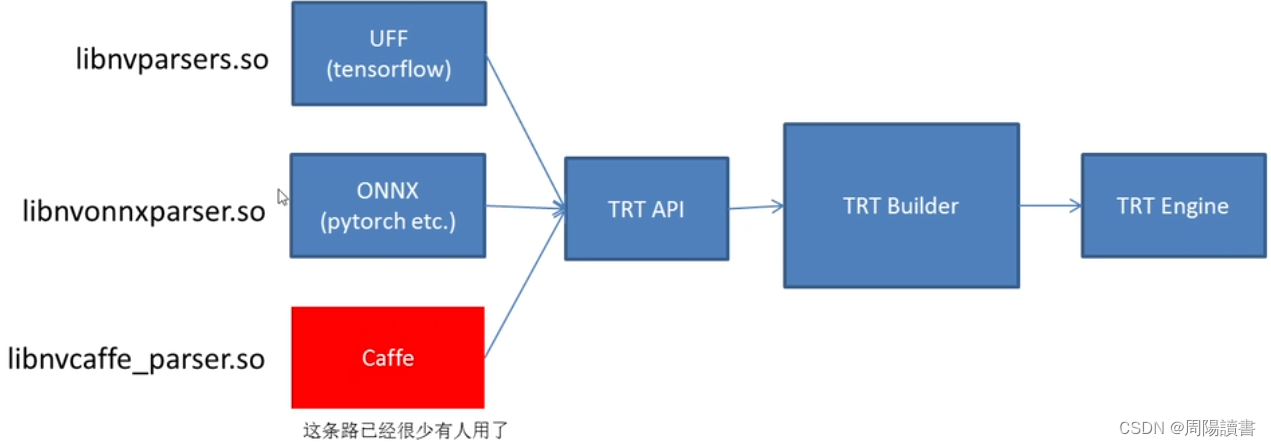

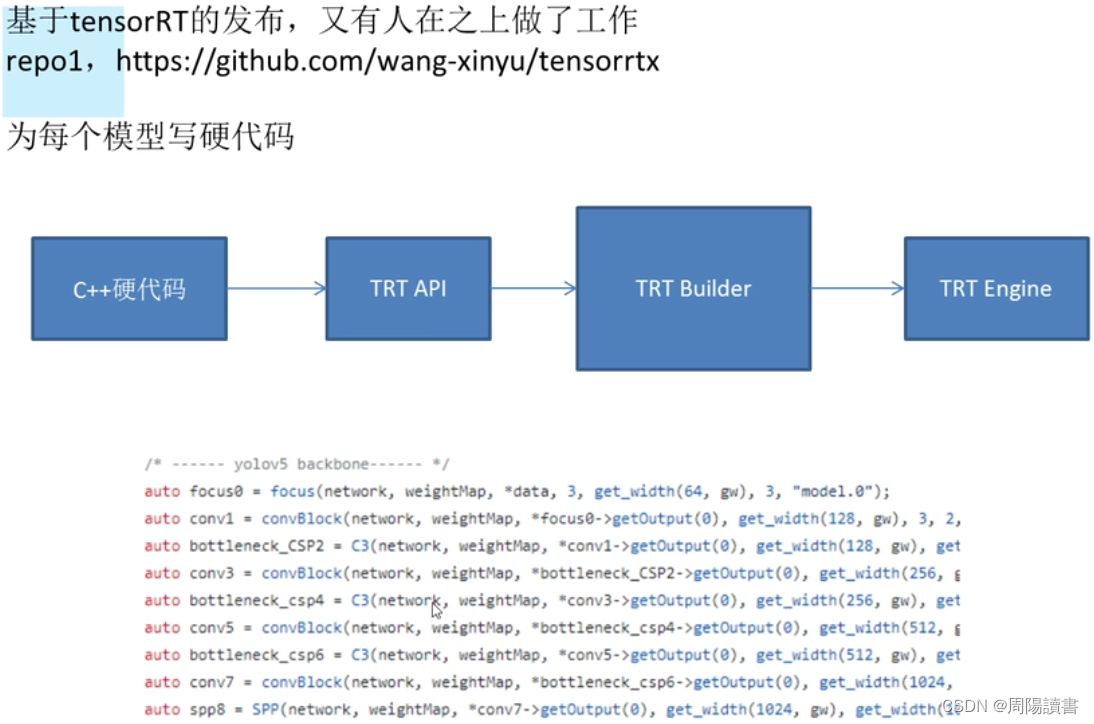

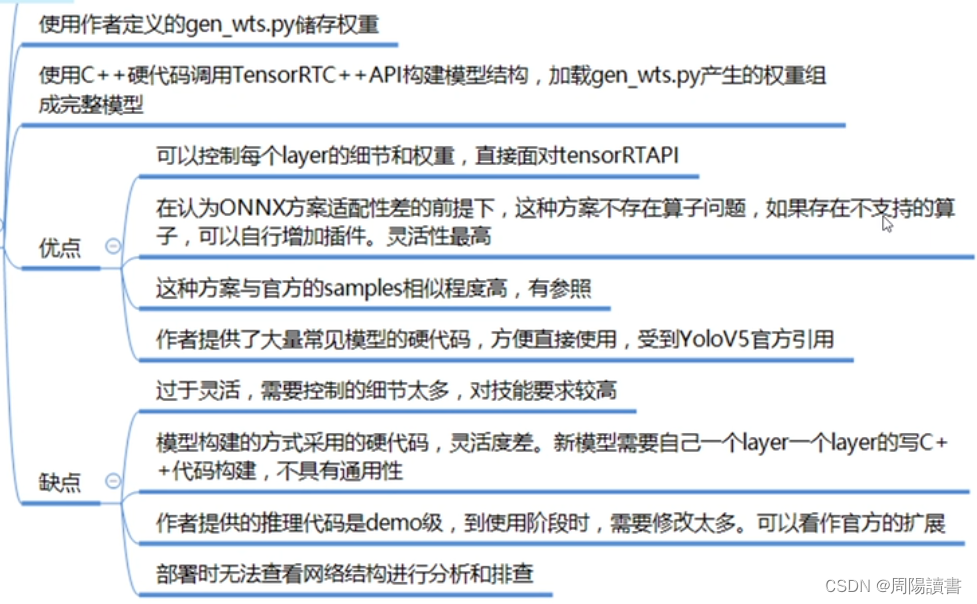

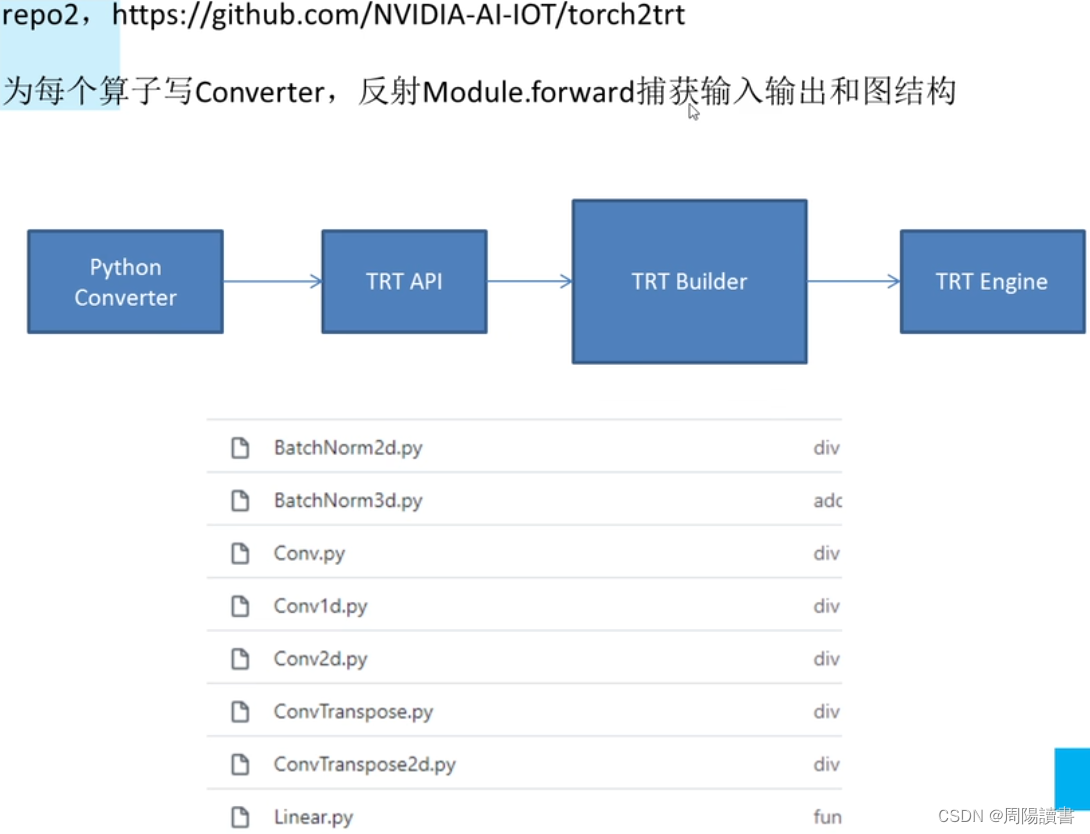

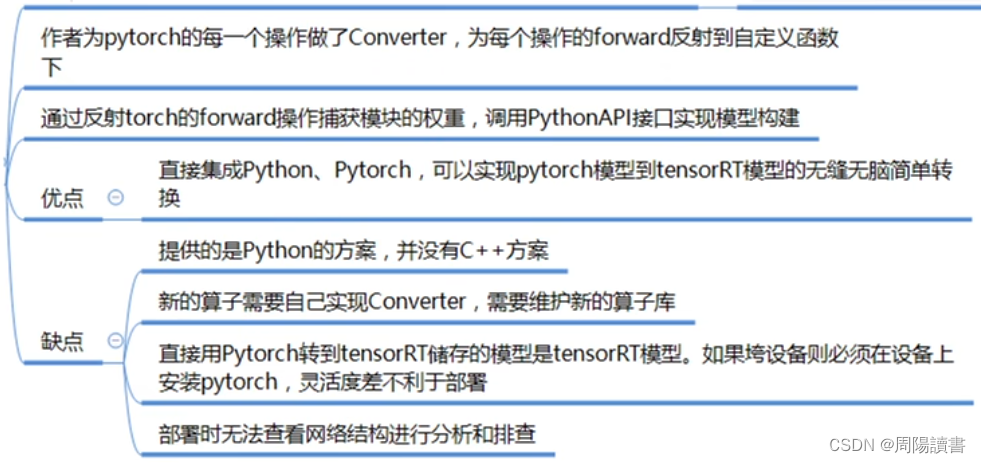

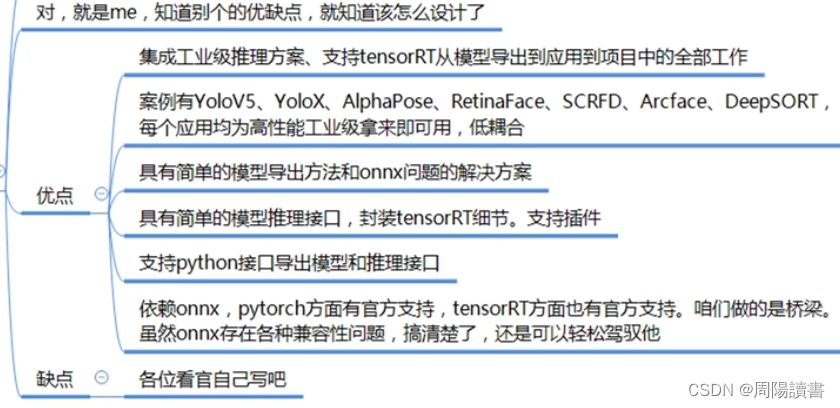

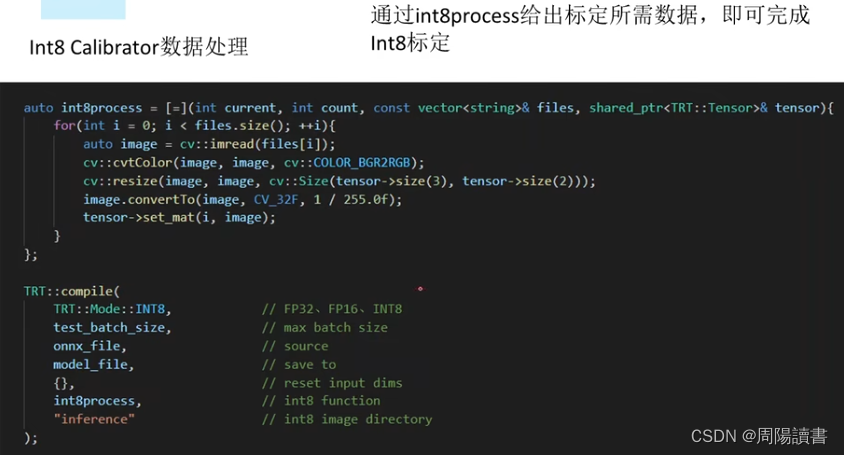

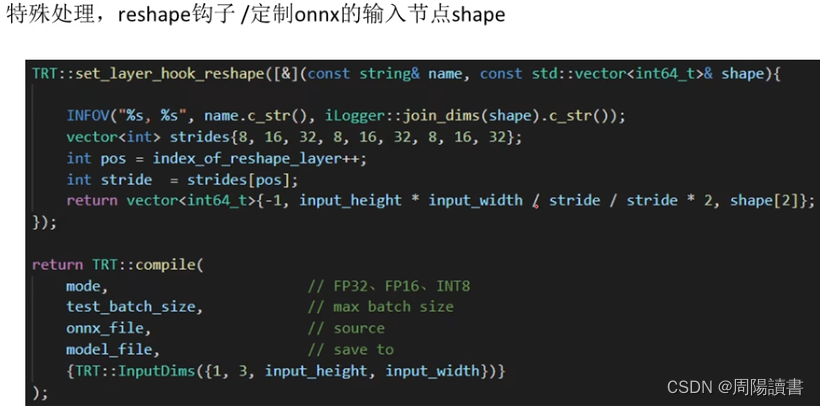

2.TensorRT驾驭方案

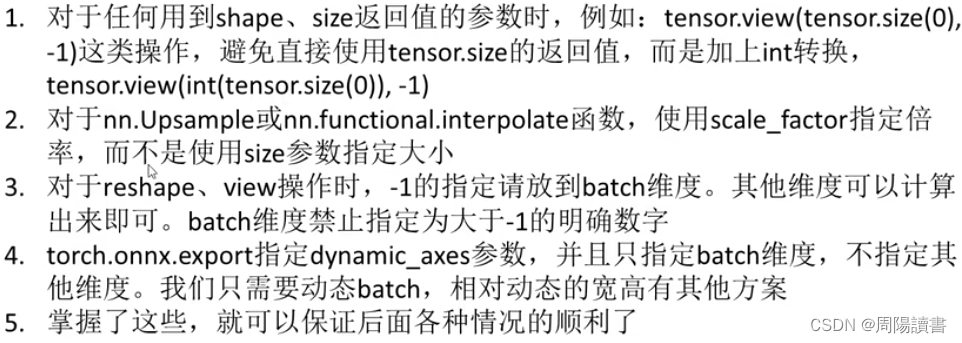

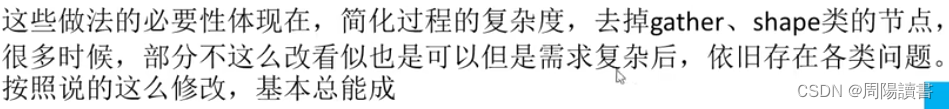

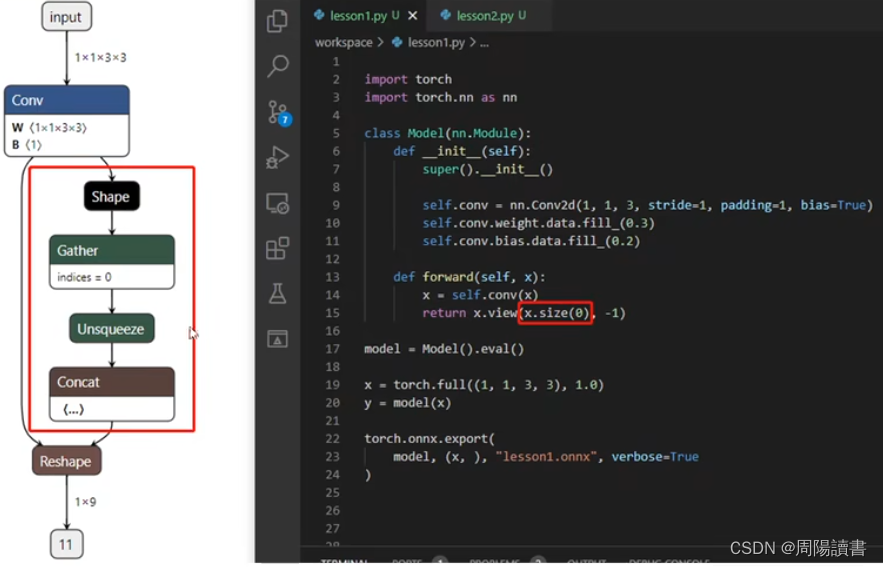

3.如何正确导出onnx

例如,原始

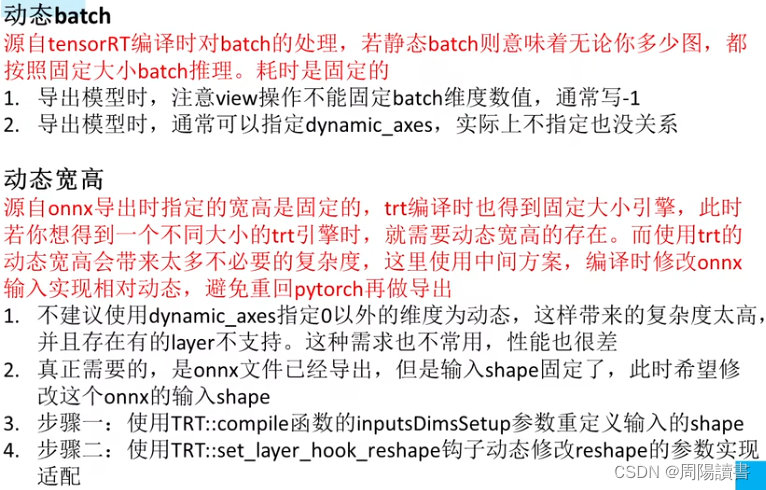

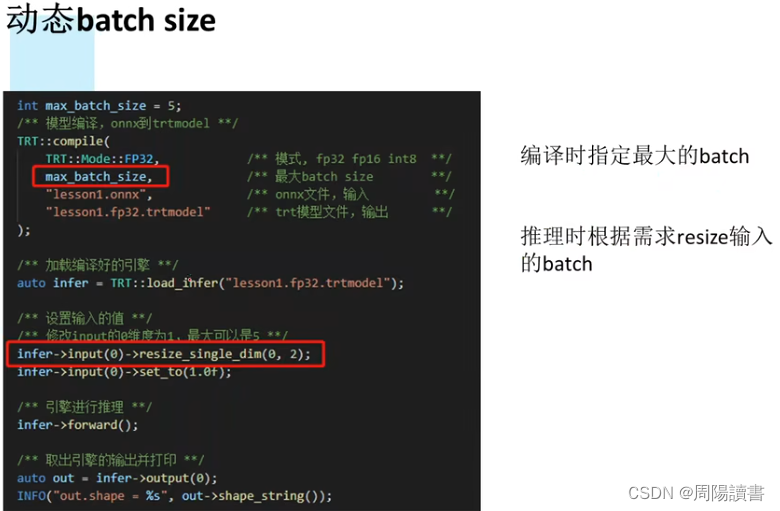

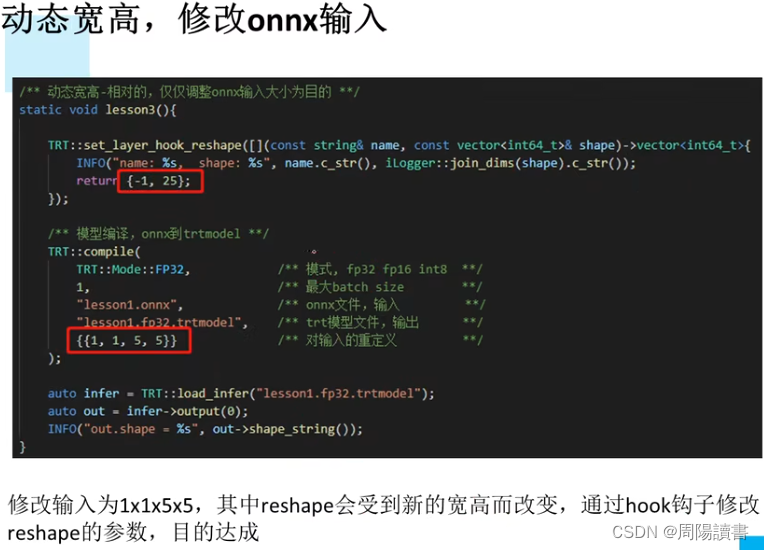

4.动态batch和动态宽高的实现

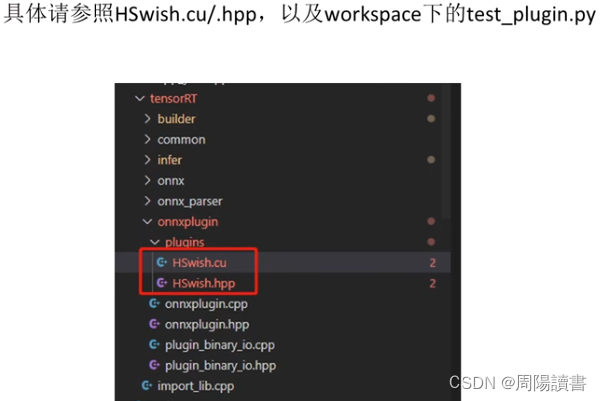

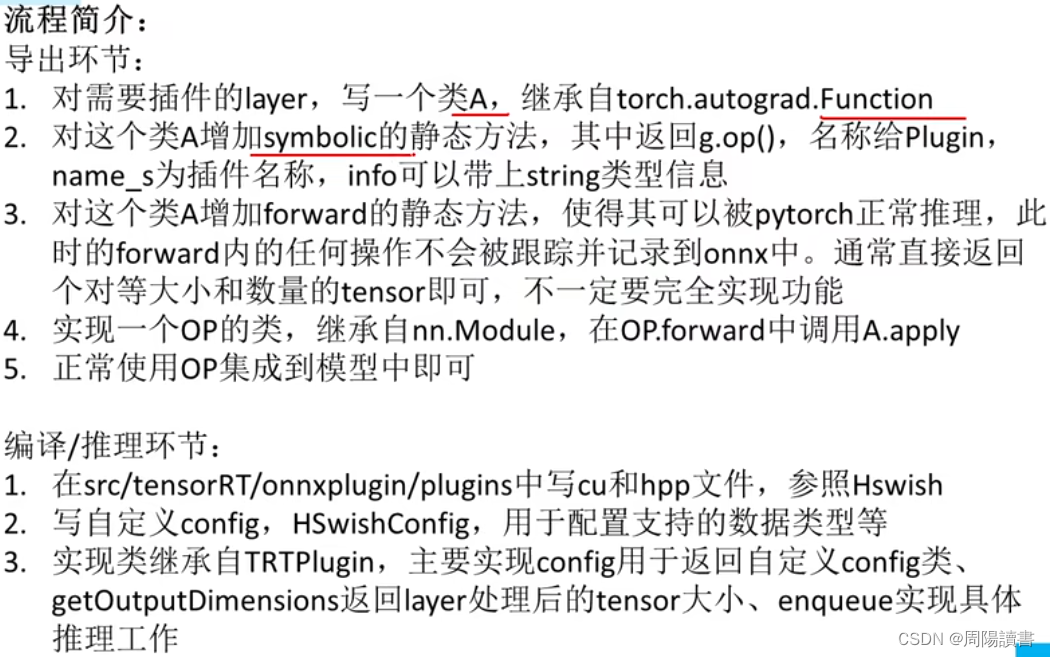

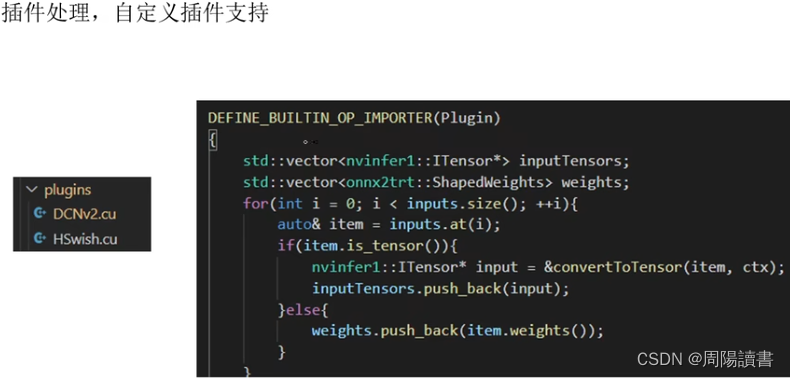

5.实现一个自定义插件

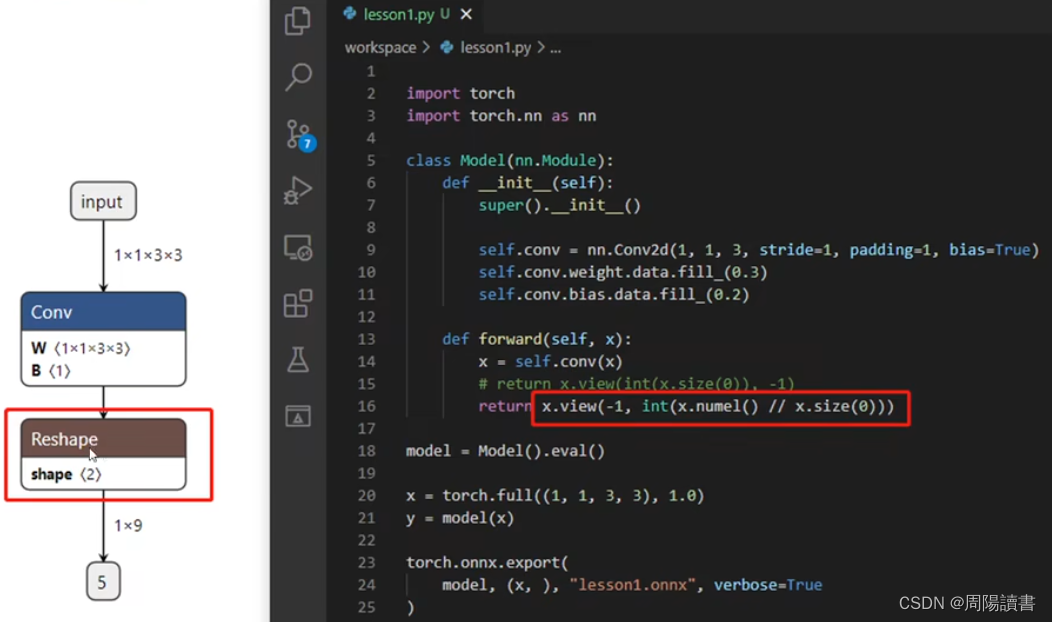

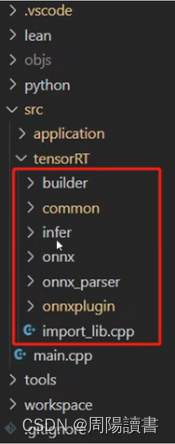

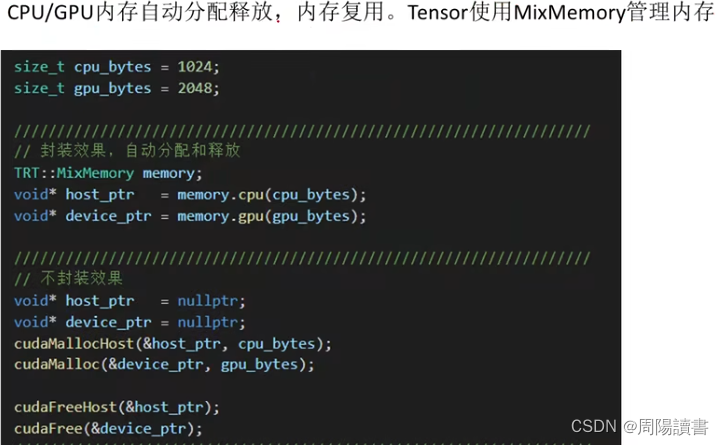

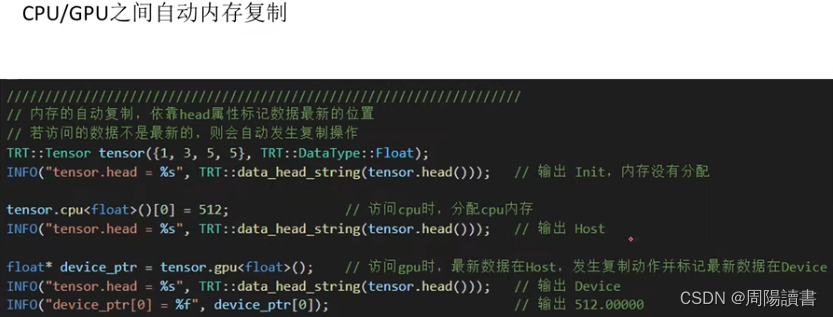

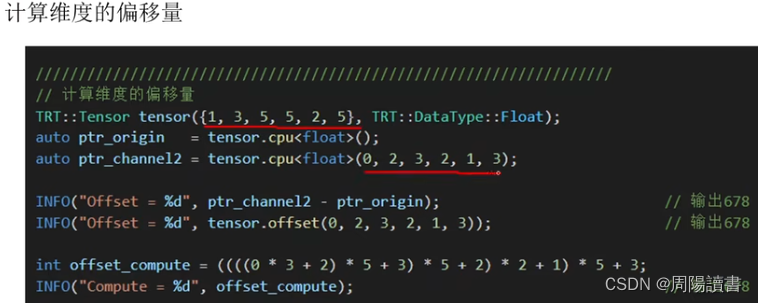

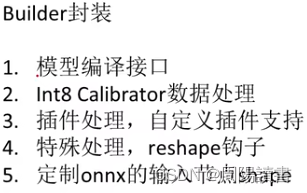

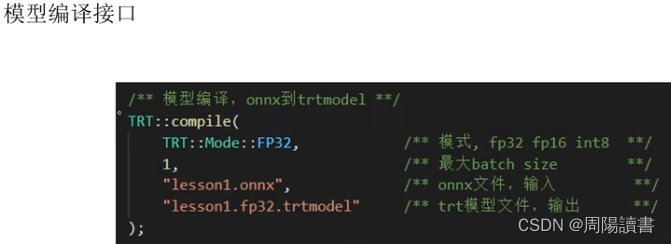

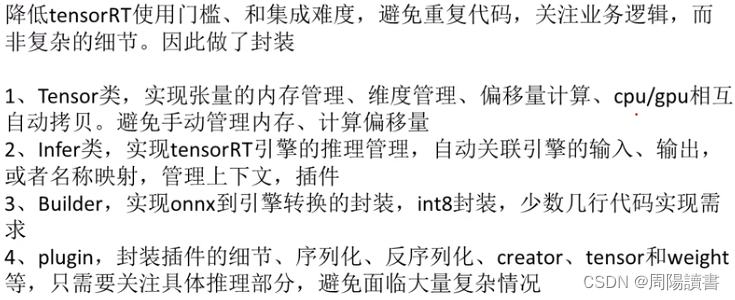

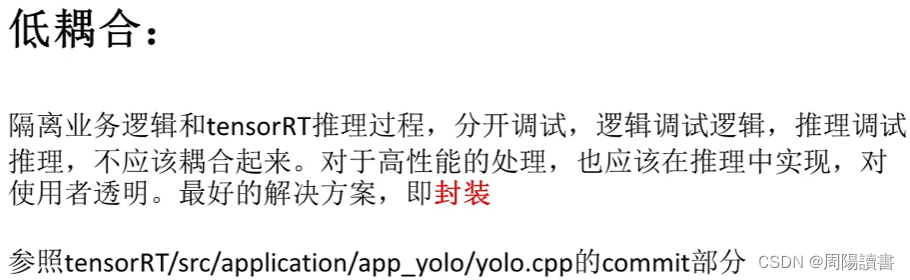

6.关于封装

封装,关注业务逻辑,避免细节

封装,关注业务逻辑,避免细节

主要是介绍该封装库代码工程,在github上,可下载下来研究

主要是介绍该封装库代码工程,在github上,可下载下来研究

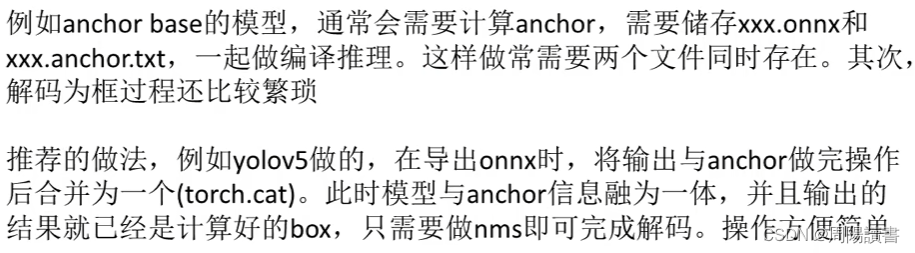

7.YoloV5案例

https://github.com/ultralytics/YOLOv5

8.Retinaface案例

https://github.com/biubug6/pytorch_Retinaface

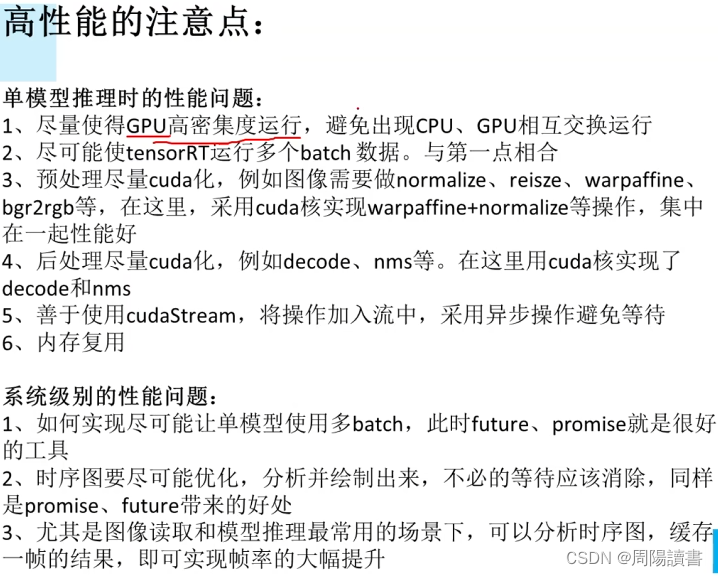

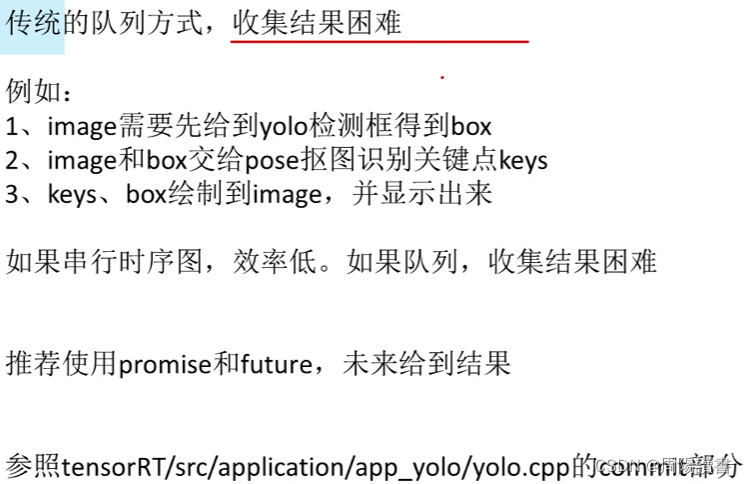

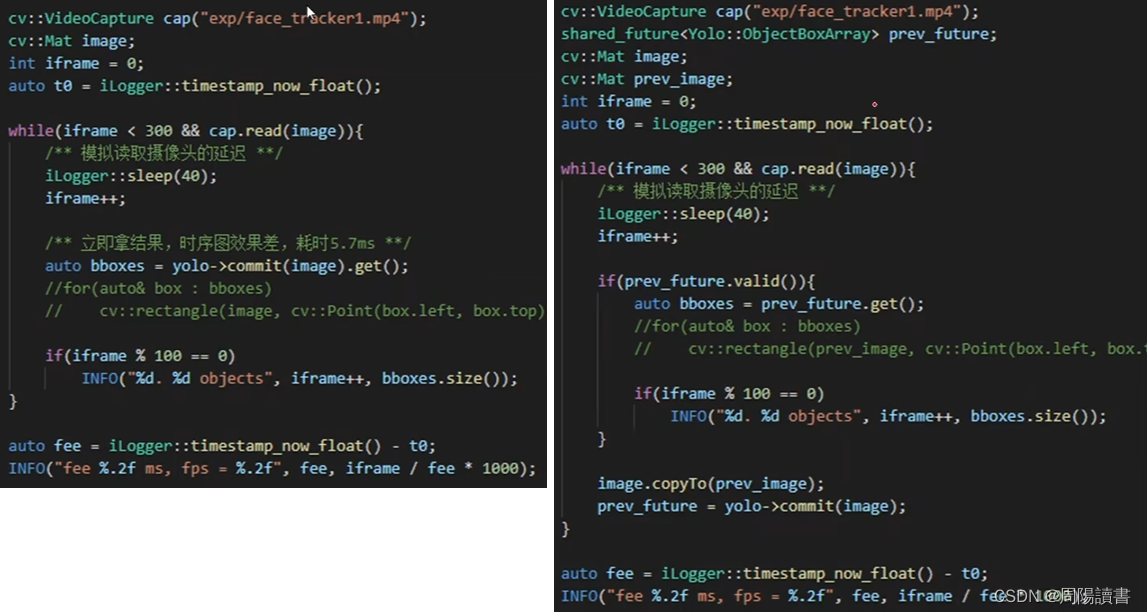

9.高性能低耦合

便捷性

10.YOLOX集成

参考

1.详解TensorRT的C++/Python高性能部署,实战应用到项目

2.作者博客,手写AI

zifuture.com

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/羊村懒王/article/detail/446274

推荐阅读

相关标签