热门标签

热门文章

- 1ngrok验证auth_使用Auth0可以轻松进行React身份验证

- 2用flutter实现类似startActivityForResult和onActivityResult功能

- 3Python字符串和列表相互转换_python 列表字符串转列表

- 4Cache -Control缓存_iis cache control

- 5探索UML类图:软件建模的关键概念和Visual Paradigm的优势

- 6跑得好好的Java进程,怎么突然就瘫痪了?

- 7Stata中一些令人困扰的易错函数——sum()和total()_stata total函数

- 82024年甘肃省职业院校技能大赛信息安全管理与评估任务书卷①—网络安全渗透、理论技能与职业素养_漏洞发现 学习 素质目标

- 9数据资产入表及估值实践与操作指南、中国数据交易市场研究分析报告(2023年)、数据交易PDCA模型、数据交易安全港白皮书、数据要素市场发展指数2023、全国数商产业发展报告2023、全球数据跨境流动

- 10【PTA】【数据结构与算法】队列_循环顺序队列中是否可以插入下一个元素

当前位置: article > 正文

ollama本地部署大模型(纯CPU推理)实践_ollama cpu

作者:羊村懒王 | 2024-05-07 23:10:43

赞

踩

ollama cpu

说明

- 本文旨在分享在linux(centos8)平台使用docker部署轻量化大模型,仅供学习和体验,无法适用于生产环境

- 运维面板使用飞致云的开源面板1panel,使用ollamadocker方案快速部署大模型,总共需要两个dcoker环境:ollama 容器环境和ollama WebUI容器环境

Ollama和Ollama WebUI简介

- Ollama :一个开源的大型语言模型服务,提供类似 OpenAI 的 API 接口和聊天界面,可以非常方便地部署最新版本的 GPT 模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

- Open WebUI:针对 LLM 用户友好的 WebUI,支持的 LLM 运行程序包括 Ollama、OpenAI 兼容的 API。

Ollama模型硬件要求

- Ollama 支持 ollama.com/library 上提供的一系列模型

内存要求

- 注意:运行 7B 型号至少需要 8 GB 可用 RAM (内存),运行 13B 型号至少需要16 GB可用 RAM (内存) ,运行 33B 型号至少需要32 GB 可用 RAM (内存)。

- 示例模型

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| Vicuna | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

Ollama容器部署

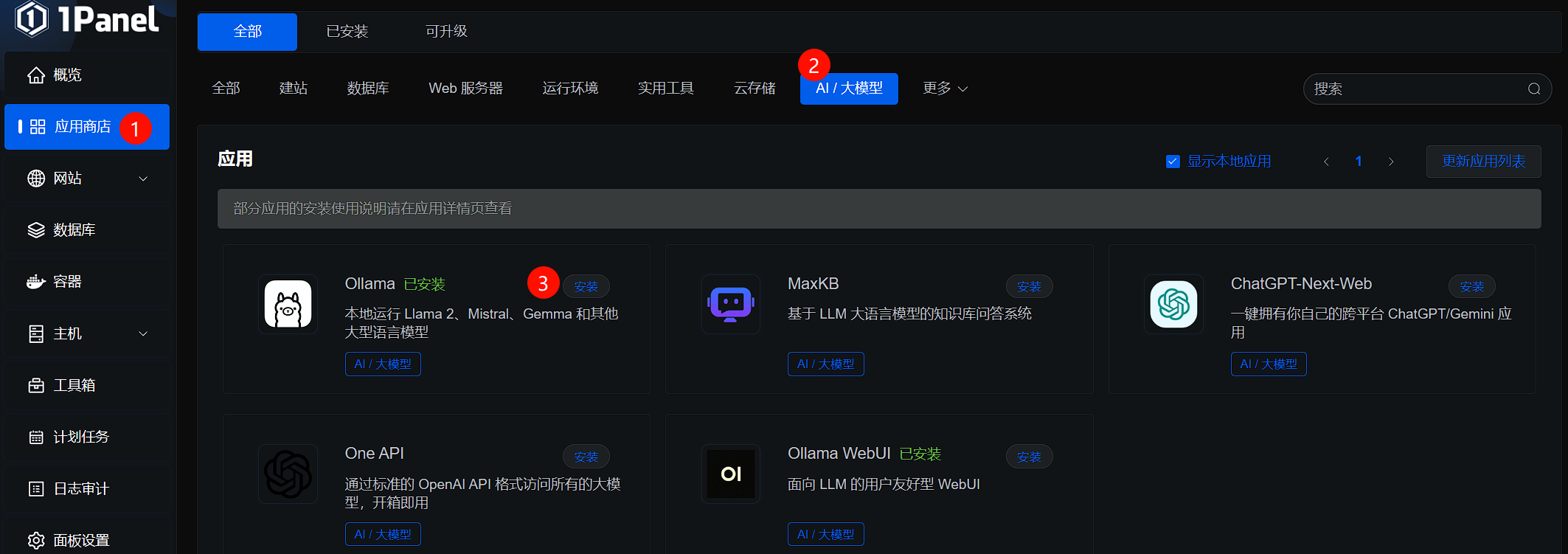

- 在1Panel应用商店中选择Ollama进行安装

- 配置容器的启动配置:容器名称、端口,最后,点击启动即可

Ollama容器内模型下载和对话

- 根据机器内存和CPU性能可以进入容器,下载示例模型

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| Vicuna | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

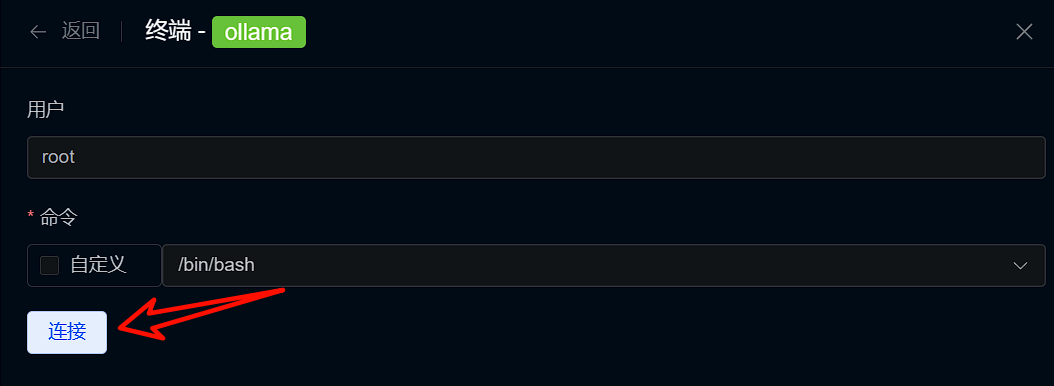

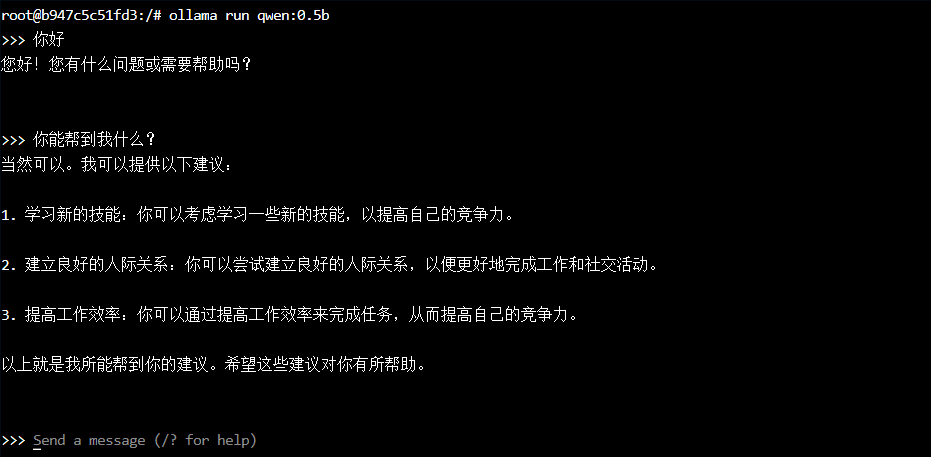

- 按照操作,进入容器终端

- 点击连接进入容器内部,输入

ollama run qwen:0.5b下载模型,下载成功后,自动启动对话

- 存在的缺点:需要进入容器进行对话,只能在终端进行,不方便,不优雅

Ollama WebUI部署

- 有关ollama WebUI镜像拉取缓慢的问题和部署的内容,请阅读一下两篇文章

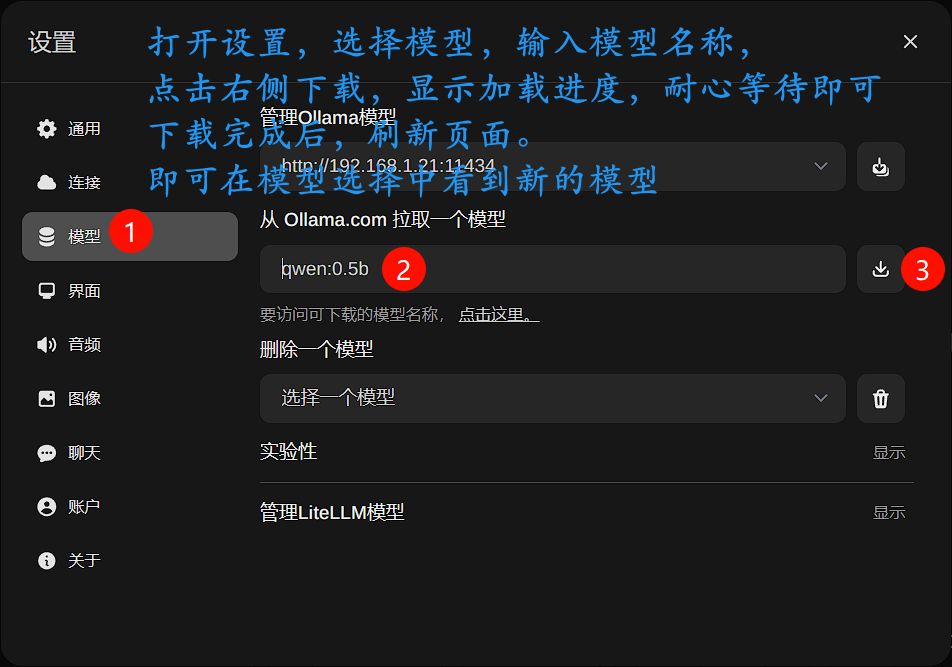

Ollama WebUI下载模型和对话

- 选择模型进行下载,然后刷新页面

- 然后,选择模型进行对话,这效果(只能图一乐)声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/羊村懒王/article/detail/551720

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。