- 1二进制安装The connection to the server localhost:8080 was refused - did you specify the right host

- 2HTTP 503错误是什么,HTTP 503错误的原因和解决方法

- 3网络设备自动巡检工具(二)——主界面和设备列表的设计【2020-10-27】_交换机巡检工具

- 4Hikvision SPON IP网络对讲广播系统命令执行漏洞

- 5DICOM笔记-医学图像读取涉及到的医学坐标体系_mri从左到右x轴

- 6为H5浏览器添加串口操作能力_html5串口界面

- 7spring cloud config关于“No decryption for FailsafeTextEncryptor”异常解决方案_no encryption for failsafetextencryptor. did you c

- 8如何在linux服务器上搭建Git服务_linux 服务器怎么转git

- 9基于Vue3+Go本地视频管理与播放系统设计与实现_用go语言实现能够查看学习视频的系统

- 10XMall 开源商城 SQL注入漏洞复现(CVE-2024-24112)_exrick xmall 开源商城 sql注入漏洞

跨模态行人重识别综述 - 计算机视觉

赞

踩

跨模态行人重识别综述 - 计算机视觉

0 引言

近年来,随着智能监控领域的不断发展,单纯凭借传统的人力已经很难在对复杂的监控场景做出完善详尽的处理。作为一项在大型非重叠视角多摄像机网络获取到的海量视频画面序列里找到目标行人的任务,行人重识别(PersonRe-Identification)可以被看作是多摄像头的行人检索问题。它建立在行人检测的基础之上,捕捉获取同一目标个体在不同非重叠摄像头中分布位置信息,推动了智能安保、智能视频监控、智能检索等领域的发展。

然而在实际应用场景下,摄像头应保证全天候的运作。由于可见光摄像头对夜间的监控安防工作作用有限,随着科技的进步发展,能够切换红外模式的摄像头正被广泛应用于智能监控系统。在可见光模式和红外模式下,分别采集到的是 RGB 图像和红外图像,这是属于两种不同模态的数据,因此跨模态行人重识别问题被提出,随之引起了广泛的关注

1 介绍

1.1 行人重识别

行人重识别作为计算机视觉领域的研究方向之一,近年来获得了一定关注。它被认为是一个利用计算机视觉技术对给定图像进行非重叠摄像头检索,从而识别出属于同一个行人图像的问题。行人重识别任务的起源最早可以追溯到1997年的多摄像头追踪问题,2014年,将深度学习中的孪生网络(SiameseNet⁃work)引入了行人重识别任务,从此开始将深度学习应用于行人重识别,形成了端对端的行人重识别系统。相较于之前大多基于手工设计的行人重识别系统,有了实质性的进展[1-2]。

基于深度学习的行人重识别可主要分为封闭世界方法(Closed-World Person Re-Identification)和开放世界方法(Open-World Person Re-Identification)两大类[3]。过去的行人重识别研究主要集中在基于封闭世界的设定上,用于训练和测试的数据为单一模态下已生成检测边界框的图像,且经过人工筛选处理和准确标注,能够保证同一个体在训练集和测试集中都有分布。相对的,开放世界方法更接近实际场景应用,其用于训练和测试的数据往往跨越单一模态,跨模态行人重识别问题属于其中的一种,它主要研究RGB图像和红外图像之间属于同一行人个体之间的匹配检索问题。

1.2 跨模态行人重识别

在以往对行人重识别的研究中,用于训练和测试的数据集往往都是单模态的RGB图像,然而在现实场景应用中,红外模式摄像头、深度摄像头,以及目击者陈述所捕捉描述的行人图像都是十分常见的。跨越可见光和红外两种模态下捕捉的行人重识别问题是其中亟待解决的一种。跨模态行人重识别,主要研究在给定一个特定个体的可见光图像或者红外图像,尝试在两种模态下的图像库中检索匹配属于同一个体图像的问题。该问题于2017年在行人重识别领域首次被Wu等人[4]提出定义。他们提出了一个跨模态行人重识别框架,并提供了一个公开的大规模 RGB-红外多模态行人 数 据 库 ,名 称 为 SYSU Multiple Modality Re- ID(SYSU-MM01)。之后开始有大量相关工作涌现,然而距离跨模态行人重识别能够投入实际场景中应用依旧存在许多问题。

目前,跨模态行人重识别问题面临的困难与挑战主要在于:

(1)两种模态下捕捉的图像存在较大差异。RGB图像拥有三个通道,包含了红绿蓝的可见光颜色信息,而红外图像只有一个通道,包含了近红外光的强度信息,而且从成像原理的角度出发,二者的波长范围也有所区别。不同的清晰度和光照条件在两类图像上所能产生效果可能会大相径庭。

(2)数据集较为单一且规模较小。虽然现在已经有许多工作致力于扩充行人重识别数据集,然而数据集中的图像大多来源于相似型号以及角度的机位,和实际中多样化的场景差距较大。

(3)传统行人重识别中存在的模态内差异,例如低分辨率、遮挡、视角变化等问题在跨模态行人重识别中也依旧存在。

2 跨模态行人重识别方法

2.1 基于表征学习的方法

基于表征学习的方法主要研究如何设计建模合理的网络架构,能够提取两种模态图像共享的具有鲁棒性和鉴别性的特征,尽量缩小模态间存在的差异性,输入到共享参数的网络,从而比较二者的相似性。2017年,Wu等人[4]首次在行人重识别领域提出定义了跨模态行人重识别问题,分析了三种网络架构,并提出了一种深度补零的数据预处理方法,比较评估了这四种网络的性能。其中,三种网络架构分别为单流网络、双流网络以及非对称全连接层结构。经过研究发现,这三种网络在特殊情况下都可以使用单流网络来表示。通过将不同模态的数据通道置于不同的对应通道,而将属于其他模态的置零,从而提出深度补零的单流网络。网络中不同的节点对应不同的模态数据会选择性“失活”,同时也存在始终激活的节点,针对不同模态数据的输入,可以进行不同的特征提取操作。

2018 年,Ye 等人[5]提出了一种分层的跨模态匹配模型,该模型通过联合优化模态特异性和模态共享矩阵来实现,其框架分为表征学习和度量学习两个部分,前者通过构造一个双流网络对分属两个模态的图像输入进行特征学习,再结合特征损失和对比损失进行相似度的学习。Dai 等人[6]为解决识别信息不足的问题,利用了GAN生成器和判别器对抗训练的思想,提出了一个交叉模式生成对抗网络,该网络分为生成器和判别器两个部分。生成器使用三元组损失和身份损失进行训练,从而使得同一身份下不同模态行人之间的相似性增加,而不同身份且不同模态的行人之间的相似性会减小;判别器则使用RGB图像和红外图像的二分类损失进行训练,从而和生成器展开对抗,减少二者特征的相似性。之后,为了解决模式间和模式内的差异这两个问题,Liu 等人[7]提出了一种增强鉴别学习的方法(Enhancing the Discriminative Feature Learning,ED⁃FL),通过采用跳跃连接从而融合中间层特征,增强了特征的鲁棒性。Zhang等人[8]提出了一种双路径交叉模态特征学习框架,主要由双路空间结构保持公共空间网络(DSCSN)和对比相关网络两部分组成。前者利用部分共享结构,学习跨模态结构共同空间特征,将交叉模态图像嵌入到一个三维张量空间从而保留空间结构;后者是通过关注两个相似对象的差异来模拟学习机制。Xiang 等人[9]利用 RGB 图像和红外图像之间的内在联系,提出了一个端到端的双路多分支交叉模态网络,通过结合图像的全局以及局部信息来提取鲁棒性特征。针对由于集中学习跨模态图像共同特征而丢失大量特异信息的情况,Lu 等人[10]一种新的跨模态共享特征转移算法(cross-modality Shared- Specific Fea⁃ture Transfer,cm-SSFT),在表示相似性的跨模态近邻吸引力模型的基础上引入模态特征,有效地利用了每个样本的共享信息和特定信息。

e 等人[11]提出了两个注意力模块机制去提高模型的识别能力和鲁棒性。模态内加权部分聚合模块(Intra-modality Weighted-PartAggregation,IWPA),将同一模态内的局部特征的权重聚合在一起;跨模态图结构化全局特征学习注意力模块(Cross-modality Graph Structured Attention for globalfeature learning,CGSA)利用跨模态的邻近结构关系去学习两个模态的全局特征。

2.2 基于度量学习的方法

基于度量学习的方法旨在通过网络学习出两张图片的相似度,关键在于设计合理的度量方法或者损失函数,从而使得在模态一致的情况下,属于同一个体的样本图像距离尽可能小,不属于同一个体的样本图像距离尽可能大;而不属于同一模态也不属于同一个体的样本图像距离尽可能大。

Ye 等人[12]提出了一种双向排序损失,将不同模态下属于同一个体的样本图像距离拉近,同时融合传统的交叉熵损失,从而达到不同模态特征进行融合的目的。Lin 等人[13]提出了一种新的特征学习框架。在该框架中,对现有的单模态行人重识别模型进行了修正以适应跨模态场景,并设计了一种难五联损失函数,它由难全局三元组损失和难跨模态三元组函数组成,从而有效处理跨模态变化和内模态变化,再结合身份损失以提高修正后的跨模态重识别模型的准确性。

Hao等人[14]提出了一种具有分类和识别约束的端到端双流超球面流形嵌入网络(Hyper-SphereManifoldEmbed⁃dingnetwork,HSMEnet),与传统映射到欧氏空间不同,该网络设计了SphereSoftmax函数将样本的深度特征映射到超球上,使模型能够学习该超球的判别表示,在这个超球面上,两个样本图像之间的距离可以通过它们的特征向量的角度来确定,结合身份损失和排序损失进行训练,再通过 KL 散度衡量两个领域的相似性。

最后,通过单矢量分解方法对 Sphere Softmax 最大值权矩阵进行了修正,从而由高相关状态转换为低相关状态。Ye等人[15]提出了一种基于双流网络的模态意识协同学习方法(Modality-AwareCollaborative,MAC),提出了基线分类器、模态特异分类器和模态分类器,进行多分类器的协同学习。Zhu等人[16]提出一个简单且高性能的网络架构来学习跨模态人再辨识的局部特征表示。由于直接约束模态分布之间的距离比较困难且代价高昂,所以使用两个模态分布之间的中心距离来代替两个模态分布之间的距离,从而缩小每个类中两个模态特征分布之间的距离。针对忽略了一致模态下样本相似性,Jia等人[17]提出了一种新颖的相似性推断度量(Similarity Inference Metric,SIM),该度量方法利用一致模态内样本图像相似性来规避针对跨模态图像匹配的跨模态差异,通过连续相似图推理和相互最近邻推理进行训练,从两个不同的角度利用一致模态内样本图像相似性来挖掘跨模态样本相似性,缩小了模态间差异。

2.3 基于生成跨模态图像的方法

随着近年来 GAN 的快速发展,实现模态的相互转换,将跨模态行人重识别问题转化为单模态的行人重识别问题,这在很大程度上减少了模态间的差异这一难点。为了实现两者的相互转换,Wang 等人[18]提出了一种双层 差 异 减 少 方 法(Dual- level Discrepancy Reduction Learning,D2RL),分为两个部分,先使用变分自编码器消除模态之间的差异,再使用传统的行人重识别方法约束外表特征差异。Wang 等人[19]一种用于跨模态行人重识别任务的端到端对齐生成对抗网络。像素对齐模块将RGB图像转化为红外图像;特征对齐模块把真实的红外图像和合成的红外图像映射到同一个特征空间,并使用基于身份标签的分类和三元组损失来监督特征;联合判别模块负责判别真假红外图像,通过身份一致性特性使得前两者互相学习从而得到鲁棒性特征。

Zhang 等人[20]提出了一种基于不同域的师生模型(TS-GAN),使用了两个模态的图像相互生成作为指导,但仅使用了 RGB 图像生成 IR 图像作为教师-学生模型的输入,分为用于RGB图像生成IR图像的GAN、提取特征的主干网络和预训练教师模型这三个模块,这三个模块互相指导,从而提升了 GAN 生成图像效果。为解决不同摄像机带来的交叉光谱问题,Fan等人[21]提出了跨光谱双子空间配对模型(Cross-spectrum Dualsubspace Pairing,CDP)模型来生成多种光谱的图像,利用生成的样本帮助网络找到鉴别信息,从而实现对同一个人的跨模态重新识别。

3 具体方案

3.1 基于生成对抗网络的方法

(1)网络结构图(AAAI 2019)

(2)使用方法

首次使用生成对抗网络处理跨模态行人重识别,主要包含一个生成器(G)联合辨别器(D)以及特征对齐模块(F),首先使用生成器生成跨模态图像,在像素空间上缓解模态差异。通过将RGB生成IR风格图像,然后使用renet-50将两种模态数据映射到同一特征空间,使用三元组损失,和ID损失来监督网络进行特征对齐。

(3)缺点

网络与特征学习网络相比参数量巨大,且训练时不易收敛,生成图像易受到背景信息干扰,生成图像不理想。

3.2 基于特征学习的方法

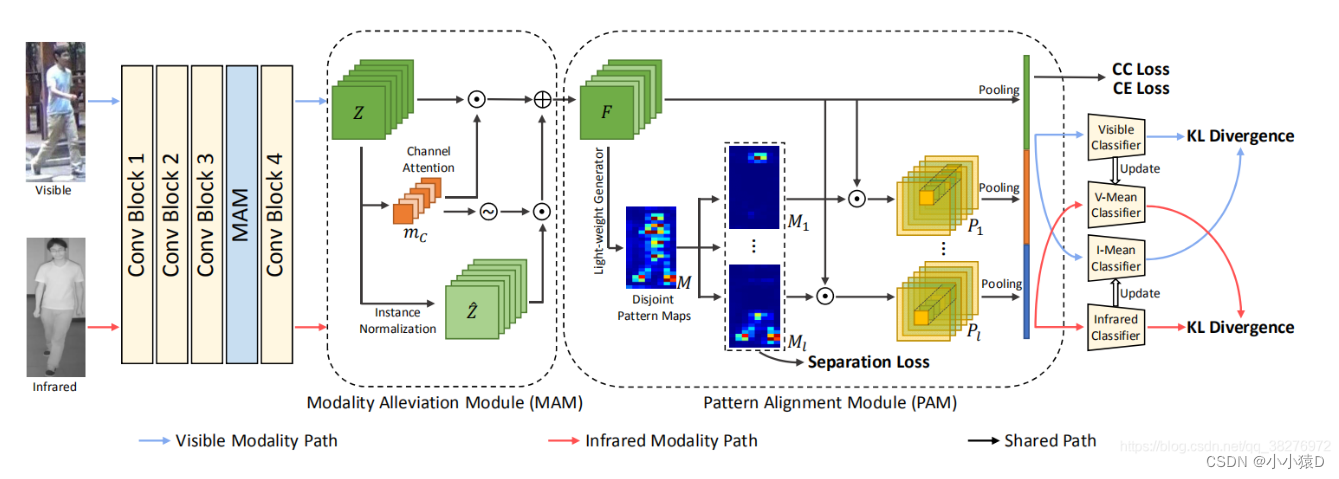

3.2.1 网络结构图(cvpr2021)

3.2.2 使用方法

MAM 从提取的特征图中去除模态信息(与模态无关的信息),采用注意力引导实例归一化,过滤与模态相关的特征。

PAM 它为一个人的不同模式生成多个模式图,以发现细微差别。采用1*1卷积生成6张mask,采用分离损失将mask覆盖到每个人身体部位,将mask点乘到全局特征图。以此达到发掘人体部位的细微差别。

3.2.3 缺点

采用分离损失只能保证减小mask在人体部位的重叠程度,但不能让每张mask都准确掩盖在身体部位。

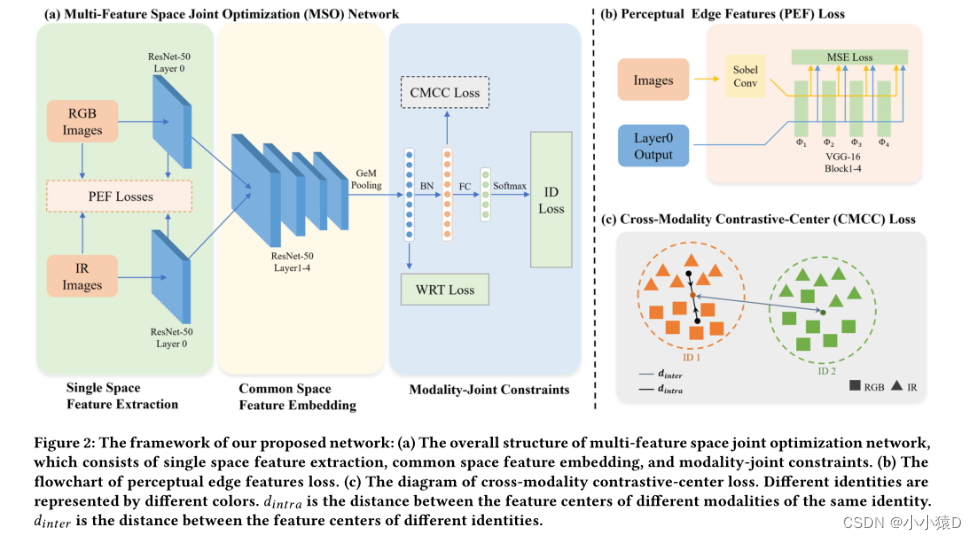

3.3.4 网络结构图(ACM2021)

3.3.5 使用方法

对于跨模态任务,主要是通过寻找与模态无关特征,人的身体轮廓在RGB和IR模式下是不变的。

基于边缘信息是模态不变性的研究,提出了一个边缘特征增强模块来增强每个单模态空间中的模态共享特征,在边缘融合策略分析后设计了一个感知边缘特征(PEF)损失。

为了增加跨模态距离和类距离之间的差异,我们在公共特征空间中的模态联合约束中引入了一种新的跨模态对比中心(CMCC)损失。

3.3.6 缺点

由于行人在不同镜头下的姿态不同,人的身体轮廓会发生变形,轮廓信息并不能直接提供辨别性信息。

行人容易受到遮挡,此时网络应该关注非遮挡部分,提取边缘信息的方法变得不太适用。

4 数据集及评价指标

为了评估跨模态行人重识别方法的性能,现有两个同时包含 RGB 图像和红外图像的公开基准数据集供研究实验,通过相同指标对不同方法进行比较。

4.1 数据集

SYSU-MM01 数据集[4]是 2017 年为研究跨模态行人重识别问题而提出的公开数据集,它包含了在白天的 4 个用于捕捉 RGB 图像的摄像视域以及在黑暗环境中用于捕捉红外图像的摄像视域,共有 491 个不同身 份 行 人 的 287628 张 RGB 图 像 和 15792 张 红外图像。

RegDB 数据集[22]共有 412 个不同身份的行人,分为 254 个女性和 158 个男性,每个人分别对应 10 张RGB 图像和 10 张红外图像,其中拍摄到 156 个行人的正面,256 个行人的背面。该数据集总共有 4120 张RGB 图像和 4120 张的红外图像。

4.2 评价指标

(1)CMC 曲线

CMC(Cumulative Match Characteristic,CMC)曲线,即累积匹配曲线,它反映了分类器性能,一般使用Rank-k 表示,表示按照某种相似度匹配规则匹配后, 第 n 次能判断出正确的行人标签的测试数目与总的测试样本数目之比。例如 Rank-1 识别率就是表示第一次匹配检索后就能返回正确匹配的概率。

(2)mAP 均值平准精度

mAP(mean Average Precision)根据准确率-召回率曲线计算得到反应召回率。具体操作是分别求出每个类别的平均准确值后再次取平均值。平均准确值是求准确率-召回率曲线下的面积,综合考虑了准确率和召回率,是衡量一个模型好坏的标准。

5 我的观点

对于生成对抗网络方法1,因该寻找新的损失函数监督网络,如何让网络生成的质量更高的IR图像将会对ReID有质的提升。

对于网络2,如果每张mask能覆盖在人体的部位,就能减小背景干扰,可以采用图像分割或者姿态估计来让mask精准覆盖在关节部位,这些部位能为我们提供更多的辨别信息。

对于网络3,人体边缘信息能够提供有用信息,但是并不能仅靠边缘轮廓作为最后检索特征,应该学习细微特征如眼镜,衣服长短,行走姿势等。

意义:

本文对跨模态行人重识别问题进行了研究,将现阶段的跨模态行人重识别方法分为基于表征学习的方法、基于度量学习的方法和基于模态互转的方法,并对这些方法进行了介绍。跨模态行人重识别作为当前行人重识别的一个分支方向,随着摄像监控系统的发展完善,在公共安全、预防犯罪和刑侦追查等领域有着重要意义,但目前的研究距离实际落地应用还有很长一段距离,可以预见到未来会持续涌现大量相关工作。

参考文献

[1]YI D,LEI Z,LIAO S,LI S Z,et al. Deep metric learning for person re-identification. ICPR,2014:34-39.

[2]Li W,ZHAO R,XIAO T,et al. Deepreid:deep filter pairing neural network for person re-identification. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2014:152-159.

[3]YE M,SHEN J,LIN G,et al. Deep Learning for Person Re-identification:A Survey and Outlook[J]. 2020.

[4]Wu A,Zheng W S,Yu H X,et al. RGB-Infrared Cross-Modality Person Re-identification[C]// 2017 IEEE International Conference on Computer Vision(ICCV). IEEE,2017.

[5]Ye M,Lan X,Li J,et al. Hierarchical discriminative learning for visible thermal pe re-identification[C]//Thirty-Second AAAI conference on artificial intelligence,2018.

[6]DAI P,JI R,WANG H,et al. Cross-modality person re-identification with generative adversarial training[C]// Twenty-Seventh International Joint Conference on Artificial Intelligence IJCAI-18,2018.

[7]LIU H,CHENG J. Enhancing the discriminative feature learning for visible-thermal cross-modality person re-identification[J],2019. [8]ZHANG S,YANG Y,WANG P,et al. Attend to the difference:cross-modality person re-identification via contrastive correlation[J],2019.

[9]XIANG X,LV N,YU Z,et al. Cross- modality person re-identification based on dual- path multi- branch network[J]. IEEE Sensors Journal,2019(99):1-1.

[10]LU Y,WU Y,LIU B,et al. Cross-modality person re-identification with shared-specific feature transfer[J],2020. [11]YE M,et al. Dynamic dual-attentive aggregation learning for visible-infrared person re-identification. ArXiv abs/2007.09314(2020):

n. pag.

[12]YE M,WANG Z,LAN X,et al. Visible thermal person re-identification via dual-constrained top-ranking[C]//Twenty-Seventh International Joint Conference on Artificial Intelligence IJCAI-18,2018.

[13]ZHAO Y B,LIN J W,XUAN Q,et al. HPILN:a feature learning framework for cross-modality person re-identification[J]. IET Image

Processing,2020,13(14):2897-2904.

[14]HAO Y,WANG N,LI J,et al. HSME:hypersphere manifold embedding for visible thermal person re-identification[J]. Proceedings of the AAAI Conference on Artificial Intelligence,2019(33):8385-8392.

[15]YE M,LAN X,LENG Q. Modality-aware collaborative learning for visible thermal person re-identification[C]//The 27th ACM International Conference. ACM,2019.

[16]ZHU Y,YANG Z,WANG L,et al. Hetero-center loss for cross-modality person re-identification[J]. Neurocomputing,2019.

[17]JIA M,ZHAI Y,LU S,et al. A similarity inference metric for RGB-infrared cross-modality person re-identification[J],2020.

[18]WANG Z,WANG Z,ZHENG Y,et al. Learning to reduce dual-level discrepancy for infrared-visible person re-identification[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR). IEEE,2020.

[19]WANG G,ZHANG T,CHENG J,et al. RGB-infrared cross-modality person re-identification via joint pixel and feature alignment[J],2019.

[20]ZHANG Z,et al. RGB-IR cross-modality person ReID based on teacher-student GAN model ArXiv abs/2007.07452(2020):n.pag.

[21]FAN X,et al. Cross-spectrum dual-subspace pairing for RGB-infrared cross-modality person re-identification. ArXiv abs/2003.00213(2020):n.pag.