- 130个极致实用的谷歌浏览器插件,让你开发事半功倍

- 2边缘计算背景介绍_边缘计算平台背景概括

- 3shell脚本耕升(一)_shell标准输出符号是 和 ,他们的区别是前者会先清空文件,再写入内容,而后者会将内

- 4使用VSCode+PlatformIO搭建ESP32开发环境_vscode安装platformio 下载esp32 websocket库

- 57zip命令

- 6[python]飞桨python小白逆袭课程day5——大作业来啦_百度飞浆用python调整图片清晰度

- 7Fastboot驱动及安装_高通fast boot驱动

- 8人工智能在医疗领域的应用

- 9Android 高级开发——NFC标签开发深度解析_wifi信息怎么写入ndefrecord

- 10Windows11下Edge浏览器登录工行农行并使用K宝U盾_中国农业银行edge安全扩展

机器人对话常用语模板_夸夸式闲聊机器人之Unilm对话生成

赞

踩

快让它夸夸你吧!夸夸式闲聊机器人夸到你满意为止~~~~~~

对话机器人分两种,即:任务式机器人和闲聊式机器人。任务式机器人主要目标是帮助用户解决带有特定需求的问题,而闲聊式机器人主要目的是陪用户闲聊,打发时间。

闲聊式机器人有分为:(1)模板式;(2)检索式;(3)生成式。

本着娱乐的心态,恰好前一段时间又开源了可以做生成的unilm模型,链接如下:

刘聪NLP:开源啦!开源啦!UNILM中文模型开源啦!zhuanlan.zhihu.com

因此训练了一个生成式的夸夸闲聊机器人,供大家娱乐~~~

该模型趣味点在于,当大家不开心或者无聊时,可以与它交流,获取更多鼓励(相信你自己,你是最棒的)!

GitHub地址:https://github.com/liucongg/UnilmChatchitRobot

数据及模型

原始语料来自豆瓣夸夸群数据,见data/douban_kuakua_qa.txt。

经过格式转化后,得到了6万多单轮对话数据,数据格式见data/sample.json。

已训练好的模型,下载地址:百度云盘,验证码:e0au

Train

- nohup python3 -u run_train.py --data_dir data/

- --src_file kuakua_data.json

- --model_type unilm

- --model_name_or_path unilm_model/

- --output_dir kuakua_robot_model/

- --max_seq_length 128

- --max_position_embeddings 512

- --do_train

- --do_lower_case

- --train_batch_size 32

- --learning_rate 2e-5

- --logging_steps 100

- --num_train_epochs 10 > log.log 2>&1 &

显卡2060s(8G),batch_size为32,训练了10个epoch。

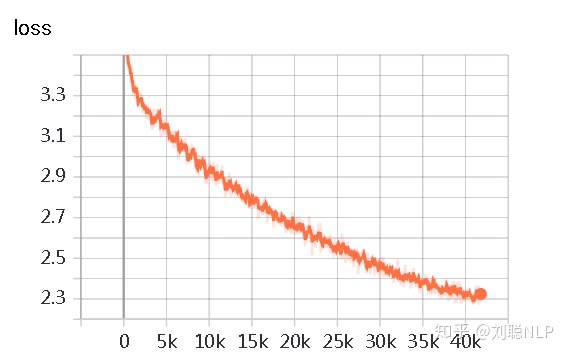

Loss如下:

通过loss曲线来看,其实模型并没有完全收敛,loss还有很大的下降幅度,可以继续进行训练,效果应该会更好。

Test

- python3 interactive_conditional_samples.py --device 0

- --topk 3

- --topp 0.95

- --dirty_path data/dirty_words.txt

- --model_name_or_path kuakua_robot_model/

- --repetition_penalty 1.2

- --max_len 32

- --no_cuda False

可以通过调节,topk、topp和repetition_penalty来修改模型生成效果。

Result

sample1

- user:工作不开心

- chatbot:你可以的!工作不开心也可以去吃火锅,看个影响自己心情的电视剧

- user:工作不开心

- chatbot:我也是,不过现在开始努力找工作啦!一起加油鸭~

- user:工作不开心

- chatbot:那就祝福你,能找到喜欢的工作吧。

- user:工作不开心

- chatbot:你也要加油鸭!

- user:工作不开心

- chatbot:我也是,不过总有一天就会好起来的

sample2

- user:我分手了

- chatbot:分手快乐,你会遇到更好的。

- user:我分手了

- chatbot:旧的不去新的不来,你会遇见更好的

- user:我分手了

- chatbot:分的好,下一个更乖

- user:我分手了

- chatbot:旧的不去新的不来

- user:我分手了

- chatbot:分手快乐,祝你快乐!

- user:我分手了

- chatbot:旧的不去新的不来,加油!

sample3

- user:好像去吃火锅,但是我在减肥

- chatbot:你好棒!一定会瘦下来的!

- user:好像去吃火锅,但是我在减肥

- chatbot:吃火锅是为了能更好的减肥,你真棒!

- user:好像去吃火锅,但是我在减肥

- chatbot:吃火锅对胃好哦!我也在减肥,一起加油呀

- user:好像去吃火锅,但是我在减肥

- chatbot:吃火锅对减肥有什么效果?我也想去吃,但是现在没勇气去吃

- user:好像去吃火锅,但是我在减肥

- chatbot:你真的很棒,我也在减肥

模型不足之处

本模型最大的问题是,在训练模型时,没有考虑上下文信息,也就是训练是针对单轮对话进行的,因此无法很好地回答上下文相关的问题,并且可能会出现文不对题的情况。

推荐几篇文章:

刘聪NLP:开源啦!开源啦!UNILM中文模型开源啦!

刘聪NLP:ACL2020论文整理之问题生成、自然语言推理、预训练语言模型及部分应用、QA问答系统及机器阅读理解

刘聪NLP:智能扩充机器人的“标准问”库之Query生成

刘聪NLP:短文本相似度算法研究