- 1开发安全之:Cross-Site Scripting: DOM_cross-site scripting: dom parser.parsefromstring(s

- 2基于主从博弈的主动配电网阻塞管理的论文复现——附Matlab代码_线路阻塞

- 3git 分支合并到master分支或者master合并到其他分支_git master 同步到其他分支

- 4idea log 不输出error_熟练掌握JS console.log,拯救你的代码

- 5【uniapp】如何在uniapp中使用xr-frame及xr-frame加载并使用gltf模型_uniapp xr-frame

- 6ABCNN: Attention-Based Convolutional Neural Network for Modeling Sentence Pairs

- 7关于亚信安全防毒墙网络版客户端的退出与卸载(2020年亲测有效,经验分享)_亚信安全防毒墙网络版客户端脱机

- 8Android10报错:open failed:EACCES(Permission denied)_android 10 open failed: eacces (permission denied)

- 9android commit规范_android studio 设置 commit message 模板

- 10Linux下的经典软件-史上最全_linux软件

Point Transformer V2: 分组向量注意力和基于分区的池化 超详细解析

赞

踩

目录

快速预览

首次提出了群体向量注意力

继承了可学习权重编码和多头注意力机制,提出了一种基于分组权值编码层的分组向量注意力。同时引入额外的位置编码乘子来增加位置编码信息。此外,设计了新颖的轻量级的基于分区的池化方法,以实现更好的空间对其和更有效的采样。

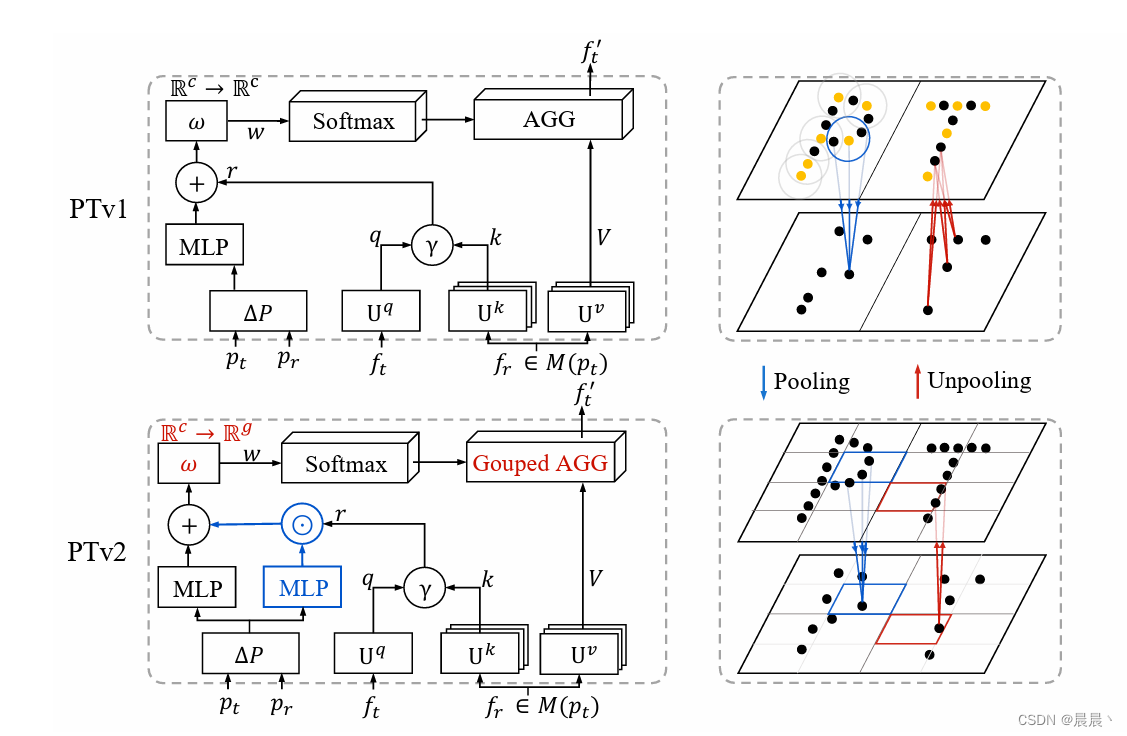

V2在V1的基础上,改进包括:分组向量注意力、位置编码乘数、基于分区的池化。

具体来讲:

1、分组向量注意力(Grouped Vector Attention,GVA):与传统的向量注意力相比,分组向量注意力通过将注意力权重分组来提高参数效率,从而克服了随着模型加深和通道数增加而导致参数数量急剧增加的问题。这种设计既继承了向量注意力和多头注意力的优点,同时也更为强大和高效(具有新颖的权重编码层,可以在注意组内部和之间有效的信息交换)。

2、位置编码乘数(Position Encoding Multiplier):针对3D点云的空间关系比2D像素的空间关系更为复杂的情况,提出了位置编码乘数来增强模型的位置编码能力,强化了模型对点云空间位置信息的捕捉能力(提高模型的空间推理能力)。

3、基于分区的池化(Partition-based Pooling):为了解决点云数据中点的不规则和非均匀分布对池化模块的挑战,提出了一种新颖的轻量级的基于分区的池化方法。该方法通过将点云划分为非重叠的分区来直接融合同一分区内的点,用均匀网格作为分区划分器,实现了更好的空间对齐和更高效的采样(更有效信息聚合)。

作者认为,分组向量注意力不仅继承了向量注意力(见Point Transformer)和多头注意力的优点,而且更加强大(作者证明多头注意力和向量注意力是分组注意力的退化情况)。

向量注意力中的Q和K的减法关系(关系函数β)随着模型的深入导致过拟合严重,为此提出了一种参数效率更高的分组向量公式,向量注意力被分成了具有共享向量注意力权重的组。

点的位置信息为3D语义信息的理解提供了重要的几何信息,以往的位置编码往往遵循二维编码方案。为此,作者通过对关系向量应用额外的位置编码乘数来增强位置编码机制。

点云数据通常具有不规则和非均匀的空间分布,这对于池化(Pooling)模块(即降维和特征融合的过程)来说是一个重大挑战。传统的点云池化方法依赖于结合采样(如最远点采样或格点采样)和邻居查询(如K最近邻或半径查询)的方式,这些方法不仅耗时而且空间对齐效果不佳。

其中,空间不对其可以理解为在进行特征融合(池化操作)时,输入数据的空间分布与期望的特征表示之间不一致。

主要涉及以下方面:

1、分布不均匀:点云数据的分布在空间上是高度不均匀的,某些区域可能点较为密集,某些区域较为稀疏。这种不均匀使得在应用传统池化策略时难以有效均衡地捕获所有区域的特征。

2、采样和邻域选择的局限性:传统的采样和局部邻域选择方法可能会导致所选区域的重叠或覆盖不完整,导致特征融合时空间信息的损失或不一致。

3、空间不对齐:在特征提取和融合阶段,期望输入的数据在空间上能够以某种方式对齐,以确保学习到的特征在空间上具有一致性和连续性。然而,由于点云的分布不均匀和采样、邻域选择的局限性,传统的特征融合函数(最大池化)难以保持特征在空间上对齐,影响了模型对空间关系的学习和理解能力。

为此,作者提出了分区池化的概念,将点云划分为非重叠的分区,并直接融合在同一分区内的点,从而实现了高效的数据降维和特征融合(使用非均匀的网格作为分割器)。

PointTransformer V2框架详解

局部注意力

对场景中的所有点进行全局关注的计算量庞大,因此常采用局部注意力。

![]()

分组向量注意力

在向量注意力中,随着网路的深入和特征编码特征的增多,权重编码层的参数数据将急剧增多。为了克服向量注意力的局限性,作者引入分组向量注意力。

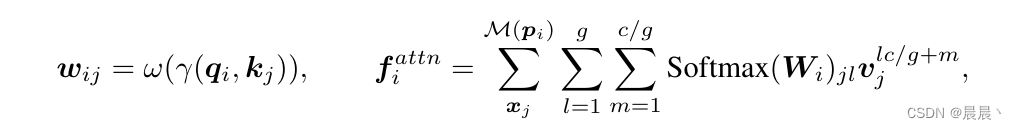

进一步理解:原来的标量注意力中,整个v共享同一个权重。再Transformer中,采用标量注意力,v中的每个特征通道都有一个单独的权重,这导致算法复杂度大幅提高。为此,再Transformer v2中,作者采用折中的方案。将v中的特征通道分组,每组共享同一个权重,以此来减少运算量。

最终的详细理解

在传统的标量注意力(Scalar Attention, SA)机制中,整个值向量(v)共享同一个权重,这种方式虽然参数量少,但可能无法充分捕捉各个通道之间的独特性。而在向量注意力(Vector Attention, VA)机制中,值向量(v)中的每一个通道都拥有一个独立的权重,这样可以更细致地调整每个通道的贡献,但随之而来的是参数数量的大幅增加,可能导致过拟合,并限制了模型深度的扩展。

分组向量注意力(GVA)通过将值向量(v)的通道分成若干组,并在每一组内部共享同一个权重,来有效平衡模型的表达能力和参数数量。这种方法不仅减少了参数量,提高了模型的效率和泛化能力,同时也保留了向量注意力机制按通道调整贡献的优点。每组内部共享一个权重的设计,允许模型在保持一定的参数效率的同时,能够更好地捕捉和处理3D点云数据中的复杂空间关系。

分组向量注意力层如下所示:

其中, 本文内容由网友自发贡献,转载请注明出处:https://www.wpsshop.cn/w/花生_TL007/article/detail/439841

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。