- 1opencv的相机校准和3D建模的理论知识_opencv 3d

- 2文生图——DALL-E 3 —论文解读——第一版_dall-e3论文解读

- 3国内访问ChatGPT, 并且支持回答图片!_altianhu

- 4uboot详细解释,两个启动阶段:先汇编,后C语言_uboot stage2

- 5MySQL入门学习:DDL和DML_mysql dml和ddl

- 6Git如何统计项目代码行数_git统计工程代码总行数

- 7Linux三剑客之sed命令详解_sed查找文件内容

- 8树莓派(主)与STM32(从)使用SPI通信_树莓派 spi

- 9微信开发者工具Cannot read property ‘getCloudAPI‘ of undefined_typeerror: cannot read property 'getcloudapi' of u

- 10python各位数字之和为5的数_编程计算100至1000之间有多少个数其各位数字之和是5。...

免费:SD软件包+高清教学视频+大模型资料!_sd从哪找教程

赞

踩

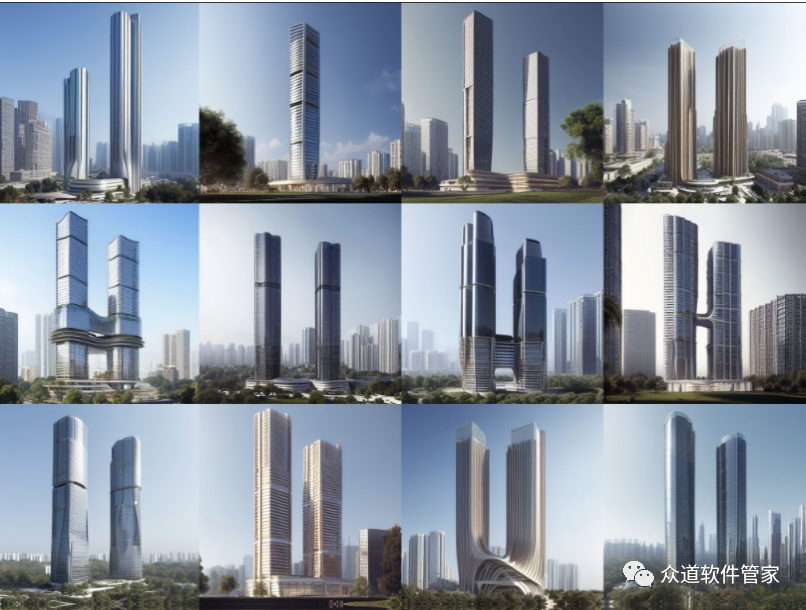

前几个月AIGC可谓是大热了一把,各种高质量的生成图片层出不穷,而其中最重要的开源模型Stable Diffusion也受到了各种技术商业上的热捧,以很快的速度不断的向前迭代着。

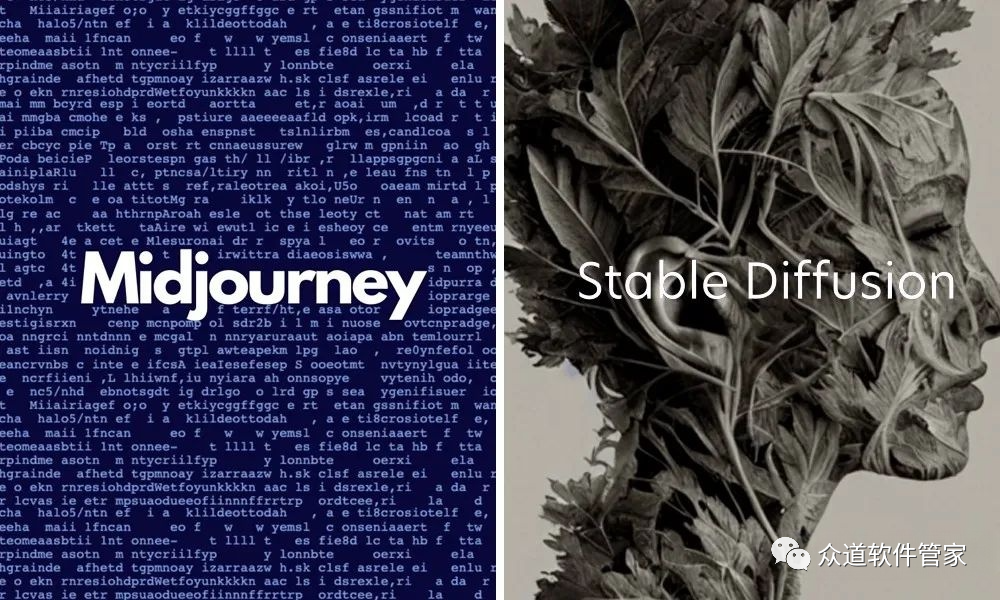

目前最主流的AI绘画平台主要有2种:Midjourney、Stable Diffusion。

Midjourney是一款AI制图工具,你只要给它关键词,它就能透过AI算法生成相对应的图片,而且绘图质量比较高。但目前不仅要收费,而且硬件要求较高,甚至同一个关键词组合每次得到的结果都不尽相同。

相比Midjourney来说,Stable Diffusion的可操作性则更高,有人曾这么简单的形容两者的区别:“Midjourney就像电子产品中的苹果,而Stable Diffusion更像是安卓。两者只是创作方式不同,没有高下之分。”

Stable Diffusion是一个文本到图像的生成模型。给它一个文本指令作为输入,它将返回给你一张与输入指令匹配的图像。

它的工作原理又是什么?

扩散模型(Diffusion Model)

稳定扩散模型(Stable Diffusion)属于深度学习模型中的一个大类,即扩散模型。它们属于生成式模型,这意味着它们是被设计用于根据学习内容来生成相似的新的数据的。对于稳定扩散模型而言,新的数据即为图像数据。

前向扩散(Forward diffusion )

所谓前向扩散(forward diffusion)过程就是向训练图像中不断地添加噪声,从而使其逐渐变为一张毫无意义的纯噪声图。在我们的例子中,前向扩散过程会将猫与狗的图片转变为噪声图。最终你将无法从得到的噪声图中分别出原来的图究竟是猫还是狗(这点很重要)。

这就好比往一杯水中滴入一滴墨水。墨滴将在水中扩散,在几分钟之后,它将随机均匀的遍布于整杯水中,你将再也无法从这杯水中看出原来的墨滴究竟是从杯子的中心还是边缘滴入的了。

逆向扩散(Reverse diffusion)

现在来到神奇的部分了。如果我们能够逆转扩散的过程会怎样呢?就像影片倒带一样,在时间线上逆向移动,那我们最终将会看到墨滴最初是从哪里滴落的了。

那么知道了原理,它又有哪些优势可以为我们所用呢?

接下来,我们就一起看看Stable Diffusion会给我们带来什么样的惊喜吧。

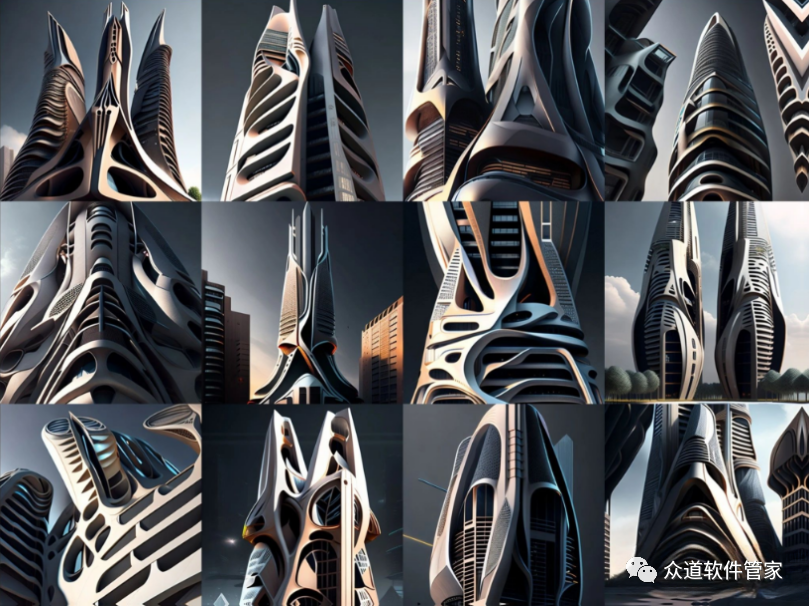

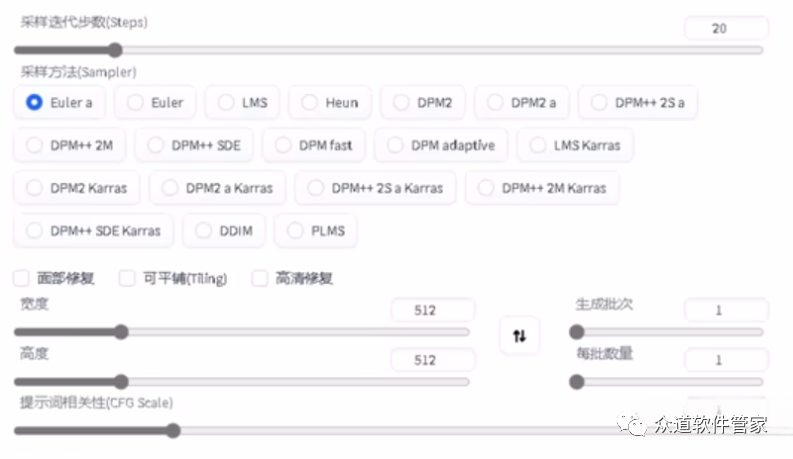

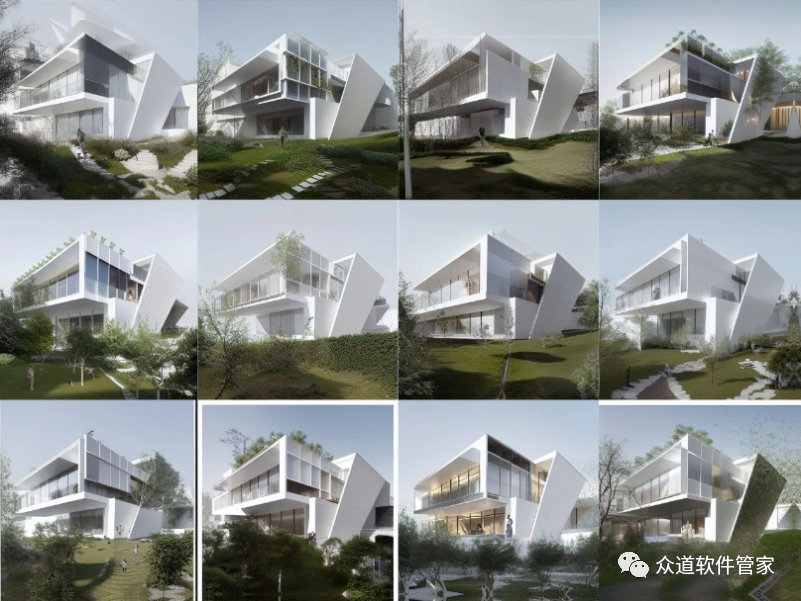

精准把控出图

AI绘画的关键在于图像的精准控制和风格控制,区别于其他AI软件,Stable Diffusion自身拥有众多选项,可以让你“定制”想要的图像效果。

此外,还包括更改图像大小、生成图片数量、采样器等;让你的效果图更加精准!

自定义训练风格模型

Stable Diffusion还有另个强大的功能——能够自定义训练风格模型。倘若现有风格无法满足你的需求,你还可以自己训练特定风格模型。

这相当于你自己在带一个任劳任怨、效率特别高的手下,还有很重要的一点就是,他不会离职!

可构建庞大的“生态”

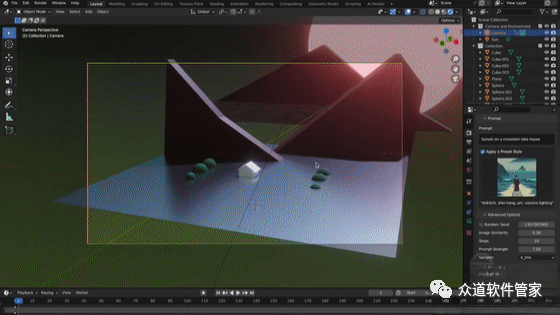

在Stable Diffusion爆火的同时,Stability.ai官方和业内大佬还研发出一系列免费插件,比如:AI Render、Stability等。

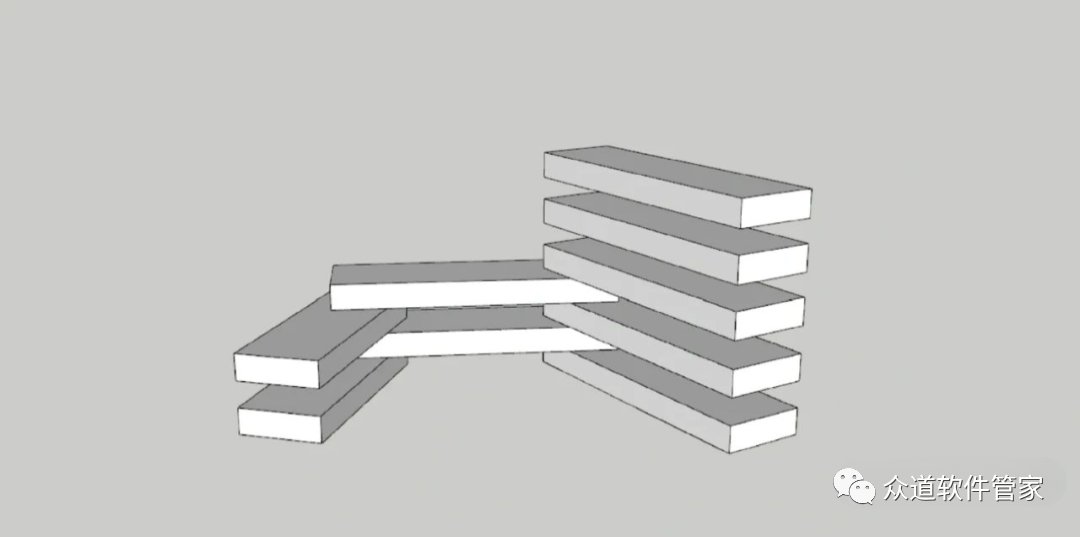

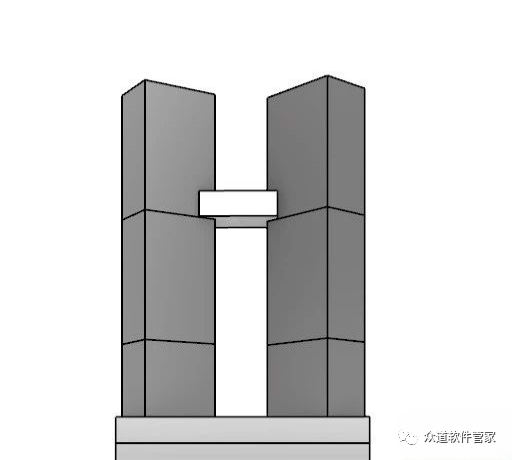

▲ 适配Blender的插件AI Render

而这些插件可以让你在使用其他3D软件(如blender)时,将简单的几何体渲染成详细图像。在不久的将来,Stable Diffusion将拥有一套十分强大的插件生态。

完全免费开源

相较于Midjourney等其他AI平台,Stable Diffusion完全免费开源,而且现在已经拥有超过一千种模型可供你下载,所有代码均在GitHub上公开,任何人都可以拷贝使用。

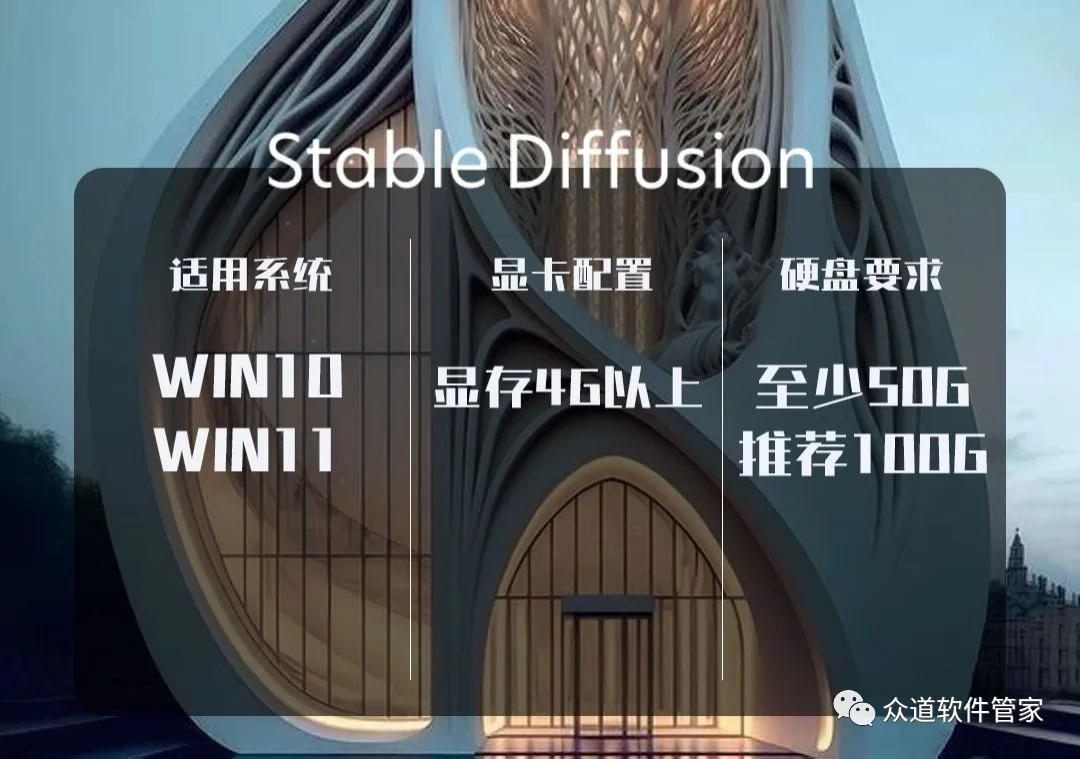

说到最后

对于建筑设计来说,结果更可控的Stable Diffusion显然更受设计师们的青睐。Stable Diffusion的配置要求并非很高,显存4G以上就可以,不过要求硬盘至少要有50G以上(建议100G),适用于Win10-11版本。

安装包及各种工具包制作人已经为你准备好了,赶紧下载试试吧!

安装配置需求:

a、显存 4GB 以上(建议N卡,如果是自己训练模型,需更高显存)

b、硬盘存储空间,100G 以上

c、操作系统 Win10 及以上

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/花生_TL007/article/detail/664895

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。