热门标签

热门文章

- 1MQTT协议分析与c语言实现(上)_mqtt-c

- 2超详细解决方案:在与 SQL Server 建立连接时出现与网络相关的或特定于实例的错误。_在与sqlserver建立连接时出现与网络相关的

- 3【华为机试题】华为机试真题附解答(2020.9.16/c++)_事件推送华为机试题

- 4海康威视RSTP摄像头视频数据从内网读取在web用HLS播放_hls插件加载rstp流视频

- 5归一化原理-python实现_python 最大最小归一化

- 6I.MX6ULL_Linux_驱动篇(37) linux系统定时器_linux 硬件定时器应用

- 7socket错误代码

- 8leetcode中级_给定一个元素为非负整数的二维数组matrix,每行和每列都是从小到大有序的。

- 9Java项目:在线服装销售商城系统(java+SpringBoot+Maven+Vue+mysql)_class shoppingcontroller extends basecontroller

- 10Samba常用配置及GUEST访问_guest ok

当前位置: article > 正文

20分钟本地部署ChatGLM3-6B_chatglm3-6b 本地

作者:菜鸟追梦旅行 | 2024-02-21 13:26:17

赞

踩

chatglm3-6b 本地

准备工作

1.下载源代码:

https://github.com/THUDM/ChatGLM3

2.下载预训练模型:

https://modelscope.cn/models/ZhipuAI/chatglm3-6b/files

可以创建一个py文件,直接使用如下代码下载到本地:

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('ZhipuAI/chatglm3-6b', cache_dir='F:/pretrained_model/chatglm3-6b/', revision='master')

- 1

- 2

- 3

注意:chatglm3-6B约11G大小

正式部署

1.创建一个虚拟环境(可选)

conda create -n chatglm3 python=3.8 --offline

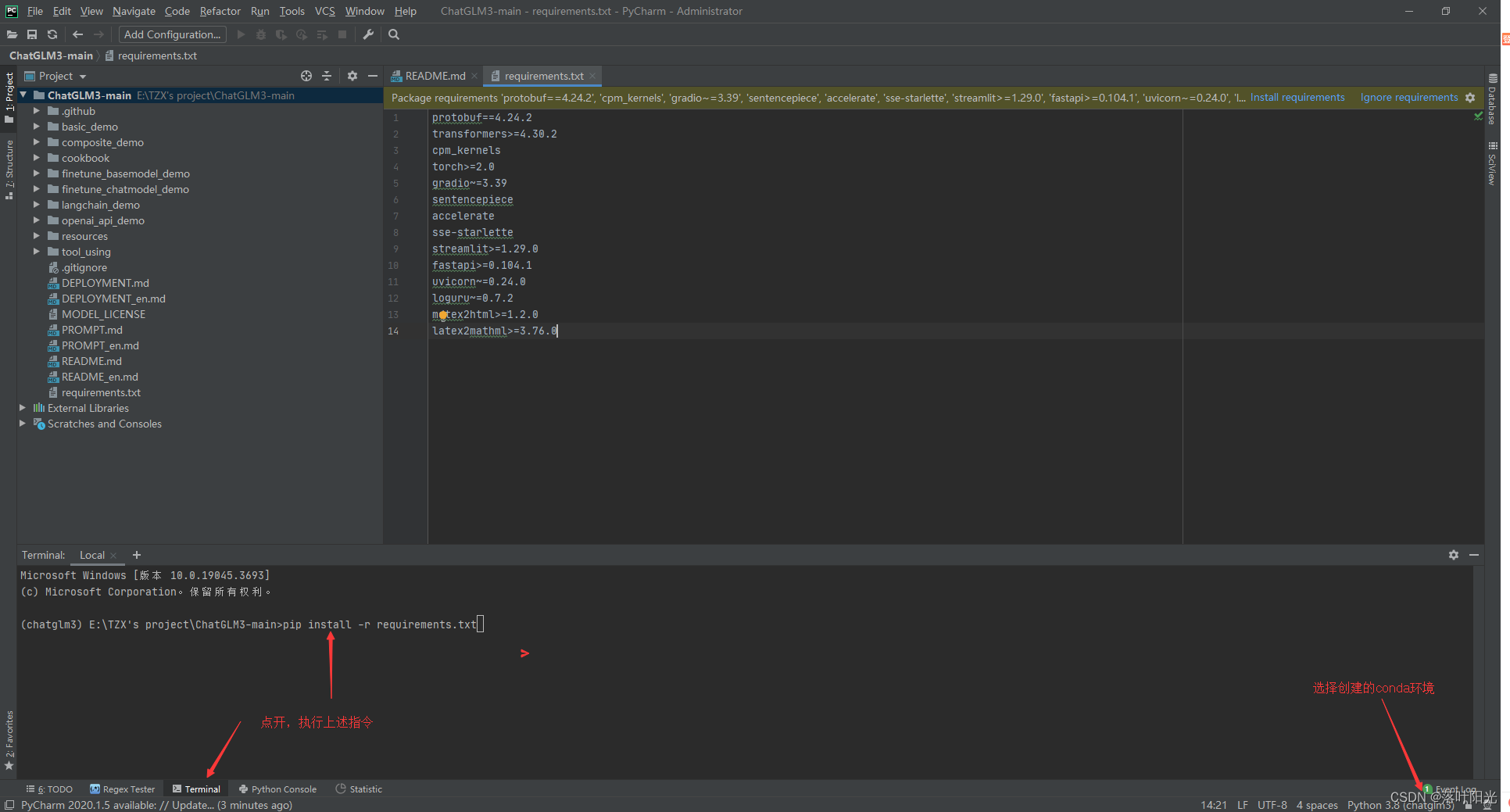

2.安装requirements

pip install -r requirements.txt

3.修改代码:

- 默认调用方式,只需将这里替换为预训练模型的保存路径即可,CPU调用需要32G内存, GPU调用方式需要13G显存

- GPU量化调用方式,修改为如下,需要5G

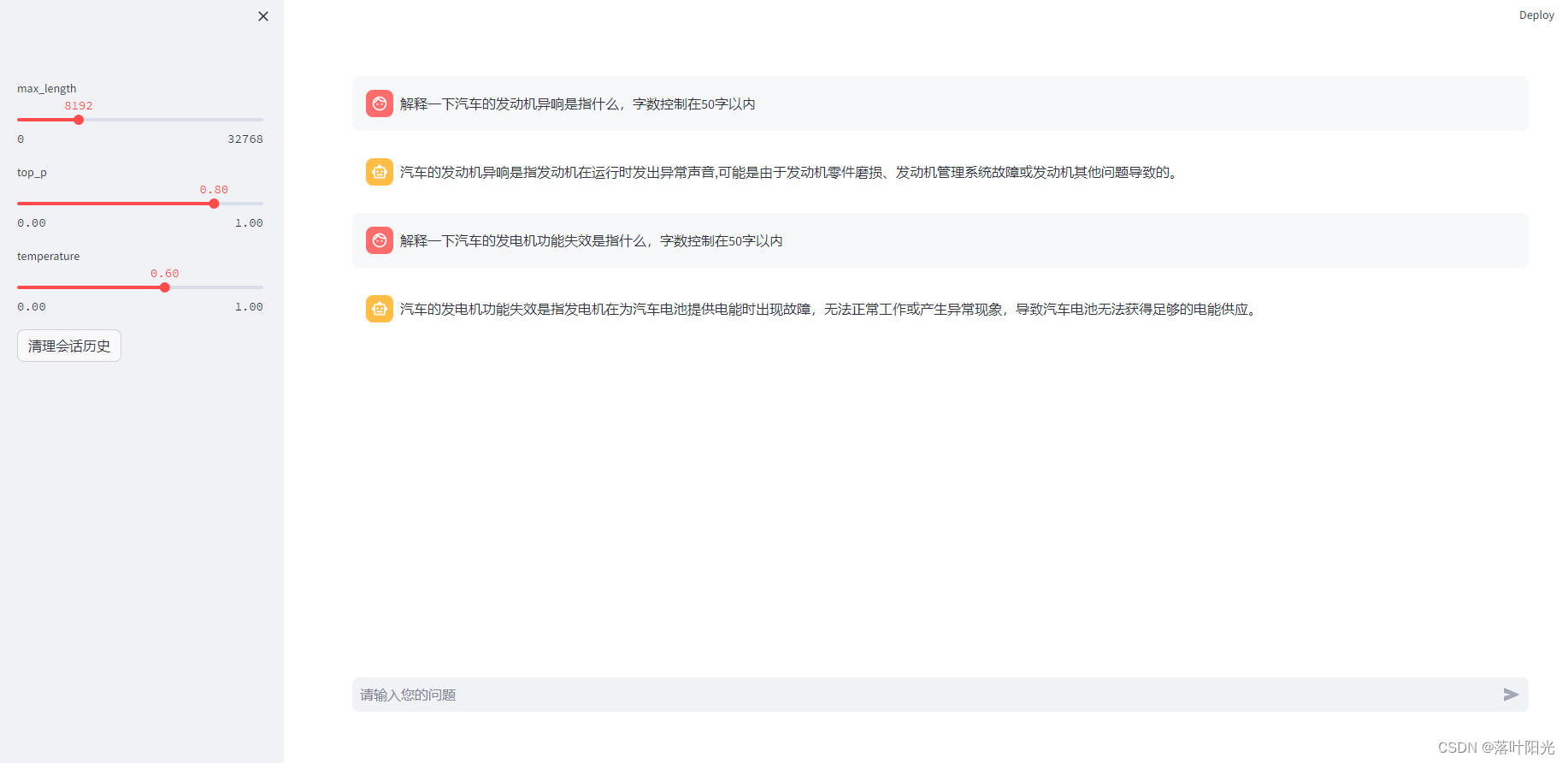

4.运行demo

cd basic_demo

streamlit run web_demo2.py

email的地方直接回车,后面就会加载模型了。

访问改地址即可进行对话:http://localhost:8501/

小结

和chatglm2相比,输出的结果似乎没有明显的改变,当最大的一个区别在于,chatglm2-6B有专门的int4版本,而chatglm3-gb取消了这个版本,在代码中可以直接指定量化版本。

2024.1.11补充:

发现chatglm3-6B在输出结果中存在着中英文混合、繁体字的问题,即使我的指令中强调了结果中不能出现英文单词和繁体字。也许是新的版本在训练数据中新增了一些训练数据导致的。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/菜鸟追梦旅行/article/detail/124068

推荐阅读

相关标签