热门标签

热门文章

- 1WPF 解决: DataGrid 已定义列,但是还是会显示模型的所有属性的问题

- 2基于springboot实现的音乐网站与分享平台_基于springboot的音乐网站

- 3深度学习Pytorch+YOLOv8(YOLOv5)环境搭建_anconda yolov8 pytorch

- 4大数据处理基础之scala编程语言入门_大数据 scala 如何做预处理

- 5吴恩达老师机器学习-ex1

- 6AI大模型应用入门实战与进阶:从数据收集到模型训练一篇通俗易懂的AI教程_ai 数据收集、模型设计、任务执行、决策和反馈

- 7adb命令操作手机各种开关

- 8Docker pull镜像io timeout问题_docker pull timeout

- 9一款高颜值开源知识管理工具

- 10安卓加固之so文件加固

当前位置: article > 正文

1分钟带你部署本地Llama3大模型_llama3本地模型如何喂数据

作者:运维做开发 | 2024-07-11 15:05:16

赞

踩

llama3本地模型如何喂数据

介绍

LLaMa 3由Meta于2024年4月18日正式发布,这一版本是对先前LLaMa系列的重大升级。新发布的模型包括8B(80亿参数)和70B(700亿参数)两个版本,这两个版本在一系列行业标准基准测试中展示了最先进的性能。

从技术架构来看,LLaMa 3继续采用Transformer的Decoder-only架构,并在此基础上进行了多项优化。例如,使用了旋转位置嵌入(RoPE)来处理长文本任务,并通过分组查询注意力(GQA)机制提升计算效率。

在训练数据方面,LLaMa 3使用超过15万亿个tokens的公开数据集进行预训练,其中包含大量的非英语数据,以支持多语言应用。这使得模型在多语言理解和生成方面有了显著的进步。

一、下载

进入网站后,选择相应版本进行下载。

二、安装

以mac电脑为例,进行安装。

跟着向导走。

安装中等待一会。

安装完成。

三、配置

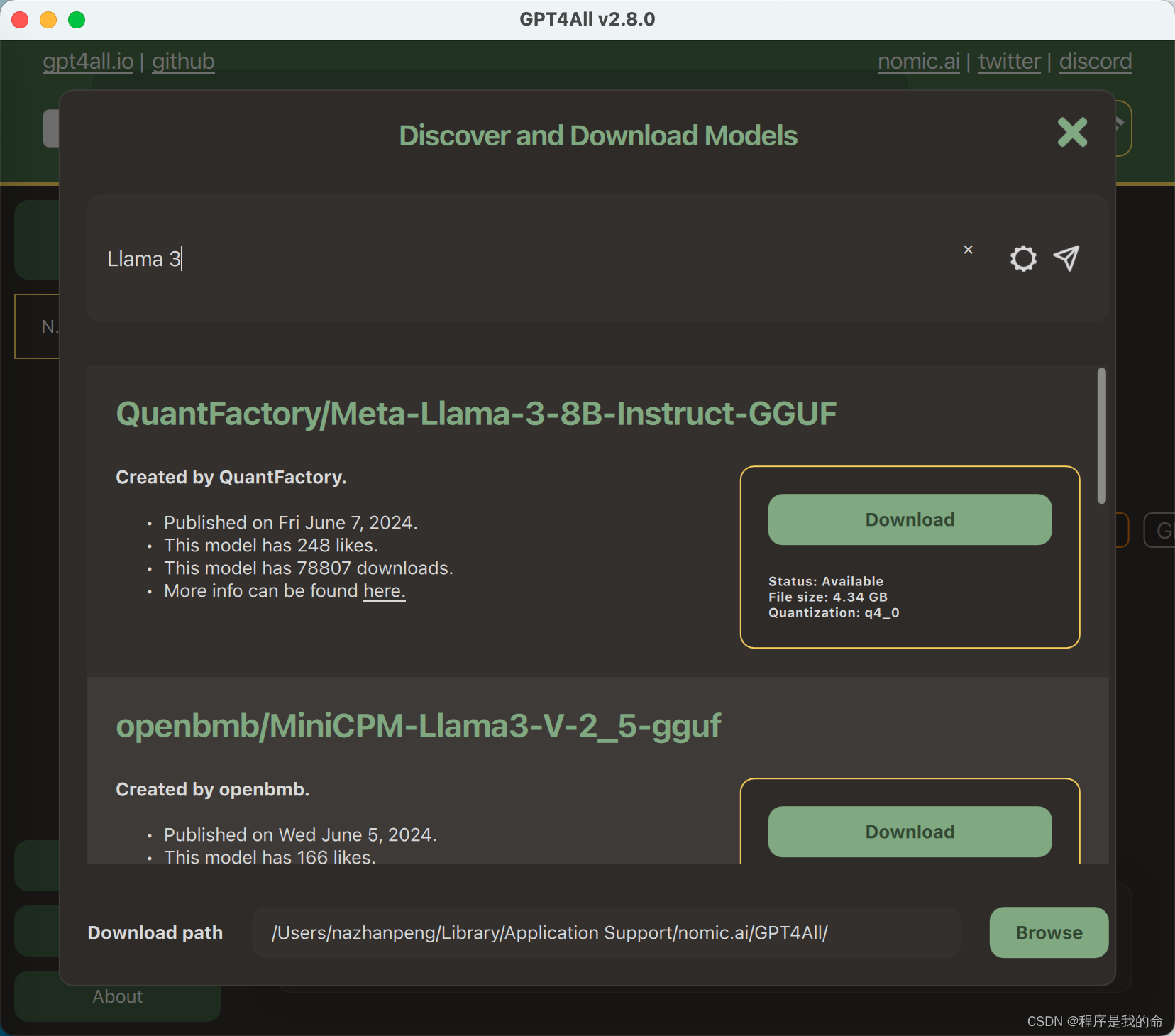

进入gpt4all程序中,在输入框输入 Llama 3进行搜索。

根据电脑配置进行选择,我这里选择8B模型。

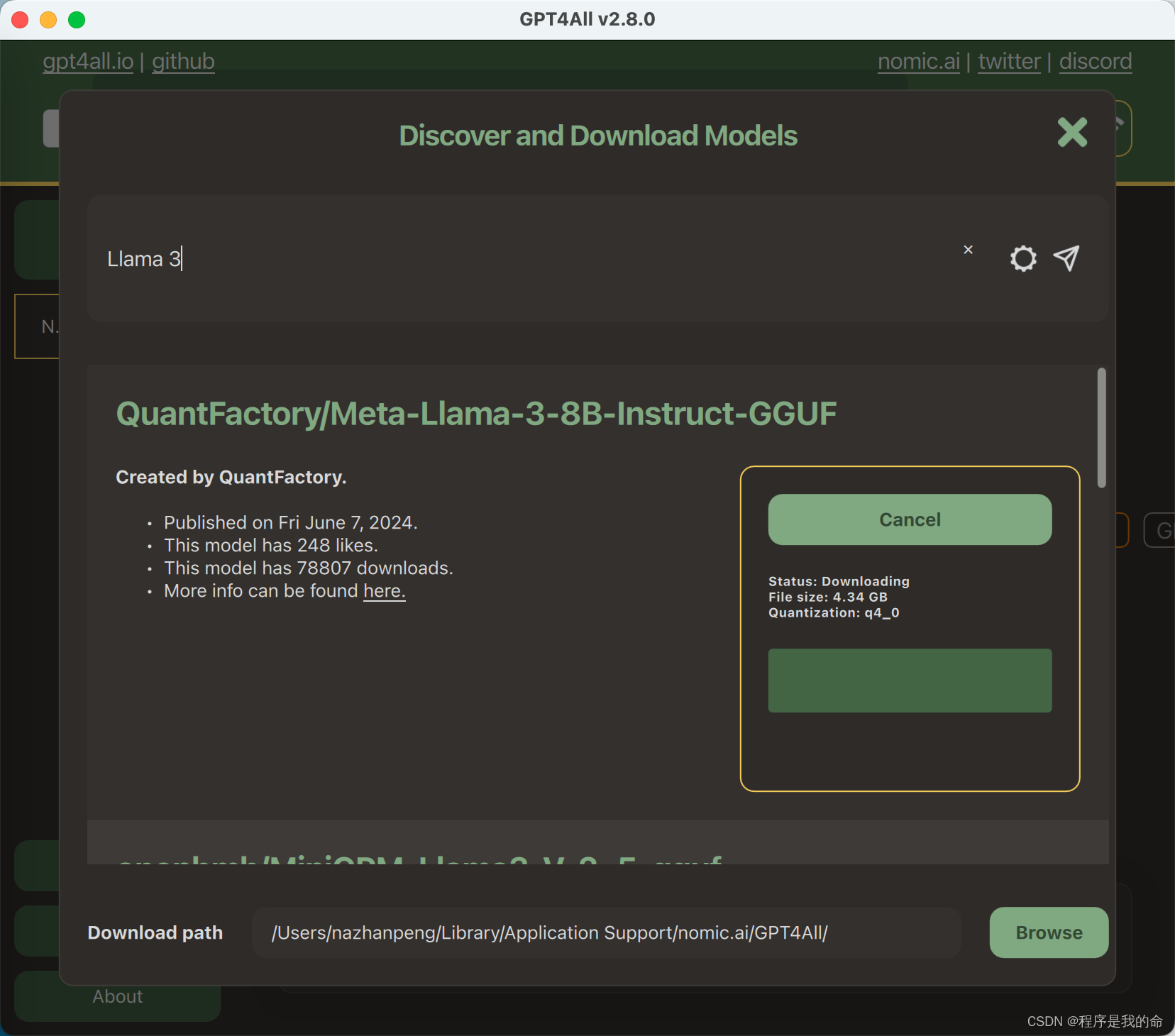

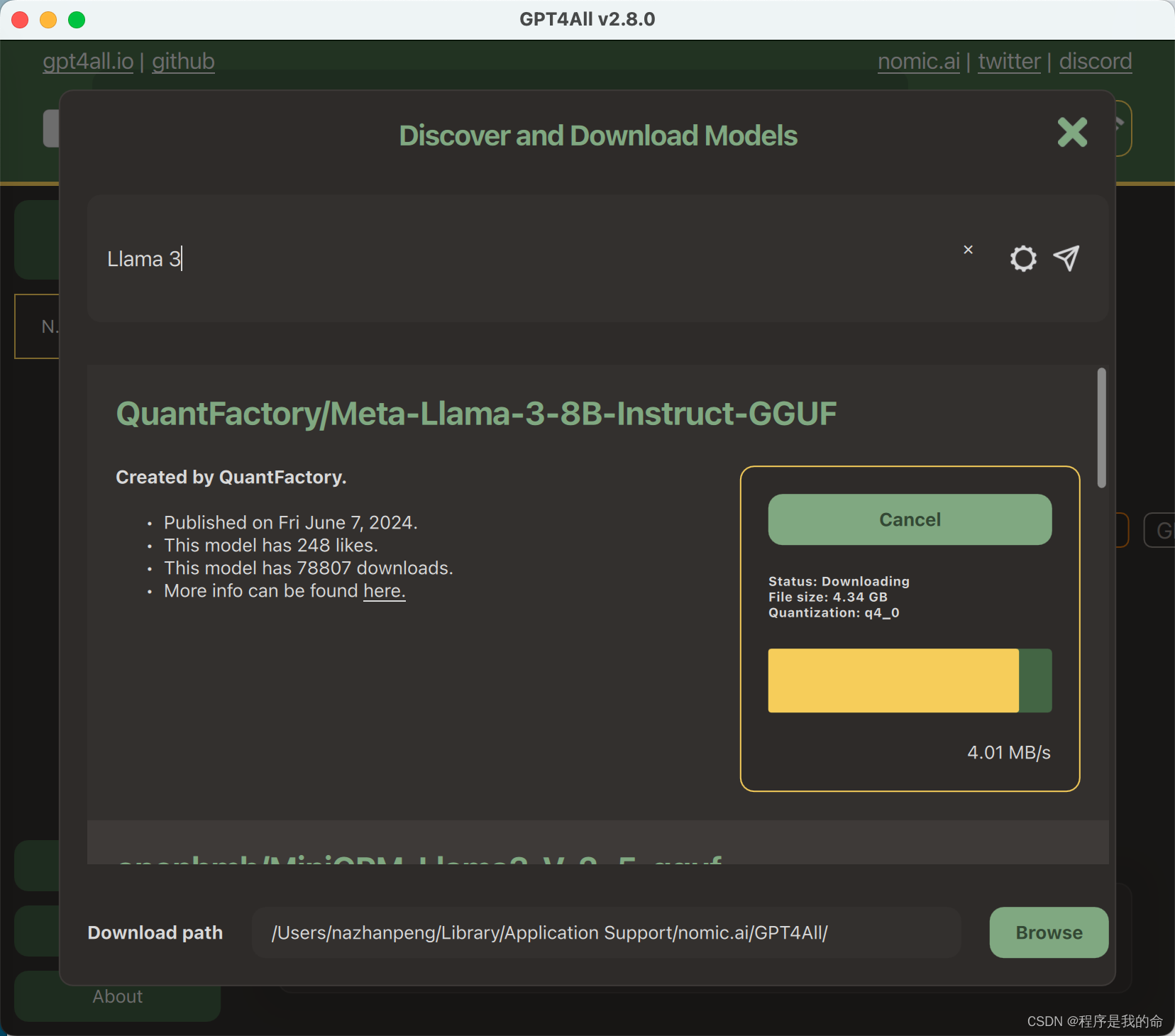

下载慢等待就好。

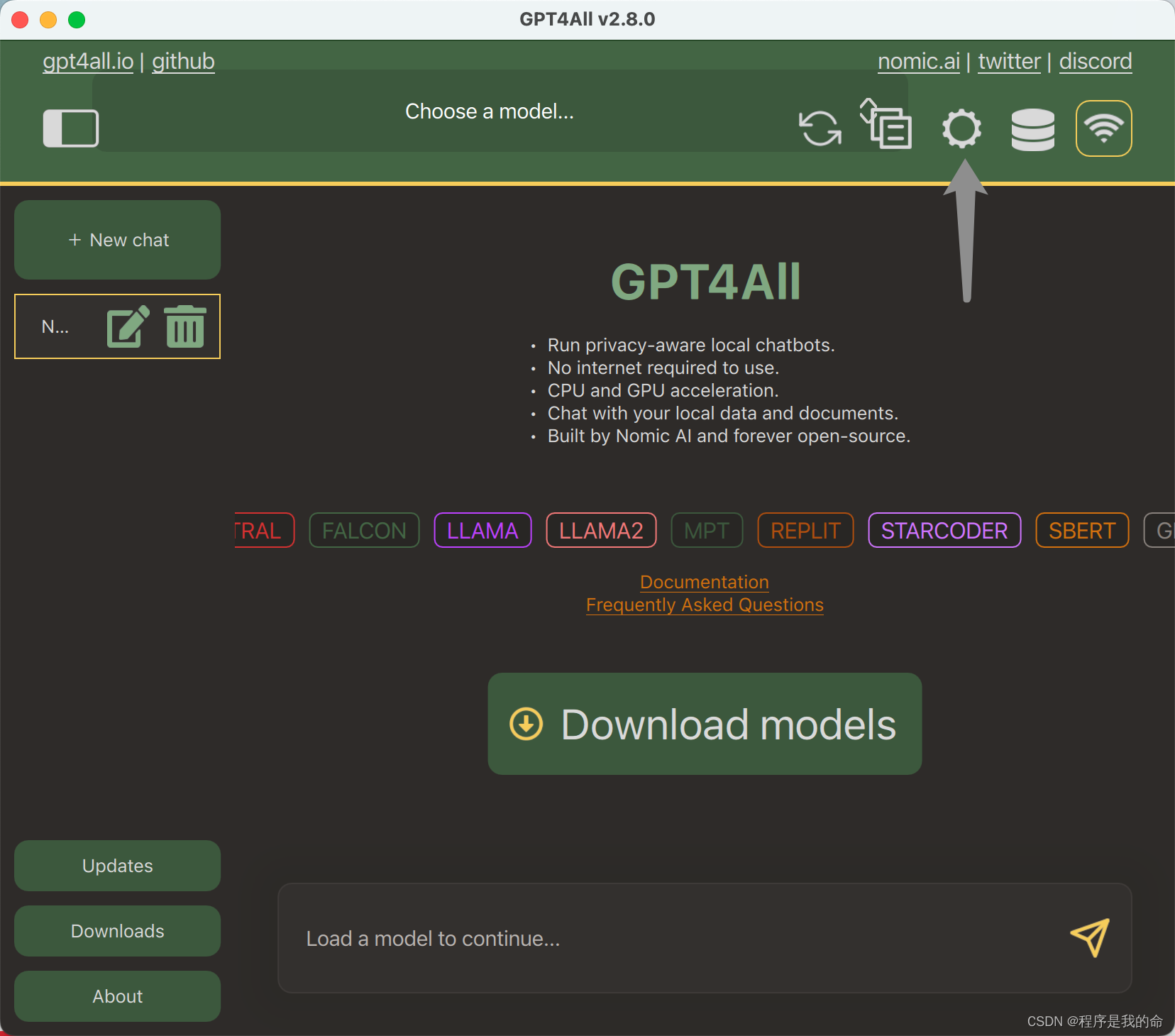

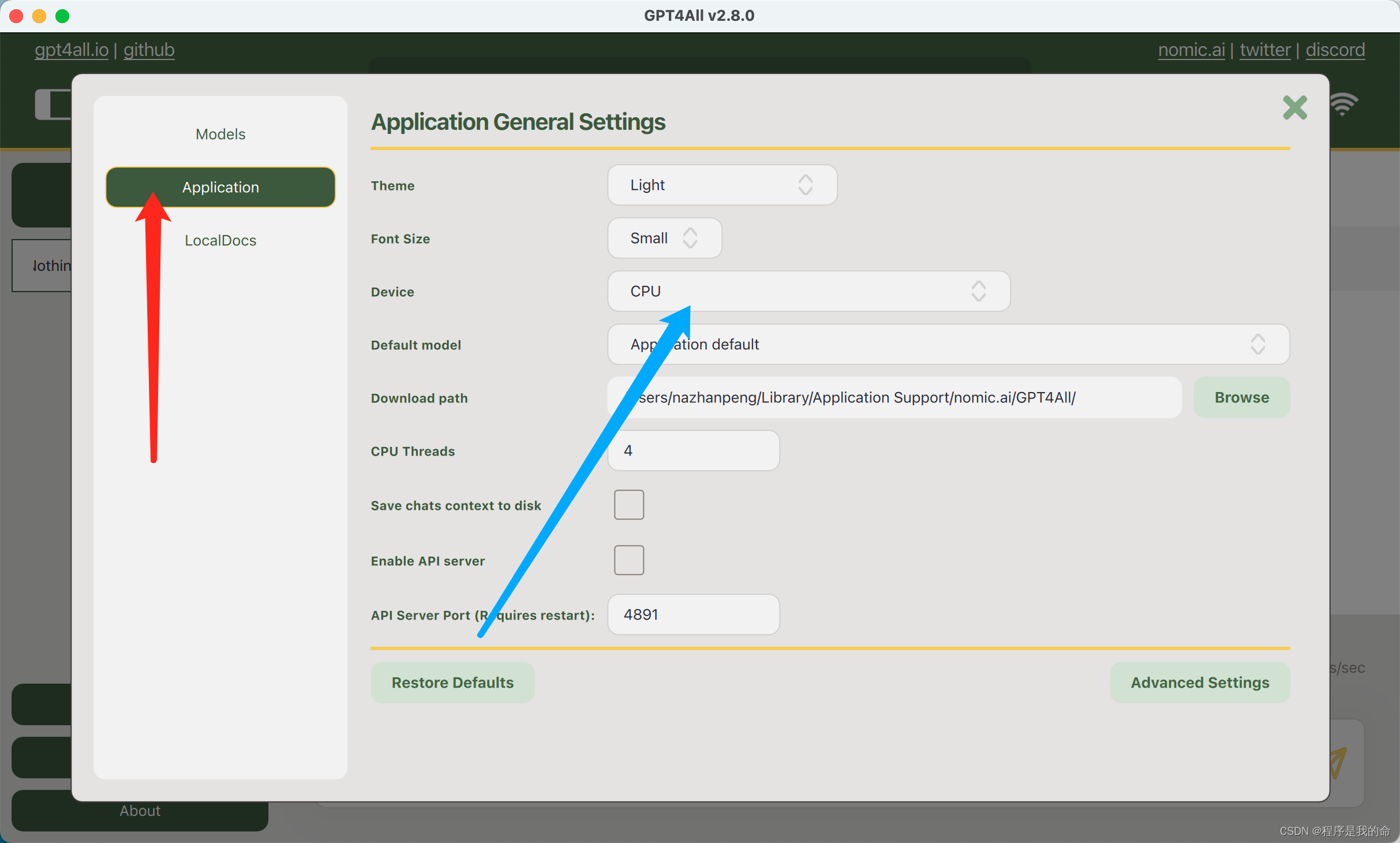

点击设置。

选择相应的显卡,没有显卡可以选择CPU(比较慢)。

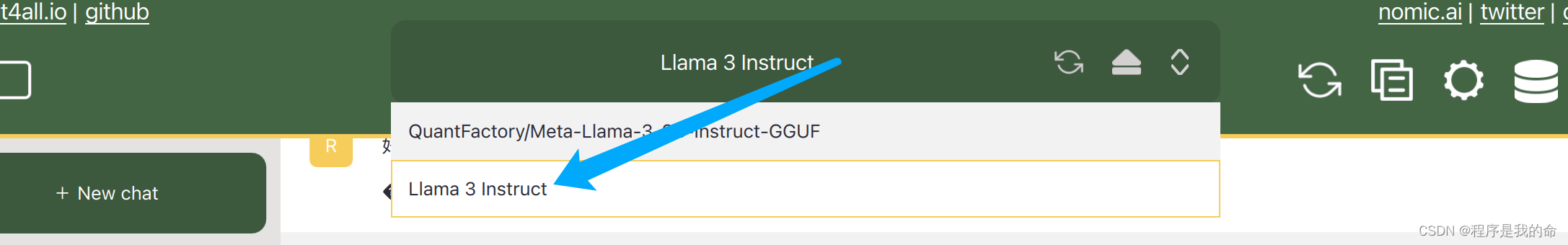

选择模型.

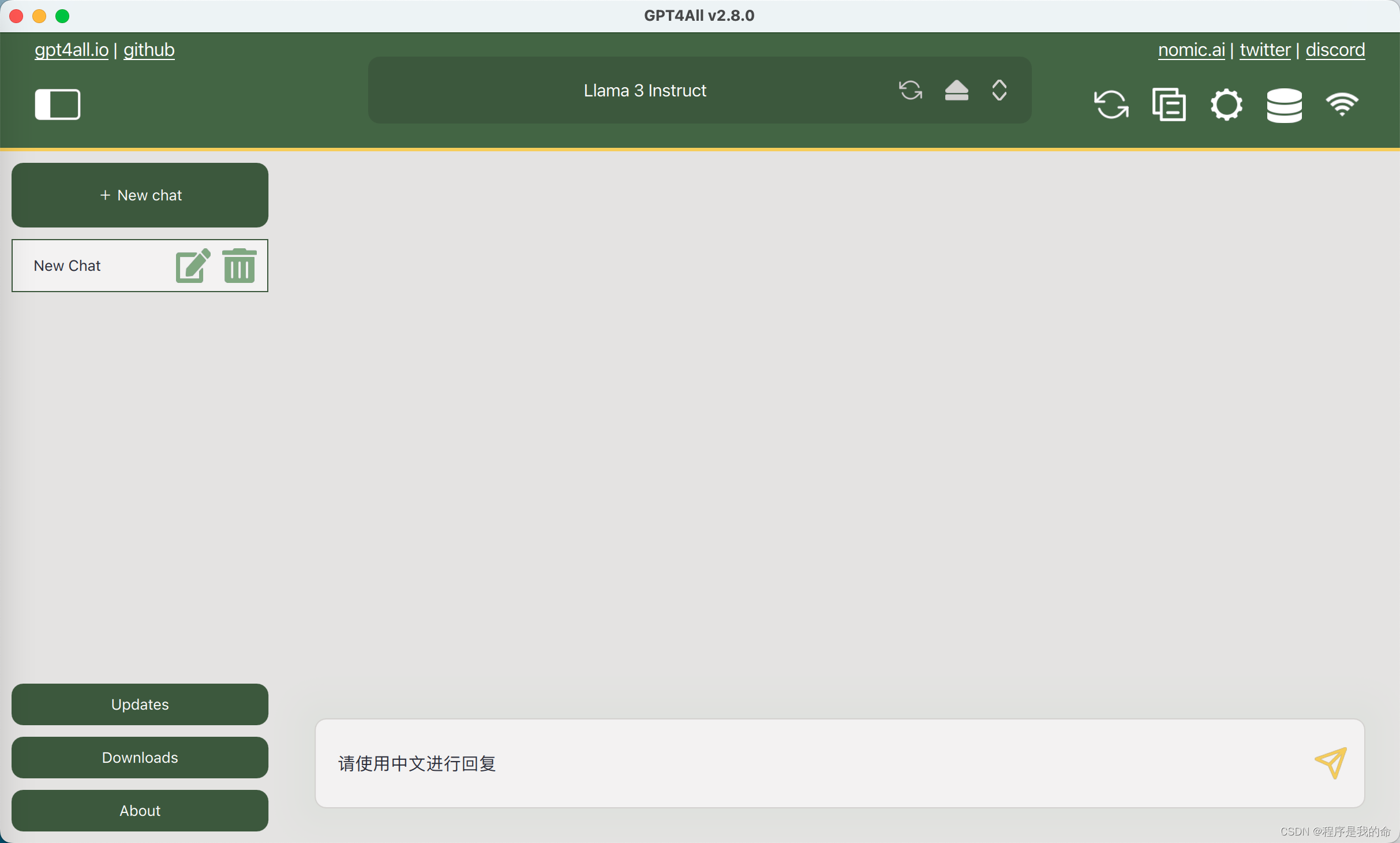

如果想让模型回复中文。需要告诉先发送“请使用中文进行回复”。

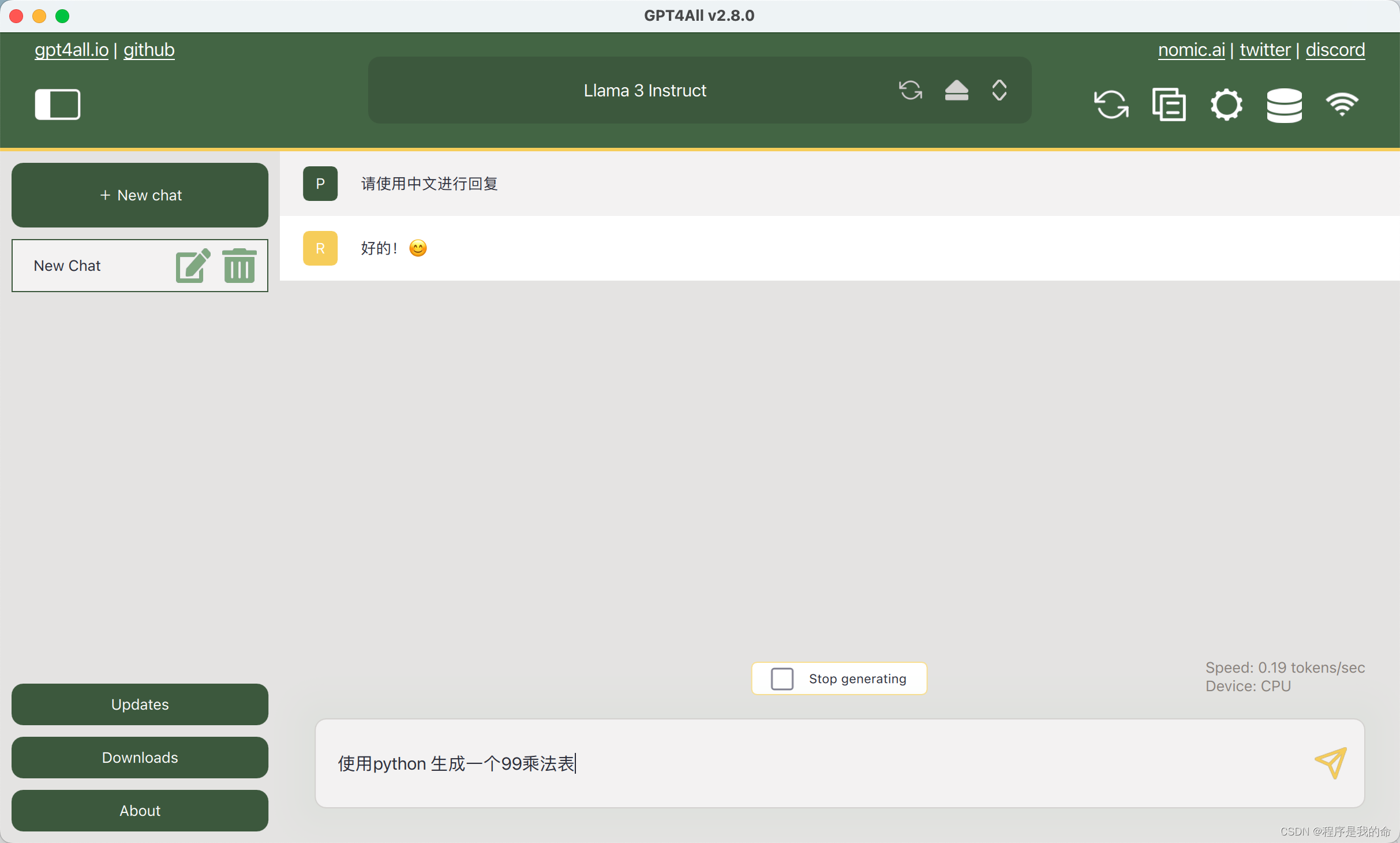

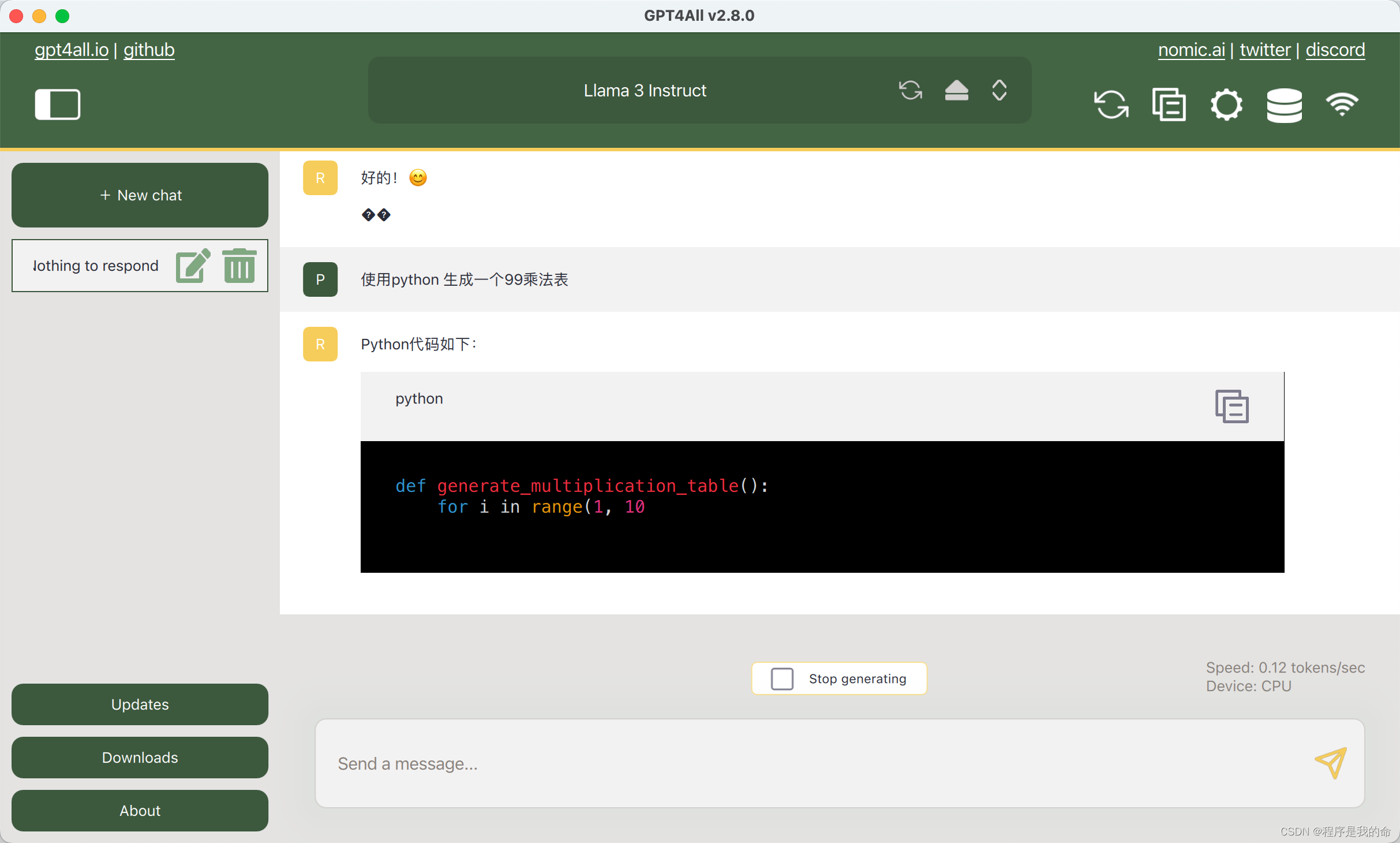

测试,使用python生成一个99乘法表。

可以生成出代码。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/运维做开发/article/detail/810690

推荐阅读

相关标签