- 1传入日期格式错误“message“: “JSON parse error: Cannot deserialize value of type `java.util.Date` from String_msg": "json parse error: cannot deserialize value

- 2基于FPGA的光口通信开发案例_tx diff swing

- 3MAC搭建MySQL,同时使用dataGrip可视化数据库_datagrip download from maven failed

- 4Java增加线程后kafka仍然消费很慢

- 5springcloud+hibernate+JPA+EntityManager Oracle 双数据源配置_java中yml配置hibernate多数据源调用接口

- 6Python课程设计:图书馆管理系统_python图书信息管理系统课设

- 7Dom4j教程详解+XML详解(详解+举例)

- 8产品读书《自卑与超越》_母亲带着三个孩子去动物园看狮子

- 9国密算法SM3

- 10Python针对MAC OS X安装_python3.12.1 mac安装教程

阿里通义千问Qwen1.5开源震撼发布,6种参数小至0.5B,性能超越GPT3.5_qwen1.5-1.8b-chat-gguf

赞

踩

引言

在人工智能技术快速发展的今天,阿里巴巴再次引领潮流,推出了最新的大模型——通义千问Qwen1.5。此次更新不仅提供了覆盖从0.5B到72B不同规模的模型,而且还开源了包括Base和Chat模型在内的多种版本,为全球开发者带来了前所未有的便利和机遇。

模型概览

Qwen1.5系列模型包括0.5B、1.8B、4B、7B、14B和72B六种规模,涵盖了Base和Chat两种类型。此外,阿里巴巴还特别提供了Int4、Int8的GPTQ模型,以及AWQ和GGUF量化模型,力求在保证模型性能的同时,进一步降低模型部署的成本和门槛。

-

Huggingface模型下载:https://huggingface.co/Qwen

-

AI快站模型免费加速下载:https://aifasthub.com/models/Qwen

核心特性

-

多语言能力提升:Qwen1.5在多语言处理能力上进行了显著优化,支持更广泛的语言类型和更复杂的语言场景。

-

人类偏好对齐:通过采用直接策略优化(DPO)和近端策略优化(PPO)等技术,增强了模型与人类偏好的对齐度。

-

长序列支持:所有规模的Qwen1.5模型均支持高达32768个tokens的上下文长度,大幅提升了处理长文本的能力。

性能评测

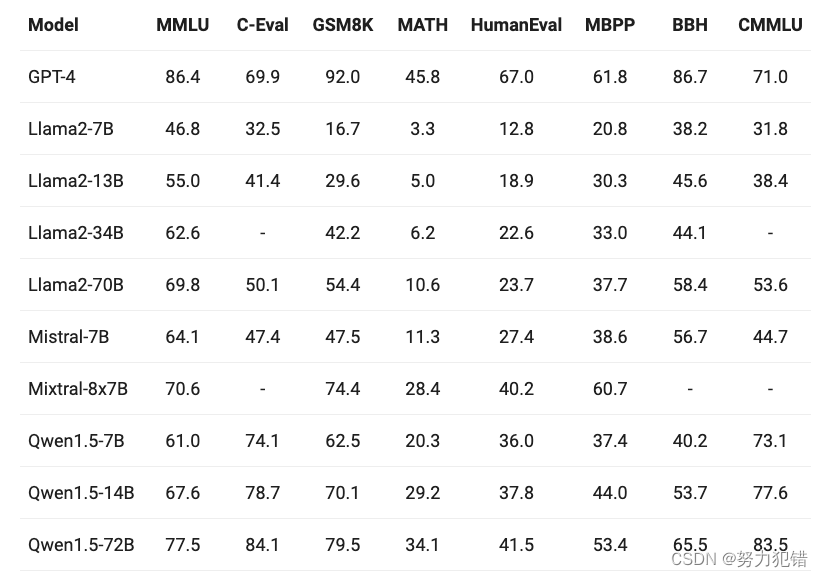

在性能评测方面,Qwen1.5在多项基准测试中均展现出优异的性能。无论是在语言理解、代码生成、推理能力,还是在多语言处理和人类偏好对齐等方面,Qwen1.5系列模型均表现出了强大的竞争力。

-

基础能力评估:在MMLU、C-Eval、Humaneval等多个基准数据集上,Qwen1.5系列模型与业界顶尖模型如GPT-3.5、Llama2等相比,展示了卓越的性能。

-

多语言能力验证:通过对12种不同语言的全面评估,Qwen1.5证明了其在全球多语言环境下的强大适应能力。

-

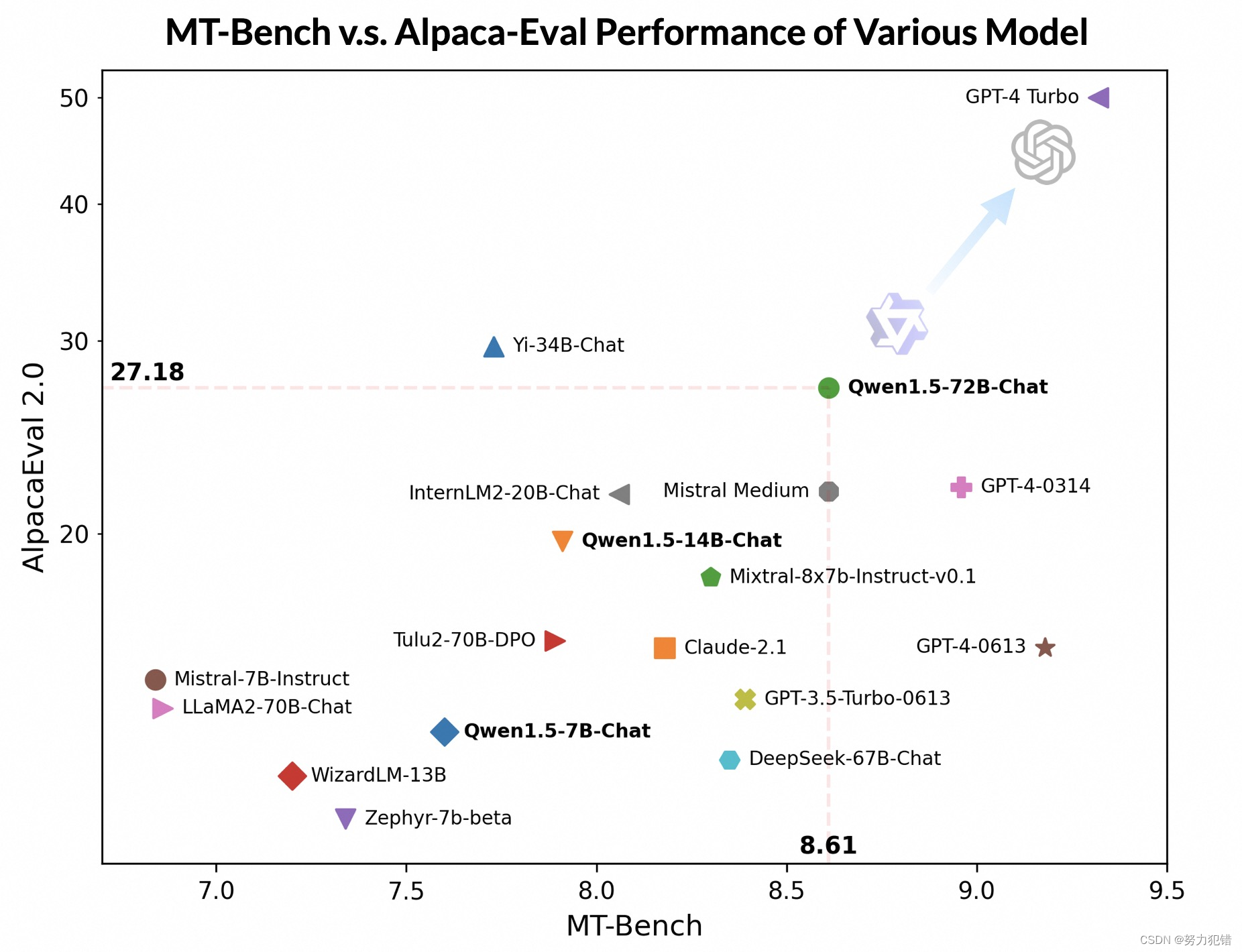

人类偏好对齐测试:在MT-Bench和Alpaca-Eval等广泛使用的基准上,Qwen1.5展现了与人类偏好高度一致的回复质量。

-

长序列:随着长序列理解的需求不断增加,阿里在新版本上提升了千问模型的相应能力,全系列 Qwen1.5 模型支持 32K tokens 的上下文。

开发者体验

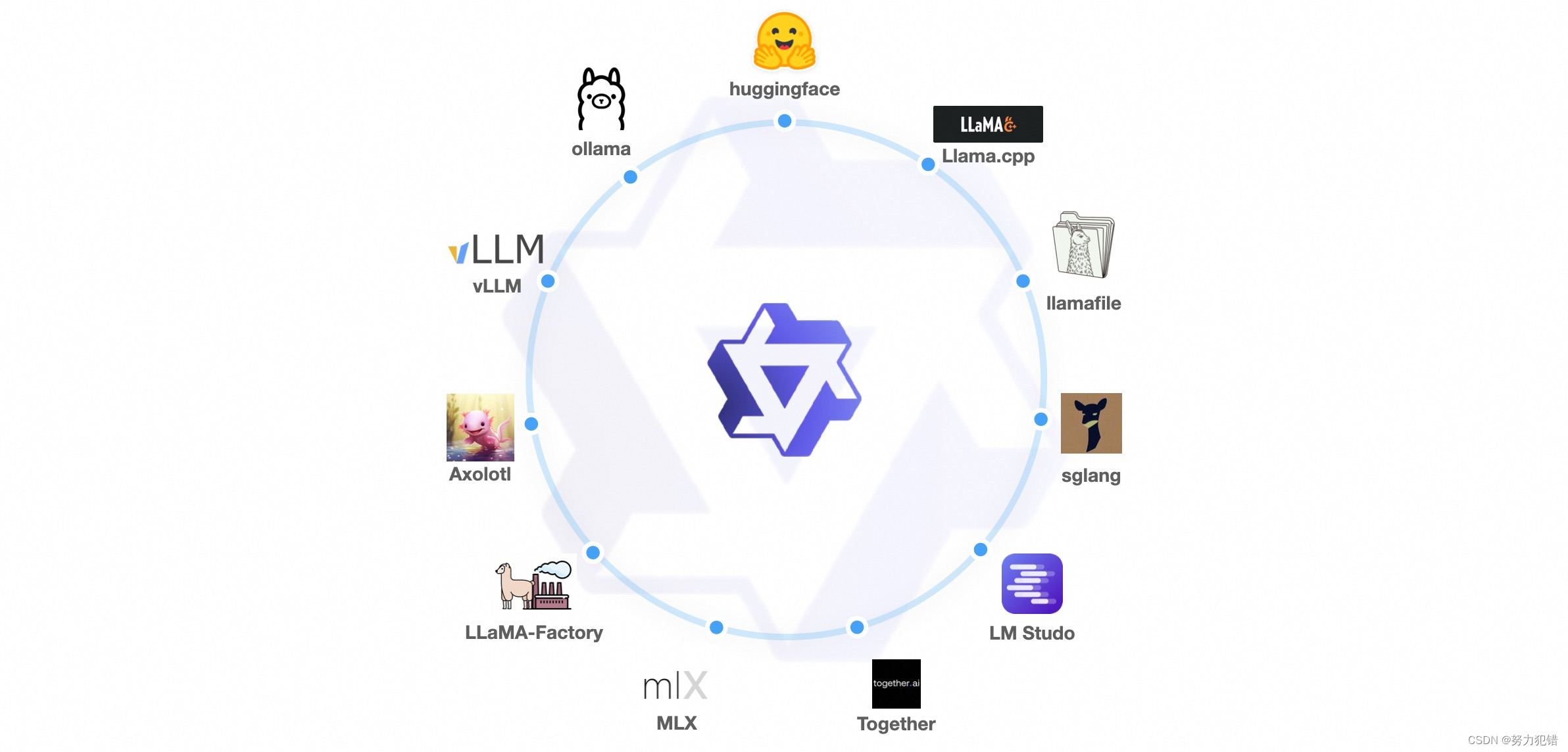

阿里巴巴将Qwen1.5的代码正式合并到Hugging Face transformers代码库中,极大地简化了模型的使用流程。现在,开发者可以直接使用transformers>=4.37.0原生代码,而无需指定trust_remote_code选项即可开发和部署。

此外,Qwen1.5还与vLLM、SGLang、AutoAWQ、AutoGPTQ等框架进行了深度集成,支持了从模型训练到部署的全流程,进一步提升了开发者的使用体验。

展望未来

阿里巴巴通义千问Qwen1.5的开源震撼发布,不仅展示了在AI领域的强大实力和创新能力,也为全球的开发者和研究者提供了一个强大的平台,共同探索人工智能的未来。随着Qwen1.5系列模型的广泛应用和进一步发展,我们有理由相信,它将为人工智能技术的发展和应用开启新的篇章,带来更多的可能性和惊喜。

结语

阿里通义千问Qwen1.5的开源不仅在技术层面展示了阿里巴巴在AI领域的强大实力,更在文化层面彰显了开源共享、合作共赢的精神。这次发布,既是对模型质量的一小步提升,也是对开发者体验的一大步优化,期待Qwen1.5能在您的研究或应用项目中发挥重要作用,共同推动AI技术的进步与发展。

模型下载

Huggingface模型下载

https://huggingface.co/Qwen

AI快站模型免费加速下载

https://aifasthub.com/models/Qwen