- 1JSP的基本概念、JPS的脚本、JSP内置对象_jps 重定向

- 2GPT(GPT1-GPT4-GPT4o)模型的发展历程:从起源到未来_gpt的发展历程

- 3C++和Rust_连续 3 年最受欢迎:Rust,香!

- 4基于Cosserat杆理论的连续同心推拉机器人模型matlab仿真

- 5vscode-CodeGeeX AI在vscode运用

- 6202406期工信部教育与考试中心《AIGC提示工程师》全国统考成功举办_aigc证书考试

- 7python多环境管理工具——pyenv-win安装与使用教程_windows pyenv

- 8鸿蒙开发之导航栏_鸿蒙开发导航栏

- 9【idea】idea配置gitee插件_简单使用_idea绑定gitee

- 10AI Gossip | 八卦人工智能的前世今生_智能八卦偏科分析

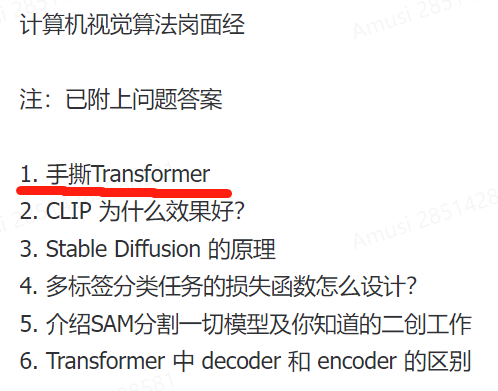

面试被问懵了:手撕 Transformer_面试手撕transformer

赞

踩

节前,我们组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学,针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。

今年最大的感受就是,今年的算法面试题普遍反馈特别的新!面试特别的卷。。。

基于大家的讨论和大模型实践,我们写一本书:《大模型面试宝典》(2024版) 发布!

这两天求职群分享了很多大厂的计算机视觉算法的面试真题,其中就有“手撕Transformer”:

要知道近年来特别出现了很多Transformer面试题(毕竟当前AI顶流)。这里特别分享15道Transformer高频面试题(求职群里有数百道Transformer题目,还有答案),希望对你有所帮助。

-

介绍Transformer和ViT

-

介绍Transformer的QKV

-

介绍Layer Normalization

-

Transformer训练和部署技巧

-

介绍Transformer的位置编码

-

介绍自注意力机制和数学公式

-

介绍Transformer的Encoder模块

-

介绍Transformer的Decoder模块

-

Transformer和Mamba(SSM)的区别

-

Transformer中的残差结构以及意义

-

为什么Transformer适合多模态任务?

-

Transformer的并行化体现在哪个地方?

-

为什么Transformer一般使用LayerNorm?

-

Transformer为什么使用多头注意力机制?

-

Transformer训练的Dropout是如何设定的?

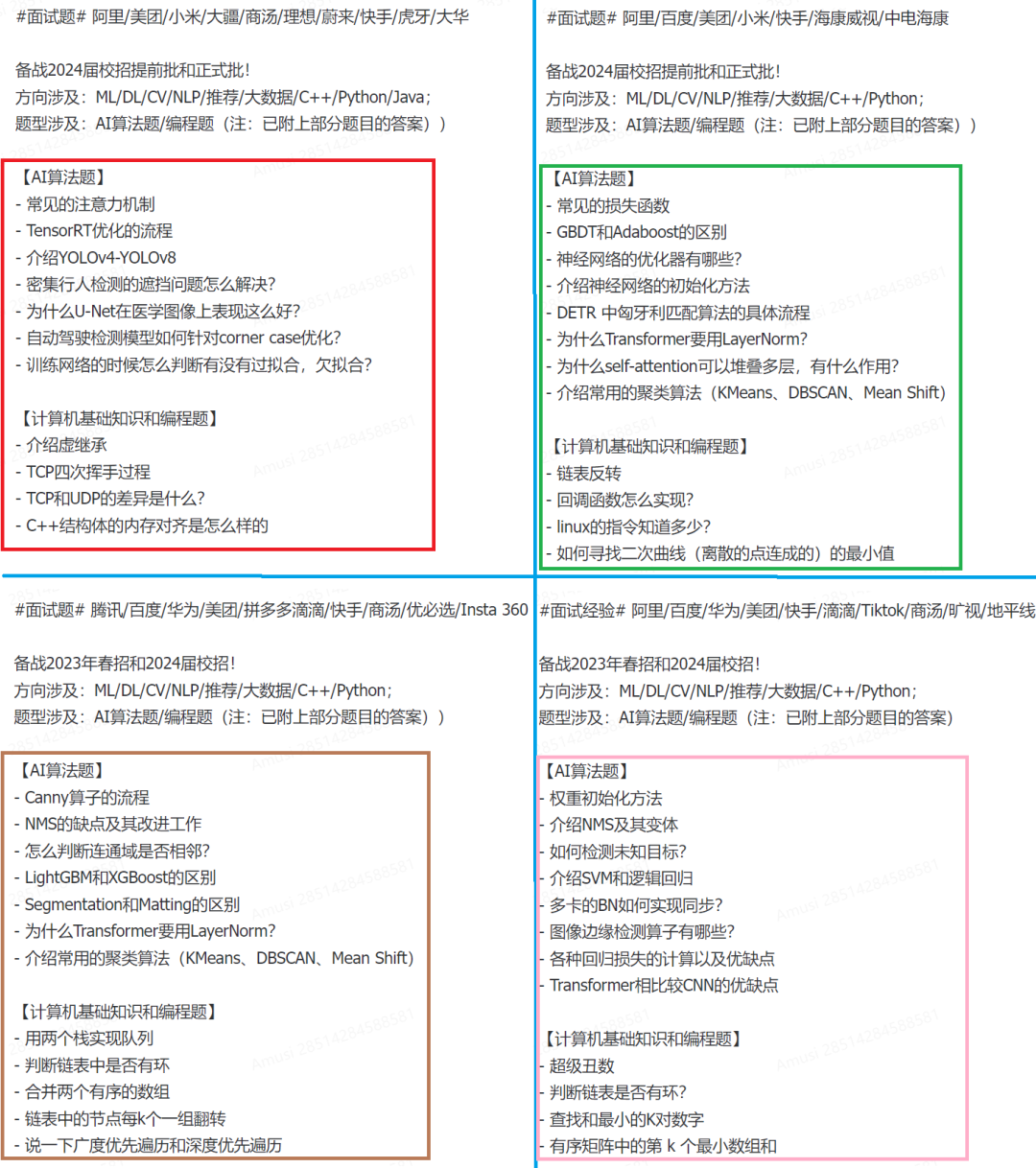

求职群还分享了很多AI算法岗、软开岗的大厂面试真题,部分截图如下:

如果你还没刷面试题?想看最新面经和答案?那得赶紧加入求职群!最新校招、实习、社招、教职信息、大厂面经和企业内推全都有!强烈建议大家加入2024年求职群(主要面向25届、26届及之后的同学)!

技术交流&资料

技术要学会分享、交流,不建议闭门造车。一个人可以走的很快、一堆人可以走的更远。

成立了大模型面试和技术交流群,相关资料、技术交流&答疑,均可加我们的交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友。

方式①、微信搜索公众号:机器学习社区,后台回复:加群

方式②、添加微信号:mlc2040,备注:来自CSDN + 技术交流