- 132. UE5 RPG使用增强输入激活GameplayAbility(二)_playercontroller 中 如何获取 enhancedinputcomponent

- 2iReport与JasperReport中文支持全面解决_jasper report support

- 3centos 自建网盘 nextcloud_centos搭建本地网盘

- 4[Java·算法·简单] LeetCode 14. 最长公共前缀 详细解读_java求公共前缀

- 52023首届大学生算法大赛 - 村庄

- 6【开源项目】CompileFlow流程引擎_开源流程引擎

- 7实验(一):运算器实验

- 8YOLOV7改进-针对小目标的NWD(损失函数)_yolov7小目标损失函数

- 9NVIDIA官网如何下载所有历史版本的驱动,包括上古化石版本?_nvidia历史驱动

- 10python 日历模块_【Python】日历模块

大模型的商业价值来自AI原生应用体验的质变|百度@MEET2024

赞

踩

编辑部 整理自 MEET2024

量子位 | 公众号 QbitAI

当下要想让大模型性能继续提升,关键要素是什么?

在MEET2024智能未来大会现场,百度AI技术生态总经理马艳军以文心一言为例,全面介绍了知识增强大语言模型,还介绍了围绕大模型建设的生态以及未来发展趋势。

在他看来,大模型给应用体验带来了质的飞跃,应用体验只要提升了,未来肯定会有更大的商业价值。

据了解,百度还围绕着文心一言的基础模型文心大模型以及飞桨深度学习平台做出了一系列技术创新与产业实践。

在技术的不断变迁中,马艳军总结了大模型与此前AI技术的三大不同点:

一是颠覆了交互方式;二是大幅降低了AI开发门槛;三是大模型会催生AI原生应用。

量子位在不改变原意的基础上,对演讲内容进行了编辑整理。

关于MEET智能未来大会:MEET大会是由量子位主办的智能科技领域顶级商业峰会,致力于探讨前沿科技技术的落地与行业应用。今年共有数十家主流媒体及直播平台报道直播了MEET2024大会,吸引了超过300万行业用户线上参会,全网总曝光量累积超过2000万。

演讲要点

人工智能的关键基础能力是理解、生成、逻辑和记忆。大模型恰恰因为这几种能力强,所以人们对其关注度才如此之高,并认为是通向通用人工智能的曙光。

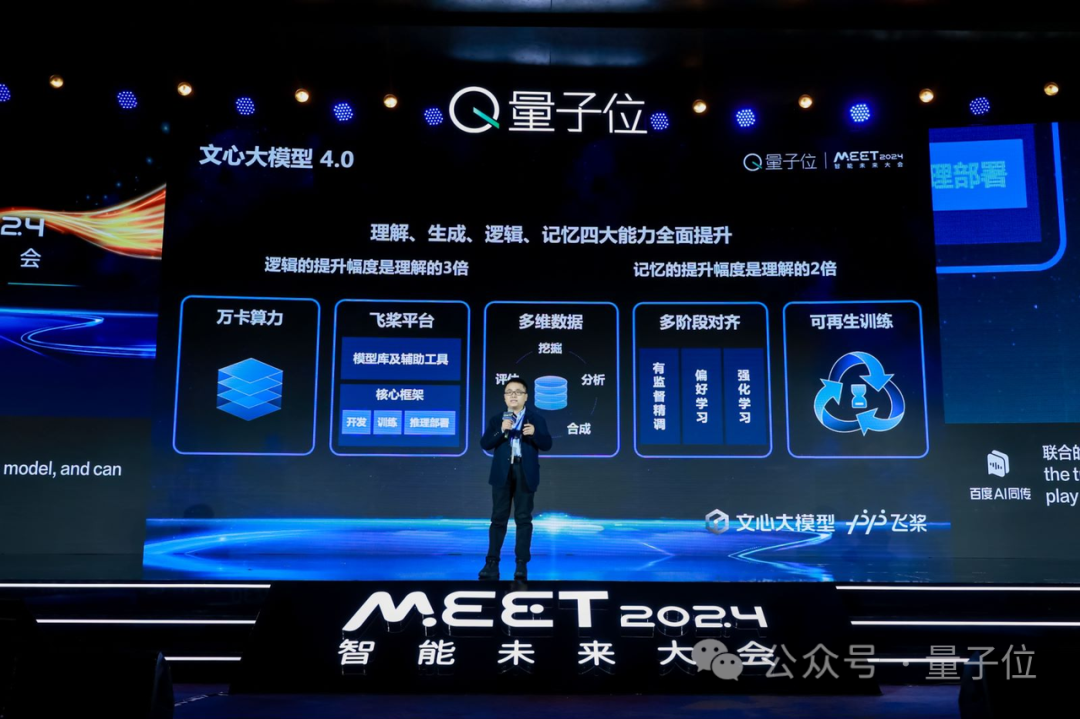

大模型发展,如何使用数据,如何挖掘、分析、合成、标注、评估数据,整个闭环非常关键。

大模型给应用体验带来了质的飞跃,应用体验只要提升了,未来肯定会有更大的商业价值。

要想大模型效果更快提升,训练效率特别关键,软硬件协同优化非常重要。

(以下为演讲分享全文)

大模型技术越发标准化

今天跟大家的分享,将以文心一言为例,探讨知识增强大语言模型的技术创新与产业实践。

我先对文心一言做一个比较全面的介绍,然后介绍围绕着文心一言建设的整个大模型生态,以及未来会有什么样的发展趋势。

现在我们提到人工智能的应用,大家可能会想到很多词。有几个比较关键的基础能力:

理解、生成、逻辑和记忆。

一般来讲一个人工智能应用一般是这四个能力中一个或者几个的组合运用,最终形成好的人工智能应用。

大语言模型也恰恰是因为这几个方面的能力比较强,所以现在大家对它的关注度非常高,并且认为是有可能通向人工智能的曙光。

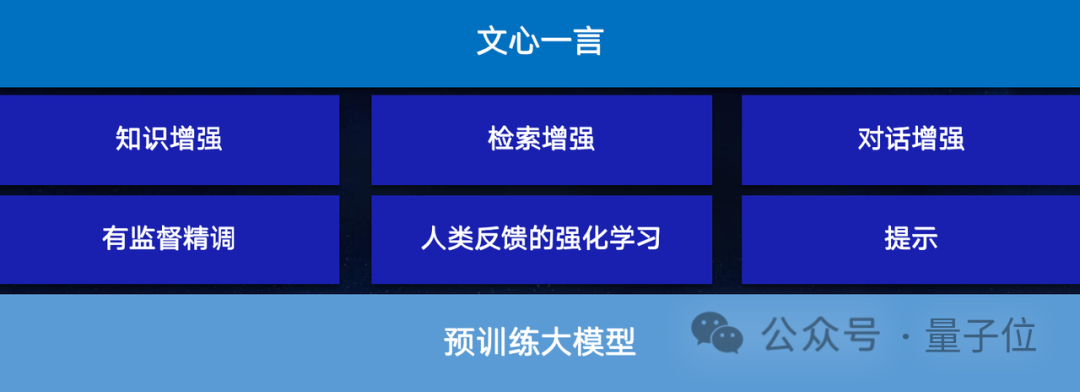

文心一言的建设,大家的关注度也非常高,首先是在底层有一个大的预训练模型,这块也是一个非常大的技术挑战。

现在随着大语言模型技术发展,实现方式也越来越标准化了,有监督的精调技术、基于人类反馈的强化学习、提示等等,这些是大家认为相对标准的一套技术。

在此基础之上,文心一言为了更好地提升回复的客观性以及时效性等一系列能力,百度专门在知识图谱注入、检索能力的引入、对话的连贯性等方面做了非常多的工作,让大家在使用的时候得到更好的体验。

文心大模型是文心一言背后的基础模型。我们2019年3月份发布了1.0版本,到今年10月份已经发展到4.0版本了。

大家如果有在使用文心一言,其中专业版背后的模型就是文心4.0。大家可能会感知到,随着4.0的上线,整个使用体验有了非常大幅的提升。它的理解能力、生成能力、逻辑能力、记忆能力,方方面面都有非常大的变化。

数据和对齐,前所未有的关键

研发期间,我们背后付出的努力还是非常大的。

首先依赖在底层资源上的巨大投入,需要在非常大的计算集群上做预训练模型的训练,基于大量的数据做训练学习。

另外,在算力之上,大家或许也都了解到,现在大模型的技术还是深度学习技术进一步发展的结果,其底层依然依赖深度学习框架和平台。

百度飞桨为大模型的训练提供了基础支撑,并且跟大规模计算集群进行联合优化、有机整合,把整个训练效率提了上来。

训练大模型,一方面是效果。要想得到好的效果,要想快点学好,训练效率特别关键,所以软硬件协同优化就显得非常重要。

不可回避的,数据是大模型训练过程中必不可缺的一环。随着大模型的发展,数据本身的质量重要度越来越高,如何使用数据,如何挖掘分析、合成、标注、评估数据,整个闭环其实非常关键。

应该说人工智能发展这么多年,以前我们也说数据重要,尤其随着深度学习的发展,大家都会说数据特别重要,需要数据、算法、算力三驾马车。

但是前所未有的,数据从未像在大模型时间点上显得如此重要,不管是质量还是整个加工闭环,都成了整个大模型训练学习当中非常关键的一环。

还有对齐,大模型技术发展对对齐技术要求非常高,为什么这么讲?

“对齐”这个术语也是因为大模型的发展被广泛知晓。背后核心还是要让大模型学会按照人类希望的内容和方式进行回复。

如何让大模型有效地跟人的要求做好对齐?这背后其实有非常多的技术需要建设。

再有,针对这么大的模型,如何在训练过程中训到一定阶段之后,完成增量式的参数调优,节省训练资源和时间,加快模型迭代速度?

所有这些技术都是在大模型研发过程中我们需要突破的。

当然文心一言面向社会开放以来,得到了非常广泛的关注,现在的用户规模已经不止七千万(截至2023年底,文心一言用户规模已破亿)。大家如果是自己使用过文心一言,相信也一定能感受到这一年当中的快速进步。

应该说大模型发展,尤其是大语言模型的发展给我们创造了一些新的机会。

大模型带来的变化

那大模型跟以前一波一波的技术变化有什么区别呢?我觉得有这几个方面:

第一个是交互方式,这次真正有了一个颠覆式的变化。

以前我们也有对话系统也可以做人机对话,对话效果往往差强人意。你说它能不能回复呢?它也能回复得还可以,但总是距离我们的预期有差距。一旦达不到临界点,其实非常影响技术的普及。大模型技术的发展,尤其是大语言模型让普及加速。

另外降低了开发门槛。

以前我们开发AI程序需要写非常多代码,写一个AI应用也需要非常多的代码,成本也非常高,大语言模型大幅降低了开发门槛。

三是大模型会催生AI原生应用。不仅是对产业应用有影响,其实对于科研,现在出现的AI for Science的趋势,也产生了非常大的影响。

所以在此驱使下,AI原生应用发展正迎来最好的时代,以大模型插件接入为基础,在此基础上进一步衍生出更强大的工具,基于这些能力必然会催生大量的AI原生应用。数字技术和实体世界加速连接与融合。

在百度大量产品当中,已经快速地在使用大语言模型来重构产品,整个产品使用体验也在快速地提升。

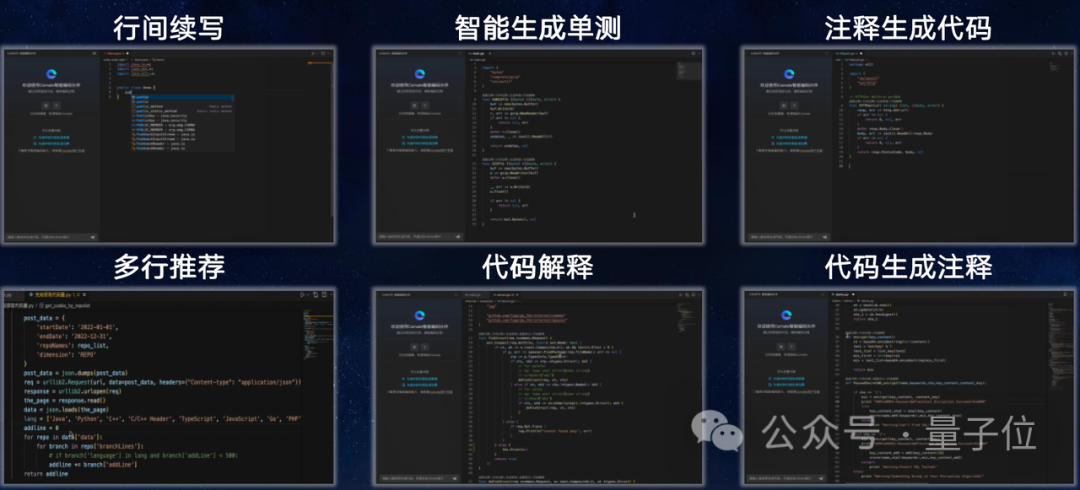

大家可以看一下,在办公场景、在程序员写代码的场景,大量的人工智能技术都可以使用起来。

比如说,一项最新的数据是,百度20%的代码都是由大模型,我们对应的工具叫Comate来实现的。

我们相信在未来的软件开发中,比较大比例的代码是由大模型帮我们实现的。

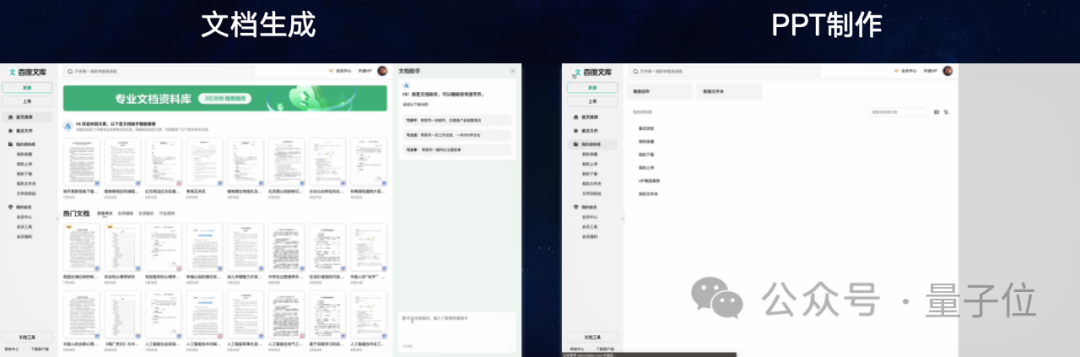

除了代码,像文档的分析等都能非常自然完成,大家可以感受到用了大模型之后,写作、做材料、做PPT效率会有非常大的提升,这是跟以前的技术很不一样的。

当然在商业分析决策等方面,借助大模型的交互能力也一样可以处理更加复杂的数据分析和任务处理。还有在百度网盘里面,可以用大模型唤醒历史上沉睡的大量的积累的图片、文档、各种各样的信息。

出行场景可以用智能助手能力更快帮我们实现交互,这些其实都是大模型所带来的产品体验方面质的飞跃。

应用体验只要提升了,未来肯定会带来更大的商业价值。

大模型对基础软硬件要求「极致」

大模型本身研发我前面也介绍了不少,确实是研发门槛比较高。

过去几年,一个企业研发的参数规模上亿的模型已经非常大了,成本很高。现在这几年发展不可同日而语,百亿参数规模大家都有点开始倾向于叫小模型了。

整体来讲,它的研发成本依然是比较高的。模型体积、算力要求、数据要求都非常大,对基础软硬件的考验也非常大。必须得在基础软硬件这一层有非常强的支撑,才能真正把一个优秀的、效果好的大模型高效地训练出来。

对于基础软硬件的要求也是前所未有的高。

应该说,以前很多人工智能应用开发非常依赖基础软件,但是对它的要求没有那么极致,相对来讲算力规模没有那么大,整体数据量没那么大。

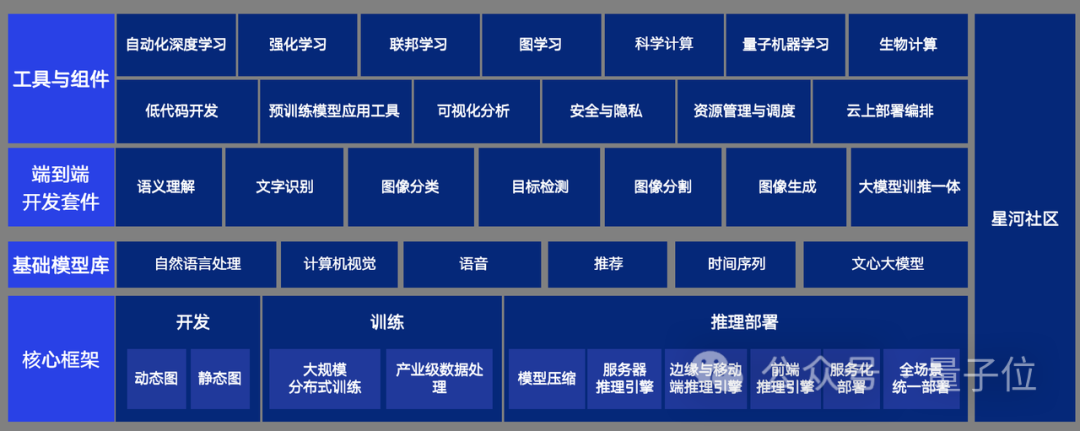

现在大模型很不一样,我们建设百度飞桨深度学习平台,是开源开放的平台,有非常多开发者都在使用,用基础软件来支撑现在大模型的整个开发训练,以及未来在大量应用当中的部署。

飞桨和文心通过联合优化,平台有效的训练时间做到98%,这是非常高的。

对于了解大模型训练特点的人而言,这么大的集群规模,98%的训练时间都是有效的,这是非常难的。另外整个推理性能也有非常大的提升。

当然了,我们在建设过程当中也非常期待跟生态伙伴一起推进,所以我们建设了星河社区,提供异构算力,提供一系列的包括飞桨和文心的基础能力,形成一站式综合服务的平台,让开发者能够在这个平台上进行交流、互相促进。

从整个生态来讲,飞桨和文心平台有1070万开发者(截至2023年底),整体来说和各类生态伙伴都有全面合作,包括芯片的合作伙伴、数据和技术的合作伙伴等等。

百度希望携手生态伙伴通力合作共创共赢,能够把大模型的技术能力更好地赋能千行百业的技术应用。

在12月28日举办的第十届WAVE SUMMIT深度学习开发者大会上,百度最新发布飞桨开源框架2.6版本和大模型重构的开发工具链,包括全新发布Comate AutoWork,飞桨低代码开发工具PaddleX v2.2,升级面向生态的文心一言开发机制,打造更智能、高效、低门槛的AI原生应用开发新范式,助力开发者把握大模型时代红利。

— 完 —

点这里 本文内容由网友自发贡献,转载请注明出处:https://www.wpsshop.cn/w/酷酷是懒虫/article/detail/787437

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。