热门标签

热门文章

- 1【hadoop】eclipse中运行hadoop相关程序出现Unable to load native-hadoop library for your platform解决方法_eclipse unable to load native-hadoop library for y

- 2mysql bit 对gorm使用何种类型?_mysql bit在go中怎么表示

- 3记录我裸辞的这100天_cc冥想怎么样了

- 4【时间序列竞赛方案】Baidu KDD Cup 2022 风电预测比赛总结 (含19个高分方案)

- 5Spring系列之异步@Async_spring 异步

- 6FPGA_fpga 是可编程阵列处理器,多用在操作系统仿真、算法固化等方面,它的性能不 如

- 7逆向推理与因果推断:人工智能在数据挖掘的应用

- 8如何看待云计算的第三次浪潮?

- 9FFNs网络理解(部分)

- 10java计算机毕业设计(附源码)学生信息管理系统(ssm+mysql+maven+LW文档)

当前位置: article > 正文

DL之GRU:GRU算法相关论文、建立过程(基于TF)、相关思路配图集合、TF代码实现_gru正式论文

作者:酷酷是懒虫 | 2024-07-14 13:24:17

赞

踩

gru正式论文

DL之GRU:GRU算法相关论文、建立过程(基于TF)、相关思路配图集合、TF代码实现

目录

相关论文

Paper:《Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation基于RNN编码器的统计机器翻译短语表征学习》的翻译与解读

https://yunyaniu.blog.csdn.net/article/details/100701711

DL之RNN/LSTM/GRU:《Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling门控循环神经网络在序列建模上的实证评估》的翻译与解读

https://yunyaniu.blog.csdn.net/article/details/81843784

GRU算法的简介

GRU是LSTM网络的一种效果很好的变体,它较LSTM网络的结构更加简单,而且效果也很好,因此也是当前非常流形的一种网络。GRU既然是LSTM的变体,因此也是可以解决RNN网络中的长依赖问题。

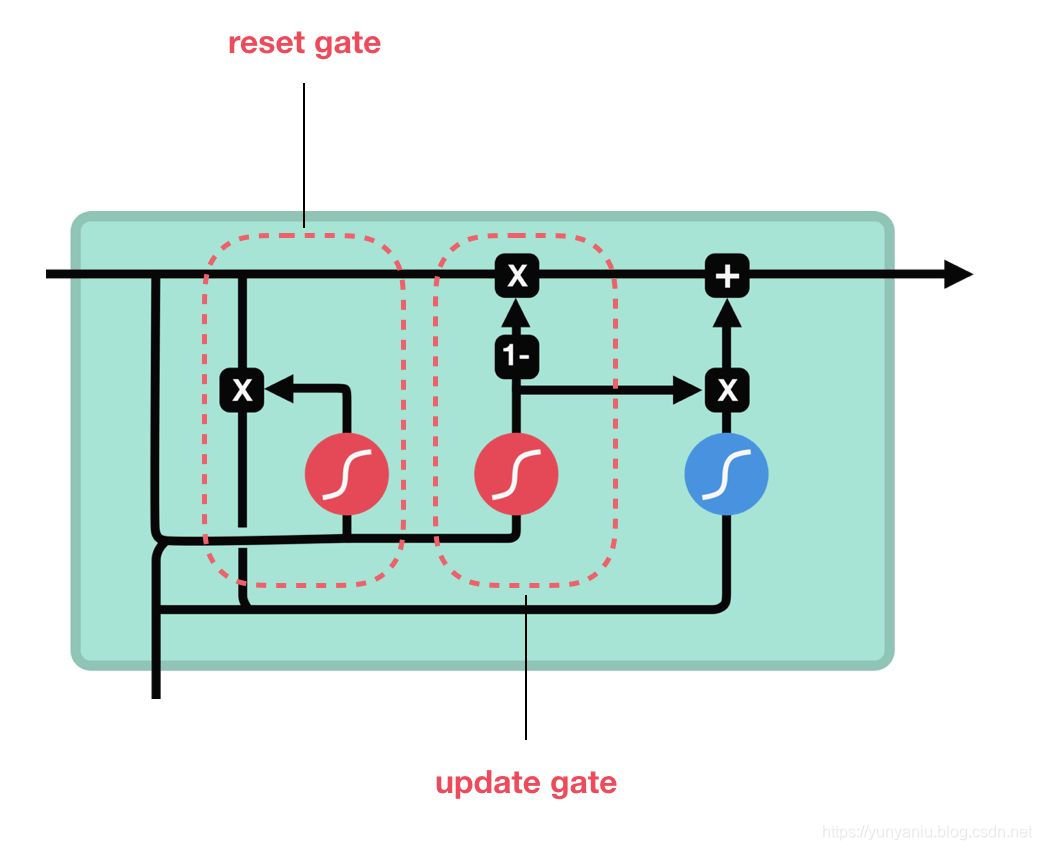

GRU门控循环单元是新一代的循环神经网络,与 LSTM 非常相似。与 LSTM 相比,GRU 去除掉了细胞状态,使用隐藏状态来进行信息的传递。它只包含两个门:重置门、更新门。

(1)、GRU的两个门控机制的特殊之处在于,它们能够保存长期序列中的信息,且不会随时间而清除或因为与预测不相关而移除。

(2)、GRU不会随时间而清除以前的信息,它会保留相关的信息并传递到下一个单元,因此它利用全部信息而避免了梯度消失问题。

- 重置门:重置门用于决定遗忘先前信息的程度。重置门决定了如何将新的输入信息与前面的记忆相结合,

(1)、重置门其实强制隐藏状态去遗忘一些历史信息,并利用当前输入的信息。这可以令隐藏状态遗忘任何在未来发现与预测不相关的信息,同时也允许构建更加紧致的表征。

(2)、本质上来说,重置门主要决定了到底有多少过去的信息需要遗忘。 - 更新门:更新门的作用类似于 LSTM 中的遗忘门+输入门。它决定要忘记哪些信息以及哪些新信息需要被添加。更新门定义了前面记忆保存到当前时间步的量。

(1)、更新门将控制前面隐藏状态的信息,有多少会传递到当前隐藏状态,这与 LSTM 网络中的记忆单元非常相似,它可以帮助 RNN 记住长期信息。

(2)、更新门帮助模型决定到底要将多少过去的信息传递到未来,或到底前一时间步和当前时间步的信息有多少是需要继续传递的。这一点非常强大,因为模型能决定从过去复制所有的信息以减少梯度消失的风险。

GRU算法建立过程(基于TF)

更新……

GRU算法的TF代码实现

更新……

推荐阅读

相关标签