- 1Android 各分区解释_基带在boot文件里面吗

- 2[YOLOv7]基于YOLOv7的动物识别系统(源码&部署教程)_yolov7动物识别

- 3linux kernel 中双向链表详解(一)_list_first_entry

- 4Elasticsearch集群部署(概念以及详细操作步骤)_elasticsearch 部署集群有几种方式

- 5听伯克利博士给你讲解Llama 2的技术细节

- 6Elasticsearch(十二)搜索---搜索匹配功能③--布尔查询及filter查询原理_elasticsearch filter

- 7便捷到家服务:同城系统源码新助力

- 8Python源码:使用海龟画图turtle画一个会动的星空_turtle海底星空

- 9人脸检测识别对比_opencv yunet人脸检测

- 10虚拟服务器hydra,使用hydra构建六大服务器及混合服务器

初识大模型-书生·浦语大模型全链路开源开放体系

赞

踩

一、大模型开源体系及其发展趋势

1.书生浦语大模型全链路开源体系

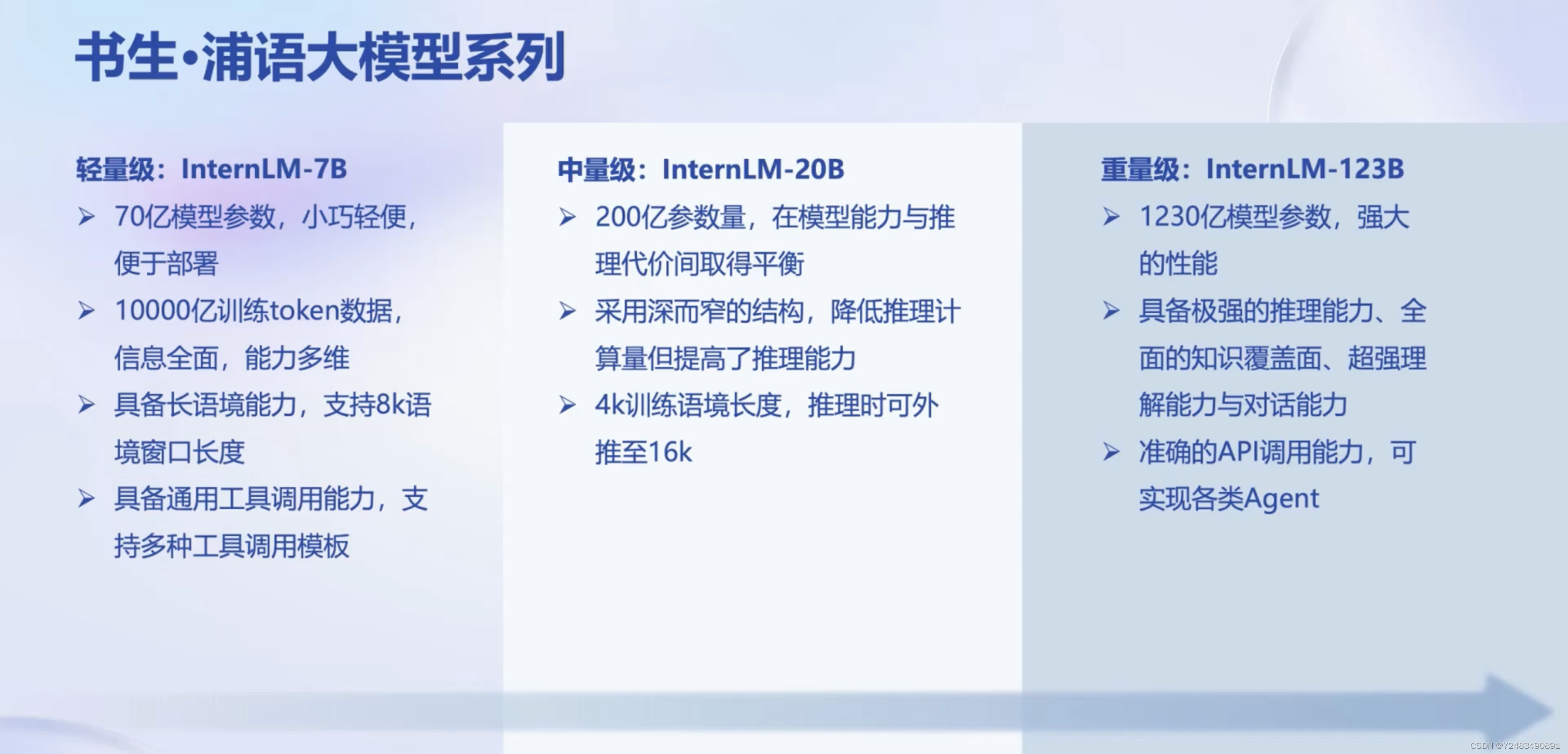

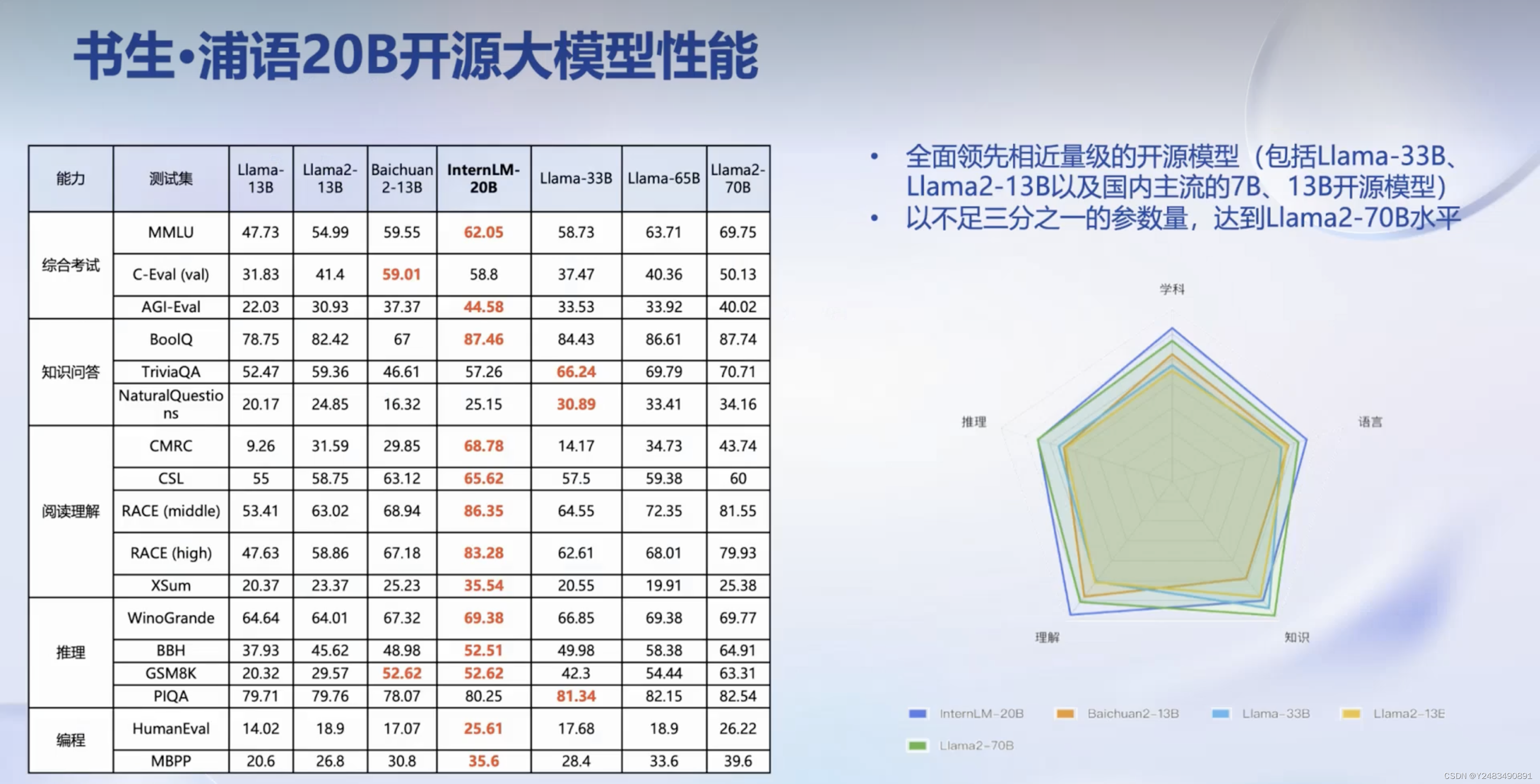

书生浦语大模型全链路开源体系是书生浦语大模型的研发和应用体系,包括模型研发、工具体系和预训练语料库等。书生浦语大模型的规模包括轻量级、中量级和重量级,其中轻量级以70亿参数的模型为代表,中量级以200亿参数的模型为代表,重量级以千亿参数的模型为代表。

2.大模型的发展趋势

大模型在人工智能领域的研究和应用越来越受到关注。

重要原因:

1.大模型是发展人工通用人工智能的一个重要途径。我们可以看到整个的一个AI的研究方向是从专用模型(针对特定的任务来去解决特定的一个用一个模型来去解决一个特定的问题)到通用模型这样的一个过程。

2.现在,更加倾向于用一个模型去应对多种任务和多种模态(ChatGPT),GPT4更是把模态从单纯的这样的语言的模态拓展到了视觉的模态。模型的通用性大幅提高(更面向更高阶的智能的这样的一种潜在的途径)

总结:大模型能够受到广泛关注的原因是它是发展人工通用人工智能的一个重要途径,能够应对多种任务和多种模态,具有更面向更高阶的智能的潜在途径。

书生浦语的大模型其实已经就完成了覆盖轻量级、中量级、重量级的这样的一套不同大小的系列。

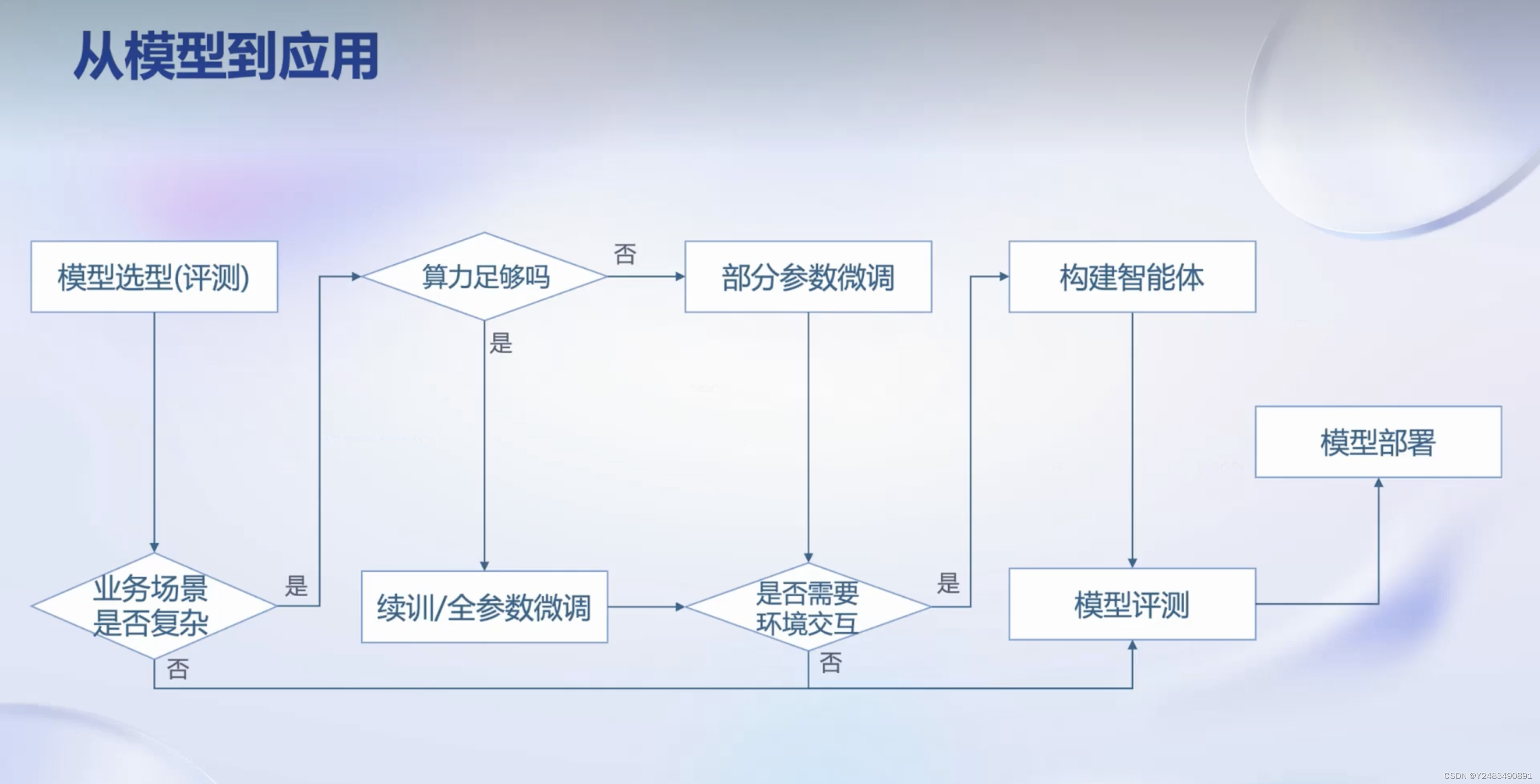

二、大模型从模型到应用的步骤和开源工具

1.有了模型之后,是不是就意味着我们能够去得到一个基于大模型的应用?

没有那么简单,其实也需要去借助一些一些工具,或者说一些框架来去协助它的完成。

2.大模型应用的关键步骤

模型选型、评估业务场景复杂度、微调、部署和评测

3.书生浦语开源开放体系

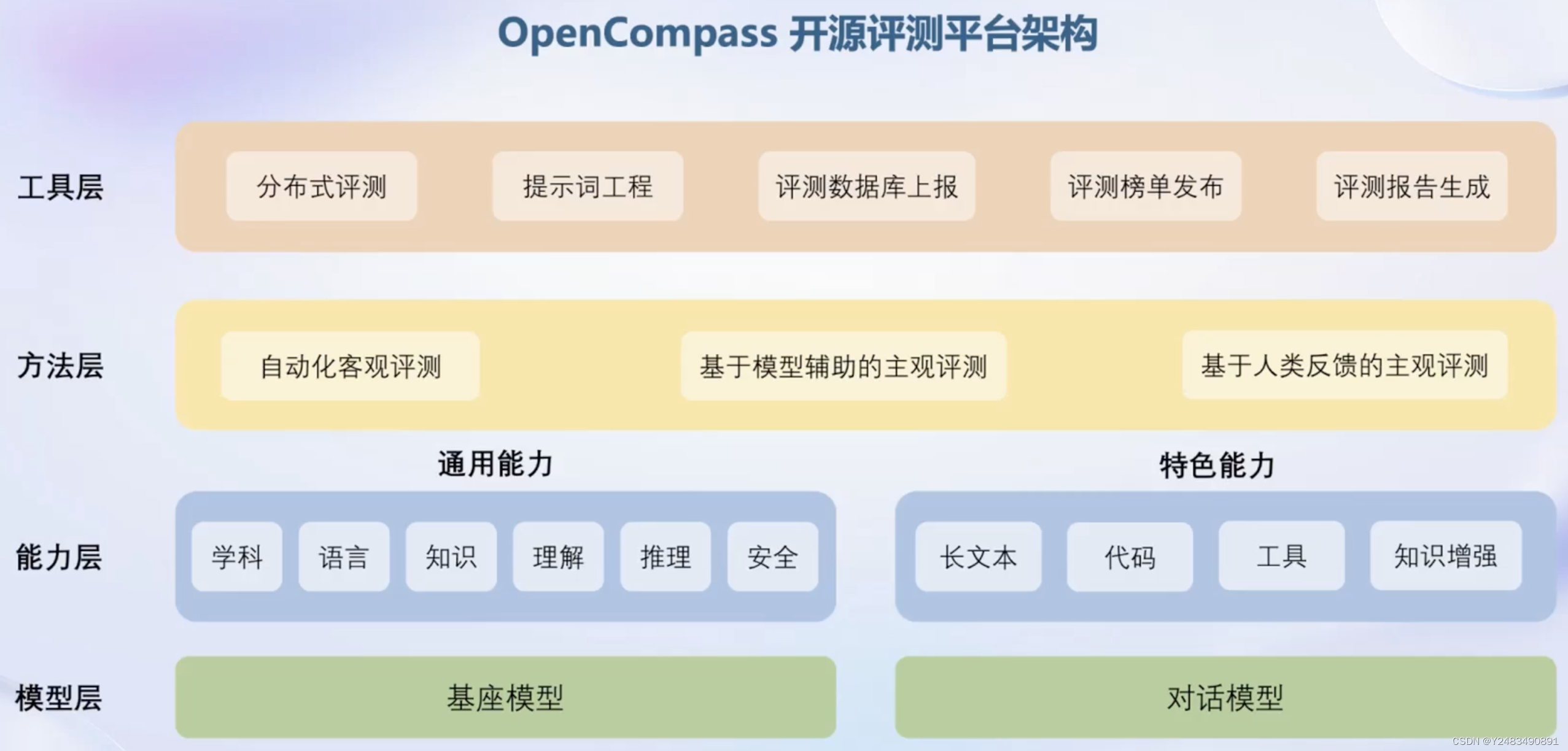

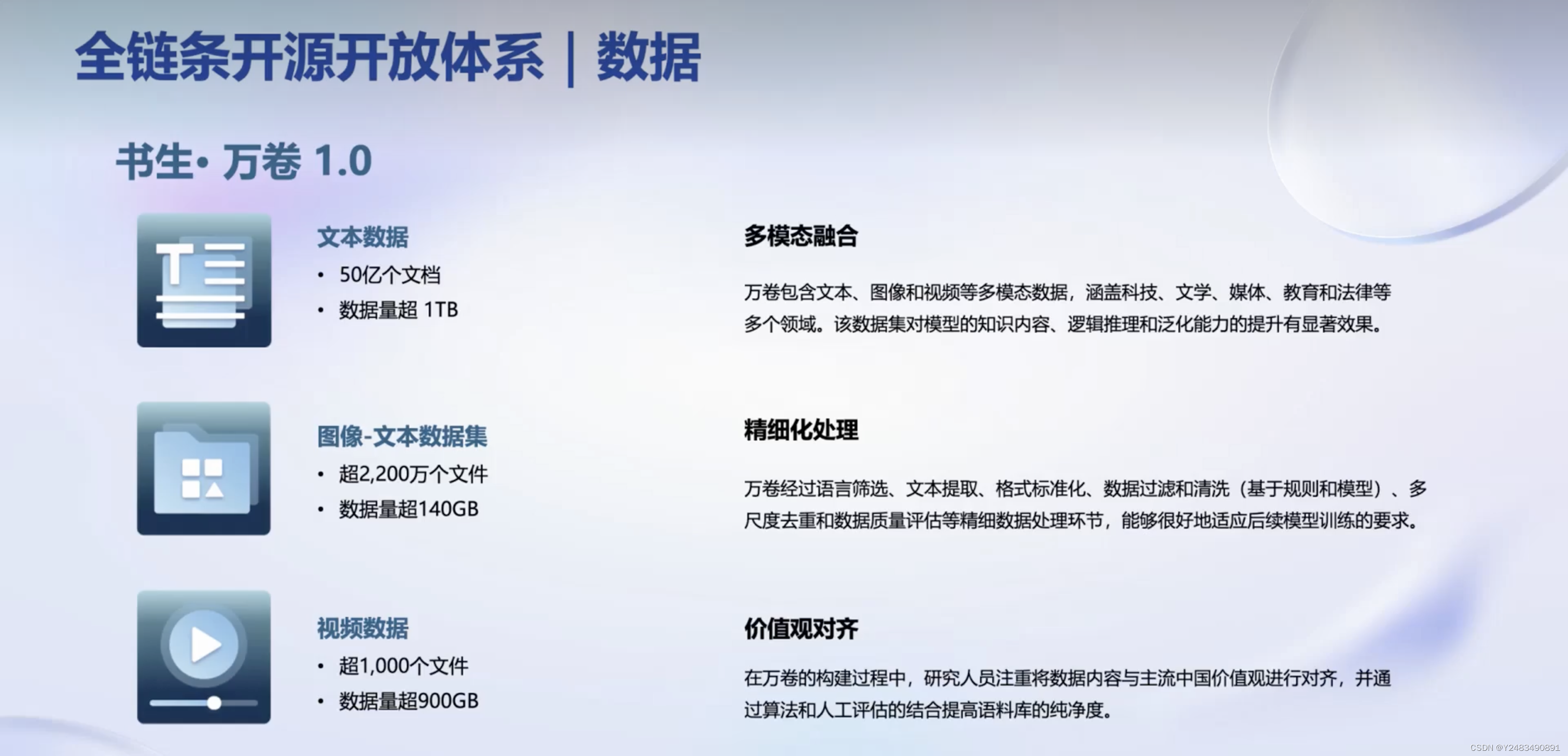

书生浦语开源开放体系,包括数据(开源的书生万卷这样的一个多模态的语料库。它里面包括了2TB的数据,也涵盖了多种模态和任务)、预训练(开源了internLM- train一个预训练框架)、微调(X tuner框架)、部署(LMDeploy)、评测(opencompass等工具)和应用等全链条环节,以及开源工具的功能和优势。

3.1 数据:书生万卷

书生万卷是一个多模态的语料库,包括文本、图像和视频数据,对模型的推理能力有显著提升效果。

3.2 预训练工具:internLM- train

internLM- train特点

| 高可扩展 支持从 8 卡到干卡训练 干卡 加速效率达 92% | |

| 极致性能优化 Hybrid Zero 独特技术+ 极致优化,加速 50% | |

| 兼容主流 无缝接入 HuggingFace 等 技术生态,支持各类轻量化 技术 | |

| 开箱即用 支持多种规格语言模型,修改配置即可训练 |

3.3 微调:X tuner框架

大语言模型的下游应用中,增量续训和有监督微调是经常会用到两种方式。

增量续训

使用场景:让基座模型学习到一些新知识,如某个垂类领域知识训练数据:文章、书籍、代码等

有监督微调

使用场景:让模型学会理解和遵循各种指令,或者注入少量领域知识训练数据:高质量的对话、问答数据

适配多种生态

- 多种微调算法

多种微调策略与算法,覆盖各类 SFT 场景 - 适配多种开源生态

支持加载 HuggingFace、ModelScope 模型或数据集 - 自动优化加速

开发者无需关注复杂的显存优化与计算加速细节

适配多种硬件

- 训练方案覆盖 NVIDIA 20 系以上所有显卡

- 最低只需 8GB 显存即可微调 7B 模型

3.4 评测:opencompass

亮点:

| 丰富模型支持 | 分布式高效评测 | 便捷的数据集接口 | 敏捷的能力选代 |

| 开源模型、API 模型一站式评测 | 数据集上分布式评测 | 支持干亿参数模型在海量 支持社区用户根据自身需求每周更新大模型能力版单,快速添加自定义数据集 | 每月提升评测工具能力 |

3.5 部署:LMDeploy

大语言模型特点

内存开销巨大

- 庞大的参数量

- 采用自回归生成token,需要缓

存k/v

动态Shape

- 请求数不固定

- token逐个生成,且数量不定模型结构相对简单

- transformer 结构,大部分是

decoder-only

技术挑战

设备

• 低存储设备(消费级显卡、移动端等)如何部署?

推理

- 如何加速 token 的生成速度

- 如何解决动态shape,让推理可以不间断

- 如何有效管理和利用内存

服务

- 提升系统整体吞吐量

- 降低请求的平均响应时间

部署方案

技术点

- 模型并行

- 低比特量化

- Attention优化

- 计算和访存优化

- Continuous Batching

三、智能体应用方面的局限性及解决方案

1.智能体应用方面的局限性

智能体应用方面的局限性,如对最新信息和知识的获取能力不足、可靠性问题以及对外部工具的使用和交互等。

为解决这些问题,需要搭建智能体框架,并调用不同的模块和工具进行规划、推理和执行。

2.开源的轻量级智能体框架lagend

开源的轻量级智能体框架lagend,以及其支持的不同类型的智能体和大语言模型。lagend和agent lego这两个工具箱,分别聚焦于智能体框架和提供多个工具集合,支持各种输入输出格式和主流智能检测系统。