- 1ESP8266+blinker(点灯科技)_blinker控制esp8266灯亮_点灯科技 eeprom address 0-1279 is used for auto contro

- 2Git 基本操作_git 基变

- 3【送书福利-第十二期】机工社Python与AI好书来袭!~_百度网盘 python大学教程 面向计算机科学和数据科学 开*一会

- 4智慧城市大数据分析系统解决方案_基于大数据技术的智慧城市运营与管理研究的系统设计

- 5十、W5100S/W5500+RP2040树莓派Pico<PING(ICMP)检测网络连通性>_w5500默认icmp配置

- 6Netlify Lambda函数教程

- 7ARINC429基础知识_hb6096

- 8Scala编程基础1:基本数据类型、变量、if、for、IO

- 9ROS机器人 (一) : URDF模型搭建小车_urdf小车模型

- 10Hadoop集群搭建以及遇到问题详解_hadoop使用中grep命令没有往文件写入数据

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片_英伟达gb200架构解析 csdn

赞

踩

2024年3月19日,英伟达CEO黄仁勋在GTC大会上公布了新一代AI芯片架构BLACKWELL,并推出基于该架构的超级芯片GB200,将助推数据处理、工程模拟、电子设计自动化、计算机辅助药物设计、量子计算和生成式 AI 等领域。

为了纪念杰出的数学家David H. Blackwell,英伟达 Blackwell架构被明确设计用来满足现代人工智能工作负载日益增长的计算和带宽需求。随着人工智能模型在规模和复杂性上呈指数级增长,对先进计算能力和内存容量的需求变得至关重要。Blackwell图形处理器架构通过在性能和效率方面实现大幅跃升,解决了这些需求。

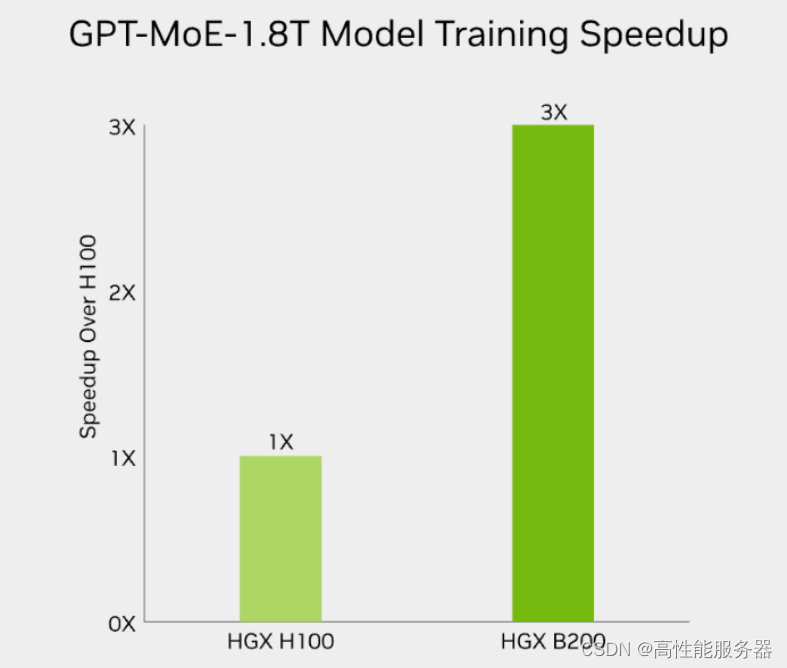

HGX B200 训练性能提升3倍,推理能力提升 15 倍

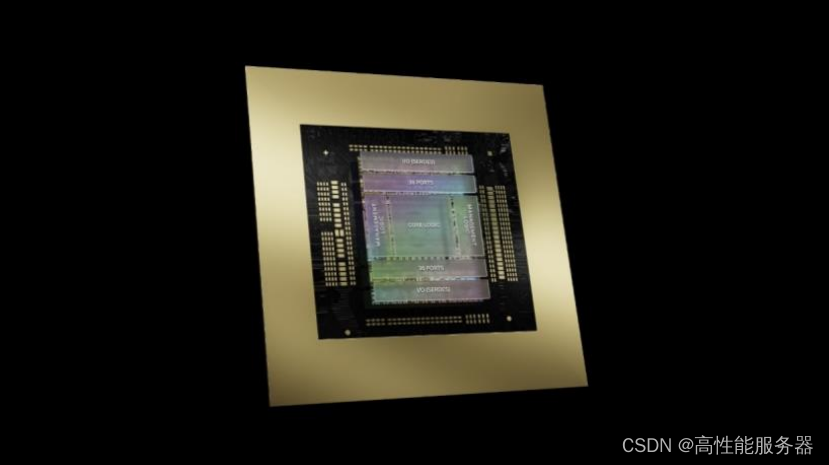

GB200由两个B200 Blackwell GPU和一个基于Arm的Grace CPU组成,采用台积电4纳米工艺制程,共有2080亿个晶体管,其AI性能为每秒20千万亿次浮点运算。

英伟达还构建了由72张GB200构成的DGX GB200 NVL72超级计算机。该超级计算机在内部节点间使用铜缆连接,以降低功耗。

Blackwell 图形处理器采用双芯片配置,通过英伟达高带宽接口(NV-HBI)将两个最大可制造芯片合并为一个图形处理器单元,支持10TB/s带宽,形成高效的通信通道,提升整体性能。

配备192GB的HBM3e内存、超过8TB/s的峰值内存带宽和1.8TB/s的NVLink带宽,使处理能力翻倍,大幅增加内存容量和带宽,为处理大规模人工智能模型和复杂计算提供必要资源。

针对大规模模型如GPT-MoE-1.8T,HGX B200的推理性能比上一代NVIDIA Hopper™提高了15倍。采用第二代Transformer引擎、定制的Blackwell Tensor Core技术、TensorRT™-LLM和Nemo™框架的创新,显著加速了大型语言模型(LLM)和专家混合(MoE)模型的推理过程。

第二代Transformer引擎采用8位浮点(FP8)和新的精度等技术,将大型语言模型如GPT-MoE-1.8T的训练速度提高3倍。同时,第五代NVLink、InfiniBand网络和NVIDIA Magnum IO™软件的支持,确保企业和广泛GPU计算集群的高效可扩展性。

HGX B200 深度学习推理能力

英伟达第五代 NVLink 技术的整合支持多达 576 个图形处理器,提供 3.6 千万亿次网络内计算,在网络结构中直接减少和组合张量,优化计算任务并增强图形处理器集群的可扩展性。

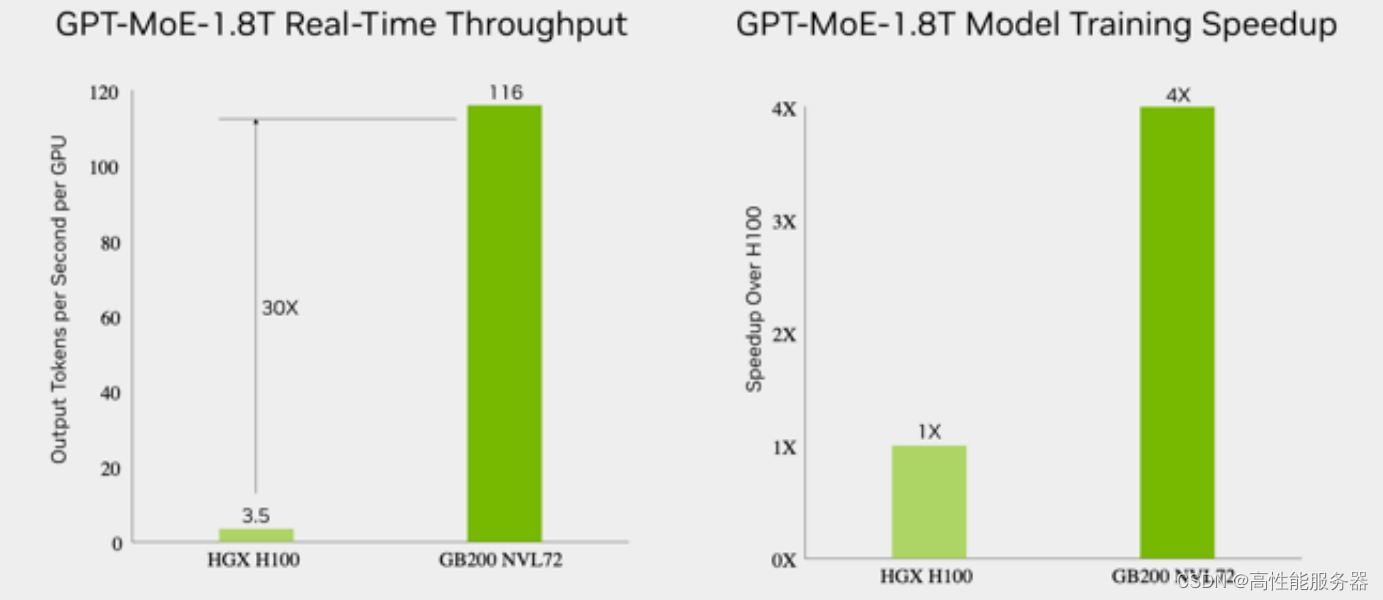

GB200 训练性能提升至 4 倍,推理能力提升至 30 倍

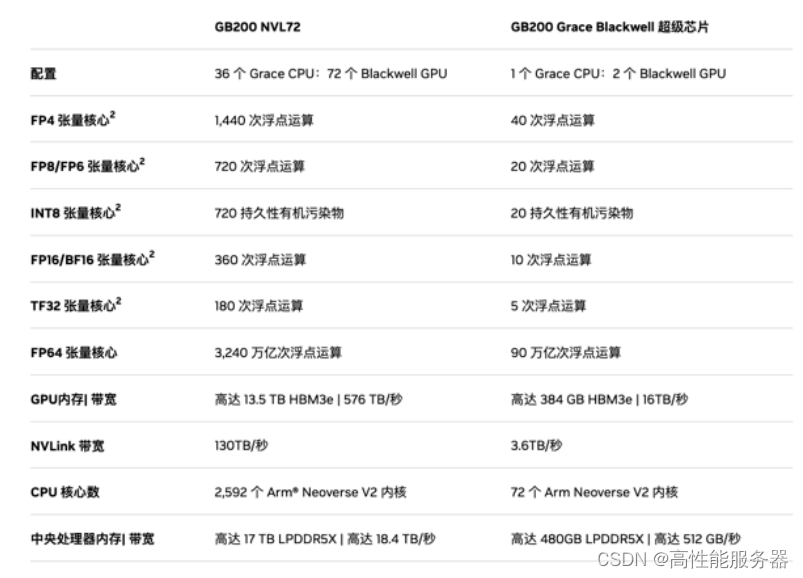

GB200 NVL72 集群将多个由 GB200 驱动的系统整合到一个液冷机架中。连接 36 个 GB200 超级芯片(36 个Grace中央处理器和 72 个Blackwell 图形处理器),为数据中心提供前所未有的计算能力。GB200 NVL72,解锁实时万亿参数模型,为万亿参数的大型语言模型(LLM)推理提供30倍的实时速度提升。GB200 NVL72 通过机架级设计,NVIDIA GB200 NVL72 的核心,GB200 Grace Blackwell Superchip,采用 NVIDIA NVLink-C2C 互连技术,将2个高性能 NVIDIA Blackwell Tensor Core GPU 与1个NVIDIA Grace CPU 连接,实现高效的计算协同。GB200 NVL72 同时集成尖端功能和第二代 Transformer 引擎,利用第五代NVIDIA NVLink,支持 FP4 AI 精度。

GB200 NVL72是一款性能卓越的计算平台,采用更快的第二代Transformer引擎和FP8精度,可将大型语言模型的训练速度提升4倍。通过每秒1.8TB的GPU到GPU互连速度、InfiniBand网络和NVIDIA Magnum IO™软件的第五代NVLink技术,GB200 NVL72性能显著提升。

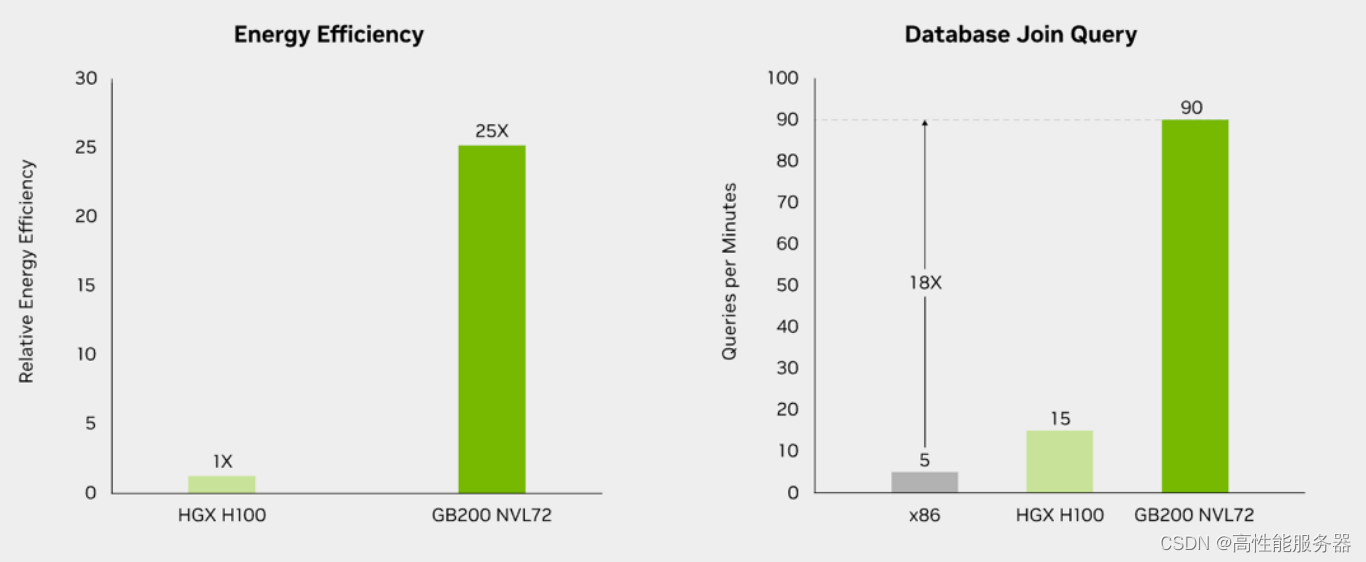

此外,GB200 NVL72还采用液体冷却技术,提高计算密度,减少占地面积,并通过高带宽、低延迟的GPU通信,有效减少数据中心的碳足迹和能源消耗。相较于传统的NVIDIA H100风冷基础设施,GB200在相同功耗下实现25倍的性能提升,同时降低水消耗。利用NVIDIA Blackwell架构的高带宽内存性能、NVLink-C2C和专用解压缩引擎,GB200大幅提高关键数据库查询的速度,比CPU提升18倍,并将总体拥有成本(TCO)降低5倍,为企业处理和分析大规模数据提供强大支持。

GB200 NVL72 规格

GB200 NVL72 规格

GB200 NVL 72 推理能力和速度对比

GB200 NVL72 性能和能耗对比

第五代NVLink GPU为百亿亿次计算和万亿参数模型提供基础

NVIDIA推出世界首个高速GPU互连技术NVLink™,提供的速度远超基于PCIe的解决方案,是多GPU系统扩展内存和性能的理想选择。NVLink为处理最大视觉计算工作负载、释放百亿亿次计算能力和万亿参数人工智能模型的全部潜力提供关键基础。

NVLink释放数万亿参数AI模型的加速性能,显著提升大型多GPU系统的可扩展性。每个英伟达Blackwell Tensor Core GPU支持多达18个NVLink连接,每个连接速度可达100 GB/秒,总带宽达到1.8 TB/秒,是上一代产品的两倍,超过PCIe Gen5的14倍以上。NVLink技术为高性能计算和人工智能领域带来突破性的进展,为用户提供更快速、更强大的计算能力。

NVlink 技术参数对比

NVLink Switch协同NVLink释放数据传输能力。通过连接多个NVLink,NVLink Switch实现机架内和机架间全速度的GPU通信,提供1.8TB/s双向直接GPU到GPU互连技术,显著扩展服务器内多GPU的输入和输出能力。NVLink Switch还配备NVIDIA可扩展分层聚合和缩减协议(SHARP)™引擎,优化网络内缩减和多播加速,进一步提高通信效率。

NVLink Switch 允许 NVLink 连接跨节点扩展,形成高带宽、多节点GPU集群,实际上创建了数据中心级的GPU。在NVL72系统中,NVLink Switch实惊人的130TB/s的GPU带宽,极大增强大型模型的并行处理能力,使得多服务器集群可以随着计算量的增加而扩展GPU通信,支持的GPU数量是单8个GPU系统的9倍。

作为NVIDIA数据中心解决方案的关键构建模块,NVLink和NVLink Switch整合英伟达AI Enterprise软件套件和NVIDIA NGC™目录中的硬件、网络、软件、库及优化的AI模型和应用程序,为用户提供全面的AI计算解决方案。

DGX SuperPOD - 专为人工智能设计的数据中心

NVIDIA 发布专为训练和推理万亿参数生成式AI模型而设计的数据中心解决方案——DGX SuperPOD™。每个采用液冷技术的机架配备36个NVIDIA GB200 Grace Blackwell Superchips,这些超级芯片集成了36个NVIDIA Grace CPU和72个Blackwell GPU,并通过NVIDIA NVLink技术连接。DGX SuperPOD可以通过NVIDIA Quantum InfiniBand连接多个机架,实现数万个GB200超级芯片的扩展,以满足大规模AI模型的训练和推理需求。

DGX SuperPOD配备智能控制平面,能够监控数千个数据点,确保系统连续运行、数据完整性,并自动重新配置集群以避免停机。每个DGX GB200系统搭载一个Grace CPU和两个Blackwell GPU,通过第五代NVLink连接,实现每秒1.8TB的GPU到GPU带宽。这种设计优化数据传输速度,显著提高处理效率,使DGX SuperPOD成为处理万亿参数生成式AI模型的理想选择。

NVL72 机架级系统支持万亿参数 LLM 训练和实时推理

GB200 NVL72 的机架级设计,通过在单个 NVIDIA NVLink 域上连接 72 个 Blackwell GPU,标志着 AI 超级计算的一次重大进步。这种独特的配置显著减少传统网络扩展时 的通信开销,使得对 1.8T 参数的模型进行实时推理成为可能,同时将模型训练速度提升4倍。借助72个 NVLink 连接的 Blackwell GPU 和 30TB 的统一内存,在130 TB/s 的计算结构上运行,GB200 NVL72 在单个机架中创造了一个exaFLOP 级别的 AI 超级计算平台,为处理最复杂的大型模型提供前所未有的计算能力。

GB200 NVL72 的 Blackwell 架构通过引入硬件解压缩引擎,具备大规模本地解压缩压缩数据能力,优化端到端的分析管道。原生支持 LZ4、Deflate 和 Snappy 压缩格式,加速内存绑定的内核操作,提供高达 800 GB/s 的性能。解压缩引擎的加入,结合高达 8 TB/s 的高内存带宽和 Grace CPU 的高速 NVLink 芯片到芯片(C2C)互连,显著加快数据库查询过程。在查询基准测试中,Grace Blackwell 的执行速度比 CPU (Sapphire Rapids)快 18 倍,比 NVIDIA H100 Tensor Core GPU 快 6 倍。

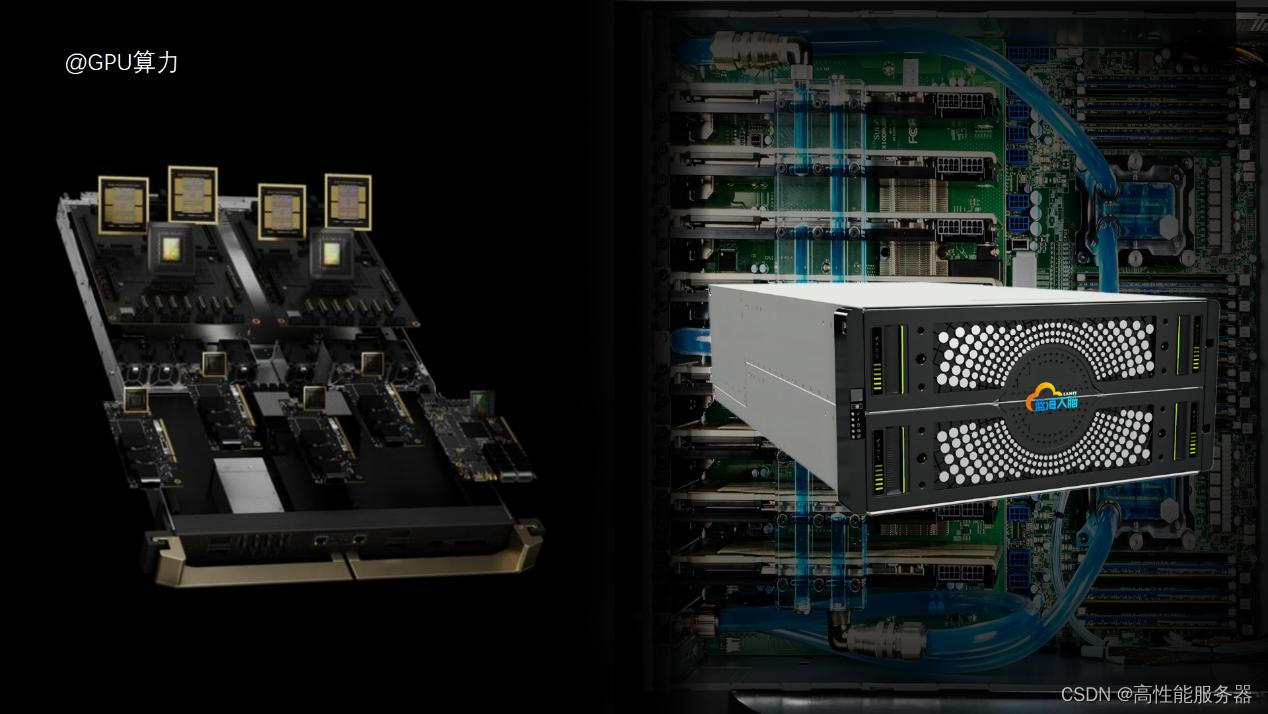

采用液体冷却的 GB200 计算托盘可实现高能效和高计算精密度

NVIDIA GB200 Grace Blackwell超级芯片是GB200 NVL72的核心,通过NVLink C2C接口连接,提供900GB/s的双向带宽。该设计简化编程过程,支持更大内存需求的万亿参数LLM、变压器模型和大规模模拟模型。GB200计算托盘采用全新的NVIDIA MGX设计,包含2个Grace CPU和4个Blackwell GPU,采用液冷技术,大幅降低成本和能耗。可提供80 petaflops的AI性能和1.7TB的快速内存。

GB200 NVL72利用NVIDIA NVLink Switch系统和铜电缆盒密集连接GPU,优化并行模型效率,液冷设计进一步降低能耗。全新的第五代NVLink在单个域中可连接多达576个GPU,带宽超过1PB/s,为大型模型的无缝高速通信设定新标准。

英伟达BlueField 实现数据中心转型

NVIDIA BlueField 网络平台为现代数据中心和超级计算集群带来了前所未有的创新。凭借强大的计算能力以及用于网络、存储和安全加速的内置软件定义硬件加速器,BlueField 可为各种环境中的多种工作负载提供安全的加速基础设施,助力企业步入加速计算和 AI 的新时代,增强云网络加速和安全。

此外,Blackwell 引入英伟达机密计算技术,在不影响性能的情况下,增强了大规模实时s生成式人工智能推理的安全性。该架构还具有新的解压缩引擎和用于人工智能预防性维护的可靠性引擎,有助于诊断并预测潜在的可靠性问题,进一步巩固了系统的稳健性。

英伟达Blackwell架构的创新之处体现在哪些方面?

1、核心技术

Blackwell GPU采用先进的4纳米台积电工艺,封装多达2080亿个晶体管,突破半导体制造技术的界限。

2、技术规格对比

最大内存:从 H100 的 80GB HBM3 到 B200 的 192GB HBM3e。

内存带宽:从 H100 的 3.35TB/s 增加到 B200 的 8TB/s。

算力:各种浮点计算能力在新一代GPU中得到了显著提升。

3.创新功能

Transformer 引擎:第二代引擎显著提高了计算、带宽和模型大小效率。

RAS 引擎:增强 AI 部署的可靠性、可用性和可维护性。

机密计算:推出业界首款支持可信执行环境 (TEE)-I/O 的 GPU。

4.数据处理能力

新的解压引擎大大加快了数据分析和数据库查询的速度,使 Blackwell 在性能上取得了显着的领先地

5.NVIDIA HGX 更新

推出新的 HGX 服务器系列,显著提高性能并降低总拥有成本。

6.NVIDIA Grace-Blackwell 超级芯片

GB200 超级芯片标志着 NVIDIA 在高性能计算、优化连接性和可扩展性领域的重大进展。

7.网络技术

GB200 集成了 NVIDIA 的最新网络技术,提出了连接性和带宽方面的进步。

8.NVLink 和 NVLink 交换机

第五代 NVLink 改善了 GPU 之间的连接,并为高性能计算和 AI 应用提供了关键支持。

9.DGX SuperPOD 和量子模拟云服务

展示 NVIDIA 在 AI 超级计算和量子计算服务方面的最新进展。

10.NVIDIA NIM 软件栈和 OVX 计算系统

推出新的软件和计算系统,加速企业级 AI 应用的开发和部署。

英伟达Blackwell架构在高性能计算方面的应用有哪些?

- 人工智能训练和推理

Blackwell 架构的 GPU 核心在训练性能上相较前代 Hopper H100 GPU 提升了四倍,推理性能提升最高可达 30 倍,能源效率提高了 25 倍。这些提升使得它能够更快地处理大规模的人工智能任务,加速模型的训练和推理过程。

- 超级计算机

英伟达推出的 DGX GB200 超级计算机由 3600 个 GB200 超级芯片模块组合而成,通过 Nvlink 链接,提供了超大规模的并行计算能力和极高的内存带宽,适用于大规模的 AI 训练、推理和高性能计算任务。

- 大模型训练

Blackwell 架构的 GPU 支持多种浮点数格式,如 FP32、FP16、BFLOAT16 甚至 INT8 等,较小的浮点数格式允许在同样的芯片面积上集成更多的计算单元,实现更密集的并行计算,从而提升大模型训练和推理的速度。

英伟达 Blackwell 架构在高性能计算方面的应用为人工智能和其他计算密集型任务提供了更强大的处理能力和效率。这些应用将有助于推动科学研究、数据分析、智能医疗等领域的发展。

英伟达Blackwell架构在数据中心方面的应用有哪些?

- AI 大模型训练

Blackwell 架构的 GPU 针对当前火爆的 AI 大模型进行了优化,能够显著提升训练和推理性能,加速模型的训练和推理过程。

- 生成式 AI 解决方案

与英伟达 Grace CPU、新一代网络芯片等产品一起,面向生成式 AI 共同组成完整解决方案,为数据中心提供强大的计算能力和效率。

- 提升通讯带宽

新架构实现了带宽的多维度提升,包括 HBM3e 带宽、NVLink 带宽和 PCIe 6.0 带宽,这有助于满足数据中心对高带宽的需求,提高数据传输速度和效率。

- 优化成本

英伟达最新机架解决方案 GB200 提升了性能,降低了 CPU:GPU 配比,有助于降低客户的总拥有成本(TCO)。

这些应用将有助于推动数据中心的发展,为人工智能、云计算等领域提供更强大的支持。

英伟达Blackwell架构在人工智能领域有哪些应用?

- 人工智能训练

Blackwell 架构的 GPU 提供了强大的计算能力,可用于训练大规模的人工智能模型,如语言模型、图像识别模型等。

- 人工智能推理

Blackwell 架构的 GPU 能够快速处理人工智能推理任务,为实时应用提供支持,如语音识别、自然语言处理等。

- 数据中心

超微电脑借助英伟达 Blackwell 架构打造的顶尖生成式 AI 系统可应用于数据中心,为企业提供高效的人工智能解决方案。

- 科学研究

Blackwell 架构的 GPU 可用于科学研究中的数据分析、模拟和计算,加速研究进程。

- 自动驾驶

在自动驾驶领域,Blackwell 架构的 GPU 可以用于感知和决策算法的计算,提高车辆的安全性和自主性。 这些只是英伟达 Blackwell 架构在人工智能领域的一些应用示例,随着技术的不断发展,其应用场景还将不断扩大。

Blackwell架构和其他人工智能计算架构相比有哪些优势?

- 高性能

Blackwell 架构通过在性能和效率方面的大幅跃升,提供了卓越的计算能力。这使得它能够更快地训练和推理人工智能模型,处理大规模数据和复杂任务。

- 双芯片配置

其独特的双芯片配置将两个最大可制造芯片有效地合并为一个图形处理器单元,增加了处理能力、内存容量和带宽,为处理大规模人工智能模型和复杂计算提供了必要的资源。

- 高带宽内存

采用 HBM3e 内存和先进的制造工艺,Blackwell 架构提供了超过 8TB/s 的峰值内存带宽,有助于加速数据传输和处理,提高整体性能。

- 先进的技术整合

英伟达第五代 NVLink 技术的整合使上一代的性能翻倍,支持多达 576 个图形处理器,并提供 3.6 千万亿次网络内计算。允许在网络结构中直接减少和组合张量,优化计算任务并增强图形处理器集群的可扩展性。

- 安全性和可靠性

引入英伟达机密计算技术,在不影响性能的情况下,增强了大规模实时生成式人工智能推理的安全性。此外,新的解压缩引擎和用于人工智能预防性维护的可靠性引擎有助于诊断并预测潜在的可靠性问题,进一步巩固系统的稳健性。

- 广泛的应用支持

Blackwell 架构的高性能和可扩展性使其在多个领域都有应用潜力,包括自动驾驶、医疗保健、金融等。这为英伟达带来了更广泛的市场机会和业务增长。

英伟达Blackwell架构的安全性和可靠性如何保证?

英伟达 Blackwell 架构内置英伟达机密计算技术,可通过基于硬件的强大安全性保护敏感数据和 AI 模型,使其免遭未经授权的访问。英伟达机密计算技术通过创建一个可信的执行环境或安全飞地来保护数据和模型的安全性。在这个安全飞地中,数据和代码的隐私性以及完整性得到保证,防止未经授权的用户访问和修改。 具体来说,英伟达机密计算技术使用与处理器相连的加密密钥创建安全飞地。这个安全数字空间支持加密签名证明,通过正确配置硬件和固件来防止他人查看或更改数据或应用代码。同时,该技术还保证了数据和代码的隐私性以及它们的完整性,确保在运行人工智能训练或推理时输入数据的安全性,以及训练模型的知识产权得到保护。

此外,Blackwell 是业内首款具备可信执行环境(TEE)I/O 功能的 GPU,它不仅能够与安全的外部设备进行交互,还可以在不影响性能的情况下,增强大规模实时生成式 AI 推理的安全性。 同时,新的解压缩引擎和用于 AI 预防性维护的可靠性引擎有助于诊断并预测潜在的可靠性问题,进一步巩固了系统的稳健性。

英伟达在 2024 GTC 人工智能大会上公布的技术标志着图形处理器技术的变革性进展,满足广泛的行业需求,并在性能和效率方面树立新的标准。Blackwell架构和GB200 超级芯片有望推动英伟达在人工智能领域更进一步,巩固其在高性能计算和人工智能技术领域的领先地位。随着亚马逊网络服务、谷歌云和微软 Azure 等公司开始整合这些新系统,英伟达创新的影响将进一步扩大,预示着各个领域人工智能能力的新时代的到来。