- 1当世界加速离你而去

- 2【Mac】【Git】 全局配置 忽略 .DS_Store_mac git dostore

- 3苹果PDF压缩工具:PDF Squeezer_pdf squeezer ipad

- 4clang frontEnd插件 常见Traverse函数、Visit函数 例子

- 5pyspark连接MySQL出错 java.sql.SQLException: No suitable driver_pyspark : java.sql.sqlexception: no suitable drive

- 6数据结构笔记1 线性表-顺序表示_!l.elem什么意思

- 7web对象page、request、session、application的生命周期_request,session,cookie,application生命周期区别

- 8文心一言 VS 讯飞星火 VS chatgpt (71)-- 算法导论7.1 1题

- 9SpringCloud--LoadBalancer负载均衡服务调用

- 10minio最新版本(2022.10.31)简易集群搭建(详细到爆)

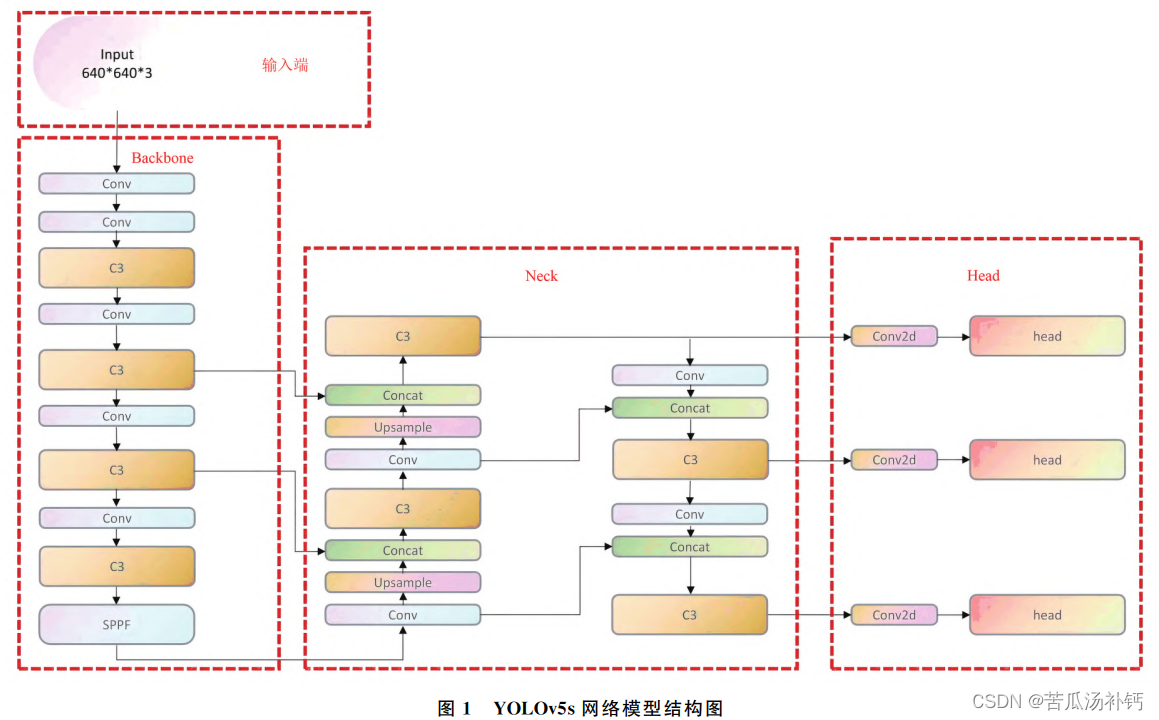

论文阅读:基于改进 YOLOv5算法的密集动态目标检测方法

赞

踩

目录

论文地址:基于改进YOLOv5算法的密集动态目标检测方法 - 中国知网 (cnki.net)

概要

目的:提出一种基于 YOLOv5改进的检测算法,解决密集动态目标检测精度低及易漏检的问题。

方法:在 YOLOv5的主干网络中使用 QARepNeXt结构提高深度学习模型训练速度;引入 S2-MLPv2注意力机制改善遮挡情况下检测效果差的问题;将具有动态聚焦机制的边界回归损失函数 Wise-IoU 替代 原有损失函数提高收敛速度。

结果:通过在公开数据集上的实验验证,改进算法在密集行人检测任务中表现出了更高的检测精度、更低的漏检率和更好的检测效果。相较于原始YOLOv5s网络模型,改进后的算法模型在复杂环境下展示了更强的鲁棒性和泛化能力,能够有效应用于密集动态目标检测及其相关领域。

结论:通过引入QARepNeXt结构、S2-MLPv2注意力机制和Wise-IoU损失函数,优化了YOLOv5s网络,提升了密集动态目标检测的性能。这一改进算法在实际应用中具有重要的潜力,尤其在行人检测等密集场景下表现出色,为相关领域的研究提供了新的思路和方法。

Motivation

- 密集动态目标检测,遮挡导致的检测精度低和漏检率高。

- 于行人尺度较小,检测难 度也增加。

整体架构流程

一种基于改进YOLOv5s算法的密集动态目标检测方法。主要改进包括:

1. 主干网络优化:引入QARepNeXt模块,增强网络特征提取和融合能力,提高检测精度。

2. 特征融合阶段改进:加入S2-MLPv2注意力机制,有效提取图像关键信息,提高对遮挡目标的关注度。

3. 损失函数替换:采用Wise-IoU损失函数,提高模型的收敛能力和检测精度。

技术细节

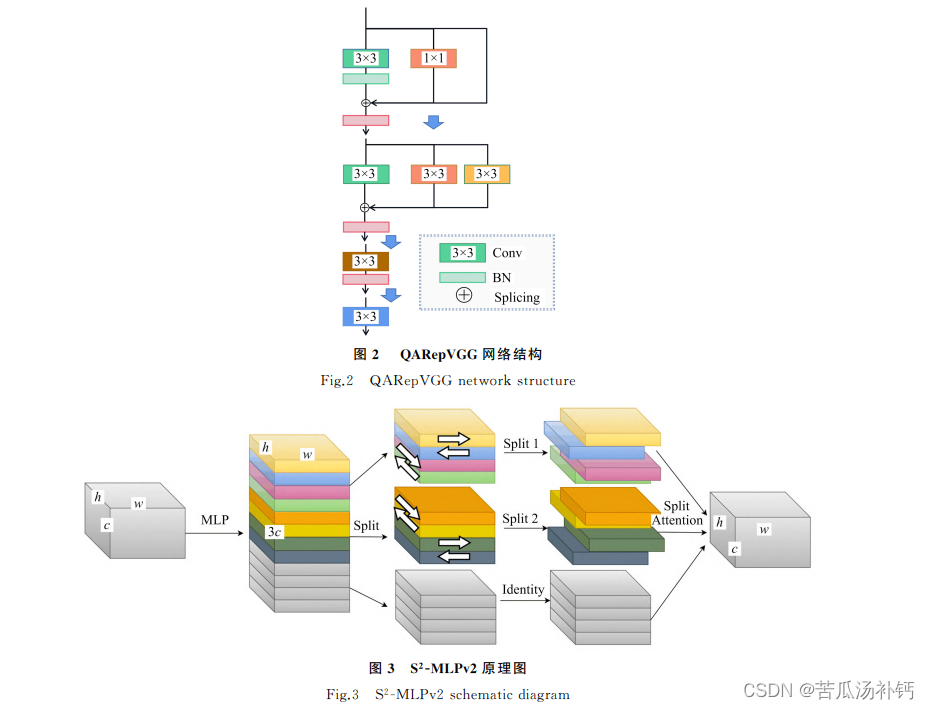

YOLOv5原始主干网络采用3×3的卷积模块,对非密集场景下的目标识别任务具有出色的能力,但在密集场景和被识别物有遮挡的情况下很难提取到有效特征信息,为此论文研究对传统的 RepVGG 结构进行修改,引入更加友好的量化感知模块 QARepNeXt。

为使网络具有更好的量化性能,引用一种在 RepVGG 的基础上改进的网络结构 QARepVGG(Quantization-AwareRepVGG),不会在训练过程中遭受量化崩溃,与 RepVGG 结构相比其量化性能得到很大程度的提升。

为提高特征信息的利用率,研究引入 S2-MLPv2注意力机制模块。

在对画面中的目标进行检测时,由于视野内可能存在多个目标,算法会生成多个预测框。为了消除冗 余的预测框,通常需要采用非极大值抑制(Non-MaximumSuppression,NMS)方法。NMS算法会根据预 测框的置信度和重叠度进行筛选,保留置信度最高的预测框,并去除与其重叠度高的其他预测框,从而得 到最终的检测结果。这样可以有效地去除冗余的预测框,提高检测的准确性和效率。

小结

针对密集动态目标检测精度低及易漏检的问题,本研究提出了一种基于 YOLOv5s 网络改进的算法模型。改进的算法模型在以下几个方面进行了优化:

1. 主干网络优化:引入了量化性能更佳的 QARepNeXt 结构。QARepNeXt 结构通过优化网络量化性能,提高了特征提取能力。相比原始 YOLOv5s 网络模型,这种改进能够更有效地捕捉并表征图像中的重要特征。

2. 特征融合阶段改进:在特征融合阶段加入了 S2-MLPv2 注意力机制。S2-MLPv2 通过增强特征信息的利用率,提高了网络对遮挡目标的关注度。这使得网络在处理密集和动态目标时,能够更准确地进行检测,减少漏检现象。

3. 损失函数替换:原有网络的损失函数被替换为回归性能更优秀的 Wise-IoU 损失函数。Wise-IoU 损失函数能够更好地衡量预测框与真实框之间的重叠情况,提高检测精度和回收率。

4. 实验验证:在公开数据集上进行了一系列实验。实验结果表明,优化后的算法在测量精确度、回收率和平均精度等方面都有显著提升。相较于原始 YOLOv5s 网络,改进模型表现出了更强的鲁棒性和泛化能力。

综上所述,通过在主干网络、特征融合和损失函数等方面的改进,优化后的 YOLOv5s 算法模型有效提升了密集动态目标检测的精度和可靠性,适用于密集动态目标检测及其相关领域。