热门标签

热门文章

- 1GitHub Actions 定时运行代码:每天定时百度链接推送

- 2Vue3+cesium添加自定义弹窗并设置随地图移动位置移动_cesium overlay

- 3PyTorch基础之激活函数模块中Sigmoid、Tanh、ReLU、LeakyReLU函数讲解(附源码)_tanh函数

- 4keras 视觉 captcha_ocr 案例分析_keras验证码识别

- 5python列表中的range用法_python range

- 6微服务架构的两大解耦利器与最佳实践_题目主数据、权限、文件、网关几个服务,每个服务之间解藕

- 7spring boot3参数校验基本用法

- 8PyTorch学习笔记(10)——上采样和PixelShuffle_上采样pixelshuffle

- 9微信小程序--自定义slider组件_小程序自定义组件 slider

- 10【区块链】智能交易模式下的数据安全流通模型

当前位置: article > 正文

构建能够使用 CPU 运行的 MetaAI LLaMA2 中文大模型_ggml和langchain在cpu上运行量化的llama2

作者:Gausst松鼠会 | 2024-02-19 23:40:56

赞

踩

ggml和langchain在cpu上运行量化的llama2

本篇文章聊聊如何使用 GGML 机器学习张量库,构建让我们能够使用 CPU 来运行 Meta 新推出的 LLaMA2 大模型。

写在前面

GGML 是前几个月 llama.cpp 和 whisper.cpp 项目背后的关键支撑技术,使用 C 语言编写,没有任何三方依赖的高性能计算库。

这个开源项目集成了模型量化方案,能够自动针对不同的平台进行优化,目前支持几十种不同的大模型项目。

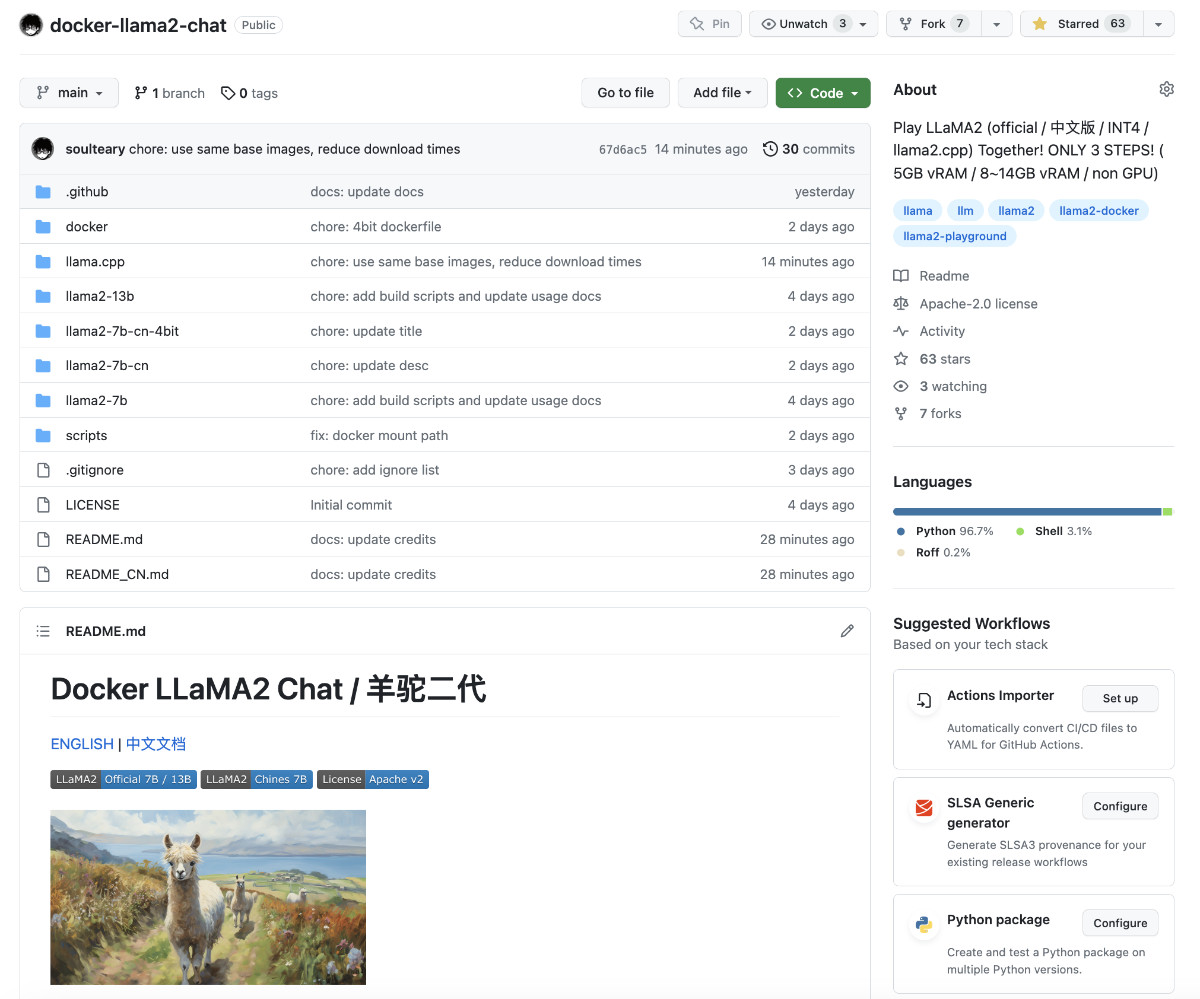

本文相关的内容,已经更新到了开源项目 soulteary/docker-llama2-chat 中,欢迎一键三连,支持项目继续更新。

相关的模型也已经上传到了 HuggingFace,感兴趣的同学自取吧。

当然,如果你还是喜欢在 GPU 环境下运行,可以参考这几天分享的关于 LLaMA2 模型相关的文章。

接下来,我们和以往一样,进行准备工作。

准备工作,以及重要的模型下载部分操作,可以参考《使用 Docker 快速上手中文版 LLaMA2 开源大模型》或《使用 Docker 快速上手官方版 LLaMA2 开源大模型》文章中的部分,完成准备工作和模型下载工作。

文章里所有的方法,我们都可以参考并在非 Docker 容器中使用。 如果你也想偷懒一些,只要你安装好 Docker 环境,配置好能够在 Docker 容器中调用显卡的基础环境,就可以进行下一步啦,如果你还不清楚如何操作,仔细阅读前两篇文章中的准备工作即可。

本文使用的 LLaMA2 中文模型,基于 LinkSoul 团队出品的LinkSoul/Chinese-Llama-2-7b,感谢他们为中文开源模型做出的贡献

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/117340

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。