热门标签

热门文章

- 1Android与Java NIO实现简单Echo服务器与客户端_用 nio技术替代一客户一线程技术改写 echo 项目的客户机/服务器设计。

- 2python中IndentationError_去把对应的tab,都改为空格,统一一下对齐的风格,即可

- 3Android T 远程动画显示流程其三——桌面侧动画启动流程(更新中)

- 4常见的7种排序算法

- 5LRU (最近最少使用页面置换算法) 的代码实现_lru代码

- 6如何修改并获得dubbo服务的端口号_idea dubbo端口号配置

- 7最详细并且直观理解Python中的可变数据类型和不可变数据类型_python中什么是可变数据类型?什么是不可变数据类型?

- 8Linux学习笔记 30(配置本地yum源)_fedora30 配置本地yum

- 9用纯HTML5制作网站_html5网页制作

- 10Android和Linux的开发差异

当前位置: article > 正文

3D目标检测论文方法汇总 【2022部分持续更新中~_lift: learning 4d lidar image fusion transformer f

作者:Gausst松鼠会 | 2024-02-22 23:17:11

赞

踩

lift: learning 4d lidar image fusion transformer for 3d object detection

Automanous-3D-detection-methods

版权注释

该项目地址为:https://github.com/LittleYuanzi/awesome-Automanous-3D-detection-methods

2017~2020汇总部分由CSDN博主Little_sky_jty博主倾力攥写,2021部分我将对其进行维护更新为我个人所用,无任何商业目的,如有侵权,告知删除

前言

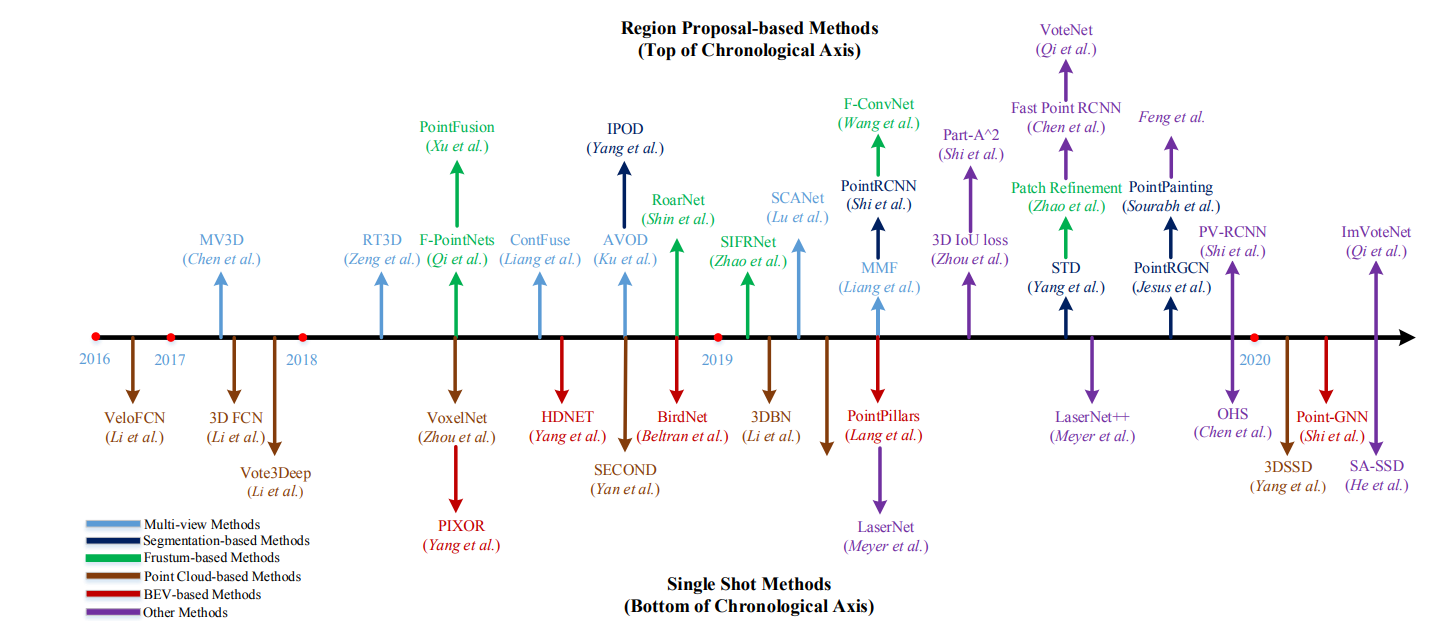

该项目主要在对近期(17年)开始的自动驾驶场景的目标检测方法做一个汇总,持续更新,也欢迎大家参与进来。为了方便表示,该项目仅仅针对自动驾驶场景,分类方法按照输入进行划分,特别地,我们也对论文实验对应的论文做出一定的标注。

keywords

inputs

按照传感器的输入: monocular: 单目 stereo: 双目 lidar: 点云 RGB-D: 深度图

如果是多种传感器融合: image+lidar: 图像+点云

对应实验数据集

用于标注该文章实验对应的数据集: kitti: KITTI nuse: NuScence waymo: Waymo ATG4D: ATG4D [lyft]: lyft [ScanNet]: ScanNet [SUN RGB-D]: SUN RGB-D [SceneNN]: SceneNN

代码

标注代码实现框架: Tensorflow: TensorFlow PyTorch: PyTorch

2017

- [CVPR] PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation. [tensorflow][pytorch] [

lidar]声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/131901

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。