热门标签

热门文章

- 1vue3+vite+axios:解决跨域问题_vue3.0 vite跨域代理axios无法替换主路径

- 2“深入探讨Java中的对象拷贝:浅拷贝与深拷贝的差异与应用“_深拷贝和浅拷贝的应用场景 java

- 3同步gitee和github_github page无法同步gitee page

- 4顺序主子式

- 5使用eve-ng模拟器进入山石防火墙的web界面_eve默认账号密码

- 6【数据结构】二叉树(C语言)

- 7python封装前端接口_Python实现封装打包自己写的代码,被python import

- 8(4)jenkins配置gitee令牌详细操作_jenkins使用令牌连接gitee

- 9C++ Reference: Standard C++ Library reference: Containers: queue: queue: emplace_queue c++ referece

- 10Python 微信自动化工具开发系列04_所有微信群的群文件自动同步拷贝到群名对应的新文件夹中(2024年2月可用 支持3.9最新微信)_wxauto

当前位置: article > 正文

本地部署Ollama大模型框架可以运行本地大模型_ollama下载太慢

作者:Guff_9hys | 2024-06-25 03:46:38

赞

踩

ollama下载太慢

本地部署Ollama

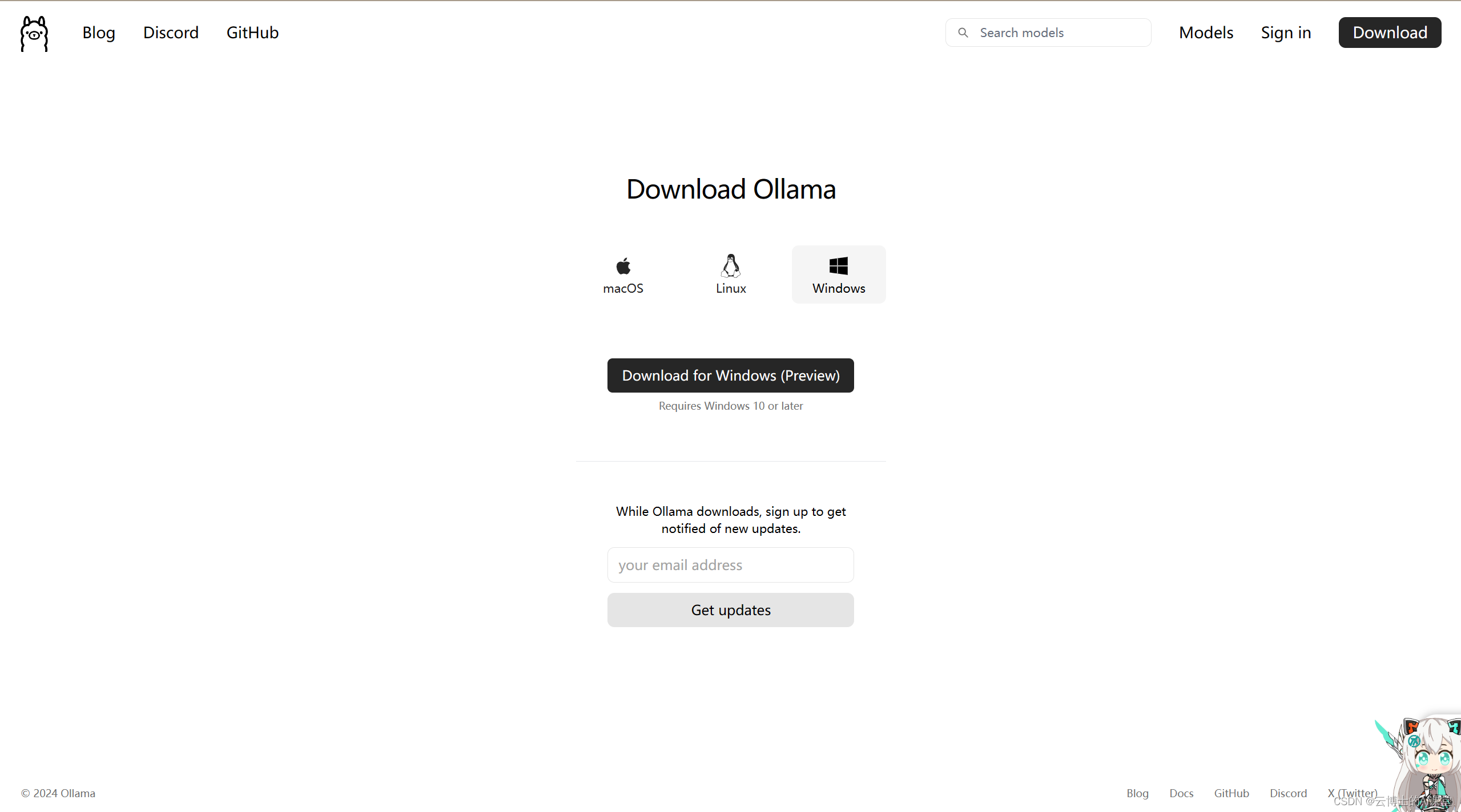

- Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型。软件地址:Download Ollama on Windows。

- 本地部署:

- 打开上述安装网址,选择windows,点击download for windows(preview)安装

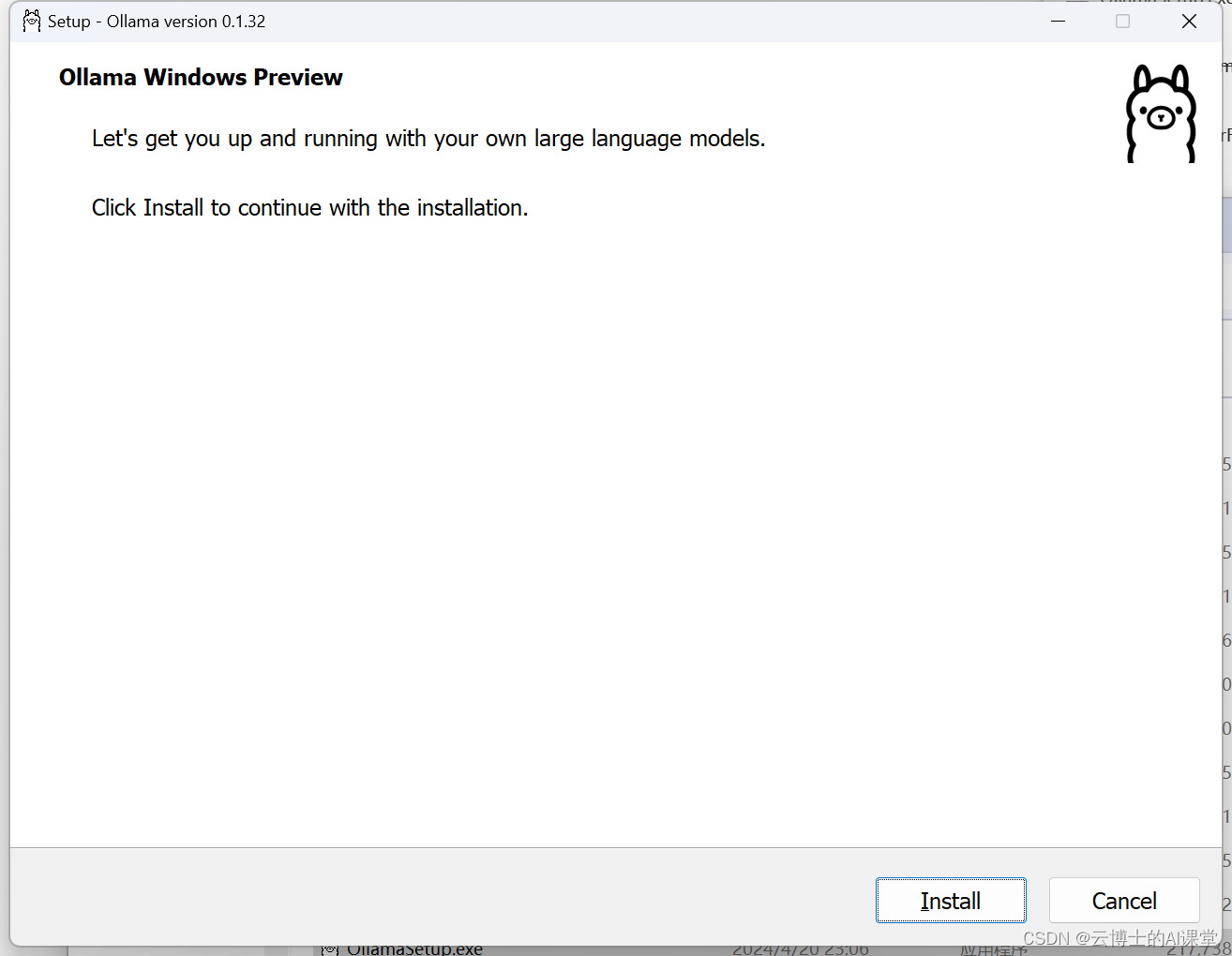

- 下载完成后双击进行安装,按提示安装即可,无需额外操作。

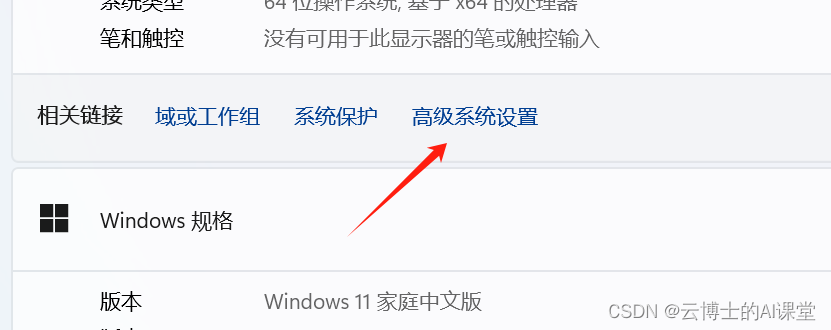

- 修改环境变量(默认模型下载至C盘)右键此电脑选择属性->高级系统设置->环境变量->用户变量->新建

设置完成后重启电脑生效修改

- 使用Ollama

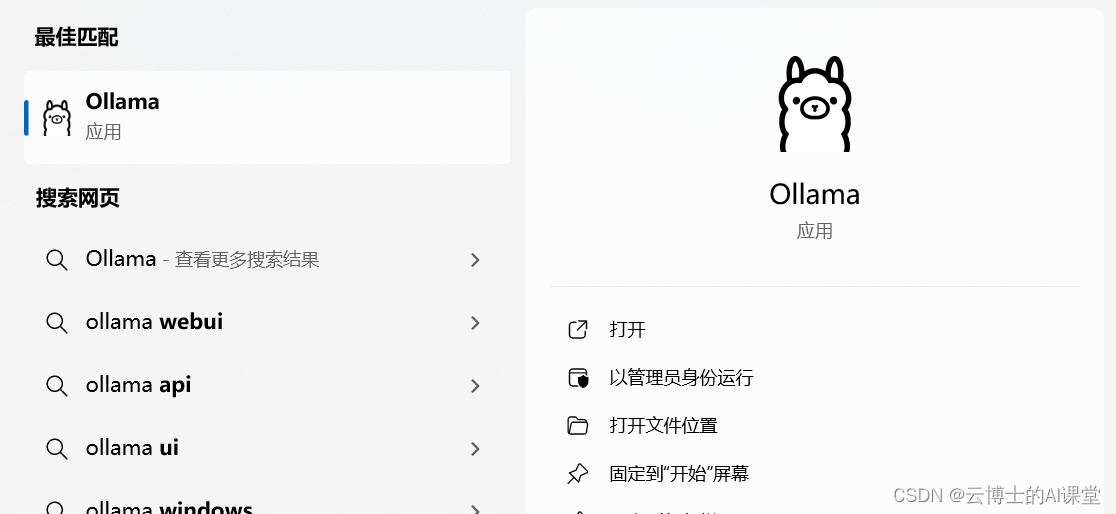

- 搜索栏搜索打开,确保Ollama在任务栏

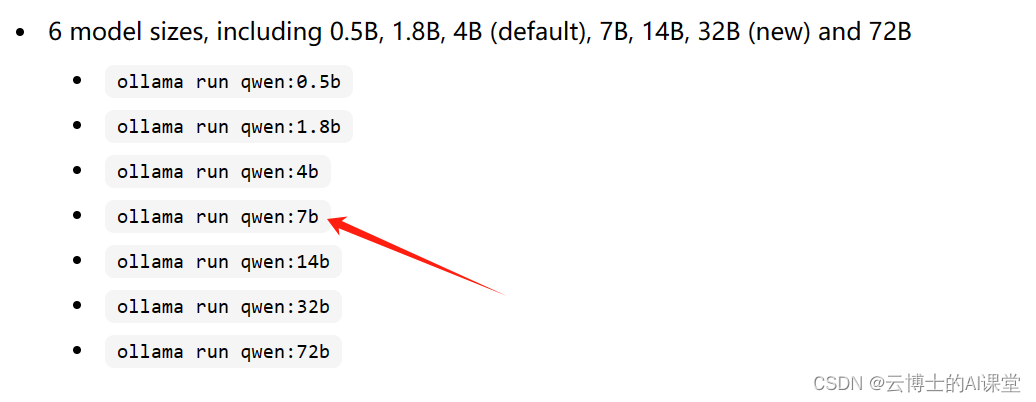

- 访问library (ollama.com),以 qwen-7b 为例,搜索qwen,选择运行 7b 的模型

- 打开cmd,将7b模型的下载命令键入并等待下载

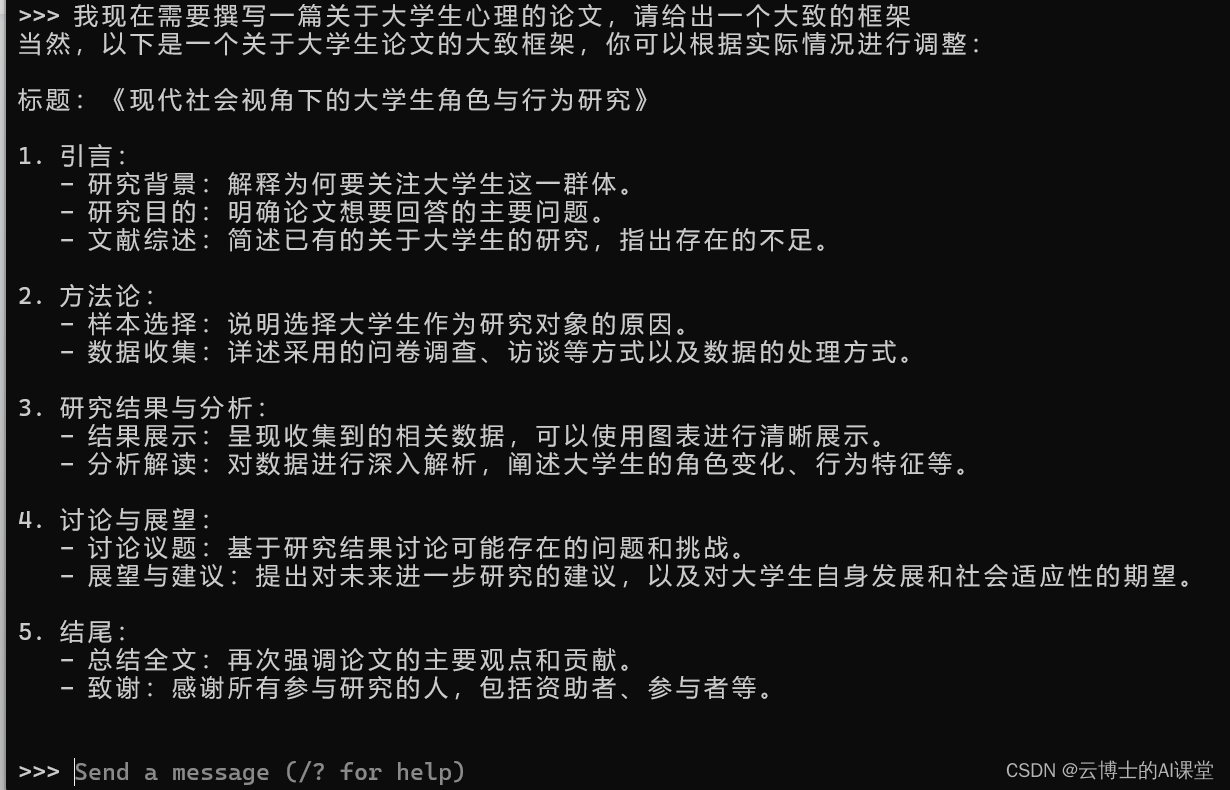

- 前95%下载速度快,99%到100%速度较慢。当出现 Send a nessage 即可开始模型的使用

- 使用,如图

- 再次使用

在cmd输入运行代码(如ollama run qwen:7b)即可免下载安装直接使用(该模型在之前已安装成功)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Guff_9hys/article/detail/754846

推荐阅读

相关标签