热门标签

热门文章

- 1解决:使用git提交代码到github时,git push总是报错的问题_git push 报错400

- 2Linux开发板(树莓派)和服务器进行双向通信(socket)_两块开发板如何双向通讯

- 3stable diffusion实践操作-重绘_stable diffusion 蒙版重绘 valueerror: coordinate 'righ

- 4FPGA模块使用Verilog调用另一个Verilog模块_verilog子模块调用

- 5基于word2vec lstm attention的英文数据情感分析 +数据预处理+ 分类+完整代码_英文数据需要word2vec

- 6参考文献的类型_csdn算什么类型的文献

- 7MeiliSearch-轻量级且美丽的搜索引擎_meilisearch 官网

- 8linux java 文件夹创建失败_Java在创建文件目录时在windows中成功,在Linux中失败的解决办法...

- 9安装时出现Requirement already satisfied问题_安装时报requierements satif

- 10【验证码逆向专栏】最新某验三代滑块逆向分析,干掉所有的 w 参数!_滑块验证码

当前位置: article > 正文

Ollama+Open WebUI本地部署Llama3 8b(附踩坑细节)

作者:爱喝兽奶帝天荒 | 2024-06-24 07:52:30

赞

踩

ollama

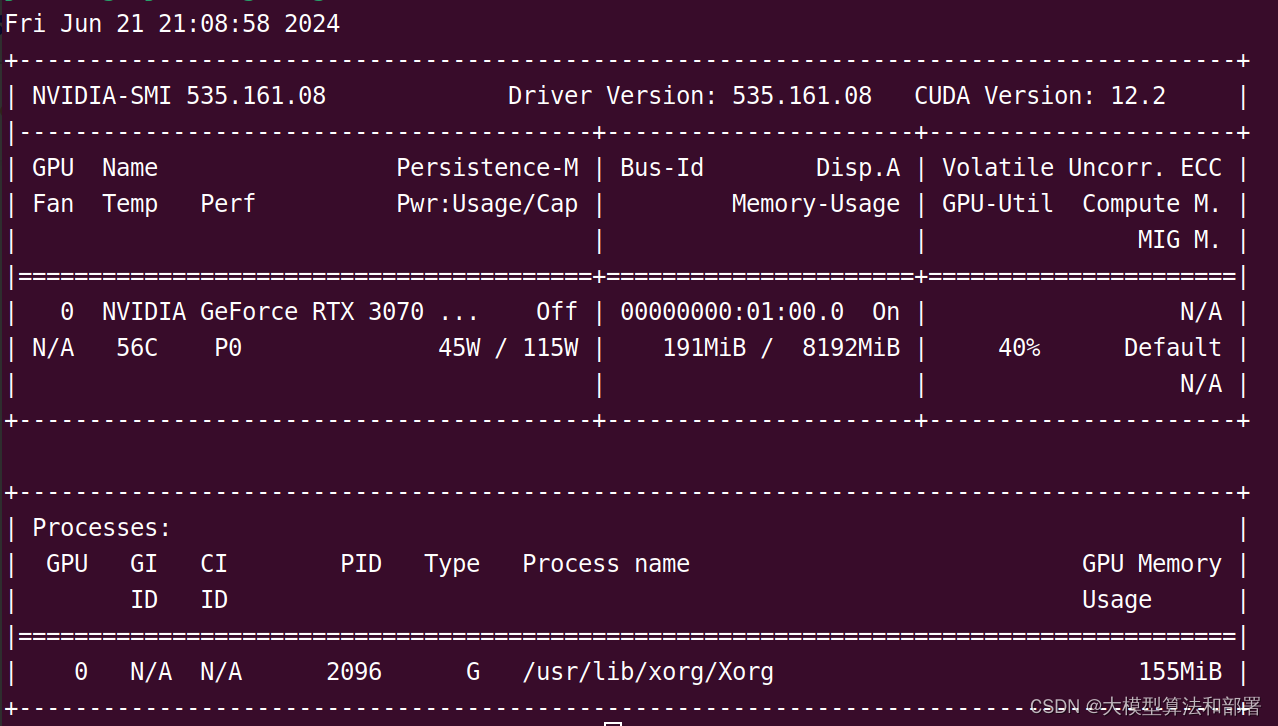

我的显卡参数:

最终结果展示,如下图所示:

1. 添加环境变量

在下载 ollama 之前,先去配置环境变量,确保模型下载到我们想要的地方

win10 和 win11 输入path或者环境变量:

增加系统环境变量

变量名不可更改,必须是OLLAMA_MODELS,变量值可以自定义,

2. 下载ollama

下载后得到安装包,如果不添加环境变量的话,默认会安装到C盘

3. 检验是否安装成功

输入ollama命令,正常的得出命令行输出,表示已经安装成功

4. 通过ollama下载模型

4.1. ollama 模型库

详见library (ollama.com),用于搜索已收录的模型库。以下是一些流行的模型:

4.2. 下载运行llama3 8b

ollama run llama3:8b # 运行llama3 8b大模型

直接使用 run 命令 + 模型名字就可以运行模型。如果之前没有下载过,那么会自动下载。下载完毕之后可以在终端中直接进行对话了。

5. 安装open-webui

open-webui 项目网址:GitCode - 全球开发者的开源社区,开源代码托管平台

open-webui 是一款可扩展的、功能丰富的用户友好型自托管 Web 界面,旨在完全离线运行。它支持包括 Ollama 和与 OpenAI 兼容的 API 在内的多种 LLM 运行器。想了解更多信息,可以查阅开放式WebUI文档。

5.1. docker 安装

open-webui 可以通过 docker 安装,也可以通过pip安装,pip安装较为简单,具体见安装文档:【wpsshop博客】

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。