热门标签

热门文章

- 1【Android】安装Android Studio遇到Unable to access Android SDK add-on list的错误导致无法选择SDK_andorid studio unable to access android sdk add-on

- 2基于SpringBoot+Vue+ElementUI+Mybatis前后端分离管理系统超详细教程(三)

- 3AWS Lambda结合Android应用的初次尝试_aws toolkit android studio lambda java aws

- 4石头剪刀布python代码_Python剪刀石头布编程思路

- 5pycharm连接数据库显示could not to creat conection to database server_python jedi client: couldn't create connection to

- 6【kotlin】在SpringBoot项目中使用kotlin协程coroutine实现方法的异步延迟调用,例如延迟查询短信发送详情结果。

- 7【Minecraft】在Linux上架设我的世界Minecraft服务器(保姆级教程)_linux搭建mc服务器

- 8Ubuntu+Stm32cubeMX+vscode+stlink开发_linux stm32cubeide 链接stlink

- 9连接过来的设备的信息存放_/data/misc/dhcp/dnsmasq.leases

- 10VCL组件DevExpress VCL v21.1 - 全新的甘特图控件_devexpressvcl

当前位置: article > 正文

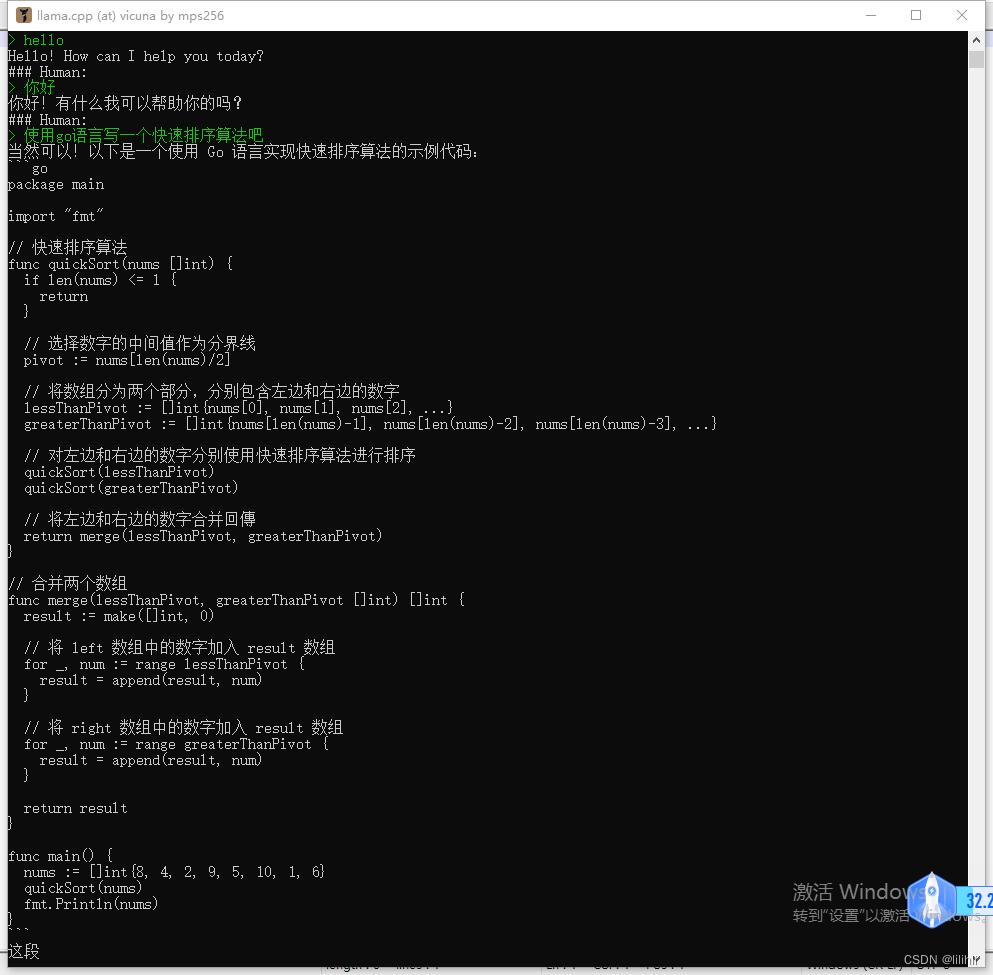

使用llama.cpp在本地搭建vicuna 13B语言模型_llama.cpp跑vicuna

作者:IT小白 | 2024-03-22 13:20:13

赞

踩

llama.cpp跑vicuna

有人做了windows下的脚本放到github上了,直接运行就可以了。我在本机试了一下13B的模型能运行,但生成速度非常慢,回复一个问题基本上要花5分钟以上的时间。我的机器配置 3900X 32G内存。

https://github.com/mps256/vicuna.ps1

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签