热门标签

热门文章

- 1git的常用语句_git语句大全

- 2【蓝桥杯】Python自带编辑器IDLE的使用教程_python蓝桥杯编译器

- 3BERT、BART、T5 等LLM大语言模型的比较分析_bart模型和t5

- 48种方案,保证缓存和数据库的最终一致性_缓存和数据库一致性同步解决方案

- 5【Transformer】什么是transformer? transformer输入输出是什么。transformer用于GPT的方法。tranformer的代码。chat-gpt_transformer编码器和解码器两个部分都包含输入该怎么理解呢

- 6RK3588 MIPIRX接收RGB888/RGB565/RGB666调试_rk3588 mipi dcphy dts

- 7C#调用Python程序的两种方法_c# python 相互调用

- 8谈谈程序员在传统企业的转型升级之路_传统公司程序员

- 9VMware vSphere 服务器虚拟化之二十七 桌面虚拟化之View中使用Thinapp软件虚拟化_thinapp的license

- 10【解决】Invalid hash given_fatal: invalid hash

当前位置: article > 正文

本地部署 Ollama_ollama本地部署

作者:IT小白 | 2024-04-27 19:41:41

赞

踩

ollama本地部署

0. Ollama 能帮我们做什么

在本地启动并运行大型语言模型。

运行 Llama 2、Code Llama 和其他模型。自定义并创建自己的。

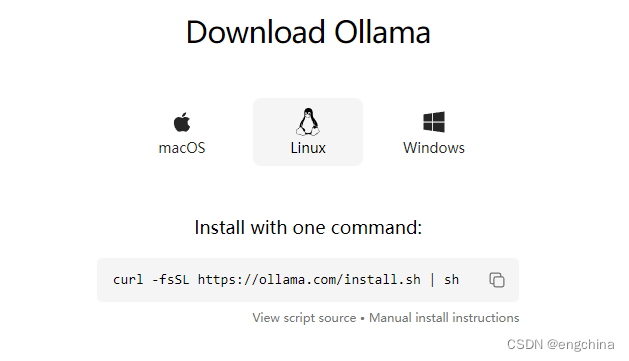

1. 下载 Ollama

访问 https://ollama.ai/download,根据你使用的系统,下载相应版本。

这里以 Linux 为例。(20240216时点,已经支持 Windows)

2. 安装 Ollama

curl https://ollama.ai/install.sh | sh

- 1

3. 使用 Ollama

访问 https://ollama.ai/library,检索你想使用的模型,然后执行下面命令运行,以 llama2 为例

ollama run llama2

- 1

4. Ollama 和 Langchain 的集成

后续有需要时,在补充详细说明。

参考地址:

完结!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/498370

推荐阅读

相关标签