- 1oracle做拉链,Datastage实现拉链算法

- 2ShardingSphere读写分离

- 3地理信息系统教程(汤国安)——重点总结_双重独立编码结构

- 4NLP发展简史_nlp的发展阶段

- 5通用与垂直,谁将领跑未来?

- 6 推荐一款高效智能的校园考勤系统:Sistem Absensi Sekolah Berbasis QR Code

- 7python3.7+dlib+face_recognition+tensorflow+keras+scipy+numpy版本(已实现)_scipy对应cpu版本

- 8ARM 上的C语言开发_arm的c语言

- 9【软件工程】——开发模型_软件三大开发方法表格对比

- 10学习笔记Label自右向左滚动和父容器内左右移动方法(含代码)_lvgl文本从右到左滚动

AI | LLaMA-Factory 一个好用的微调工具_llama-factory微调模型windows

赞

踩

‘’

LLama Factory,这个工具能够高效且低成本地支持对 100 多个模型进行微调。LLama Factory 简化了模型微调的过程,并且易于访问,使用体验友好。此外,它还提供了由 Hiyouga 提供的 Hugging Face 空间,可用于对模型进行微调。

下载LLaMA-Factory

-

- #下载LLaMA-Factory

- git clone https://github.com/hiyouga/LLaMA-Factory.git

- #创建一个环境

- conda create -n llama_factory python=3.10

- #切换到llama_factory环境

- conda activate llama_factory

- #进入到LLaMA-Factory目录下

- cd LLaMA-Factory

- #下载LLaMA-Factory所需要的包

- pip install -r requirements.txt

-

-

开始

启动页面:

python src\train_web.py进入可视化页面:

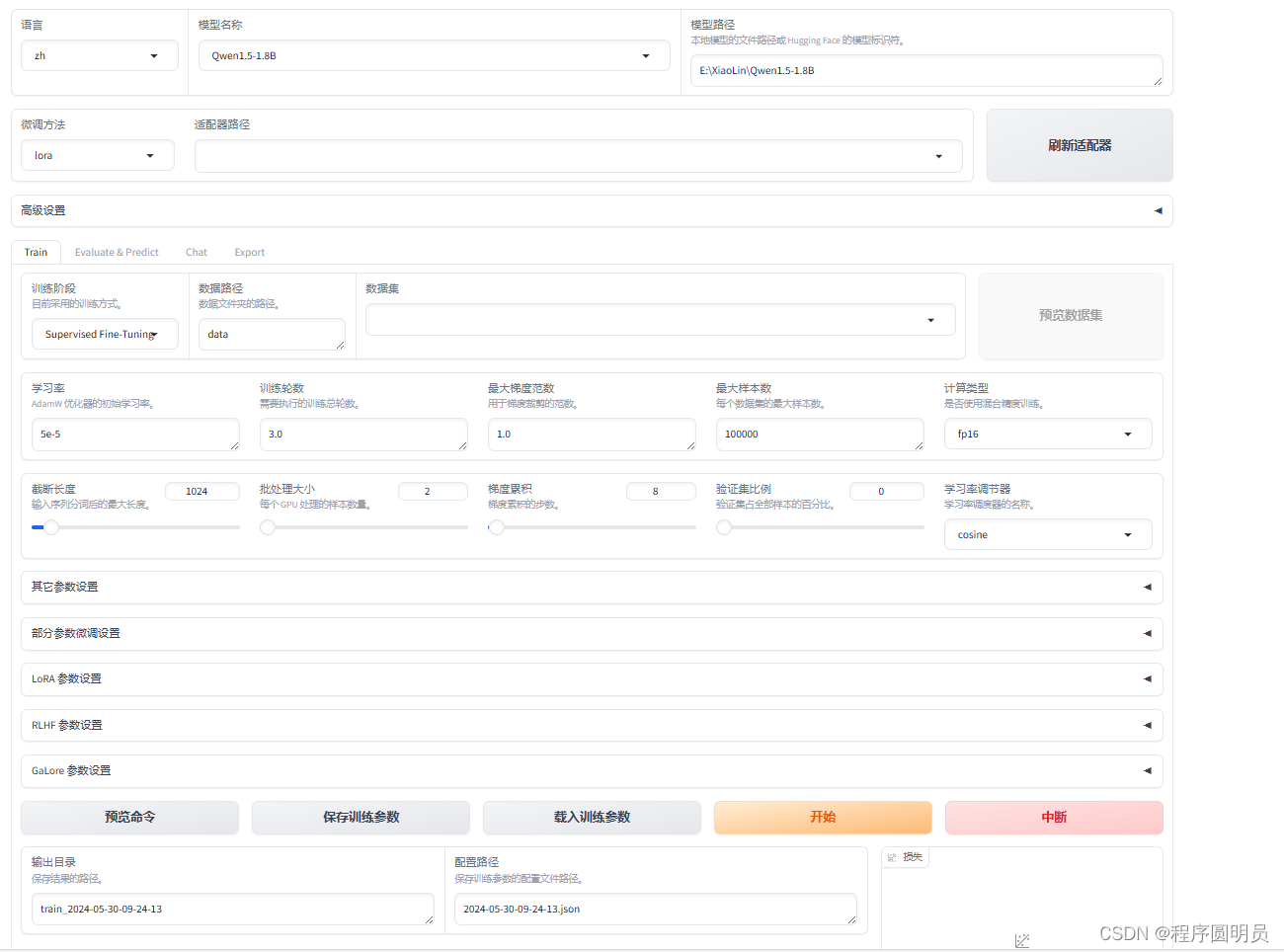

支持 Lora 和 GaLore 配置,以减少 GPU 的使用。用户可以通过简单的滑块轻松更改参数,如 dropout、epochs、批次大小等。同时,也有多个数据集选项可供选择以微调你的模型。正如本文所述,LLama Factory支持许多模型,包括不同版本的 LLama、mistral 和 Falcon。它还支持像 galore、badm 和 Lora 这样的高级算法,提供诸如flash attention、位置编码和缩放等各种功能。

此外,你还可以集成像 TensorBoard、VanDB 和 MLflow 这样的监控工具。为了更快地进行推理,你还可以使用Gradio 和 CLI。本质上,LLama Factory 提供了一系列多样化的选项,以增强模型性能并简化微调过程。

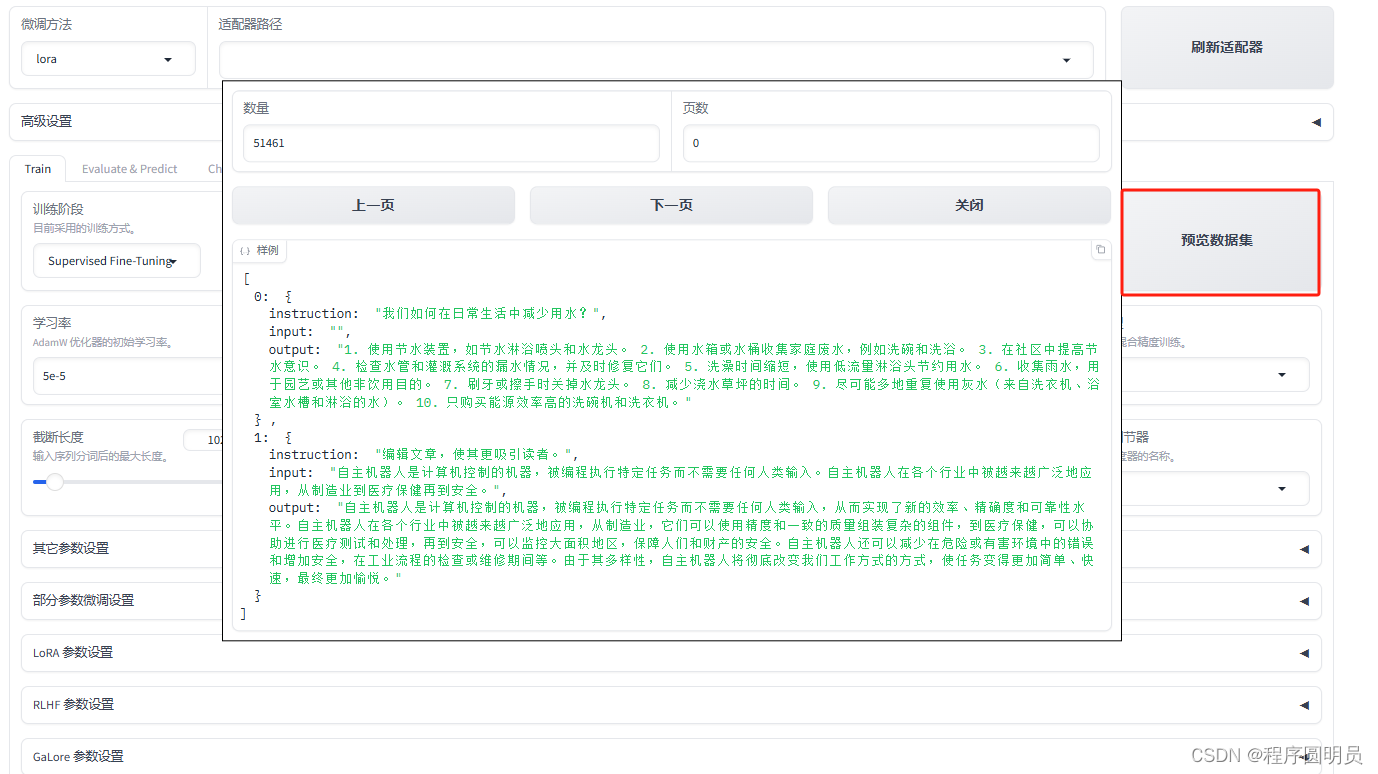

LLaMA-Factory有自带的数据集也可以自己生成数据集然后导入:

自制微调数据集代码下载地址:

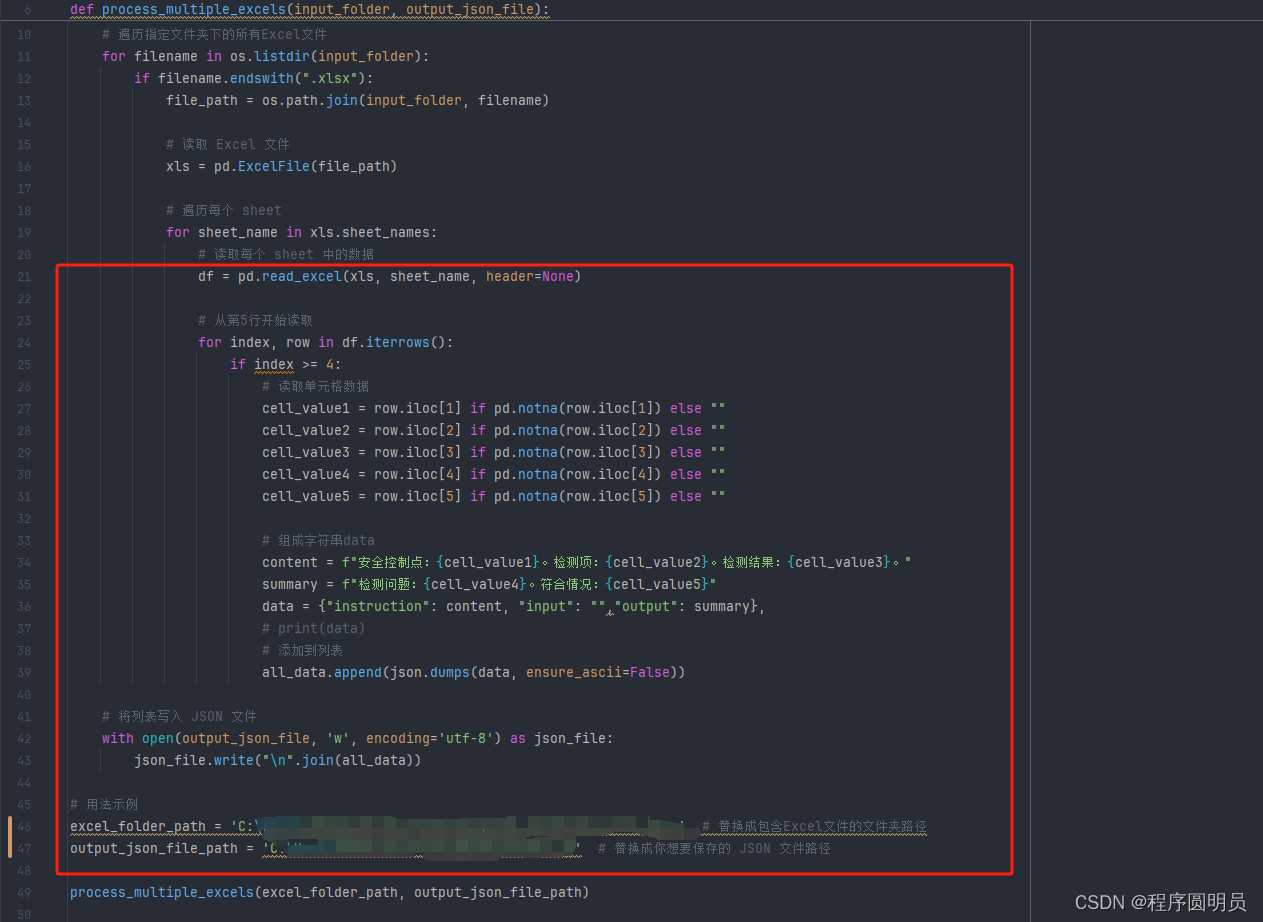

https://github.com/KevinFanng/makeChatGLM3FinetuneData/blob/main/finetunningData_for_qwen_piliang.py自制微调数据集代码读取Excel示例:

https://github.com/KevinFanng/makeChatGLM3FinetuneData/blob/main/%E5%8E%9F%E5%A7%8B%E6%95%B0%E6%8D%AE%E6%A0%BC%E5%BC%8F.xlsx自制微调数据集代码关键注释:

预览命令:

开始微调,点击开始:

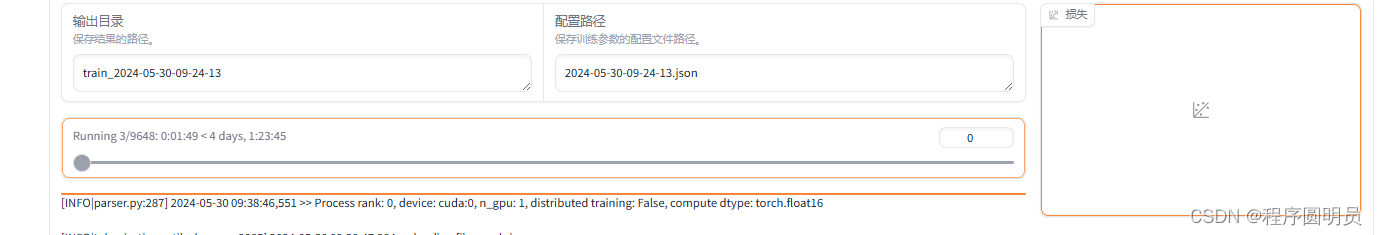

微调所需要的时间百分比:

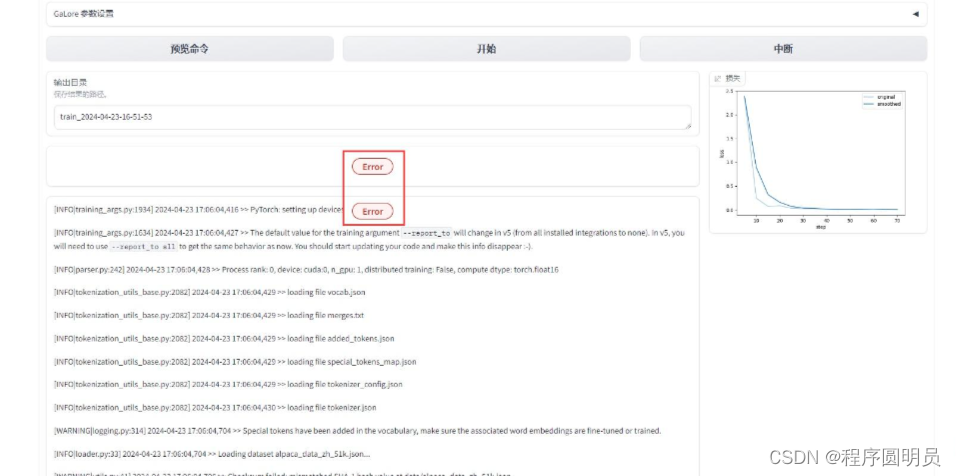

报错:

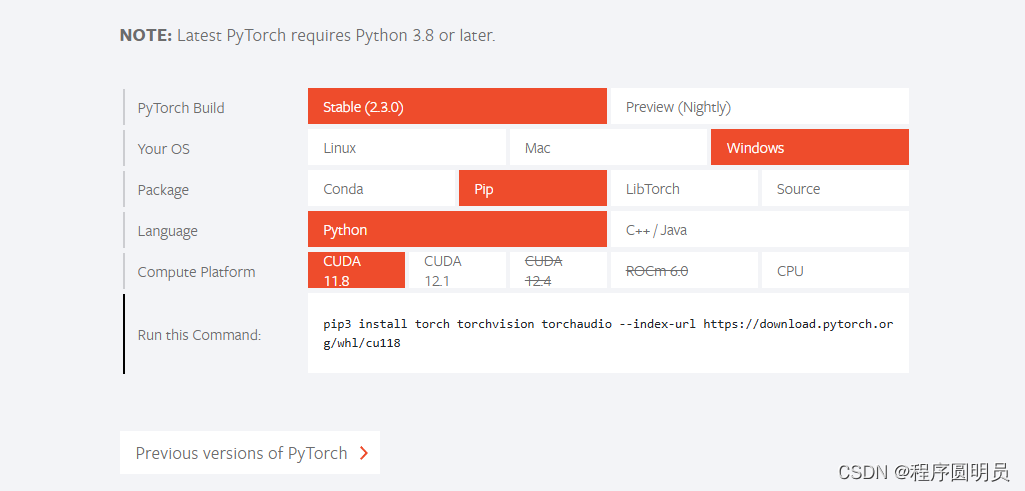

我当时跑的期间也会有报错,但是只要跟着教程走,就不会错,当时我的报错是关于torch版本的问题,原因是没有下载对应cuda的torch, 我当时候的解决方案是去torch官网下载对应自己版本的cuda。

进入PyTorch官网:PyTorch(魔法)

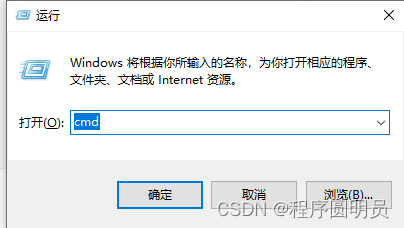

Windows+R打开cmd小黑框:

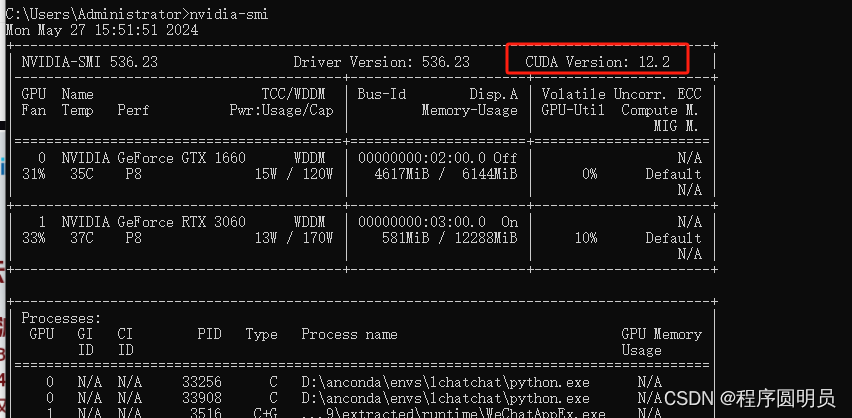

查看你的cuda版本:nvidia-smi

找到对应的cuda版本下载即可!

可视化界面偶尔可能也出现报错,我们重新刷新页面即可继续

结语

有效的微调已成为大型语言模型(LLMs)适应特定任务的必要条件之一。然而,这需要一定的努力,有时也相当具有挑战性。随着 Llama-Factory 的引入,这一全面的框架让训练更加高效,用户无需编写代码即可轻松为超过 100 个 LLMs 定制微调。

现在,很多人对大型语言模型(LLMs)更加好奇,有这样想法的开发者可以试试 Llama-Factory 是否可以调整自己的模型。这有助于开源社区的成长和活跃。Llama-Factory 正变得广为人知,甚至已被列入 Awesome Transformers3 中,作为高效微调 LLMs 的工具。

我们希望本文能鼓励更多开发者使用这一框架来创建有价值的 LLMs。不过请记得,在使用Llama-Factory微调LLMs时,遵守模型的许可规则很重要。

至此,本文结束。我们看到了如今在几分钟内微调任何模型是多么容易。我们还可以使用 Hugging Face CLI 将这个模型推送到 Hugging Face Hub 上。