热门标签

热门文章

- 1使用verilog实现流水灯

- 2paramiko使用秘钥连接_window下paramiko使用密钥连接服务器

- 3AIGC 图片 & 视频创作设计大赛来袭,丰厚奖金等你拿!

- 4推荐开源项目:Rustcat —— 现代化的端口监听器与反向Shell

- 5Unity3d中使用自带动画系统制作下雨效果_unity3d 雨天特效

- 6FANUC机器人附加轴的参数设置和启动步骤_fanuc外部附加轴配置实例

- 7微信小程序开发入门与实战 ⑩⑥(纯数据字段及组件生命周期)_微信小程序lifetimes

- 8Android之RadioButton_android radiobutton控件

- 9FPGA交通信号灯设计报告(VHDL语言)_quartus ii fpga仿真

- 10五一 Llama 3 超级课堂 | LMDeploy 高效部署 Llama3 实践笔记_llama3加速框架deplo

当前位置: article > 正文

教程:利用LLaMA_Factory微调llama3:8b大模型_llama3模型微调保存

作者:Monodyee | 2024-05-21 19:03:51

赞

踩

llama3模型微调保存

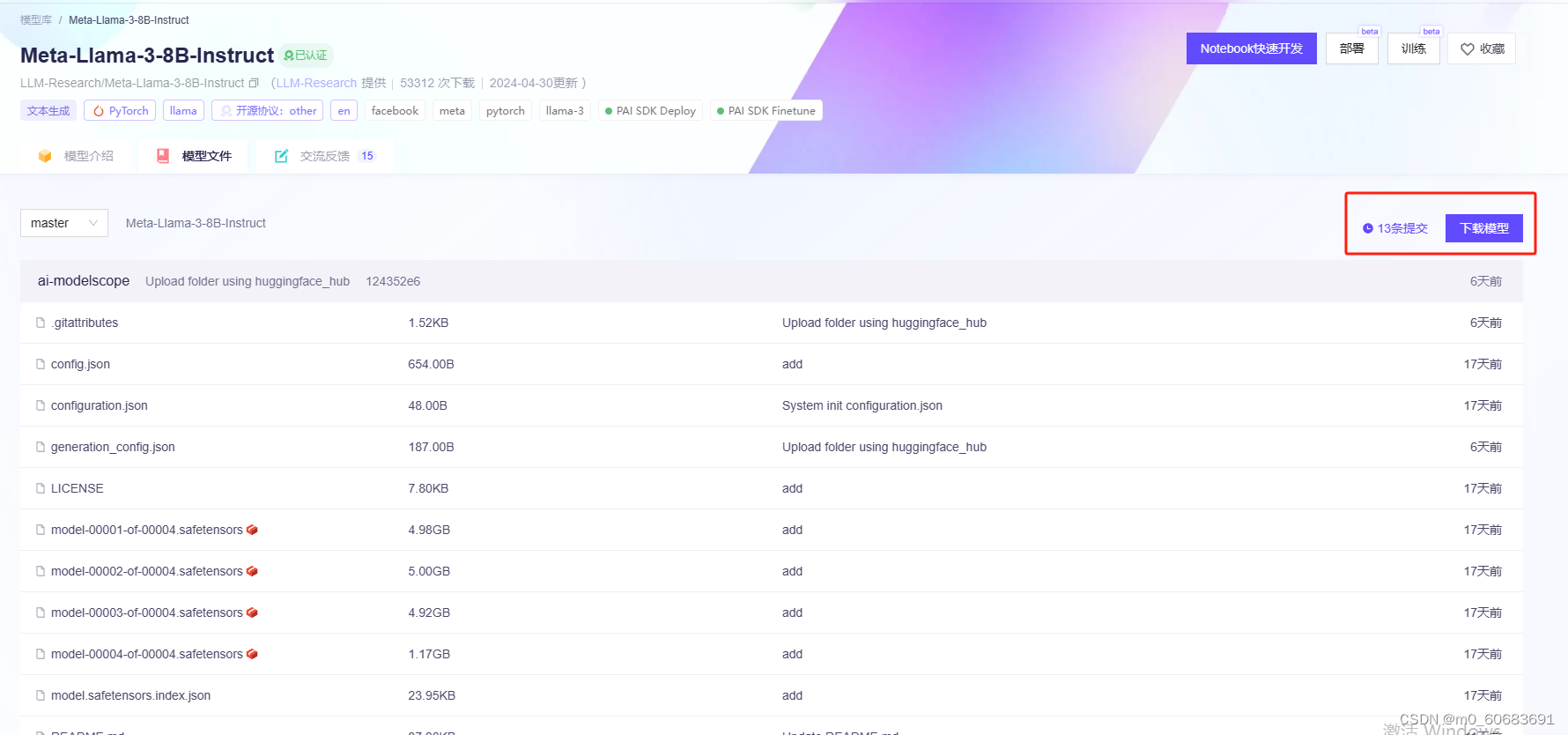

一、安装llama模型文件

下载地址(魔塔):https://modelscope.cn/models/LLM-Research/Meta-Llama-3-8B-Instruct/files

点击下载模型,复制git命令:

git clone https://www.modelscope.cn/LLM-Research/Meta-Llama-3-8B-Instruct.git

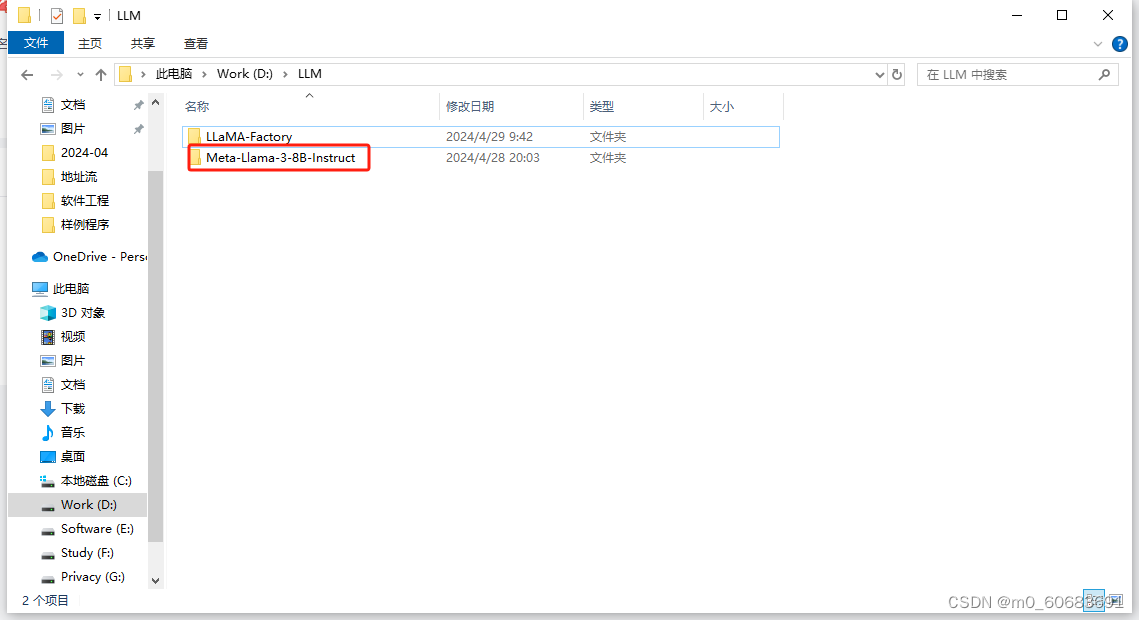

在存放模型空白处右键,点击git bash here,下载llama3模型至本地

由于文件较大,因此该过程比较久,保持下载窗口打开,知道出现下一命令行表示下载完成。

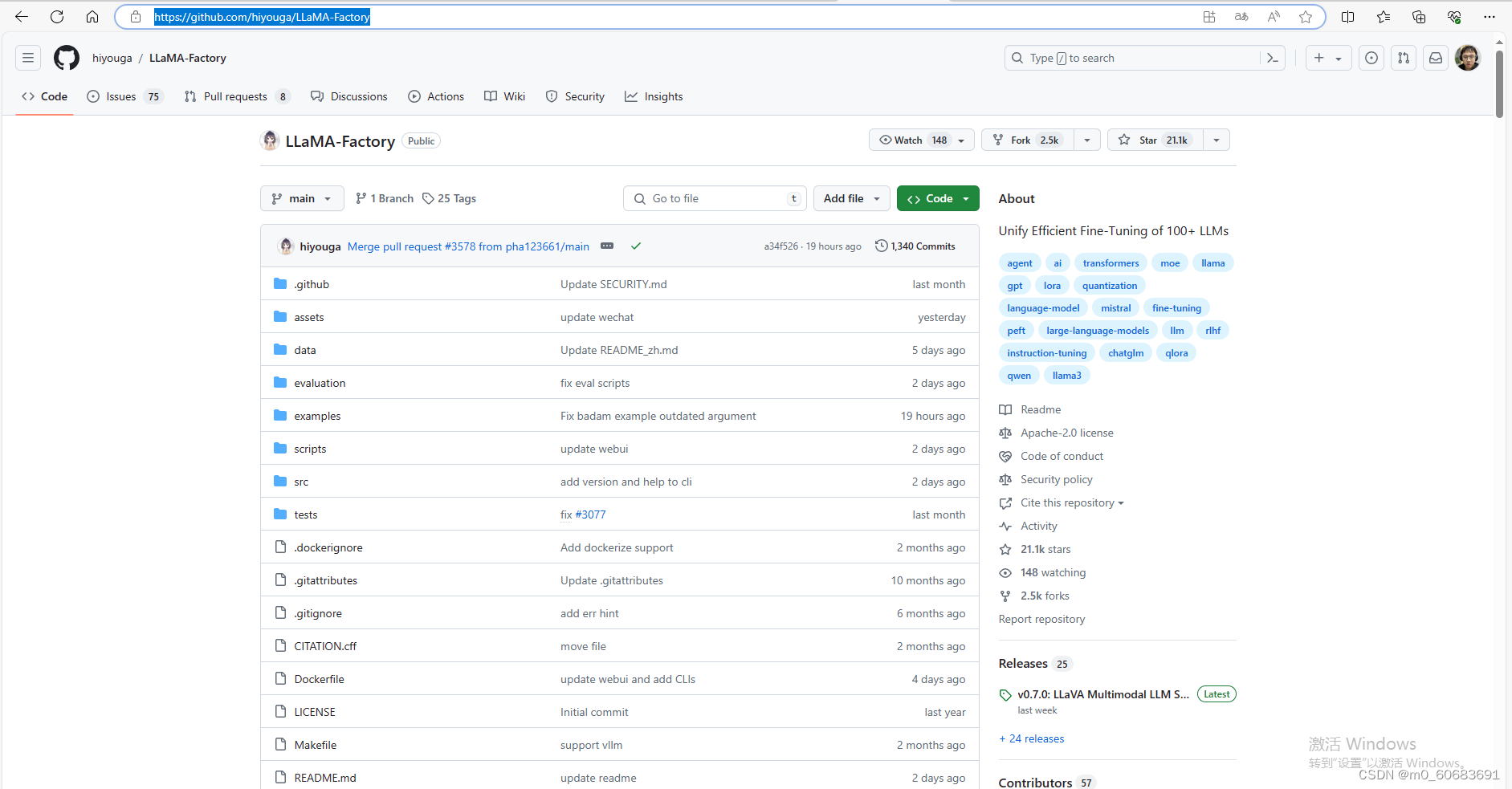

二、安装LLaMA-Factory

github:hiyouga/LLaMA-Factory: Unify Efficient Fine-Tuning of 100+ LLMs (github.com)

将其下载到本地

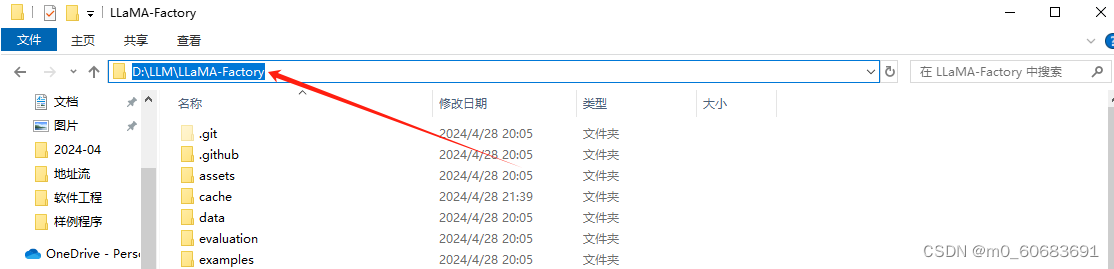

三、为LLaMA-Factory配置环境

进入LLaMA-Factory目录,在路径处输入cmd并回车进入该目录位置的终端

新建虚拟环境

conda create -n llama_factory python=3.10 -y激活虚拟环境

conda activate llama_factory安装依赖

pip install -e .[metrics,modelscope,qwen]pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121pip install https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl安装tensorboard

pip install tensorboard设置环境变量

Set USE MODELSCOPE HUB=1四、运行LLaMA-Factory的train_web.py

执行代码

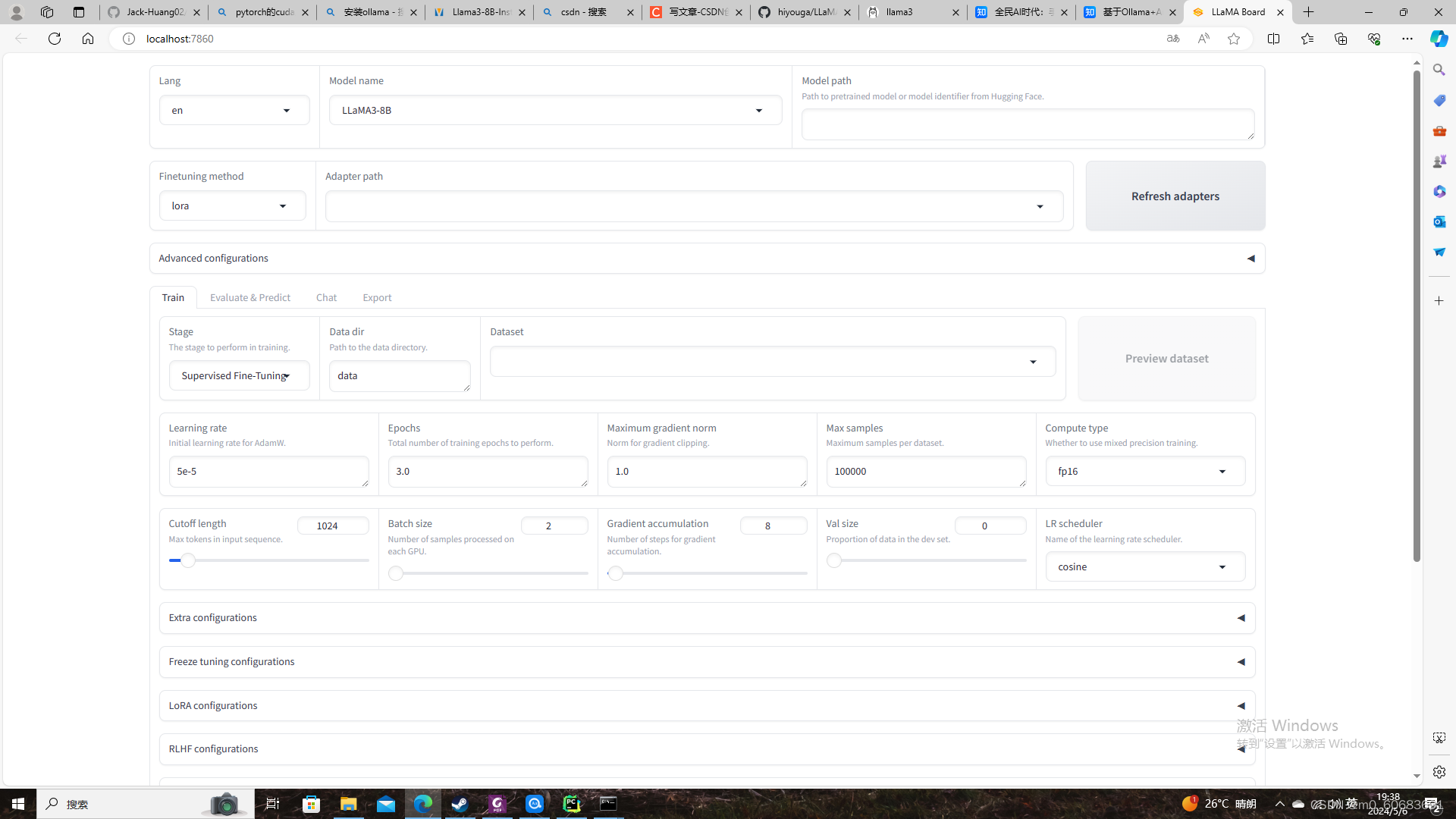

python src/train_web.py若顺利,会打开如下网页(初始界面)

五、微调模型

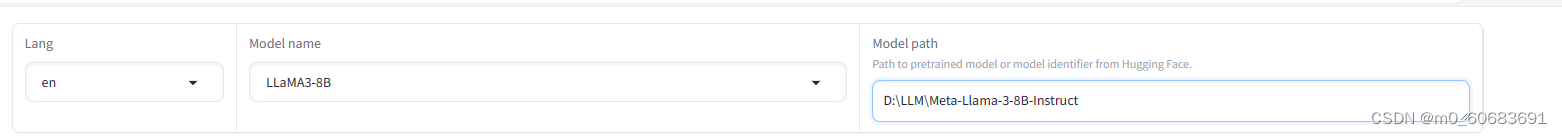

在“Model name”中选择“LLaMA3-8B”,将“Model path”中的路径填写Meta-Llama-3-8B-Instruct文件夹的路径

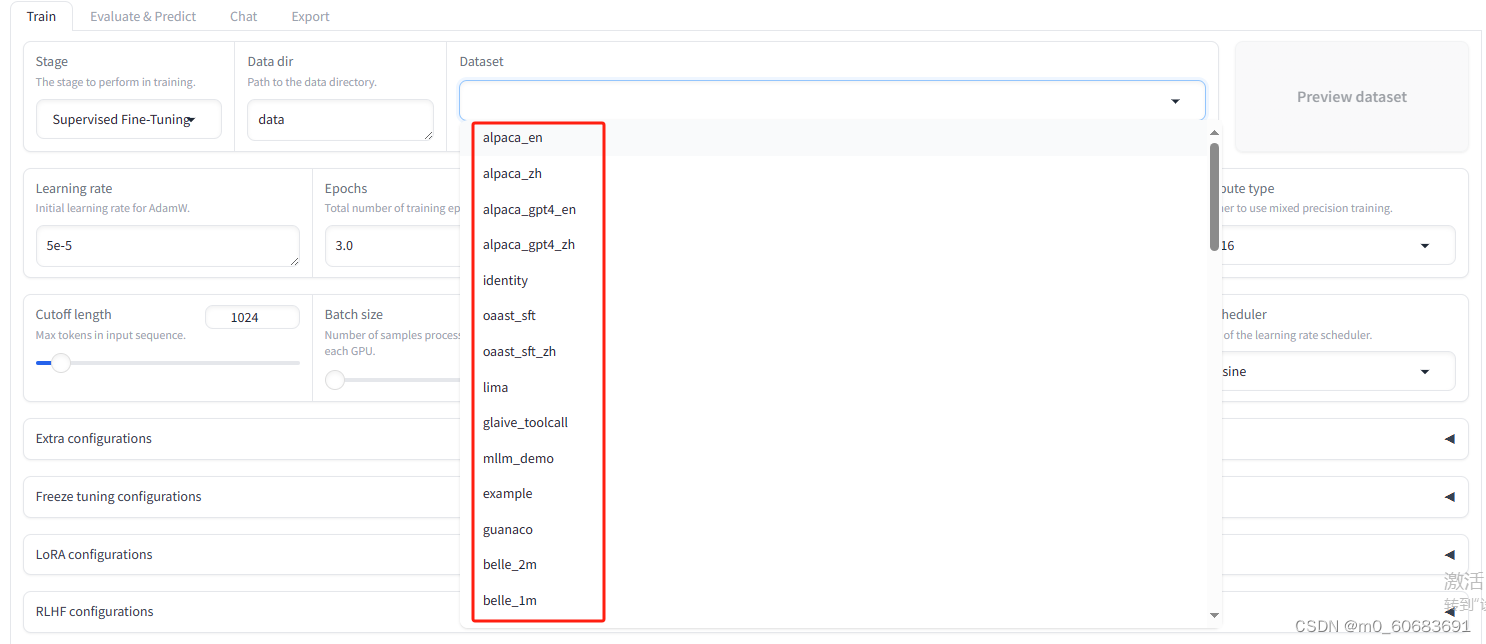

在dataset中即可选择预先准备好的数据集进行微调

以微调为中文模型举例,则在下拉选项中选择后缀为zh的数据集

点击“Start”开始微调。

六、导出模型

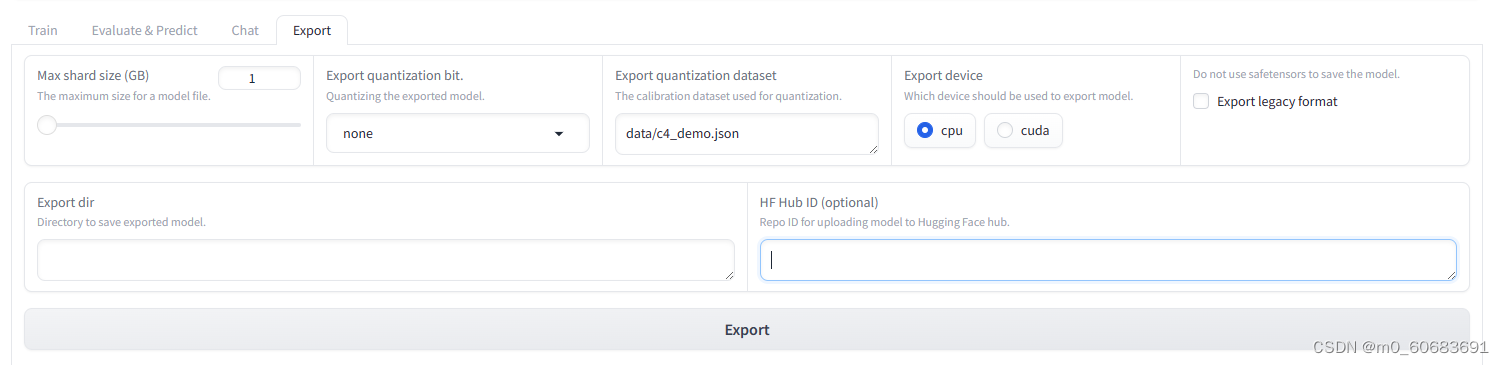

1.微调训练结束之后,点击“Export”选项卡,切换到导出功能区!

2.点击“Refresh adapters”按钮,刷新lora模型,在左侧的下拉列表中选择刚刚训练好的模型!

3.在“Max shard size(GB)”中设置好每个拆分模型的最大size;

4.在“Export dir”中设置模型保存的路径;

5.点击“Export”按钮,开始导出模型(需要点时间等待);

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/604168

推荐阅读

相关标签