热门标签

热门文章

- 1Oracle又裁员!_oracle裁员

- 2KeeperErrorCode = ConnectionLoss 问题解决

- 37 Series FPGAs Integrated Block for PCI Express IP核基本模式配置详解

- 4If you want an embedded database (H2, HSQL or Derby), please put it on the classpath.

- 5python数组求和函数_python数据分析之Numpy数据库第三期数组的运算

- 6第三阶段应用层——1.7 数码相册—电子书(2)—编写通用的Makefile_在主目录下创建dianzi1和dianzi2两个文件夹,在dianzi1文件夹中创建file1 fi

- 7<网络安全>《70 微课堂<第11课 0day、1day、nday(精华版)>》_0day、1day、n day

- 8计算机领域顶级会议归纳(计算机视觉CV、机器学习ML、人工智能AI)_wacv

- 9RabbitMQ消费者Consumer实现_java rabbitmq consumer

- 10CKA 06_Kubernetes 工作负载与调度 Pod 管理 yaml 资源清单 标签 Pod 生命周期 容器探针_kubernetes工作负载 yaml

当前位置: article > 正文

【Python+中文NLP】(一) NLTK库

作者:Monodyee | 2024-05-27 16:37:23

赞

踩

【Python+中文NLP】(一) NLTK库

一、nltk库

nltk是一个python工具包, 用来处理与自然语言相关的东西. 包括分词(tokenize), 词性标注(POS), 文本分类等,是较为好用的现成工具。但是目前该工具包的分词模块,只支持英文分词,而不支持中文分词。

1.安装nltk库

在命令行输入:

- conda install nltk #anaconda环境

- pip install nltk #纯python环境

进入对应的环境中,输入如下:

- import nltk

- nltk.download()

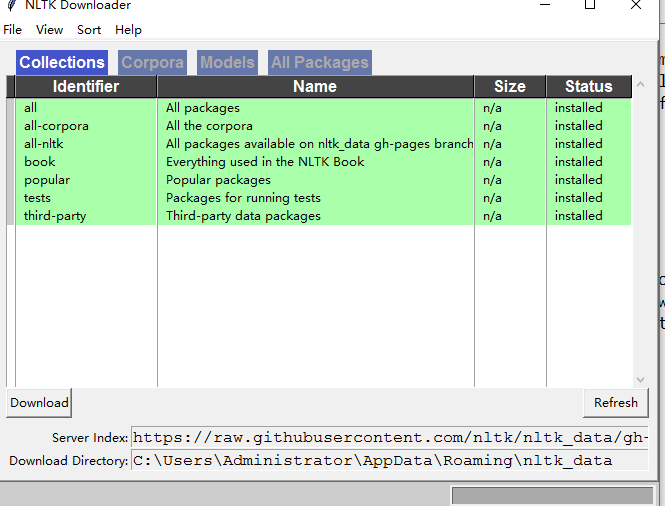

运行后,弹出NLTK Downloader窗口,自定义安装内容 (博主选择all ,即全部安装,大概3.2G左右) ,安装成功如下图所示:

2.nltk库的使用方法

(1)学习资料

【参考文章】

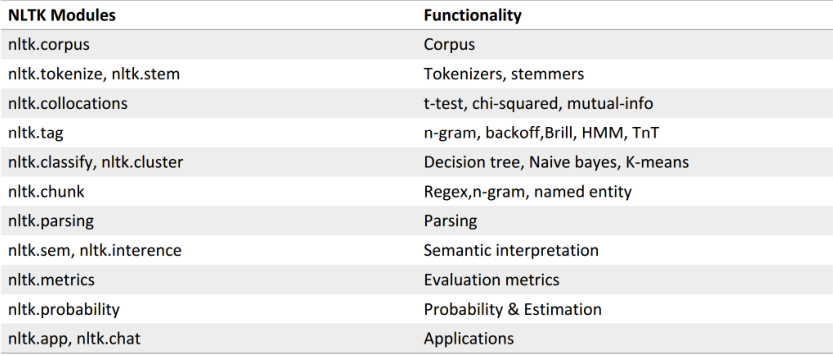

【nltk功能模块】如下图

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/632895

推荐阅读

相关标签