- 1scrapy框架-反爬虫与绕过方法+setting动态配置

- 2浅谈单元测试和JUnit4使用_还有人在用 junit4吗

- 3开源新纪元:ChatTTS——引领对话式文本转语音的新潮流_chattts特点

- 4pnpm安装成功但不能用_pnpm 安装没效果

- 5【Mysql】utf8与utf8mb4区别,utf8mb4_bin、utf8mb4_general_ci、utf8mb4_unicode_ci区别

- 6python2.7是什么_python2.7是什么

- 7PG302 QDMA Subsystem for PCI Express v4.0 Ch.2 Overview

- 8AIGC总体相似度是什么意思_aigc相似度

- 9记录docker-compose遇到的坑_dockercompose keyerror: 'containerconfig

- 10unity入门教程(非常详细)从零基础入门到精通,看完这一篇就够了_unity完全自学教程

大型语言模型(LLMs)在AIGC中的核心地位

赞

踩

本文收录于专栏:精通AI实战千例专栏合集

https://blog.csdn.net/weixin_52908342/category_11863492.html

- 1

从基础到实践,深入学习。无论你是初学者还是经验丰富的老手,对于本专栏案例和项目实践都有参考学习意义。

每一个案例都附带关键代码,详细讲解供大家学习,希望可以帮到大家。正在不断更新中~

一.大型语言模型(LLMs)在AIGC中的核心地位

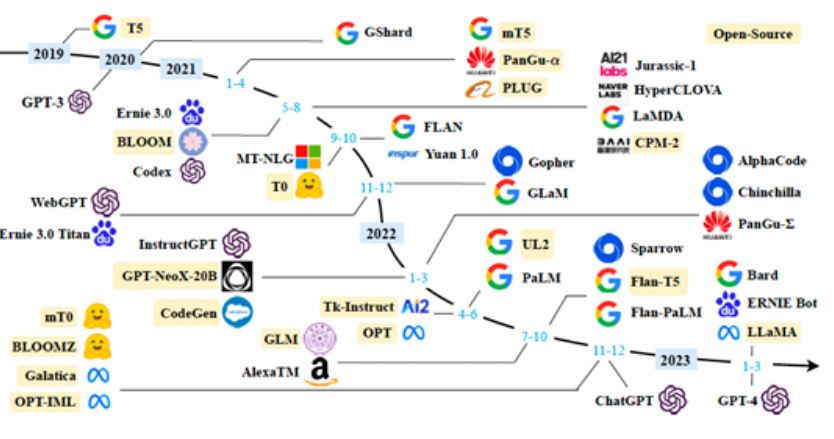

人工智能生成内容(AIGC)正在迅速改变着我们创作和消费内容的方式。在这个领域中,大型语言模型(LLMs,如GPT-3和GPT-4)占据着核心地位。它们不仅可以生成自然语言文本,还可以进行翻译、写作、编程和问题解答等多种任务。本文将探讨LLMs在AIGC中的核心地位,并通过代码实例展示其强大的生成能力。

LLMs在AIGC中的作用

LLMs利用深度学习技术,通过大量的文本数据进行训练,能够生成高质量、连贯的文本。它们在AIGC中的应用包括但不限于:

- 文本生成:自动写作、新闻报道、小说创作等。

- 翻译:多语言翻译,实现跨语言的沟通。

- 对话系统:智能客服、聊天机器人等。

- 编程辅助:代码生成、代码解释等。

- 数据分析:生成数据报告、总结分析结果等。

代码实例

为了展示LLMs在AIGC中的强大功能,我们使用OpenAI的GPT-4模型来生成文本内容。以下是一个简单的Python代码示例,展示如何使用GPT-4生成一段关于AIGC的文章片段。

安装和配置

首先,我们需要安装OpenAI的Python库,并配置API密钥。

pip install openai

- 1

然后,设置API密钥:

import openai

openai.api_key = 'your-api-key'

- 1

- 2

- 3

生成文本

接下来,我们使用GPT-4生成一段关于AIGC的文本。

def generate_text(prompt):

response = openai.Completion.create(

engine="text-davinci-004",

prompt=prompt,

max_tokens=500,

n=1,

stop=None,

temperature=0.7,

)

return response.choices[0].text.strip()

prompt = "请解释大型语言模型在人工智能生成内容中的重要性。"

generated_text = generate_text(prompt)

print(generated_text)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

输出示例

运行上述代码,GPT-4会生成一段关于大型语言模型在AIGC中重要性的文字,类似如下:

大型语言模型(LLMs)在人工智能生成内容(AIGC)中具有关键作用。它们通过对海量数据的深度学习,能够生成高质量、自然流畅的文本内容。LLMs在AIGC中的应用范围广泛,包括自动写作、翻译、对话系统和编程辅助等。其核心优势在于能够理解和生成复杂的语言结构,从而满足不同场景下的内容需求。随着技术的不断进步,LLMs在AIGC中的地位将愈发重要,推动内容创作进入一个全新的智能时代。

- 1

LLMs的优势

LLMs在AIGC中的核心地位源于其几个显著的优势:

- 自然语言理解和生成:LLMs能够理解复杂的语言结构,并生成与人类写作风格相似的文本。

- 多任务处理:同一个模型可以执行多种任务,如写作、翻译、编程等,具有高度的灵活性。

- 大规模训练:通过在海量数据上进行训练,LLMs具备了丰富的知识和上下文理解能力。

- 不断进化:随着新模型和技术的开发,LLMs的性能和应用范围不断扩展,保持了技术前沿的领先地位。

挑战与解决方案

尽管大型语言模型在AIGC中展现出巨大的潜力,但其应用过程中也面临一些挑战。这些挑战主要包括:

- 内容质量和真实性:LLMs可能生成不准确或误导性的内容。

- 伦理和偏见:LLMs在训练过程中可能会学习到数据中的偏见,导致生成的内容存在伦理问题。

- 计算资源和成本:训练和运行大型语言模型需要大量的计算资源和能源,成本较高。

- 隐私和安全:LLMs的生成内容可能涉及敏感信息,存在隐私和安全风险。

解决方案

为了解决上述挑战,研究人员和开发者提出了一些有效的解决方案:

- 内容审核和验证:结合人工审核和自动化验证技术,确保生成内容的质量和真实性。

- 去偏见技术:在训练过程中应用去偏见算法,减少模型生成内容中的偏见和伦理问题。

- 优化模型架构:通过改进模型架构和训练方法,提高模型效率,降低计算资源消耗。

- 数据隐私保护:应用隐私保护技术,如差分隐私,确保训练数据和生成内容的安全性。

实际应用案例

LLMs在实际应用中已经展现出令人瞩目的成就。以下是几个典型的应用案例:

- 新闻自动生成:媒体公司使用LLMs生成新闻报道,提高内容生产效率。例如,《华盛顿邮报》使用AI技术自动生成新闻文章。

- 智能客服:许多企业采用LLMs构建智能客服系统,实现全天候、高效的客户服务。

- 教育和培训:LLMs被用于生成教育内容、自动批改作业和提供个性化学习建议,提升教育质量。

- 编程辅助:GitHub Copilot等工具利用LLMs帮助程序员编写代码、调试和优化,极大地提高了开发效率。

案例代码示例

以下是一个使用GPT-4生成新闻报道的示例代码:

def generate_news_report(prompt):

response = openai.Completion.create(

engine="text-davinci-004",

prompt=prompt,

max_tokens=1000,

n=1,

stop=None,

temperature=0.7,

)

return response.choices[0].text.strip()

news_prompt = "生成一篇关于人工智能最新进展的新闻报道。"

news_report = generate_news_report(news_prompt)

print(news_report)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

运行上述代码,GPT-4会生成一篇关于人工智能最新进展的新闻报道,内容可能如下:

近日,人工智能领域迎来了重要的技术突破。一支国际研究团队宣布,他们开发出了一种新型深度学习算法,显著提升了图像识别的准确性。这一成果有望广泛应用于医疗、安防等多个领域,推动相关行业的发展。研究团队表示,该算法通过引入多层次的特征提取机制,使得模型能够更好地理解和处理复杂的图像数据。专家们认为,这一突破将为未来的人工智能应用带来新的机遇。

- 1

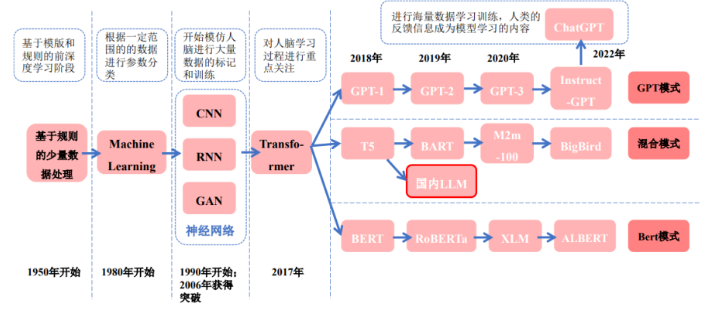

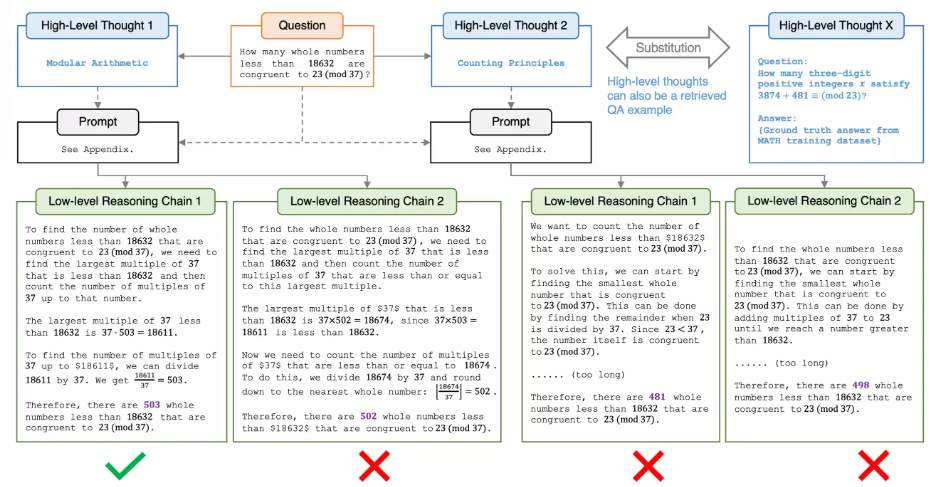

深度学习与LLMs的技术基础

LLMs的核心技术基础是深度学习,尤其是基于Transformer架构的神经网络模型。Transformer模型通过自注意机制(Self-Attention)来处理和生成自然语言文本。以下是Transformer模型的一些关键技术概念:

- 自注意机制:允许模型在处理每个词时关注输入序列中的其他词,从而捕捉词之间的长距离依赖关系。

- 多头注意机制:通过并行计算多个自注意机制,使模型能够捕捉不同层次的语义信息。

- 位置编码:由于Transformer模型本身不包含位置信息,位置编码被引入以表示输入序列中词的位置。

Transformer模型的实现

以下是一个简化的Transformer模型实现示例,展示其基本结构和自注意机制的原理:

import torch import torch.nn as nn class SelfAttention(nn.Module): def __init__(self, embed_size, heads): super(SelfAttention, self).__init__() self.embed_size = embed_size self.heads = heads self.head_dim = embed_size // heads assert ( self.head_dim * heads == embed_size ), "Embedding size needs to be divisible by heads" self.values = nn.Linear(self.head_dim, embed_size, bias=False) self.keys = nn.Linear(self.head_dim, embed_size, bias=False) self.queries = nn.Linear(self.head_dim, embed_size, bias=False) self.fc_out = nn.Linear(embed_size, embed_size) def forward(self, values, keys, query, mask): N = query.shape[0] value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1] # Split the embedding into self.heads different pieces values = values.reshape(N, value_len, self.heads, self.head_dim) keys = keys.reshape(N, key_len, self.heads, self.head_dim) queries = query.reshape(N, query_len, self.heads, self.head_dim) energy = torch.einsum("nqhd,nkhd->nhqk", [queries, keys]) if mask is not None: energy = energy.masked_fill(mask == 0, float("-1e20")) attention = torch.softmax(energy / (self.embed_size ** (1 / 2)), dim=3) out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape( N, query_len, self.embed_size ) out = self.fc_out(out) return out class TransformerBlock(nn.Module): def __init__(self, embed_size, heads, dropout, forward_expansion): super(TransformerBlock, self).__init__() self.attention = SelfAttention(embed_size, heads) self.norm1 = nn.LayerNorm(embed_size) self.norm2 = nn.LayerNorm(embed_size) self.feed_forward = nn.Sequential( nn.Linear(embed_size, forward_expansion * embed_size), nn.ReLU(), nn.Linear(forward_expansion * embed_size, embed_size) ) self.dropout = nn.Dropout(dropout) def forward(self, value, key, query, mask): attention = self.attention(value, key, query, mask) x = self.dropout(self.norm1(attention + query)) forward = self.feed_forward(x) out = self.dropout(self.norm2(forward + x)) return out

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

这个代码示例展示了自注意机制和Transformer块的基本结构。每个Transformer块包含一个自注意层和一个前向传播网络,并使用层归一化和dropout来稳定训练过程。

LLMs的未来发展

多模态生成模型

未来的LLMs不仅限于生成文本,还将扩展到多模态生成,包括图像、音频和视频等。多模态生成模型可以理解和生成跨越不同媒体形式的内容,实现更丰富和复杂的创作。例如,DALL-E模型就是一个可以根据文本描述生成图像的多模态模型。

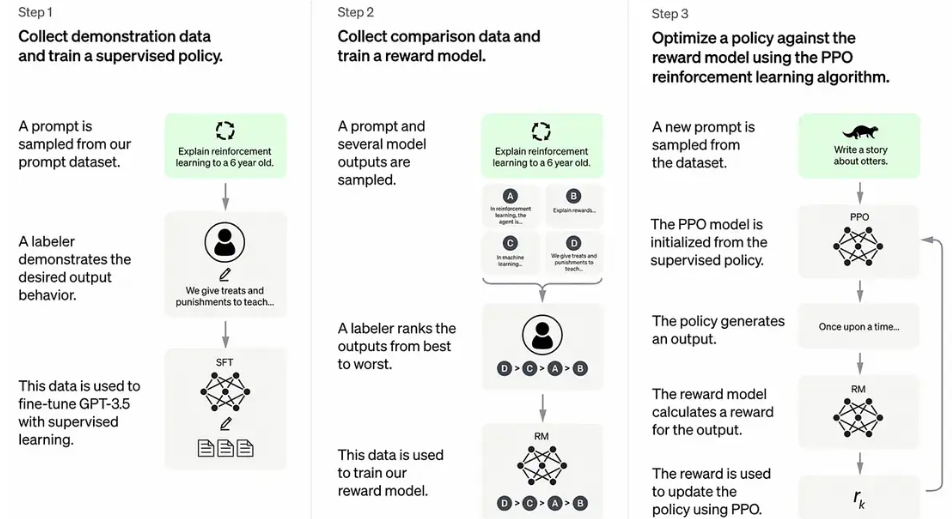

强化学习与LLMs

将强化学习(RL)技术与LLMs结合,可以实现更智能的内容生成。通过引入RL,模型可以在生成过程中不断调整和优化,确保生成内容的质量和一致性。例如,DeepMind的AlphaGo使用RL技术实现了超越人类水平的围棋策略,这一技术也可以应用于内容生成领域。

自主学习和进化

未来的LLMs将具备更强的自主学习能力,能够根据用户反馈和交互数据不断优化和进化。通过引入自监督学习和迁移学习等技术,模型可以在较少的数据和计算资源下实现高效的学习和适应。

伦理与法规

随着LLMs的发展,伦理和法规问题变得愈发重要。研究人员和开发者需要共同制定相关的伦理准则和法律法规,确保LLMs的应用安全、透明和公平。具体措施包括:

- 透明度:确保LLMs的工作原理和数据来源透明可见,便于审查和监督。

- 责任机制:建立明确的责任机制,确保生成内容的质量和安全。

- 公众教育:加强公众对LLMs技术的认识和理解,防止误用和滥用。

结论

大型语言模型(LLMs)在人工智能生成内容(AIGC)中占据着核心地位,其强大的自然语言处理能力使其成为内容创作的重要工具。尽管面临一些挑战,LLMs通过不断的发展和优化,正在推动内容生成进入一个智能化、个性化的新时代。

通过深度学习技术,LLMs能够理解和生成复杂的文本内容,应用范围广泛,包括新闻报道、智能客服、教育培训和编程辅助等领域。未来,随着多模态生成、强化学习和自主学习技术的引入,LLMs将展现出更强的能力和潜力,为我们带来更加丰富和智能的内容生成体验。

我们有理由相信,在技术和伦理的共同推进下,LLMs将在AIGC领域中发挥更加重要的作用,推动内容创作和消费方式的变革,开创内容创作的新纪元。