- 1成功解决PermissionError: [Errno 13] Permission denied: './data\\mnist\\train-images-idx3-ubyte'_permissionerror: [errno 13] permission denied: '..

- 2[卡空间][可持久化线段树]Couriers LibreOJ2432_线段树 出现次数大于等于k

- 3用AD绘制的Stm32最小系统电路原理图它来啦_stm32mp1最小系统原理图

- 4[解决]opencv编译过程 ”系统找不到指定的路径“问题_win10 opencv460 21>系统找不到指定的路径。

- 5fastdfs-client使用

- 6Hadoop实战:微博数据分析_基于hadoop的微博数据分析系统

- 7用Python开发web可视化应用_python web可视化

- 8Android开发--WebView简单录音功能的实现_webview 录音返回文件

- 9python计算机二级考前三天冲刺(附刷题软件)_x=['90','87','90']

- 10用SQL语句进行数据库查询(简单查询)_利用sql语句完成以下查询(1)显示前10%的女生记录。(2)查询选修了课程的学生学号。

如何将大模型应用到自己的业务中?7种大模型应用方式和代表论文总结

赞

踩

来自:圆圆的算法笔记

进NLP群—>加入NLP交流群

如何将大模型应用落地到自己的业务或工作中?这篇文章整理了7种目前业内最常用的大模型应用方法,以及各个方法的代表论文。通过对各种应用大模型方法的特点对比,找到最适合自己场景的应用方法。

1

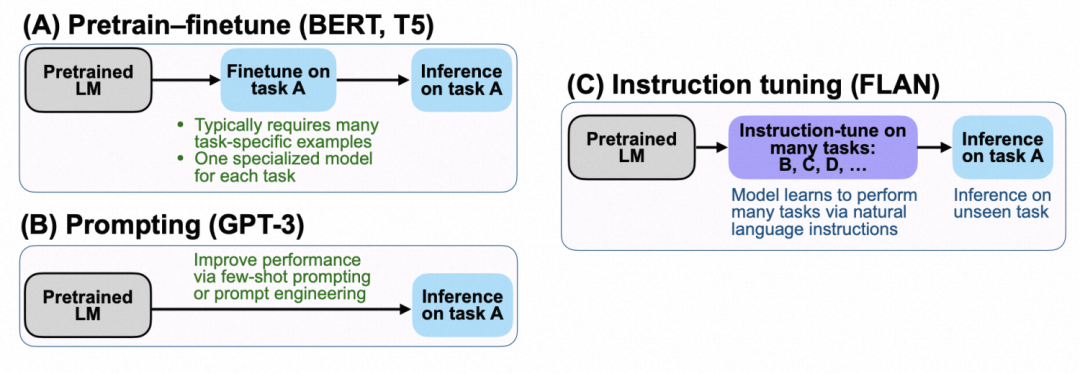

Pretrain-Finetune

直接针对下游任务进行全量参数或者部分参数的finetune,在BERT时期是主要的大模型应用方式。其局限性是成本较高,灵活性较差,需要针对每个任务单独finetune和保存一组模型,可复用性较低。

2

Prompt

Prompt是GPT以来的一种大模型应用方式,基于生成式语言模型(Transformer Decoder),将下游任务通过prompt的形式转换成完形填空任务,让模型预测缺失部分的文本,再将文本映射回对应任务的label。Prompt方式完全不进行大模型finetune,只利用大模型内部的知识,让下游任务反向适配预训练任务。其缺陷在于效果非常依赖于人工定义的prompt。

3

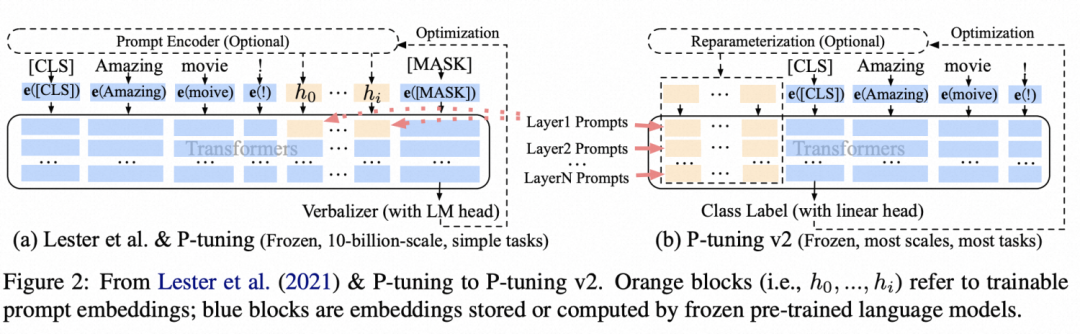

Prompt-tuning

Prompt-tuning不人工设定prompt,而是将其转换为可学习的向量。例如原来的prompt为The capital of Y is ...,这里Y是上下文,其他部分是prompt模板,那么prompt-tuning将这些明文的prompt token全部替换成可学习的向量,基于训练数据对模型进行finetune,只finetune这些prompt embedding,模型主体参数固定不变。。这种方式不再依赖人工定义prompt明文模板,交给模型自己去学,同时需要finetune的参数量也比较小。

代表论文:P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks(2021)、GPT Understands, Too(2021)

4

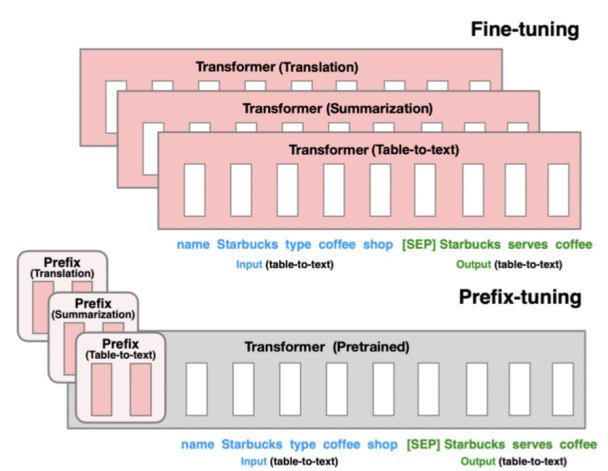

Prefix-tuning

与prompt-tuning的思路非常类似,prefix-tuning在输入文本前面加入一些任务特定的可学习参数,这些参数跟随下游任务做finetune,预训练模型整体参数固定不变。Prefix-tuning和prompt-tuning是同一时期的两类工作,二者核心思路是相同的,都是用一小部分参数的finetune(prefix对应的前缀向量,或prompt对应的模板向量)让大模型适配下游任务,二者区别不大。

代表论文:Prefix-Tuning: Optimizing Continuous Prompts for Generation(2021)

5

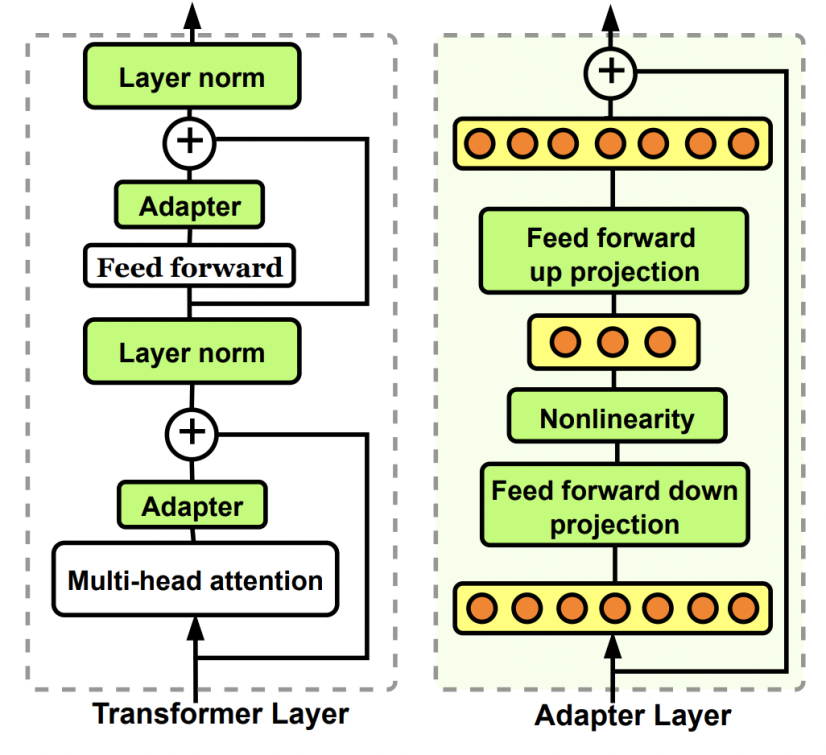

Adapter-tuning

在大模型的中间部分加一个参数量较小的网络结构(即adapter),大模型整体参数freeze不变,只更新adapter部分的参数。Adapter一般采用bottleneck的结构,缩小参数量。本质上也是一种通过少量参数的更新影响大模型整体参数的finetune方式。

代表论文:Parameter-Efficient Transfer Learning for NLP(ICML 2019)

6

Instruction-tuning

Instruction-tuning将所有下游的各类NLP任务都转换为自然语言,在大模型的基础上finetune全部参数,finetune的目标就是语言模型,通过这种方式让预训练大模型适应人类的指令(即人类描述各类NLP任务,并要求模型给出答案的语言范式),进而有效解决各类NLP任务,具备强大的zero-shot learning能力。

7

Knowledge Distillition

从大模型中获取数据,用获取到的数据训练尺寸更小的模型,过程中结合思维链等技术,让模型生成更有价值更准确的训练数据。这种方式也是成本最低,但是可能很有效果的方法。最简单的就是直接调用ChatGPT或者GPT4的接口获取想要的数据,核心是如何设计prompt让黑盒大模型输出我们想要的结果。

代表论文:Distilling Step-by-Step! Outperforming Larger Language Models with Less Training Data and Smaller Model Sizes

进NLP群—>加入NLP交流群