- 1sed 常用命令_sed命令

- 2JetPack及常用组件_jetpack常用

- 3【效率提升】IDEA中书签功能的妙用_idea 书签

- 4微信小程序集成three.js--VR全景项目源码_微信小程序实景导航vr

- 5Android11.0 V-A/B无缝OTA升级update_engine_实现 a/b update

- 6白话RAM,ROM,Flash的区别_flash闪存是rom的一种吗

- 7SEO技术大师-论坛网站SEO设置方法_dz论坛好做优化吗

- 8手机之家签名工具_手机端自签名续签名 AltStore越狱安装工具AltServer与AltDeploy使用教程iOS13.5...

- 9通过ADB命令刷入boot.img和recovery.img的方法

- 10【网络原理】使用Java基于UDP实现简单客户端与服务器通信_java web 如何使用udp/跟其他客户端交互

DeBERTa讲解

赞

踩

Disentangled attention.

- 相对位置关系很重要

- BERT将绝对位置embedding和词embedding相加,不足以区分词在句中位置关系

-

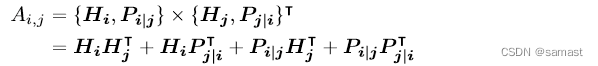

attention得分计算。H是attention层输出,P是相对位置embedding。在每一层都加入一个位置编码。区别于BERT只在输入加上绝对位置编码。 想法推测来源于transformer XL。

-

第一项内容对内容查询, 二三项分别是位置对内容,内容对位置查询(查表)。第四项位置对位置丢掉。

-

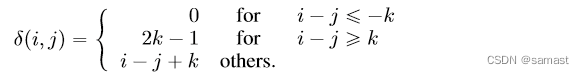

相对位置表, i 在 j 前太远为 0。 i 在 j 后太远为最大值。

-

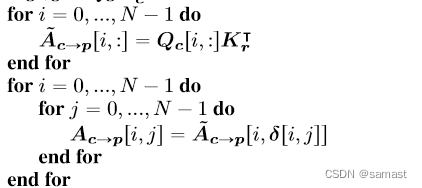

C->P为例, A ^ \hat A A^ 是每个单词和它周围任一单词的关系(例如对前一个位置得分)。 A [ i , j ] A[i, j] A[i,j]是内容 i 对当前句子位置 j 的得分。所以计算 i - j 然后在 A ^ \hat A A^ 中查表。

-

本质上是只看单词和当前状态 H H H 然后在周围选取value。

Enhanced mask decoder.

- query加上绝对位置编码。