热门标签

热门文章

- 1高性能MySQL第四版-1_高性能mysql第四版电子书

- 2oracle数据库id字段自增长_oracle id自增

- 3带默认值的函数、内联函数和函数重载_内联函数,带默认值的函数,函数的重载有什么特点,请结合实例加以说明。

- 4怎样建立产品体系?(二)- 战略

- 5OriginBot智能机器人开源套件-Step10相机驱动与图像可视化

- 6在linux下使用git上传代码,在Linux下写一个进度条程序_git 进度条 zenmzuo

- 7SLF4J: Class path contains multiple SLF4J bindings.——Hbase启动输出

- 8PLSQL连接Oracle

- 9中兴新支点Linux桌面操作系统,中兴新支点Linux桌面操作系统,小白也能轻松上手...

- 10愿我能陪你颠沛流离

当前位置: article > 正文

透彻分析Transformer中的位置编码(positional enconding)_transformer位置编码为啥用sin和cos

作者:weixin_40725706 | 2024-06-01 07:31:39

赞

踩

transformer位置编码为啥用sin和cos

一、Transformer中为什么要使用位置编码positional encoding

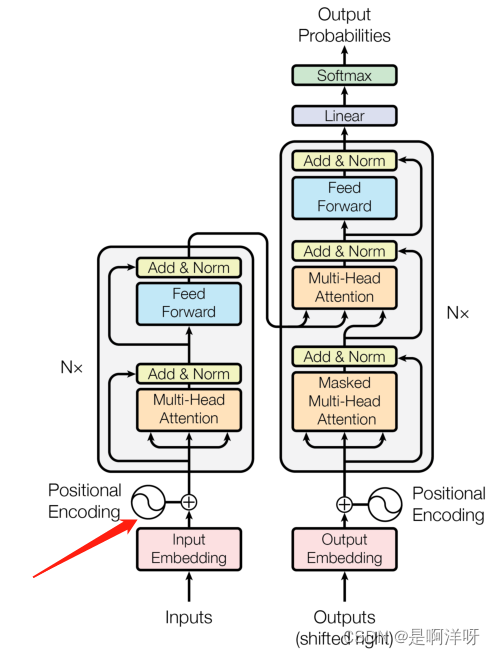

在《Attention Is All You Need》这篇论文中首次提到了transformer模型,transformer模型在输入端用了一个位置编码(positional encoding),其主要目的是增加相对位置信息,使其可以更好的利用每个元素相互之间的位置关系

二、具体编码实现方式

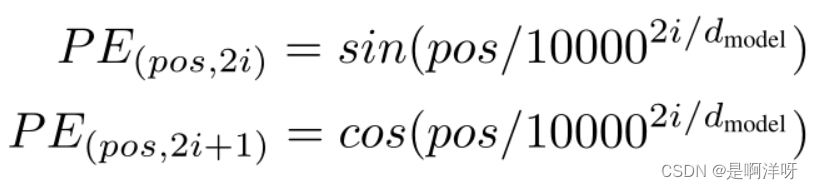

论文作者使用的是正余弦函数进行编码,这时可能会有人产生了疑惑,为什么要使用这么复杂的编码方式呢,这里举个例子,一句话“你好吗”用“1,0,0”、“0,1,0”、“0,0,1”的独热编码不可以么,编码方式还会更加的简单,为什么要用下图这么复杂的编码方式呢?

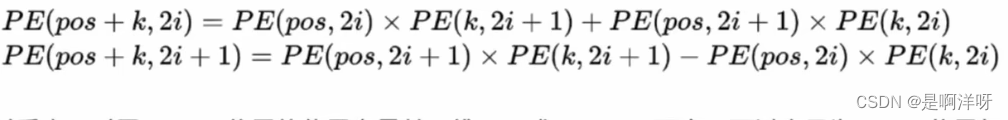

因为正余弦编码的表示方法蕴含了相对位置信息,假设一句话“我是小狗”的“狗”的位置为 pos+k,那么即可用在位置为“pos”的“我”和在“k”位置的“是”这两个位置的编码向量进行线性组合来表示出狗这个字的位置编码向量,具体公式如下。

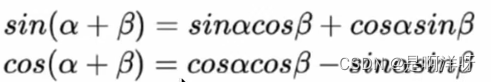

上式的具体推到用到了sin和cos的积化和差的性质,这也就是为什么要用sin和cos交替的形式来进行位置编码

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/656640

推荐阅读

相关标签