- 1性能猛兽:OrangePi Kunpeng Pro评测!

- 2CPU设计实战:Loongarch版 lab6--20条指令单周期CPU_cpu设计实战loongarch版

- 3开源利器:`cloudflare-python`— 带您轻松玩转Cloudflare API

- 4你知道人工智能机器的学习过程是怎样的吗?_ai机器人机器学习过程

- 5mongodb安全配置

- 6评分卡:WOE、IV、PSI计算及ROC和KS曲线_woe iv psi

- 7Vue2项目引入高德地图并展示_vue2引入高德地图

- 8经典例题(二)——最大子段和

- 9java数据结构(1):集合框架,时间,空间复杂度,初识泛型

- 10数学模型:Python实现整数规划

ICML2024 | TimeSiam: 时间序列的孪生预训练方法

赞

踩

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

本文介绍清华大学软件学院机器学习组 ICML2024时间序列表征学习方向的最新工作:TimeSiam: A Pre-Training Framework for Siamese Time-Series Modeling

摘要:时间序列预训练因其可以有效减少标注成本并有益于各种时序分析任务而引起了广泛的关注。本文提出了一种名为TimeSiam的时间序列自监督预训练框架,通过预训练孪生网络来捕捉随机采样的过去和当前子序列之间潜在的时间相关性,并通过过去到当前子序列的重建和可学习的时差嵌入,学习时序数据内部的时间依赖表征。我们的方法在同领域和跨领域两个场景下的13个标准基准测试中均展现了出色的预测和分类效果。

作者列表:董家祥*,吴海旭*,王雨轩,邱云中,张力,王建民,龙明盛

链接:https://arxiv.org/abs/2402.02475

代码:https://github.com/thuml/TimeSiam

1. 引言

时间序列预训练已经引起了广泛关注,因为它能有效减少数据标注成本,还能显著提升多种下游时间序列分析任务的效果。

我们注意到时间序列与图像和自然语言数据的一个关键性差异在于,时间序列是由沿时间维度的一系列有限数据标量值组成,这意味着时间序列中的关键信息主要保存在时序关联(Temporal Correlation)中。因此,时间序列建模的关键在于优化模型以准确捕捉时序关联关系。

本文专注于时间序列中的时序关联建模,设计并提出了一种简单有效的时间序列自监督预训练框架TimeSiam,在预测和分类两类主要时序分析任务上实现了全面领先。

2. 设计思路

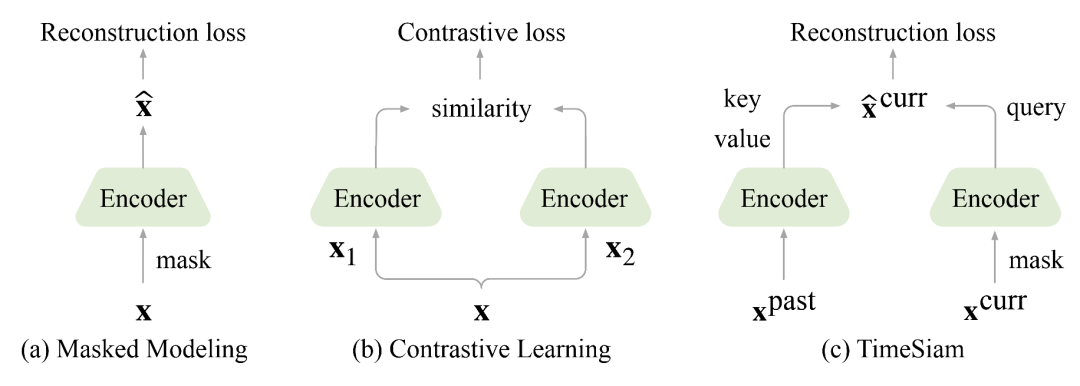

在现实世界中,每天都有大量的时间序列数据被采集。有效的时间序列预训练方法能够从这些数据中提取有价值且可迁移的知识,从而提升多样化的下游时序分析任务的效果。目前,主流的时间序列预训练方法主要分为对比学习(Contrastive Learning)和掩码建模(Masked Modeling)两类。然而,这些方法受到数据增广选择和数据掩码过程中时序关键信息破坏的限制,无法进行有效的时间序列建模,从而限制了其实际应用性。

为了解决上述问题,我们提出了一种简单且有效的时间序列自监督预训练框架TimeSiam。如图所示,TimeSiam不同于已有的对比学习和掩码建模预训练框架,提出了基于孪生神经网络(Siamese Network)的过去重建当下的时间序列掩码建模新思想。

TimeSiam从相同的时间序列中随机采样跨越不同时间步的序列样本对儿,称为孪生子序列(Siamese Subseries),并基于孪生神经网络捕捉不同时间距离下采样的孪生子序列间的关联关系。通过引入简单的掩码增广,TimeSiam不仅进一步提高了孪生子序列间的多样性,还自然地派生出一个从过去到当前序列的重建任务,从而强化模型对数据内部时序关键信息的学习,并捕捉过去和当前序列间的时序关联关系。

此外,为了覆盖不同采样距离(长、短期)的孪生子序列间的关系建模,我们提出了可学习的时差嵌入(lineage Embedding),以强化模型对多样化时序依赖表征的学习,并引入了结合交叉注意力(Cross-attention)和自注意力(Self-attention)机制的解码器,以确保稳定的过去到当前掩码序列的重建过程。

3. TimeSiam

TimeSiam是一种专为时间序列数据设计的自监督预训练框架。基于孪生神经网络,TimeSiam能够有效的捕捉随机采样的过去和当前子序列之间的潜在时间相关性。通过从过去到当前子序列的重建以及可学习的时差嵌入,TimeSiam能够有效的学习时间序列数据内部的时序依赖表征。

3.1 预训练

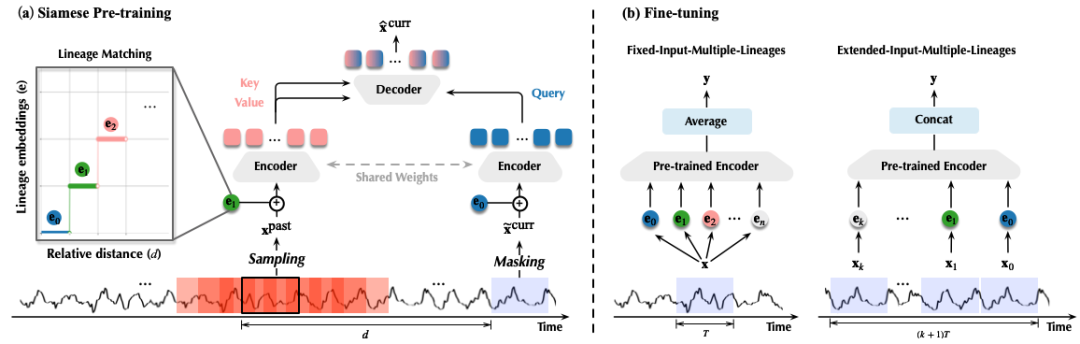

TimeSiam的预训练过程包括以下三部分:孪生子序列采样,孪生关联建模和孪生掩码重建。

孪生子序列采样

已有的时间序列预训练方法通常仅关注于序列自身的建模,而忽略了相关时间序列之间关联关系的建模。与之相反,TimeSiam重点关注跨不同时间步采样的子序列之间的时序关联建模。如上图(a)所示,我们通过在相同的时间序列中随机采样一个当前序列样本前的过去序列样本,构建孪生子序列。

进一步地,我们应用简单的掩码技术生成掩码的当前子序列的,以提高孪生子序列间的多样性,确保更鲁棒、充分的预训练过程。以上过程可以形式化为:

孪生关联建模

构建掩码增广后的孪生子序列对儿之后,如上图(a)所示,我们进一步结合可学习的时差嵌入,以有效捕捉不同孪生子序列间的差异性,进而增强模型学习多样化的时序关联表征的能力。

具体来说,我们首先初始化个维的可学习时差嵌入。对于过去子序列,我们基于孪生子序列间的相对距离,通过函数动态匹配其对应的时差嵌入。对于掩码的当前子序列,我们使用一个固定的时差嵌入,表示退化状态。

注意,时差嵌入用于识别孪生子序列间的时序距离,可以沿时间维度共享。时差嵌入与孪生子序列表征融合后生成和,它们均属于。接下来,基于孪生神经网络,生成成对儿的完整的过去和掩码的当前子序列表征。

如上图(a)所示,孪生采样和掩码增广过程会自然地派生出一个从过去到当前的序列重建任务。TimeSiam使用一个特殊设计的解码器,该解码器结合了交叉注意力(Cross-attention)和自注意力(Self-attention)机制。具体来说,以掩码的当前时间序列表征作为query,过去的时间序列表征作为key和value,以动态捕捉过去到当前时间序列间潜在的关联关系。所获得的融合表征通过Self-attention层与FFN层进行进一步的表征强化,具体表示如下:

孪生掩码重建

最后,解码器的输出通过一个线性映射层用于当前掩码序列的重建。基于以上设计,TimeSiam可以通过一个简单的序列重建损失函数进行自监督训练,通过从过去到当前的时序关联建模,学习时间序列数据中的时间依赖表征。

3.2 微调

结合预训练的孪生网络和时差嵌入,如上图(b)所示,TimeSiam可以适应两类微调范式:多时差嵌入的固定输入序列和可扩展输入序列。

多时差嵌入的固定输入序列

在标准的微调范式下,一个样本通常只生成一类表征,这会限制预训练模型生成表征的多样性和丰富性。与之相反,TimeSiam受益于多种不同类型的时差嵌入,通过与预训练的孪生网络相结合,可以生成当前样本在不同时差视角下的不同时序表征,从而极大地丰富了表征的多样性。

多时差嵌入的可扩展输入序列

在微调阶段,模型可能会处理比预训练阶段更长的时间序列。例如,长度的输入序列。以往的时间序列预训练方法对不同的时间片段采用相同的编码器,这显然忽略了扩展序列的时间顺序。然而,TimeSiam可以利用在不同时间距离下预训练的多类时差嵌入到不同的时间片段中。通过将每个片段与其对应的时差嵌入关联融合,从而有效地保留时间序列的原始时间顺序。

4. 实验

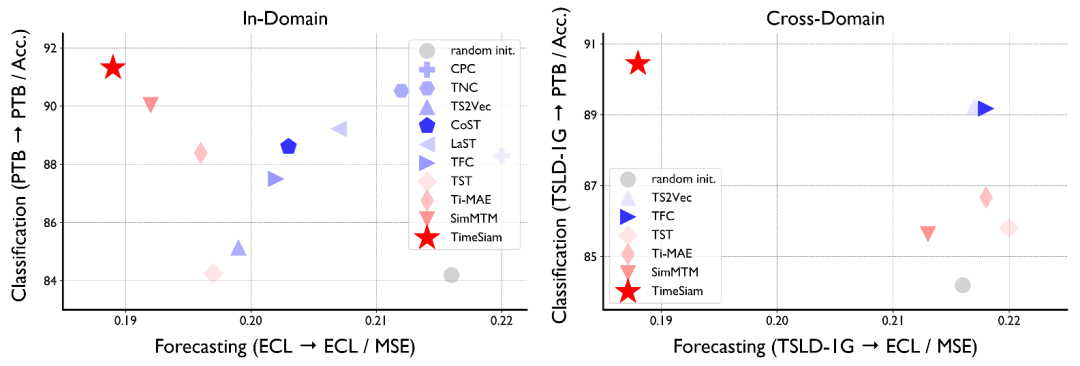

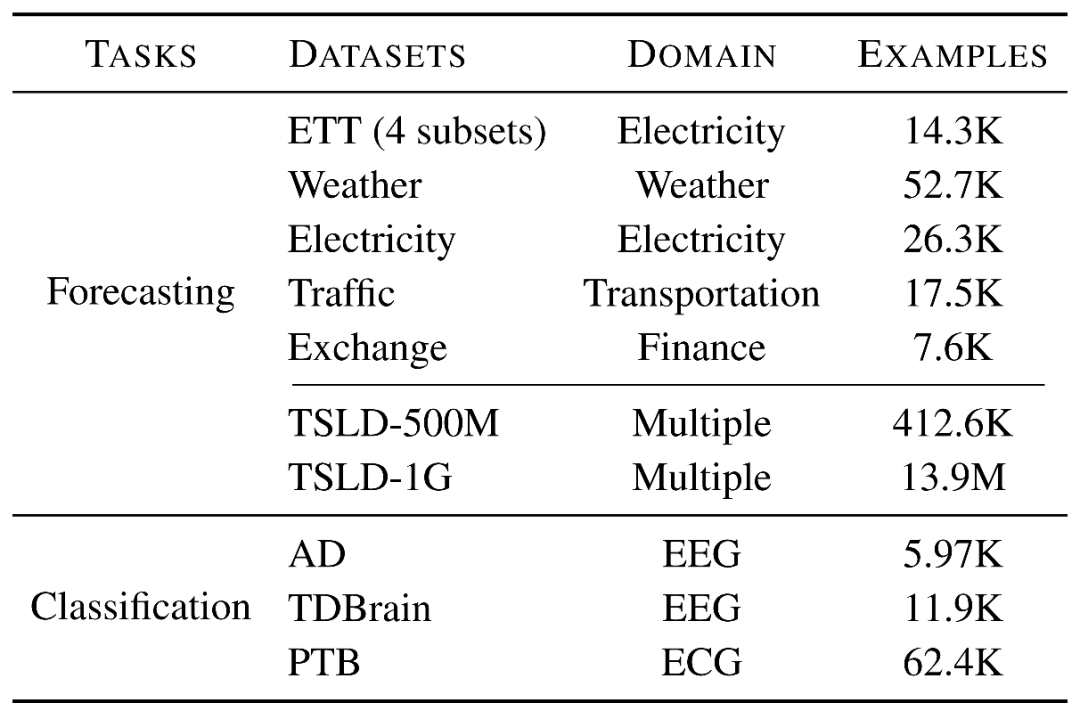

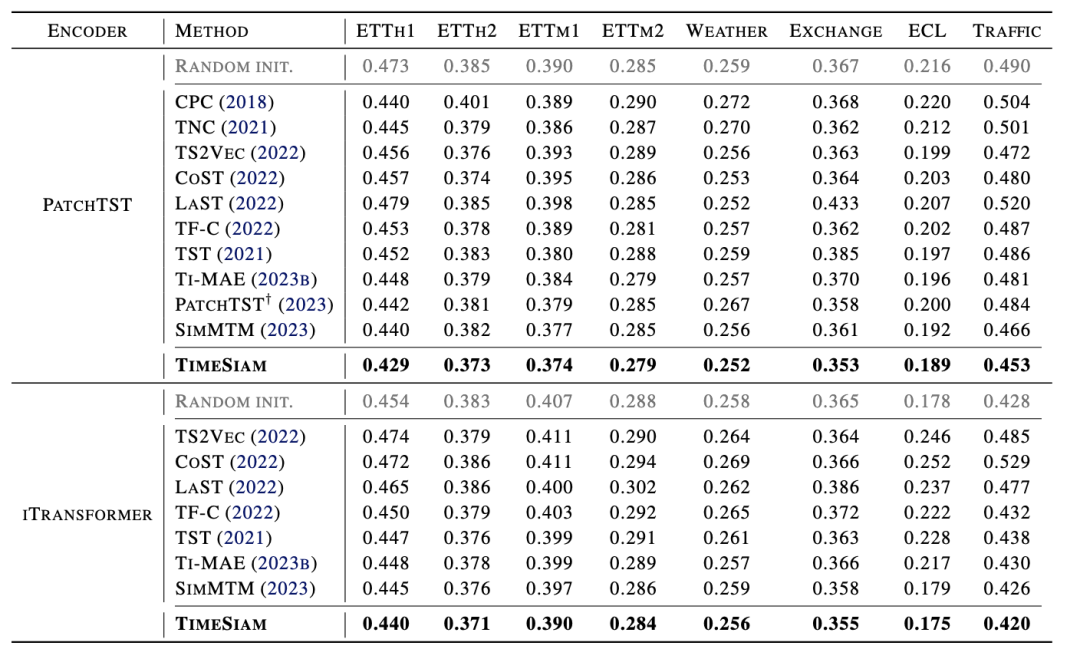

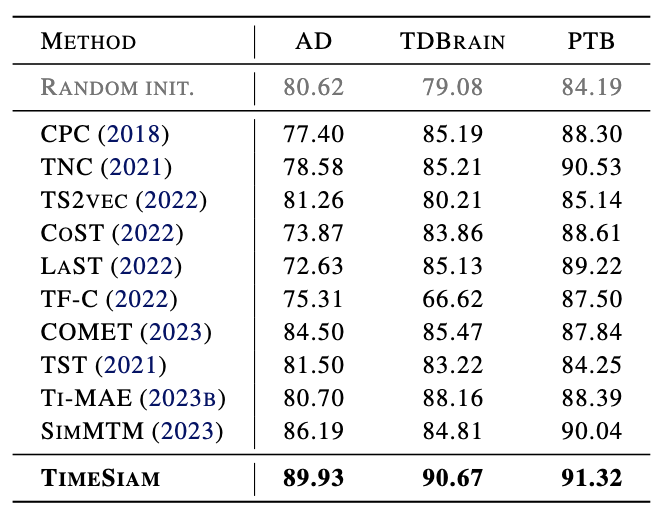

如下表所示,我们在最常见的时间序列预测和分类任务上进行了效果验证。实验设置包括同领域和跨领域的多个场景,并在13个公开的标准基准测试集上对比了11个先进的基线方法,分别包括对比学习方法:COMET(2023)、TF-C(2022)、LaST(2022)、CoST(2022)、TS2Vec(2022)、TNC(2021)、CPC(2018),以及掩码建模方法:SimMTM(2023)、Ti-MAE(2023)、TST(2021)和PatchTST(2023)的自监督预训练版本。

4.1 总体结果

实验结果证明,TimeSiam在两类主要的时间序列分析任务上均取得了全面领先的效果。

(1)预测任务: 我们使用目前最先进的时间序列模型PatchTST(2023)和iTransformer(2023)作为孪生网络的backbone,进行不同基线方法的公平对比,TimeSiam取得了一致最优的预测效果。

(3)分类任务: 在此任务上,TimeSiam超越了前沿的时间序列表征学习方法。

更多实验结果详见论文。

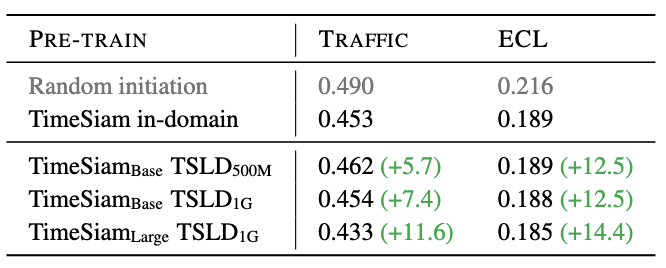

4.2 数据规模与模型容量

我们收集了更大规模的时间序列数据集,并在不同容量大小的模型上进行效果验证。如下表所示,更大规模的数据和模型容量可以带来更优异的效果。

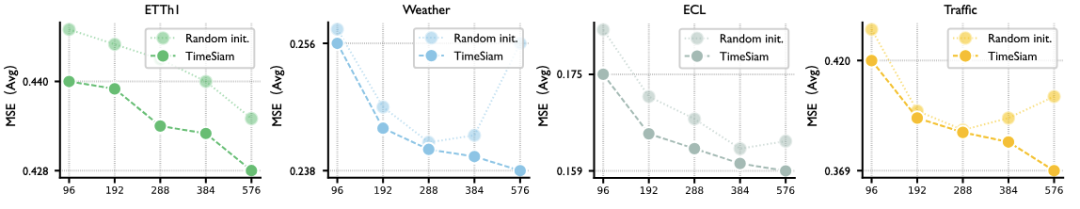

4.3 可扩展的输入长度

为了证明TimeSiam在适应扩展输入长度方面的优势,我们列举了不同输入长度下模型的预测效果,如下图所示。实验结果表明,TimeSiam在处理可扩展的输入序列时表现更佳。

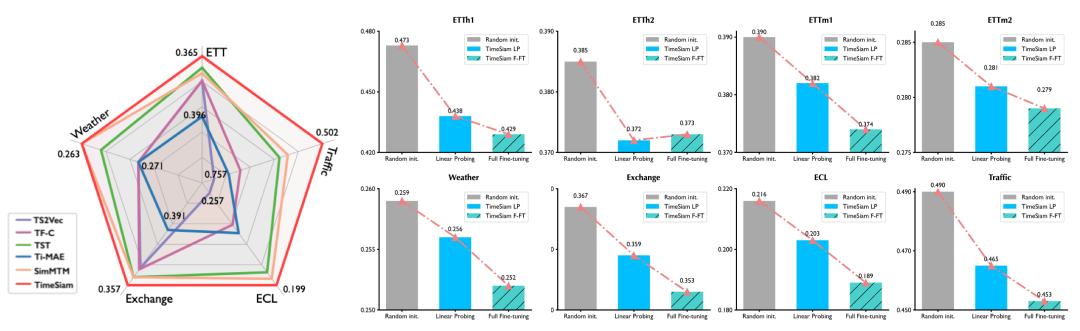

4.4 线性探测

我们还进行了不同时间序列表征学习方法的线性探测实验。如下图所示,TimeSiam取得了更为全面的线性探测效果,证明其学习到了更为有效的时间序列表征。

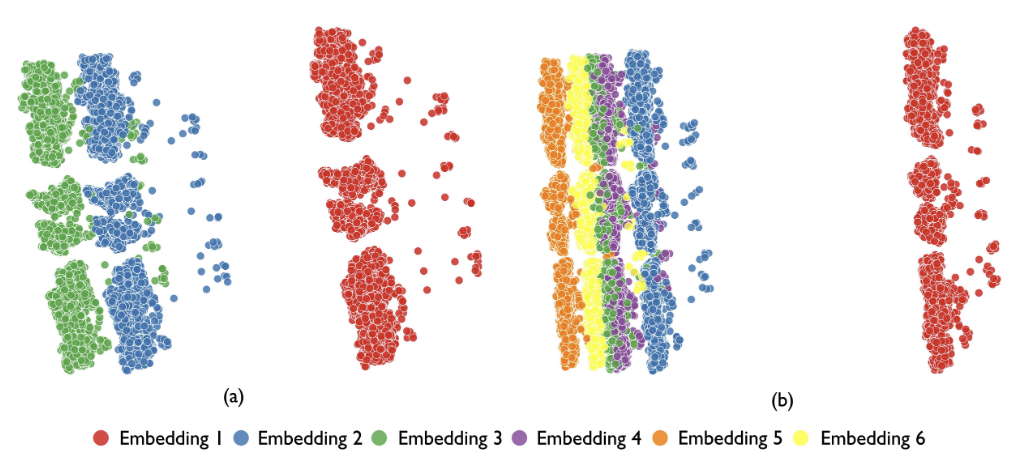

4.5 表征分析

为了进一步探究基于TimeSiam学习的时序表征的有效性,我们进行了表征的可视化分析。对于相同的时间序列,将其分别与不同的时差嵌入融合后输入固定参数的预训练孪生网络中。需要注意的是,相同序列的表征如果不与时差嵌入融合,其表征应该是相同的。如下图所示,相同数据与不同的时差嵌入融合后所生成的表征明显区分。此现象证明,TimeSiam可以有效增强表征的多样性。

5. 总结

本文聚焦于符合时间序列数据特点的时序关联建模这一关键问题,创新性地提出了一种基于孪生神经网络的过去到当前的掩码时间序列建模框架——TimeSiam。在常见的时间序列分析任务中,TimeSiam取得了一致最优的领先效果。

得益于其简单且有效的设计思路,TimeSiam能够应用于更大规模、更具多样性的时间序列自监督预训练场景,对后续时间序列基础模型的研究具有良好的启发作用。

往期精彩文章推荐

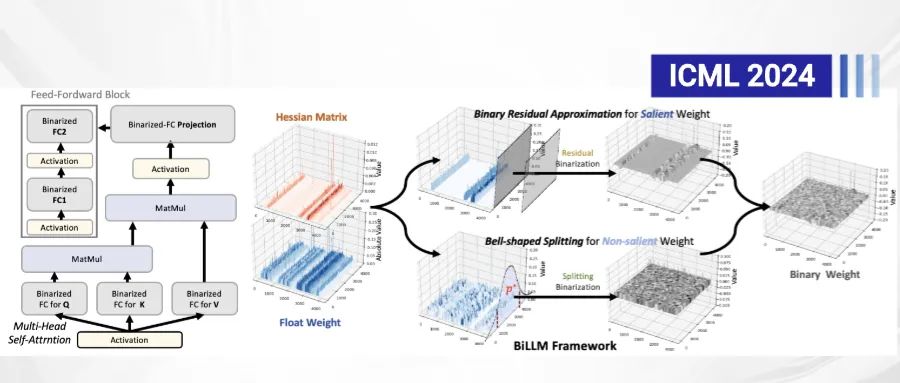

论文解读 | ICML2024:BiLLM:推进大型语言模型后训练量化的极限

论文解读 | ICML2024:BiLLM:推进大型语言模型后训练量化的极限

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1800多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 作者直播讲解回放!