热门标签

热门文章

- 1【全面了解自然语言处理三大特征提取器】RNN(LSTM)、transformer(注意力机制)、CNN_nlp自然语言 transformer rnn lstm

- 2python读取文件内容的方法_教你一招!Python读取文件内容为字符串的方法

- 3【脉冲神经网络教程 02】脉冲神经网络搭建及训练-实战篇_脉冲神经网络训练

- 4解密人工智能:语言理解与机器翻译技术的革命

- 5构建外卖跑腿系统:技术实现与架构设计_跑腿系统设计与实现

- 6通过挂载阿里云盘,把手机存储空间扩展到2000G【详细教程】_手机储存空间扩容挂载阿里云盘

- 7创建你的第一个 DeepFake 视频_deep fake

- 8急速搭建ChatGPT——GPT4All本地部署_本地部署chatgpt4

- 9Vision Transformer(iGPT,ViT,DERT,IPT,TransReID,TransGAN,TNT,CvT)_generative pretraining from pixels

- 10会议论文出版社、出版地、引用格式_ijcai出版商地址

当前位置: article > 正文

yolov5载入训练过的模型之后,loss会飙升的解决方法。_yolov5的obj_loss置信度怎么下降

作者:不正经 | 2024-03-28 10:10:55

赞

踩

yolov5的obj_loss置信度怎么下降

原因:

每次重新运行代码之后,学习率会重置,导致学习率过高从而开始升高损失。

yolov5的学习率下降模型,是one_cycle.

def one_cycle(y1=0.0, y2=1.0, steps=100):

# lambda function for sinusoidal ramp from y1 to y2

return lambda x: ((1 - math.cos(x * math.pi / steps)) / 2) * (y2 - y1) + y1

- 1

- 2

- 3

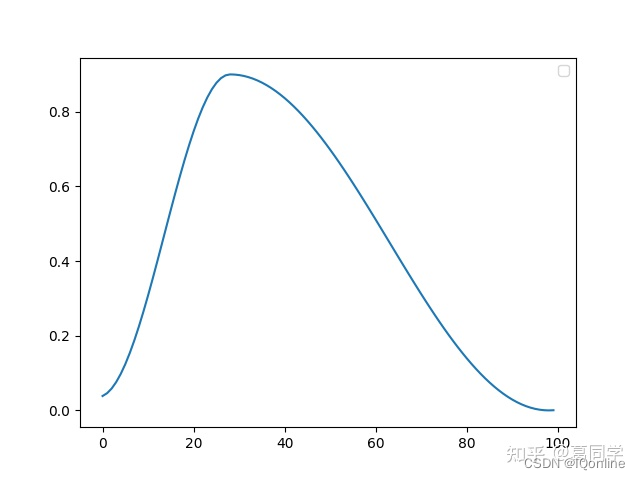

图片长下面这样。

学习率又会有一次升高回落的过程。

解决方法:

采用其他的学习率方法,如余弦退火,线性降低等。

在train.py中,将代码修改如下情况即可(采用了余弦退火,同时承接了上次one_cycle的学习率最小值),便于继续训练。

# Scheduler

if opt.linear_lr:

lf = lambda x: (1 - x / (epochs - 1)) * (1.0 - hyp['lrf']) + hyp['lrf'] # linear

else:

#lf = one_cycle(1, hyp['lrf'], epochs) # cosine 1->hyp['lrf']

lf = lambda x: ((1 + math.cos(x * math.pi / epochs)) / 2) * 0.1 + 0.005

scheduler = lr_scheduler.LambdaLR(optimizer, lr_lambda=lf) # plot_lr_scheduler(optimizer, scheduler, epochs)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

参考 :

OneCycleLR学习率的原理与使用

YOLOv5的Tricks | 【Trick6】学习率调整策略(One Cycle Policy、余弦退火等)

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签