- 1支持向量机(Support Vector Machine,SVM)之SMO算法及其Python实现_smo优化算法对svm多分类优化python代码

- 2【计算机网络】2、TCP:四次挥手与TIME_WAIT、shutdown() 优雅关闭 server、探活、拥塞窗口与 Nagle 算法、端口占用、tcp 的流式协议、可靠性_tcptimewait阶段进行中断abort

- 3一篇文章搞懂MySQL的分库分表,从拆分场景、目标评估、拆分方案、不停机迁移、一致性补偿等方面详细阐述MySQL数据库的分库分表方案_mysql分库分表

- 4SpringBoot + Vue实现Github第三方登录

- 5【安路科技FPGA】从流水灯入门(软件环境、vivado仿真、流水灯)_安路fpga教程

- 6知识图谱 vs GPT_知识图谱与gpt

- 7【JavaEE初阶】多线程 _ 进阶篇 _ 锁的优化、JUC的常用类、线程安全的集合类_java线程安全锁的粒度如何细化

- 8![rejected]master->master (non-fast-forward)![remote rejected] (deny updating a hidden ref)push报错解决

- 9解决MySQL错误:`ERROR 1049 (42000): Unknown database ‘nonexistentdb‘`_error 1049 (42000): unknown database 'nuoxu

- 10【C/C++】C语言runtime调用技术_c++ runtime

最大的开源大模型:马斯克的Grok-1可供企业商用_grok1.0

赞

踩

由马斯克xAI团队研发的最大的开源大语言模型Grok-1,从头开始训练的总参数量为314B(3140亿)的混合专家(MoE)模型,其规模超过ChatGPT-3.5,目前Grok背后代码和权重架构已全部开放上线在GitHub。

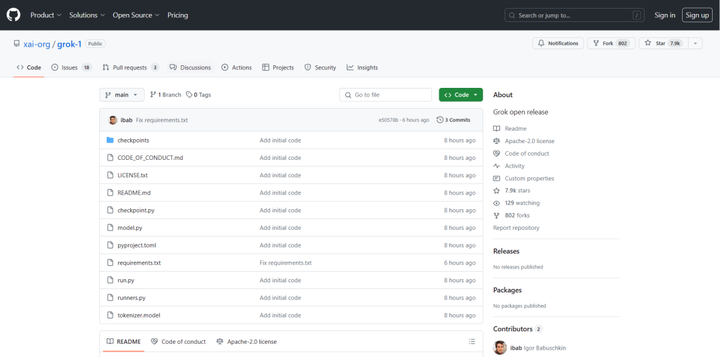

下载地址:https://github.com/xai-org/grok-1

Grok 1.0利用了定制的训练技术栈,在 JAX 和 Rust 的基础上从零开始构建。该模型在 2023 年 10 月完成预训练阶段时的基础模型数据,具有高达 314B 的模型参数数量。

Grok 1.0 采用了8个MoE,每一个数据单元由 2 位专家处理,嵌入向量的维度为 6144,并采用旋转式嵌入表示。此外,Grok 1.0 具有处理更长上下文信息的能力,最大序列长度为 8192 个数据单元。

值得注意的是,由于尚未对任何特定应用(如对话系统)进行微调,Grok 1.0 在处理特定任务时的表现可能不如一些专门为任务微调过的模型。根据 Apache 2.0 许可协议,现在公众可以自由访问模型的权重和架构,这为研究人员和开发者提供了更多探索和利用的机会。

xAI团队使用了一些旨在衡量数学和推理能力的标准机器学习基准对Grok-1进行了一系列评估。在MMLU、GSM8K等一系列的基准测试中,Grok-1显示出了超强的性能,胜过其计算类中的所有其他模型,包括ChatGPT-3.5和Inflection-1,但和Claude 2以及GPT-4仍有不小的差距。

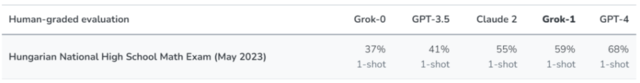

不过,xAI团队表示,由于这些基准数据可在网上找到,无法排除模型在这些数据上进行了无意的训练。因此,在收集完数据集后,根据去年 5 月底公布的 2023 年匈牙利全国高中数学期末考试题(数据截止日期之后),xAI 对他们的模型(包括 Grok 1.0、Claude-2 和 GPT-4)进行了人工评分。结果显示,Grok 1.0 和 Claude-2 都获得了 C 级(59% 和 55%),而 GPT-4 则以 B 级(68%)通过考试。xAI 表示,他们并没有为了迎接这次考试而特别准备或调整模型。

值得一提的是,Grok-1采用的是Apache 2.0 license,这意味着程序员、公司和科研机构可以将该模型的副本用于各种目的,包括商业应用。

由于模型规模较大,需要有足够GPU和内存的机器才能运行Grok。可能需要一台拥有628GB GPU、8块H100内存的服务器才能够支撑Grok的运行,目前英智未来已建立数千P不同规格的智算算力,包括RTX系列、HGX1系列等,程序员、公司和机构都可以租赁英智未来的智算算力,基于Grok-1等各种开源大模型用于各种AI应用程序,快速构建自己的AI应用产品。

尽管 Grok 1.0 还需要更多复杂的微调和优化,庞大的体量对计算资源的需求面临很多挑战,Grok的开源仍然是一个值得称赞的无私行为,也是迈向开源 AGI 的重要一步。伴随更多开源模型的发布,希望未来更多开发者加入人工智能行列,共同推动科技创新和发展。