- 1python语言程序设计 答案,python程序设计教程题库_python语言程序设计基础教程答案

- 2Coze在手,GPTs&DALLE免费用_coze账户

- 3LLaMA模型学习笔记_llama q k s

- 4大模型卷出白菜价的背后?听百度、阿里、腾讯、字节、小米等专家共话软件智能研发新实践..._阿里 算法 多云

- 5Mysql导出SQL脚本和导入SQL脚本_iade怎么导入sql脚本

- 6标定参数存取(C++、Python)

- 7推荐几个有深度的Java学习公众号

- 8CNN表情识别实例_表情识别的应用举例

- 9哪个版本的python最好用,python哪个版本好用知乎_python现在到哪个版本了

- 10深度学习的八大开源框架_开源深度学习框架

人工智能预测,蔚来汽车大模型,特斯拉自驾,AI反诈

赞

踩

1 推演人工智能的发展 | 3万字采访

与 Nat Friedman 和 Daniel Gross 推演人工智能的发展 | 3万字采访, Stratechery 3月

文章来自知名的“科技与商业战略” 博客 Stratechery, 作者是 Stratechery 的创办人 Ben Thompson

这篇文章的采访对象,Nat Friedman 和 Daniel Gross 是一对投资二人组,

他们很像是 “人工智能时代” 的 Marc Andreessen 和 Ben Horowitz,后者通过创办了 A16Z 在 2008 年之后成为了移动互联网时代硅谷的顶级投资人。

当农民们在18世纪( 1700年代 )挖井时意外发现了这座被埋葬的别墅,当他们在地下挖掘穿过墙壁和房间时,他们主要掠夺了不同的雕像和文物,

他们也发现了一组奇怪的灰色物体,一种碳化块(carbonized lumps ),原来是莎草卷轴( papyrus scrolls )

但其中的奥秘和难度在于这些留下的碳化古卷无法被打开。它们非常脆弱,我经历过这种情况,

如果你把莎草纸卷碳化并试图打开它,它们会在你手中碎成片,你无法阅读它们。试图打开它们的过程即会摧毁它们。

因此,自从 18 世纪被发现以来,已经有近 300 年的努力尝试打开和阅读这些文物。

丹尼尔和我决定启动一个项目,试图破解这个难题。

总的方法是在不打开和不损坏卷轴的情况下,对卷轴进行真正高分辨率的三维扫描(scan the scrolls at really high resolution in 3D without opening them )。

要做到这一点,需要使用粒子加速器 ( a particle accelerator ) 来获得非常高的分辨率,然后希望通过这些扫描,将这个问题简化为一个软件问题,在这个软件中,您可以使用计算机视觉和机器学习算法来虚拟地拆开和读取这些卷轴。

70 万美元的大奖颁给了一个团队,他们刚刚完成了这项具有里程碑意义的工作,他们能够展示一个卷轴的大部分内容并阅读出来。

我们有了 2000 个希腊文字符,这些字符以前从未被看到过,对世界来说是全新的。

视频和文本:

视频包含的信息要比文本多得多,并且我会认为,尤其是随着互联网的出现,捕捉和传播视频其实更便宜

当然,在文本中,也存在着分布的梯度,任何预训练过模型的人都会告诉你,大部分文本是无用的,

实际上,文本或视频中非常高质量的 tokens 数量很少。

在音乐中可能也是如此。这里存在一个有趣的帕累托分布( Pareto distribution )。

transformer 架构的神奇之处在于即使数据质量很糟糕,它也能工作。

高质量的 tokens 在某种程度上是一种存储计算的形式,所以我认为现在许多研究人员所做的数学工作是你可以花费数亿美元在 Nvidia 上,试图获得高度精细化的 tokens,或者你可以从人们那里获得它们,基本上需要对每个 token 的成本进行数学建模,以及计算其价值如何。

但是,理论上存在非常高价值的数据,你可以通过无限的计算资源来获得,但是你也可以绕过许多浮点运算,并且在某些专业领域仅通过从人类那里获取高质量信息就会更容易

在这个行业里,我们可以看到一个有趣的共识,那就是对于人类来说,视频绝对是注意力的层级顶端,它是最能抓住你的东西。

预测:

1. “超人般能力的推理实体” ( superhuman reasoning entity )是下一个大事件,

如果有人能够创造一种像人类一样,在他们选择的任何领域中主动推理,以及主动思考问题的东西,他们就会成为行业领军者。

这就像谷歌在过去创造出了 PageRank 算法一样,并且围绕这个技术打造了完整的产品,商业模式和价值观,最终一直领先于别人。

2. 对 Transformer / 大语言模型 / scaling law 的路径依赖是真实存在的,过去的计算机和互联网发展也有同样的路径依赖。

但是现在也有一些不是基于 transformer 架构的创新,一些正在被研究的有趣和有前途的领域也在发生,虽然你很难看明白。

3. 真正实现价值的方式和真正的差异化是通过一个产品,真正有价值的 “评估” 是用户的评价

2 蔚来汽车在 AI 和大模型领域的应用实践

辩证看待“幻觉”问题,蔚来汽车在AI和大模型领域的应用实践_企业动态_潘鹏举_InfoQ精选文章

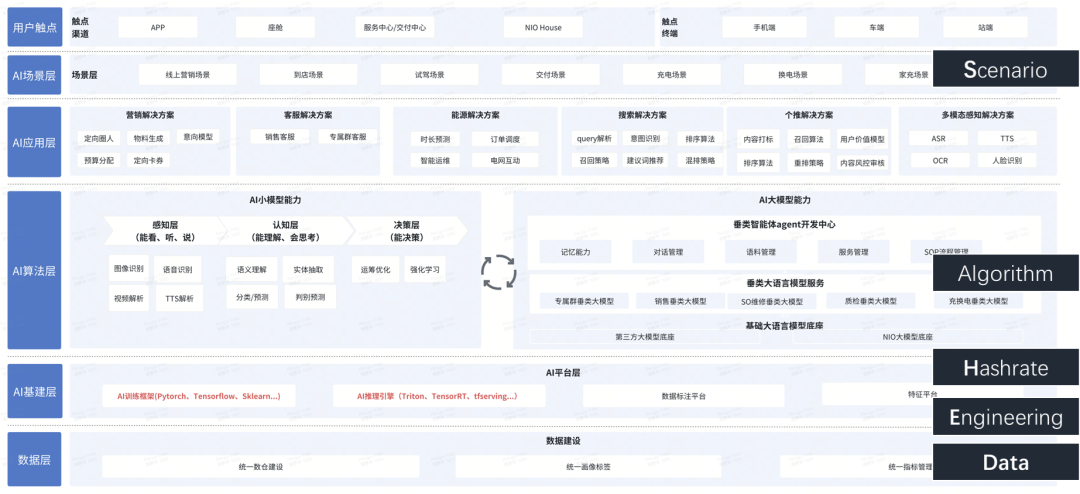

整体架构:

以开源大模型做基座,再结合公司的数据做垂类大模型的开发,整体架构包括基建层、模型层、开发层、应用层四个层面,重点支撑不同领域的垂类的大模型的开发和应用。

蔚来的人工智能应用分为 to B 和 to C 两大板块,本质上仍然是用人工智能为业务赋能,只是各个层面在赋能的程度上稍有不同,有偏向辅助的、有替代人工的、也有可以成为机器人的。

案例一:错峰充电

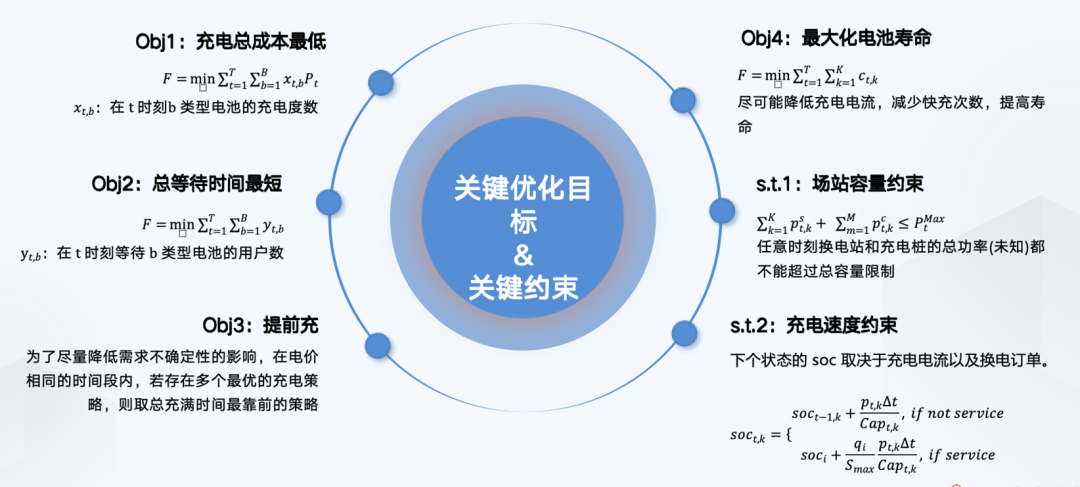

假设现在有两千多座换电站,一个换电站十块电池,那就有两万多块电池;一个换电站一天充一度电,那就是两万多块钱。

我们的实际成本比这个假设还要多得多,因此电费的成本巨大。那么有什么方法、机制和算法能够实现每一天的充电成本最小化呢?

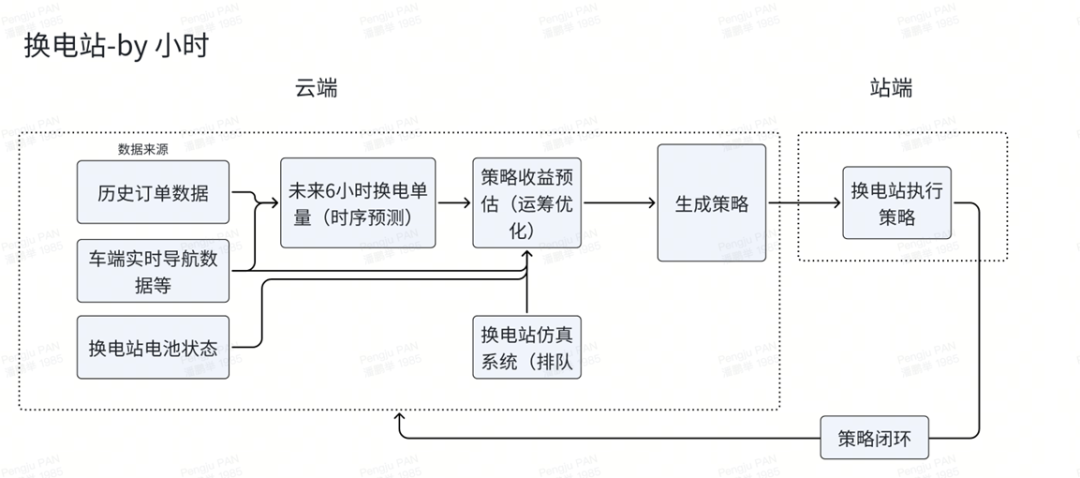

进行“错峰”的第一步是预测用户的需求订单。如果用户不来充电,换电站就可以少充甚至不充以节约成本。

首先要准确的预测用户什么时候来换电,才能进行何时充电、充多少电的决策。这一过程有很多约束条件,要在满足用户体验的前提下进行决策。

这个方案与智能驾驶的逻辑比较相像。第一,通过时序预测感知到用户的需求量。第二,用运筹优化算法计算充多少电能达到收益最大化。

最后,指令下发、决策和策略的执行。为了规避整个业务系统在诸多环节中出现的问题,我们还要通过一系列策略设计来实现流程闭环。

根据预测进行决策:

案例二:充换电智能运维

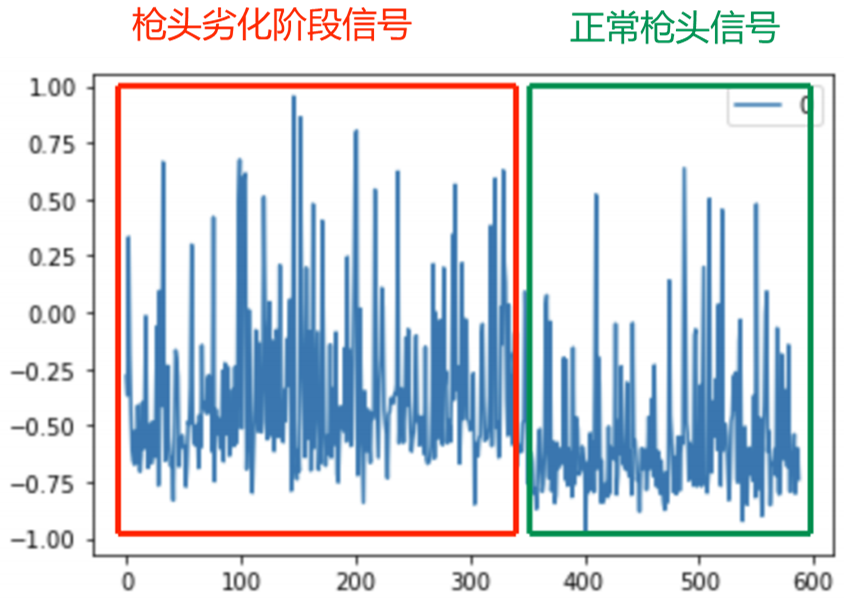

当充电枪长期使用后会出现劣化的情况,导致后续的用户跳枪或者无法充电,我们就需要对所有换电站和充电桩的每一个设备、每一个零件进行监测,以及时发现哪些枪头有劣化迹象,进而提升用户体验。

监测的方法有很多,比较传统的方法就是直接收集设备所处环境的温度、湿度等各方面影响因素的数据并进行预估,就能大致得出设备能否正常充电的结论了。

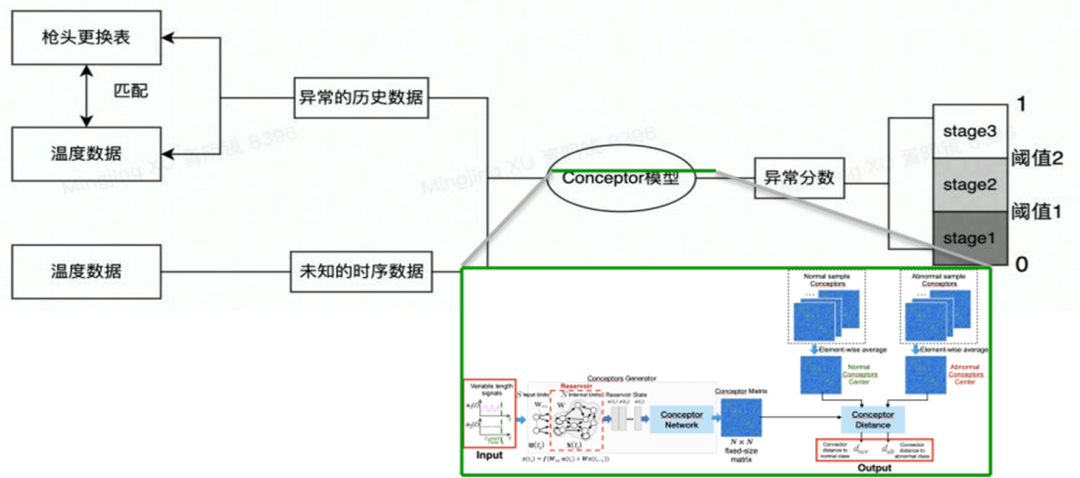

下面这张图展示的就是⼯业机理分析的结果,即根据充电枪的充电电流、电压、温度等物理信号建立物理模型得到枪头的温升系数物理量,并以此为信号进⾏故障诊断。

从结果来看这种机理模型其实也有一定效果,但正常枪头信号和异常枪头信号结果之间的差异不够显著。

把机理模型升级到基于 Conceptor-AI 算法检测模型 + 机理模型。这一方案其实并没有完全抛弃传统做法、只使用深度学习算法,

而是融合了人类经验知识与机器算法,最终使误报警数减少⾄20%

案例三:APP 个性化推荐

蔚来的 APP 内容本身很丰富,除了售车信息,还有汽车资讯、相关商品售卖、充电地图服务等等内容。

不同板块下的相关内容推荐的场景和入口都不相同,因为不同内容推荐对应的业务领域有不同目标。

比如对于资讯类内容,我们追求的是高点击率;对于商品,我们追求的是 GMV(商品交易总额)。

一个 APP 内要做很多场景、每个场景有不同的目标,针对这么多的场景,不形成一套系统就很难支撑这么多业务,

因此我们做的第一件事就是把个性化推荐的系统架构抽象出来。

我们把搜索和推荐合并为一套,而不是单纯只做推荐系统,这与搜索只存在于索引步骤的情形有区别。

第二件事是围绕业务背景对算法目标体系进行整体优化和提升。

通过一些非常简单的数据、用 1 到 2 个核心算法去解决所有业务场景的问题。

这是我们现在正在尝试的一个解法,即打通所有底层数据。

完成数据共通之后,我们在算法层面又引入了一个目前比较好的方法,即专家网络(MoE)。

在不同的业务场景里使用不同的专家网络去学习不同的权重,然后再做一些应用层,围绕最终业务目标,输出不同的业务指标,从而尽量降低整体维护的工作量。

场景化开发方式对每个业务人员的依赖度很高,会对不同业务领域有很强的业务理解。

可以用一些比较简单的数据和复杂的模型来解决下游推荐效果的问题提高整体迭代效率和输出成果。

3 端到端的人工智能==》特斯拉自动驾驶

特斯拉 FSD 以及 Robotaxi 业务做好准备

Robotaxi 的服务将介于 Uber 和 Airbnb 之间,特斯拉车主可以决定何时以及由谁使用他们的特斯拉汽车,并计划将打车服务无缝地融入特斯拉应用程序中。

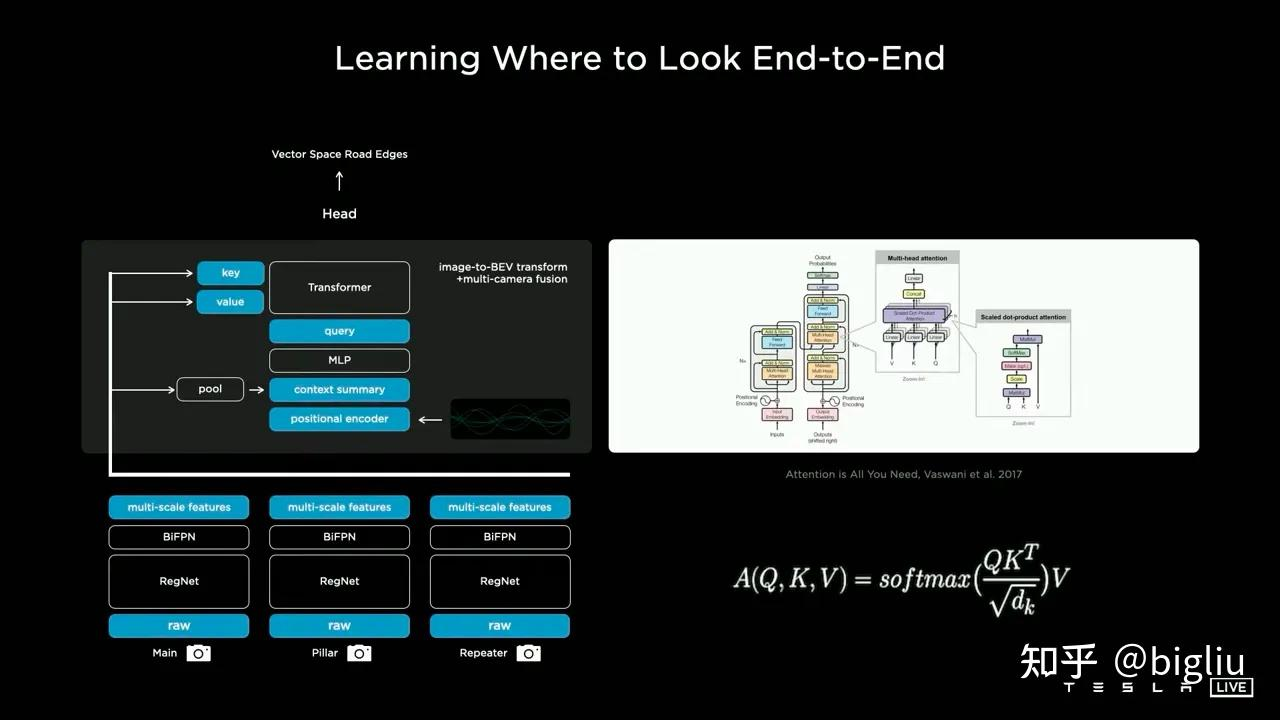

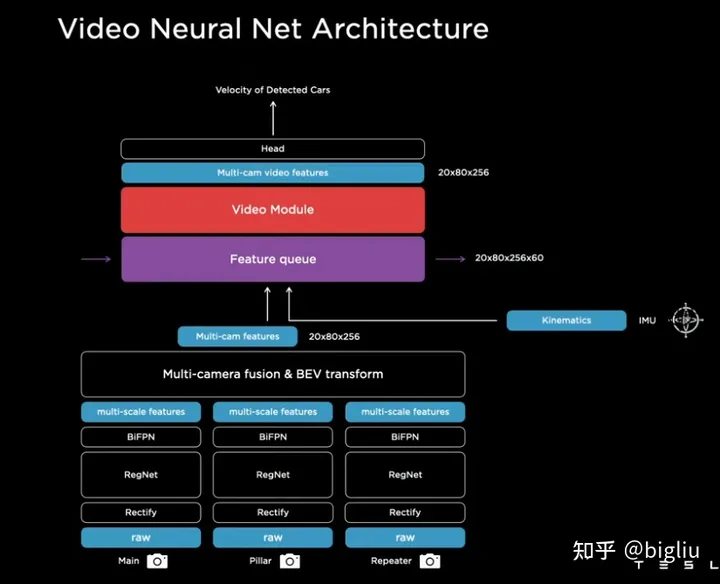

BEV架构:

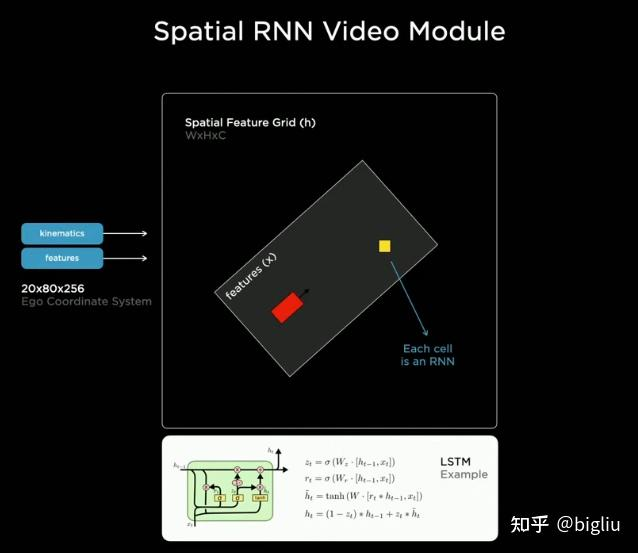

Tesla这套BEV感知方案同时实现了对空间域信息、时间域信息的融合

时序融合

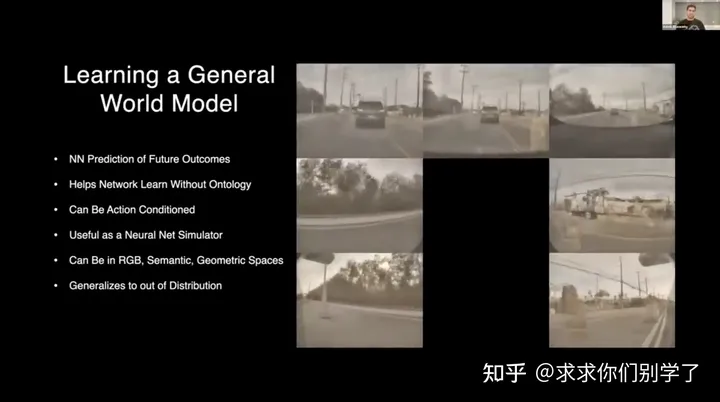

最新进化能力:世界模型

核心:过去的数据来生成未来的数据。也是在占用网络的基础上进行的。

目的:占据栅格网络很通用,但是有些东西也很难表达。所以学习一个更通用的模型来表示任意事物。(预测运动规律、物理规律等)

亮点:• 受到生成模型和扩散的启发。• 根据过去的场景和动作,对所有摄像机一致地以 3D 方式预测未来。

使用极其多样化的 3D 数据进行训练,RGB非常通用,可以从视频剪辑、YouTube。都可以用来训练通用的世界模型。

* 没有任何先验,让网络自己去理解深度和运动。

首先World Model生成的素材非常接近FSD实车采集的视频,可以看到生成图片与Tesla实车差不多,

都是Tesla特有的带滤镜的黄色调图像,这说明了Tesla World Model具备一定的传感器仿真能力,能够模拟一些传感器特性甚至是传感器缺陷。

Tesla生成的是多视角的视频,Ashok还特意提到生成的视频中车辆在跨视角的时候位置,速度,形状能保持相对稳定,

这说明了生成模型一定程度上的理解了相机间的几何布局以及物体经过的变化规律。

Tesla World Model不仅能够生成RGB空间图像,还能够生成类似标注的语义信息,而这既表明了这项技术未来被利用在标注数据生成的潜力,

也说明了模型具备了一定的对于语义的理解推演能力。

①Tesla可以做到多个摄像头同步联合预测。

②支持prompt嵌入,可以提出要求生成车辆直行或者对向车道视角的未来数据。

(同样的过去数据输入,不同prompt,生成符合要求的输出数据。这个还是挺震撼的)

-

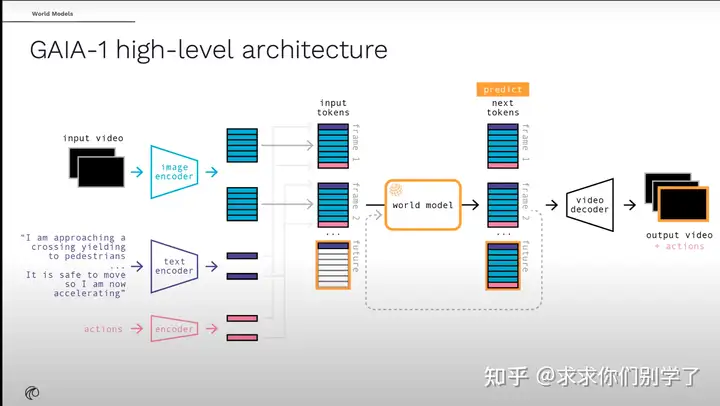

自监督的、自回归的世界模型。

-

利用视频、文本和动作输入来生成逼真的驾驶视频,并为自车行为和场景特征提供细粒度的控制。

-

学习到如何安全驾驶

-

世界模型想要通过视频,来尝试理解整个场景,对运动规律、物理规则去进行理解,无疑是非常困难的。

世界模型也不仅仅用于自动驾驶或者感知,这是个通用的人工智能。

如果能做得很好,或许我们将逐步踏入真正的人工智能时代。

-

目前的世界模型生成的未来数据效果还比较一般,在wayve展示的视频中,很多若隐若现,或者中途车辆不断变化的情况。

-

prompt大模型在自动驾驶的应用,可谓是未来可期。

未来的自动驾驶大模型一定是多模态的。

可以结合人类指令、导航地图信息(甚至给一张场景图片,chatgpt也能给出这个图片的潜在危险),这些都是可以辅助自动驾驶的。

-

世界模型训练还是挺耗时的。wayve的世界模型,需要在64张A100训练15天,有65亿参数。

视频解码模块也需要在32张A100训练15天,26亿参数量。

4 AI反诈

我们用机器学习模型协助打击不法行为_AI&大模型_褚杏娟_InfoQ精选文章

背景:

钱包、交易所被盗造成的产品损失并不鲜见,犯罪分子也常利用比特币、以太坊、USDT 作案,这些让人总觉得这个新生事物常和网络犯罪融合在一起,导致其被妖魔化。

为什么网络违法案件难破获?

他们通过深度伪造、语音合成等技术,制作逼真的视频通话或语音信息,诱使受害者上当受骗。

Web3 行业涉虚拟币的不法行为也呈现出增长态势。他们利用虚拟币的匿名性和去中心化特点,进行洗钱、贩毒、非法集资等不法活动。

传统 Web2 领域的黑灰产都是通过银行转账进行,需要身份验证,追查相对容易些,再加上很多银行都有反欺诈、反洗钱的基础设施模型,黑灰产难以在其中生存。

但在 Web3 的区块链领域则给大家打开了一个完全崭新的世界,其中没有什么监管,人人都是匿名,交易成本低但效率又很高,是黑灰产天然非常喜欢的环境。

其一,由于这类案件涉及的数据非常庞大且复杂,链上钱包生成免费且非常便捷,甚至有工具可以批量生成,因此犯罪分子会为了隐藏自己的资金和踪迹,批量生成钱包,并通过这些钱包互相转移资金。

这种方式效率很高,手续费也很低,相比传统银行金融体系的资金转移会便捷很多,从而形成了一个巨大复杂的交易结构网,侦察工作难度很高。

其二,来自区块链天然的匿名性。先前提到的钱包生成时不需要任何身份证明,所以我们即使找到了非常实锤的涉案地址,也是不知道背后的真实人员,

所以我们需要继续侦破,直到发现涉案的资金在某些环节被兑换成法定货币、进入银行体系,我们才能得知背后的真实人员。

突破口:

但也正因为整体数据量庞大,且需要非常精准地查找线索,也为机器学习、大数据的技术应用提供了非常好的土壤。

这也是我们的优势所在:利用大数据和机器学习对复杂交易网络进行分析识别并提升精准度。

为什么银行或支付宝这种金融机构不给资金上链,让它们可以被追溯?

我们所说的区块链是指公链,比如比特币链、以太坊链、波场链、币安智能链等。

公链秉承的是抗审核、匿名性和去中心化原则,这是和现实中金融机构所形成的银行网络完全隔离的两个世界。

如果一个金融机构想要将用户的资金上链,就需要将用户存放的法定货币一对一转换成链上的 USDC 稳定币或其他代币后,再进行上链。

这样一来,银行机构就行使了交易所的职责,但我国法律是禁止银行机构进行虚拟货币经营的,这种业务是违法的。

我国现在推行的电子人民币是将人民币变成电子货币,并在可监管的环境中更方便的使用,这种电子货币和公链的区块链是不同的。

Web3 的本质是利用去中心化的区块链技术,要求 App 开发商和钱包用户都对自己的行为承担更大的责任。

而 Web2 时代的滴滴、字节和各种银行等都是平台中心化的机构。

本质上,做平台就要承担平台上安全的责任,比如银行存款被盗是能得到赔付的,但 Web3 时代是没有的,钱包密钥自己保管,

如果被钓鱼或者胡乱签名导致资金被盗,那么你找不到一个中心化机构寻求赔付,甚至现实世界中都没有法律能够保护这些资产,这是最大的问题。

AI反诈团队

我们的 AI 系统有三个部分:数据平台(数据特征模块)、模型训练平台(负责训练模型),以及模型服务平台(部署 G 端应用的对接服务和一些自己微服务)。

这三个平台会应用于数据的探查阶段、模型的训练研究阶段,以及模型的部署使用阶段。

数据特征平台方面,算法领域的数据是非常重要的因素,我们将各个链上的数据接入到了我们的大数据平台上,

再进行各种数据的清洗和数据仓库的特征提取,从而保证数据的高可用性,另外还使用离线+实时数据来保证时效性。

数据训练平台方面,我们用来研发较大的神经网络模型和时序模型所需要的分布式计算资源及 GPU 资源,都会用到这个平台。

模型部署平台则是负责模型的部署和版本控制的平台,版本控制可以在模型预测错误时依然保证预测的时效性。

此外,我们还有监控系统,在模型指标等不达标时,及时对模型进行更新,从而保证模型的效果。

实现方式:

常用特征主要是交易相关,比如时间属性(高低频次、周期性等)、金额属性(大额或小额、是否是定时周转固定金额等)、交易行为特征(交易对象是否频繁、交易关系是否复杂等)。

具体来说,时间上我们采用的特征会包括地址、base 属性、创建时间、地址对的最大最小交易时间;

金额上有地址对之间的汇总交易金额、最大最小交易金额均值标准差等统计特征;

至于交易关系,特别是在波场链上,我们利用 TRX 激活关系的特征捕捉下游涉案金额的转入概率

图聚类模型其实基于一个确定的地址,比如案件中的路径归集地址,利用大数据平台向下开展更多的节点,从而形成一个网图数据,这样就可以用图聚类的方法圈选出一些涉案概率更大的地址。

简单来说,其实是借鉴 Facebook 或者 Twitter 这些社交媒体的思想,对用户进行聚类和兴趣社群的挖掘,同一个类簇可以理解为是在同一个兴趣圈子。

我们也是以交易为边进行兴趣爱好模式的挖掘,同一个聚类里的地址可能联系更为紧密、交互更为频繁。

除了圈选出类簇,我们还会在类簇的基础上对节点进行中心度计算,提取出一个团伙中更为重要或关键的核心地址。

我们后续在研究角色相关的挖掘或 role-based embedding 模型的角色建模时,也会用到图聚类,

比如同属跑分车队的两个地址可能之间没有联系,但在某些交易行为或模式上具备相似性,那我们就认为这两个地址较为相似。

图聚类最多的应用场景其实是社交网络的挖掘,筛选出相同兴趣爱好的用户;

其他也有生物医学方面的应用,比如药物关联度的挖掘,将老药混合构建出新药并用于抵抗当前的某种疾病,

这种其实也是以药物为节点做向量化 embedding 和图聚类,

圈选出哪些药物的某种特性下在某些生物反应上会有相同的模式;

金融行业的下游分析、犯罪团伙分析或金融上交易模式的研究,都可以有所应用;

交通类则可以联合时序分析和图聚类,对交通生活进行类似的挖掘探索。

加入大模型能力:

首先是模型的选择。我们在体验了一些法律领域的大模型,如 LawGPT、ChatLaw 等后,总体感觉和通用的 ChatGLM 差不多,即使 ChatLaw 在交易方面相对更好,也因为其没有开源的预训练参数,导致我们无法直接使用。LawGPT 在法律方面的问题回答表现不错,但其检索问答的能力是借助的 RAG(检索增强式问题生成),其效果不如 ChatGLM 通用大模型。

此外,当时虽然也有 ChatGLM 的二代模型,但其架构上大体没有变化,只是支持更快的推理速度和更长的上下文,再加上当时对一代的模型应用更多,我们最终选择直接部署一代 ChatGLM。当然,我们后续也陆续更新到了目前最新的模型 ChatGLM 3。

再说工具的选择。我们考虑过 LangChain、LlamaIndex,以及国内的 FastGPT,但这些工具的集成度相对较高,且没有集成向量数据库功能,因此我们直接自己搭建了一套框架,在 RAG 中了添加数据清洗、判例文档核心句子提取、意图识别等自定义环节,也搭建了用于检索的向量数据库。

从模型分工来说,ChatLaw-Text2Vec 和 ChatGLM 在架构中是串行进行的;

ChatLaw-Text2Vec 负责检索,将用户输入的问题转变为向量,再从向量数据库中检索出和用户问题语义相似度较高的法律判例文档,最后将问题和检索到的文档一同作为 instruction 输入到 ChatGLM 中,从而实现问题问答,类似于将原先的开放式大题变成了选择题或阅读理解题目。

再说基座模型和垂直模型的混合应用,ChatLaw-Text2Vec 是专门针对法律问答方向的向量化 embedding 模型,使用了 90 多万条高质量中文法律问答的句子对作为训练数据,天然适合法律领域的问答语义相似度计算。

我们也尝试过其他如 Text2Vec 模型,但在法律场景中的表现均逊于 ChatLaw-Text2Vec,因此,我们最终的检索模型使用了垂直领域的 Text2Vec,但问答还是采用通用的 ChatGLM。

5 半年涨粉1000万,这个AI聊天搭子是怎么火的

最近,很多快手用户都能发现,一个名叫「AI小快」的账号格外活跃。

在视频作品的评论区,经常有人跟「AI小快」聊得火热,一个抛梗、一个接梗:

AI小快在 2023 年 10 月底就开通了快手账号。到 2024 年 4 月,才不过半年,AI小快的粉丝就突破了 1000W,也算是快手平台上的「头部网红」了。

目前,平均每天都有超过百万的快手用户,在评论区通过一个「@」呼唤 AI小快。看 AI小快的回复,也成为了很多人点开评论区的动力之一。

具体来说,能说会画的「AI小快」背后,是两个快手从零到一独立自主研发的大模型:大语言模型「快意」和文生图大模型「可图」。

「快意」是快手大模型团队自主研发的大语言模型,能够实现高效的自然语言理解和文本生成,为复杂的知识问答、文案创作、实时翻译、逻辑推理,以及代码编写与分析等任务提供强大支持。

自去年 8 月份快手发布自研大语言模型「快意」(KwaiYii)-13B 版本以来,半年内快手又相继研发了 66B、175B 版本的大模型,用以适配不同的业务场景的需求。

经过数万亿 Tokens 训练的快意大模型在 MMLU、C-Eval 等中英文权威榜单上均取得了行业领先的成绩,在实际用户体验和反馈中可以看到,快意 175B 的模型效果已显著超越了 ChatGPT-3.5,并达到了接近 GPT-4 的水平。

AI小快在快意大模型基础上注入了情感陪伴能力,让用户在与 AI小快沟通过程中,不仅能够收获有用的信息,而且能够让聊天变得有趣,给用户提供长期的情绪价值。

AI小快文生图和 AI 扩图的能力,则来源于快手自研的文生图大模型「可图」(Kolors)。

该模型的参数规模达十亿级,基于来自开源社区、内部构建和自研 AI 技术合成的数十亿的图文数据训练实现,这些数据覆盖了常见的千万级中文实体概念,兼具世界知识。

在智能化生产方面,视频 AIGC 产品「盘古」推动获客成本同比降低 62%、数字人直播 AIGC 产品「女娲」转化率接近客户真人水平;

在智能投放方面,通过大模型的挖掘和推理实现了用户和广告主的精准匹配,自动投放与非自动投放相比,单计划 ARPU 值提升 196%,助力优质商家的 GMV 增长了 30%。

此外,快手提供的智能客服、私信等工具,已经通过智能机器人实现 24 小时自动多轮互动,帮助企业实时把咨询变为线索再变为留资,双聊率提升至真人水平的 4 倍。

6 Ian Macartney分享:本地运行一个AI小镇!

本地运行一个AI小镇,由llama3提供支持

无需云端注册。创建你自己的世界,然后与之对话:)

在本地运行开源的@convex_dev后端。

在本地使用@ollama或在云端使用@togethercompute的大语言模型。

AI Town 是一个虚拟小镇,AI 角色在这里生活、聊天和社交。

demo 地址:AI Town

该项目是一个可部署的入门套件,用于轻松构建和自定义您自己的 AI town 版本。

灵感来自研究论文《生成代理:人类行为的交互式模拟》

https://arxiv.org/pdf/2304.03442.pdf

这个项目的主要目标,不仅仅是工作的乐趣,是提供一个具有坚实基础的平台,旨在扩展。

后端原生支持共享的全局状态、事务和模拟引擎,应该适用于从简单的项目到可扩展的多人游戏的所有内容。

第二个目标是使 JS/TS 框架可用,因为这个空间中的大多数模拟器(包括上面的原始论文)都是用 Python 编写的。

本地可基于Ollama运行

UI开发基于Pixel Art GUI Elements by Mounir Tohami

项目中组件的所有交互、背景音乐和渲染均由 PixiJS 提供支持。

PixiJS | The HTML5 Creation Engine | PixiJS

静态资源库: ansimuz

这个开源项目参考的项目:https://github.com/pierpo/phaser3-simple-rpg

-

Tilesheet::

-

16x16 Game Assets | OpenGameArt.org by George Bailey

-

16x16 RPG Tileset | OpenGameArt.org by hilau

-

-

Convex 是一个托管的后端平台,具有内置数据库,可让您在 TypeScript 中编写数据库架构和服务器函数。

-

服务器端数据库查询会自动缓存和订阅数据,为我们的 React 客户端中的实时 useQuery 钩子提供支持。还有 Python、Rust、ReactNative 和 Node 的客户端,以及一个简单的 HTTP API。

-

该数据库支持具有选择加入架构验证、关系和自定义索引(包括嵌套对象中的字段)的 NoSQL 样式文档。

-

query 和 mutation 服务器函数对数据库具有事务性、低延迟的访问,并利用我们的 v8 运行时和确定性护栏来提供市场上最强的 ACID 保证:即时一致性、可序列化隔离以及通过乐观的多版本并发控制 (OCC/MVCC) 自动解决冲突。

-

action 服务器函数可以访问外部 API,并在优化的 v8 运行时或更灵活 node 的运行时中启用其他副作用和非确定性。

-

函数可以通过调度和 cron 作业在后台运行

-

有用于响应式分页、文件存储、响应式文本搜索、矢量搜索、https 端点(用于 Webhook)、快照导入/导出、流式导入/导出以及函数参数和数据库数据的运行时验证的内置功能。

https://x.com/ianmacartney/status/1783692386994110884

7 AI产品

Wonderplan 是一个基于 AI 的创新型旅行规划工具,通过博客/视频转换、互动对话、日历微调等来帮助用户轻松规划和定制独特有趣的旅行计划,

同时还提供全球旅行见解总结,让旅行规划变得更加轻松高效。

https://beta.wonderplan.ai/

Langfuse 是一款开源的观测性和分析平台,专门为开发者打造,以满足大语言模型(LLM)应用程序的需求。它提供了跟踪、评估、数据管理、指标分析、提示管理等一系列功能,帮助工程师更好地监控、优化和管理其LLM应用。

https://langfuse.com/

ScrapeGraphAI: 爬虫库,使用LLM自动爬取

ScrapeGraphAI:只需爬取一次

ScrapeGraphAI 是一个网络爬虫 Python 库,它使用大型语言模型(LLM)为网站、文档和 XML 文件创建爬取流水线。

只需说明你想提取哪些信息,该库就会为你完成!

https://github.com/VinciGit00/Scrapegraph-ai

Notta Showcase

Notta 专注于开发 AI 驱动的视频翻译工具,其主打产品 Notta Showcase 旨在帮助企业、内容创作者和

教育工作者更便捷和经济高效地实现视频内容的多语言本地化,突破语言障碍,使视频内容能够更广泛地传播和被观众接受。

该工具支持多种主要语言的自动翻译,能保留原声说话人的声音效果,并自动生成字幕,为用户提供一种简单实用的视频翻译解决方案,满足他们面向全球用户的需求。

https://www.notta.ai/en/showcase

Moobius.app

我们的产品是23年9月份正式上线,第一批用户在中国。

上线三个月后,我们就到美国去找机会。

上线之初是通过线上的方式获得了一批美国的华人用户,然后在今年3月份左右的时候,

正式在stanford这边发布,我们有一个非常给力的go to market的合伙人。

现在我们在stanford有一些用户,并且在试图做的更大,我们的核心场景就是用AI重新定义群聊!

Midreal.ai

·Midreal是一个AI故事互动的平台。你只要输入你内心中想要的一个想法,

比如说我今天想和taylor swift的约会。接下来你就能体验一场图文互动的小冒险。

我们从去年10月上线到今年年初一直在discord里面积累了大约2万名的内测用户。

一个月前,我们迁移到了web平台,现在大约加起来总共十万的用户,我们一直在面向海外的用户群。

我们这次更多的面向的是C端的18到35的充满幻想的,喜欢读小说的、看故事、玩AI的这批人。