- 1Androidstudio ADB调试_andriod studio canary11 adb 调试

- 2通过mac电脑将macos系统的dmg镜像转换为iso文件,供VMware安装mac系统_dmg转iso

- 3自动驾驶合集5

- 4【免费】如何考取HarmonyOS应用开发者基础认证和高级认证(详细教程)_华为开发者认证考试在哪里打开

- 5CodeWhisperer--手把手教你使用一个十分强大的工具_coderormer

- 6Android性能优化系列之Bitmap图片优化_android 列表获取封面 bitmapfactory.decodebytearray 太卡

- 7使用 python nltk 库对预料库进行自动词性标注_怎么利用nltk进行词性标注要把语料放哪里

- 8BERT_论文解析_bert 论文

- 9VUE点击切换样式_vue ul li 文本内容样式

- 10pycharm中的terminal运行前面的PS如何修改成自己环境_terminal里面ps怎么换成base

ControlNet 1.1重磅发布,14个模型全部开源!_controlnet模型

赞

踩

来源:https://github.com/lllyasviel/ControlNet-v1-1-nightly

ControlNet 1.1 与 ControlNet 1.0 具有完全相同的体系结构,ControlNet 1.1 包括所有以前的模型,具有改进的稳健性和结果质量,并添加了几个新模型。

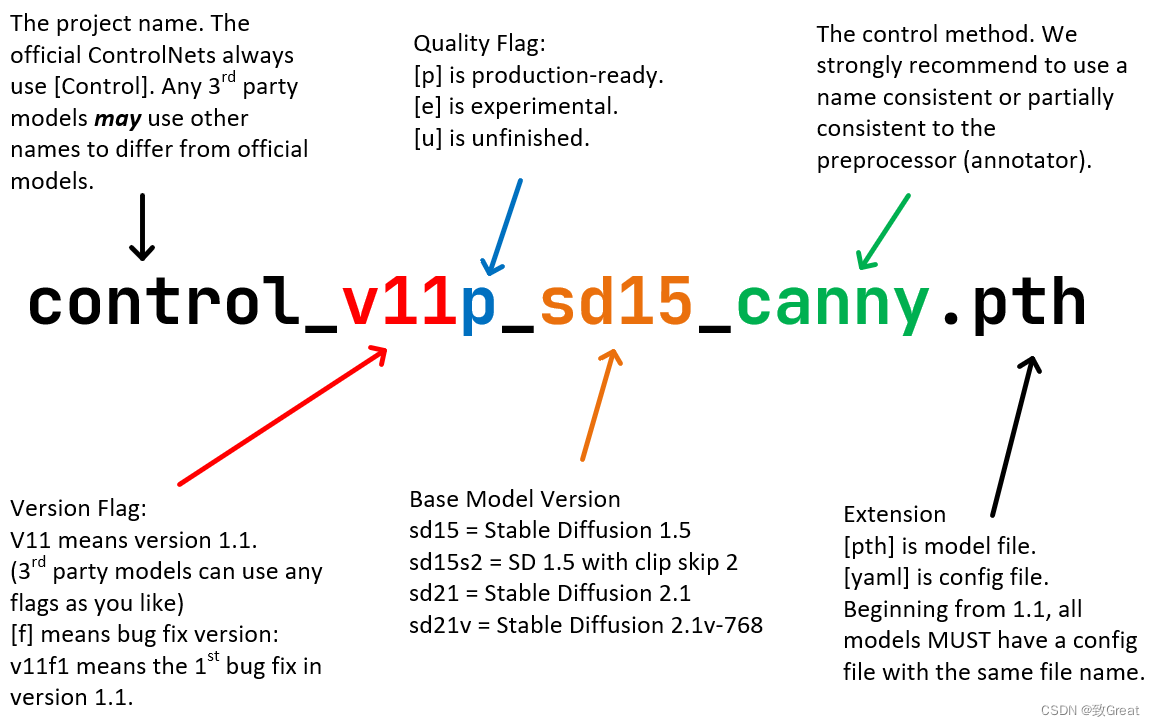

模型命名规则更新

从 ControlNet 1.1 开始,我们开始使用标准 ControlNet 命名规则 (SCNNRs) 来命名所有模型,作者希望这个命名规则能够提升用户体验。

ControlNet 1.1 包括 14 个模型(11 个生产就绪模型、2 个实验模型和 1 个未完成模型):

control_v11p_sd15_canny

control_v11p_sd15_mlsd

control_v11f1p_sd15_depth

control_v11p_sd15_normalbae

control_v11p_sd15_seg

control_v11p_sd15_inpaint

control_v11p_sd15_lineart

control_v11p_sd15s2_lineart_anime

control_v11p_sd15_openpose

control_v11p_sd15_scribble

control_v11p_sd15_softedge

control_v11e_sd15_shuffle

control_v11e_sd15_ip2p

control_v11u_sd15_tile

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

模型下载地址:https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main

ControlNet 1.1 Depth

模型文件:

Model file: control_v11f1p_sd15_depth.pth

Config file: control_v11f1p_sd15_depth.yaml

- 1

- 2

模型效果:

Depth1.1 的改进:

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于数据处理脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

- 新的深度模型是一个相对无偏的模型。它没有通过某种特定的深度估计方法以某种特定类型的深度进行训练。它不会过度适合一个预处理器。这意味着该模型将在不同的深度估计、不同的预处理器分辨率甚至 3D 引擎创建的真实深度下更好地工作。

- 一些合理的数据增强应用于训练,如随机左右翻转。

- 该模型从深度 1.0 恢复,它应该在深度 1.0 运行良好的所有情况下运行良好。Depth 1.1 在 depth 1.0 的许多失败案例中效果很好。

- 如果使用具有 384 预处理器分辨率的 Midas 深度(webui 插件中的“深度”),则深度 1.0 和 1.1 之间的差异应该很小。但是,如果尝试其他预处理器分辨率或其他预处理器(如 leres 和 zoe),深度 1.1 预计会比 1.0 好一点。

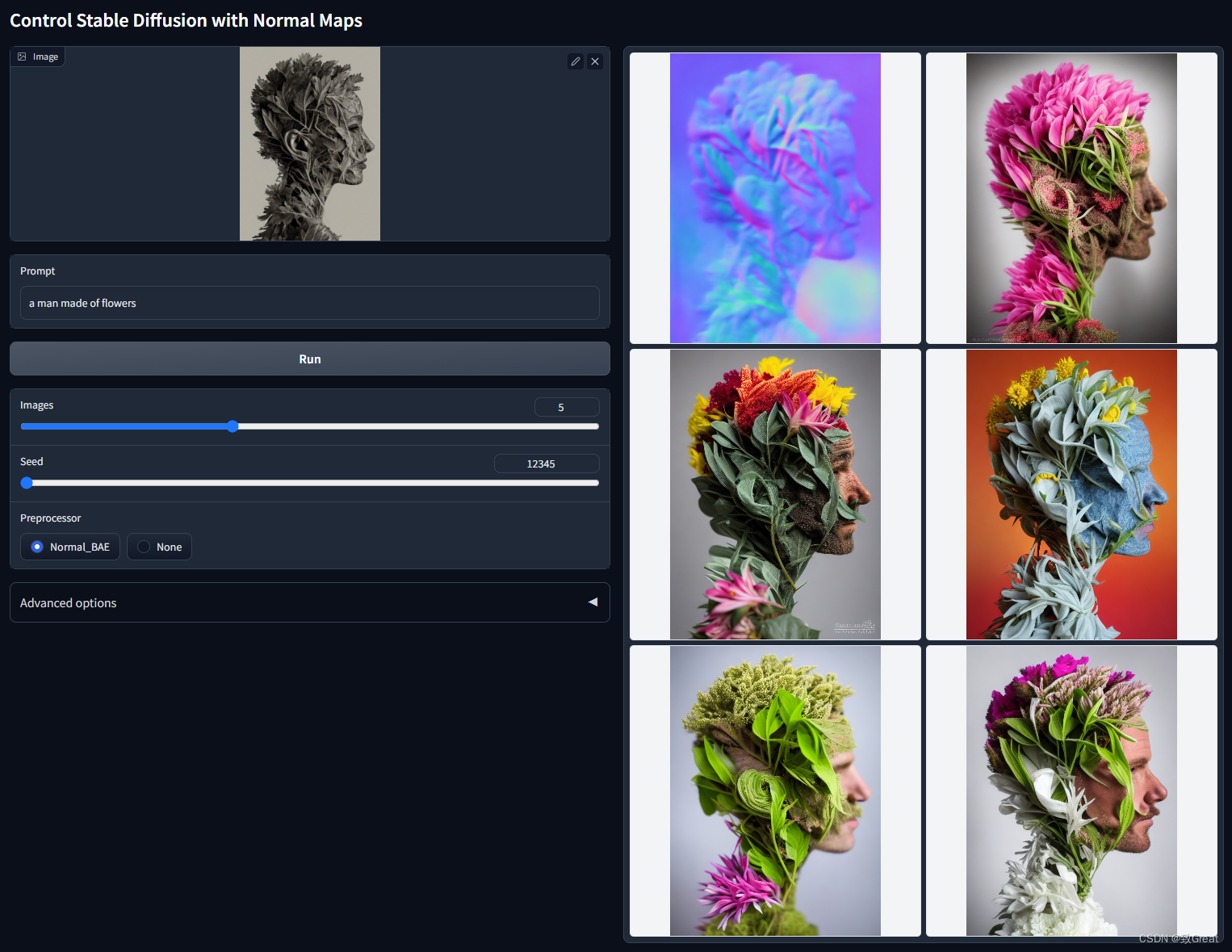

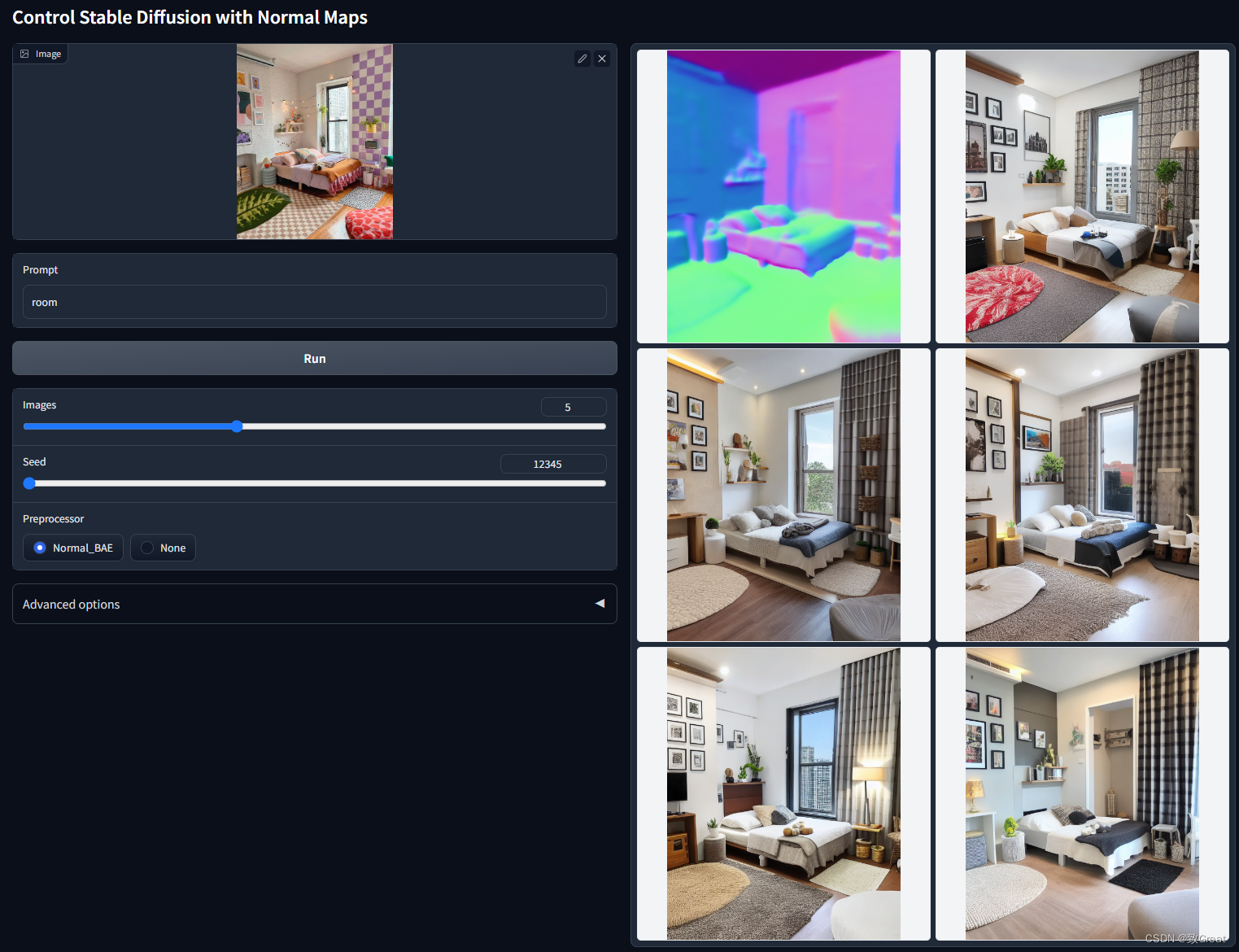

ControlNet 1.1 Normal

模型文件:

Model file: control_v11p_sd15_normalbae.pth

Config file: control_v11p_sd15_normalbae.yaml

- 1

- 2

Normal 1.1 的改进:

- Normal 1.0 中的 normal-from-midas 方法既不合理也不正确。该方法在许多图像中效果不佳。法线 1.0 模型无法解释渲染引擎创建的真实法线贴图。

- 这个 Normal 1.1 更合理,因为预处理器经过训练可以使用相对正确的协议(NYU-V2 的可视化方法)来估计法线贴图。这意味着法线 1.1 可以解释来自渲染引擎的真实法线贴图,只要颜色正确(蓝色在前面,红色在左边,绿色在上面)。

- 在测试中,这个模型更加健壮的,可以达到与深度模型相似的性能。在之前的 CNET 1.0 中,Normal 1.0 并不是很常用。但是这个 Normal 2.0 有了很大的改进,并且有可能被更频繁地使用。

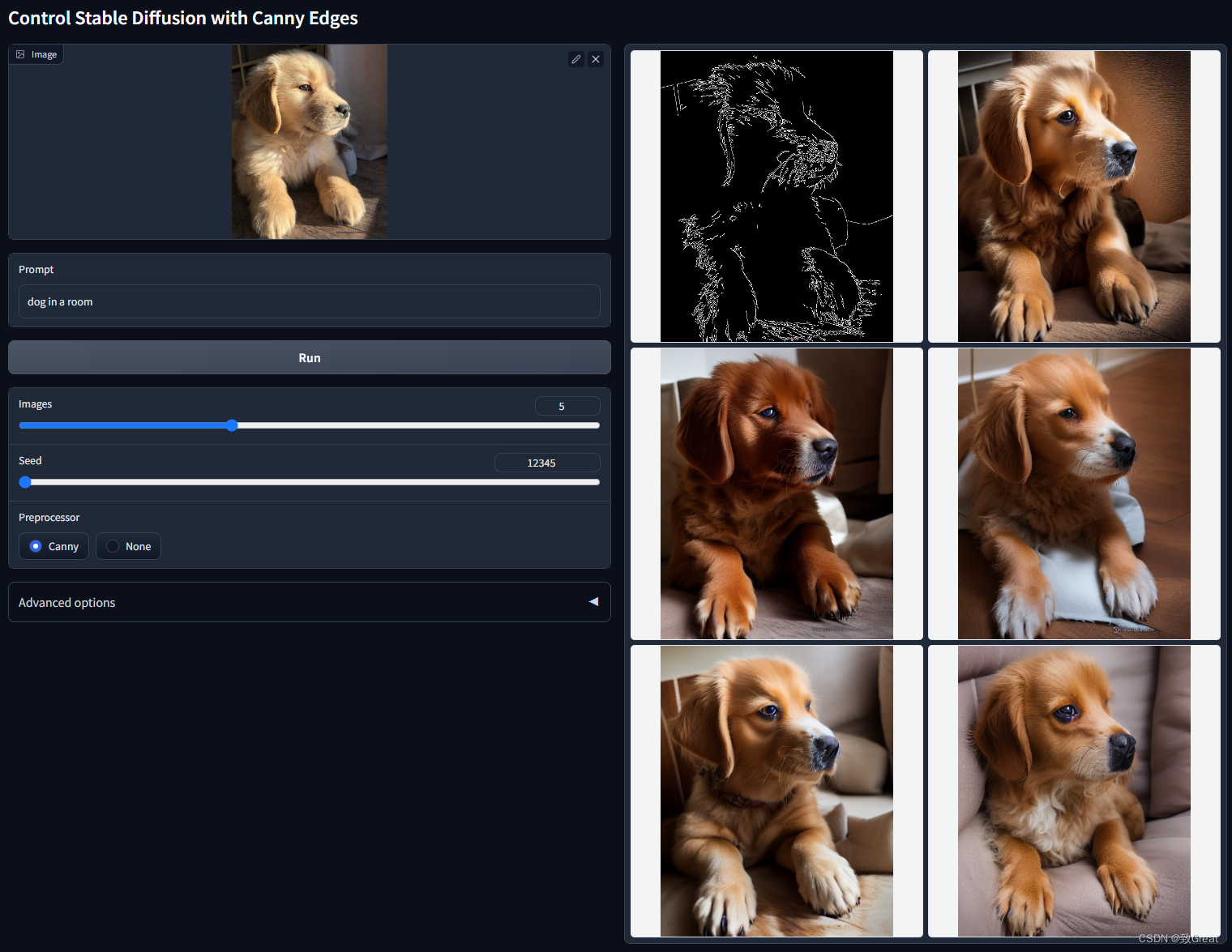

ControlNet 1.1 Canny

模型文件:

Model file: control_v11p_sd15_canny.pth

Config file: control_v11p_sd15_canny.yaml

- 1

- 2

Canny 1.1 的改进:

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于我们数据处理脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

- 因为 Canny 模型是最重要的(也许是最常用的)ControlNet 模型之一,所以我们用一个基金在一台机器上用 8 块 Nvidia A100 80G batchsize 8×32=256 训练了 3 天,花费 72×30= 2160 美元(8 个 A100 80G,每小时 30 美元)。该模型从 Canny 1.0 恢复。

- 一些合理的数据增强应用于训练,如随机左右翻转。

- 尽管很难评估 ControlNet,但我们发现 Canny 1.1 比 Canny 1.0 更健壮,视觉质量也更高。

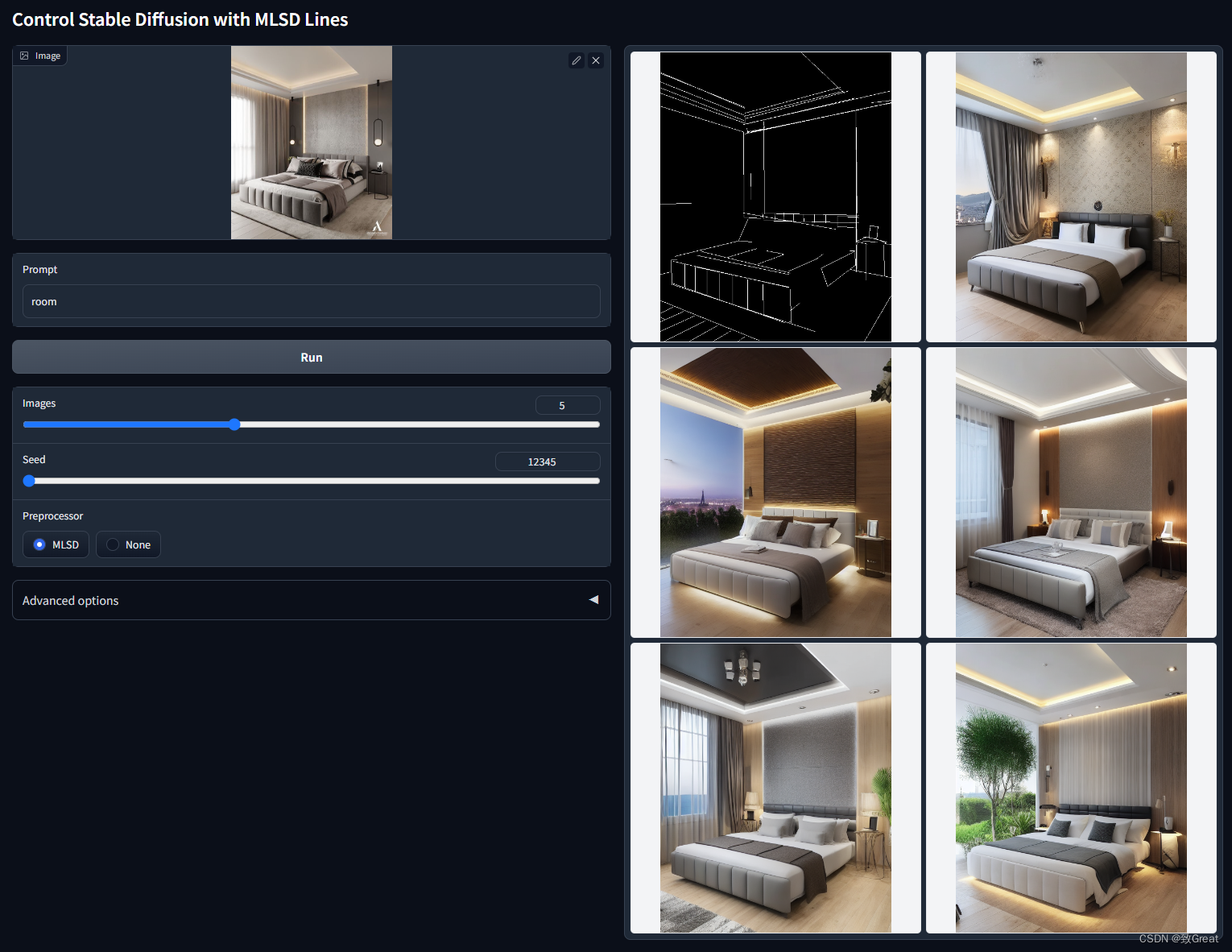

ControlNet 1.1 MLSD

Model file: control_v11p_sd15_mlsd.pth

Config file: control_v11p_sd15_mlsd.yaml

- 1

- 2

MLSD 1.1 的改进:

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于我们数据处理3. 脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

- 通过使用 MLSD 查找其中包含超过 16 条直线的图像,增加了 300K 个图像,从而扩大了训练数据集。

- 一些合理的数据增强应用于训练,如随机左右翻转。

- 从 MLSD 1.0 恢复并继续使用 A100 80G 的 200 GPU 小时进行训练。

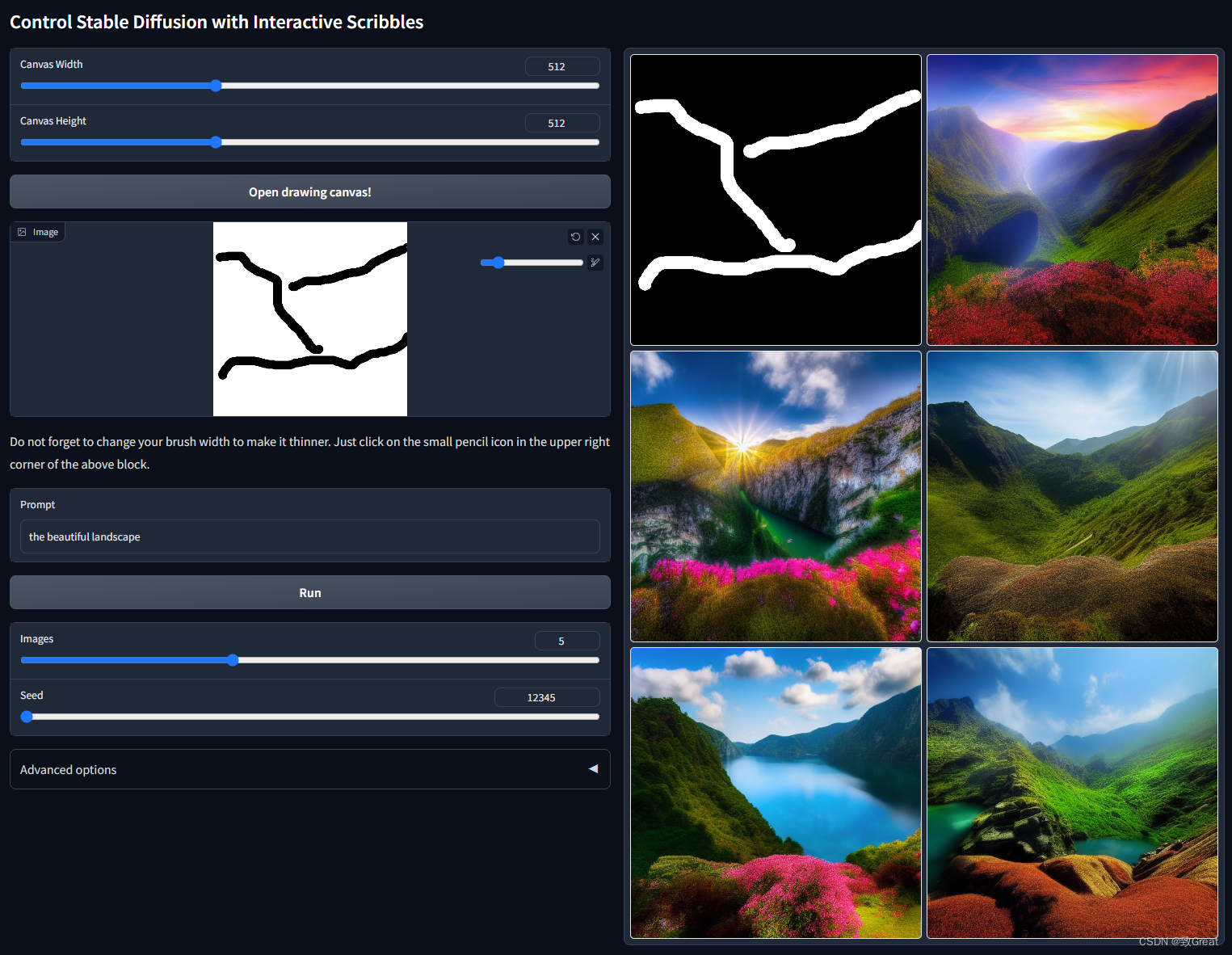

ControlNet 1.1 Scribble

Model file: control_v11p_sd15_scribble.pth

Config file: control_v11p_sd15_scribble.yaml

- 1

- 2

Scribble 1.1 的改进:

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于我们数据处理脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

- 发现用户有时喜欢画很粗的涂鸦。因此,我们使用更积极的随机形态变换来合成涂鸦。即使涂鸦相对较粗(训练数据的最大宽度为 512 画布中的 24 像素宽度的涂鸦,但即使对于更宽的涂鸦,它似乎也能正常工作;最小宽度为 1 像素,此模型应该也能正常工作).

- 从 Scribble 1.0 恢复,继续使用 A100 80G 的 200 GPU 小时。

ControlNet 1.1 Soft Edge

模型文件:

Model file: control_v11p_sd15_softedge.pth

Config file: control_v11p_sd15_softedge.yaml

- 1

- 2

模型效果:

ControlNet 1.1 中的新功能:现在我们添加了一种名为“SoftEdge_safe”的新型软边缘。这是因为 HED 或 PIDI 倾向于在软估计中隐藏原始图像的损坏灰度版本,而这种隐藏模式会分散 ControlNet 的注意力,从而导致不良结果。解决方案是使用预处理将边缘图量化为多个级别,以便完全删除隐藏的模式

Soft Edge 1.1 的改进:

- Soft Edge 1.1 在以前的 ControlNet 中称为 HED 1.0。

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于我们数据处理脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

- Soft Edge 1.1 明显(几乎 100% 的情况下)优于 HED 1.0。这主要是因为 HED 或 PIDI 估计器倾向于将损坏的原始图像的灰度版本隐藏在软边缘图中,而之前的模型 HED 1.0 过度拟合以恢复隐藏的损坏图像而不是执行边界感知扩散。Soft Edge 1.1 的训练使用了 75% 的“安全”过滤来去除此类隐藏的损坏灰度图像内部控制图。这使得 Soft Edge 1.1 非常强大。在实际测试中,Soft Edge 1.1 与深度模型一样可用,并且有可能被更频繁地使用。

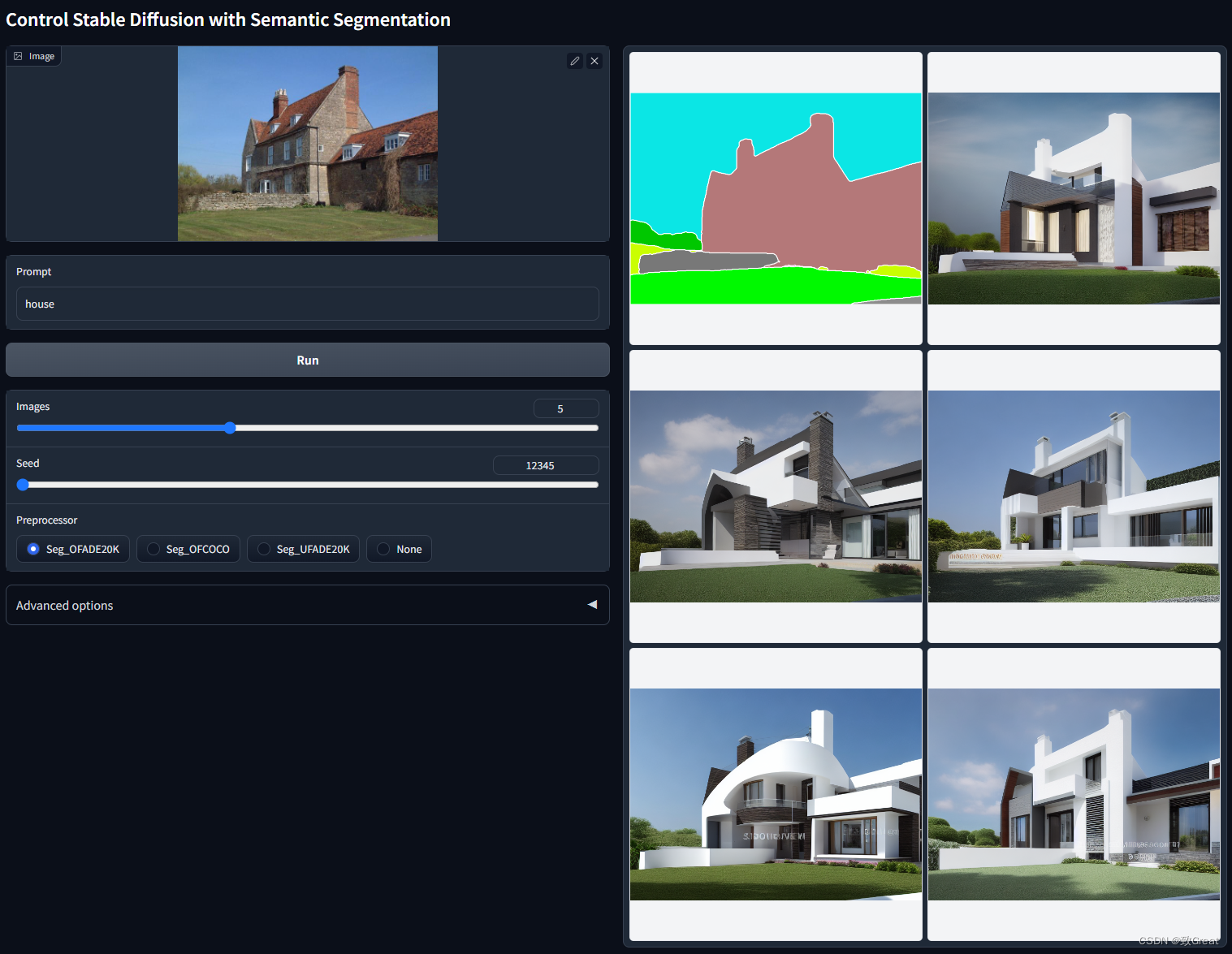

ControlNet 1.1 Segmentation

模型文件:

Model file: control_v11p_sd15_seg.pth

Config file: control_v11p_sd15_seg.yaml

- 1

- 2

模型效果:

Segmentation 1.1: 的改进:

- 支持 COCO 协议。之前的Segmentation 1.0支持大约150种颜色,但是Segmentation 1.1支持coco另外182种颜色。

- 从分段 1.0 恢复。所有以前的输入应该仍然有效。

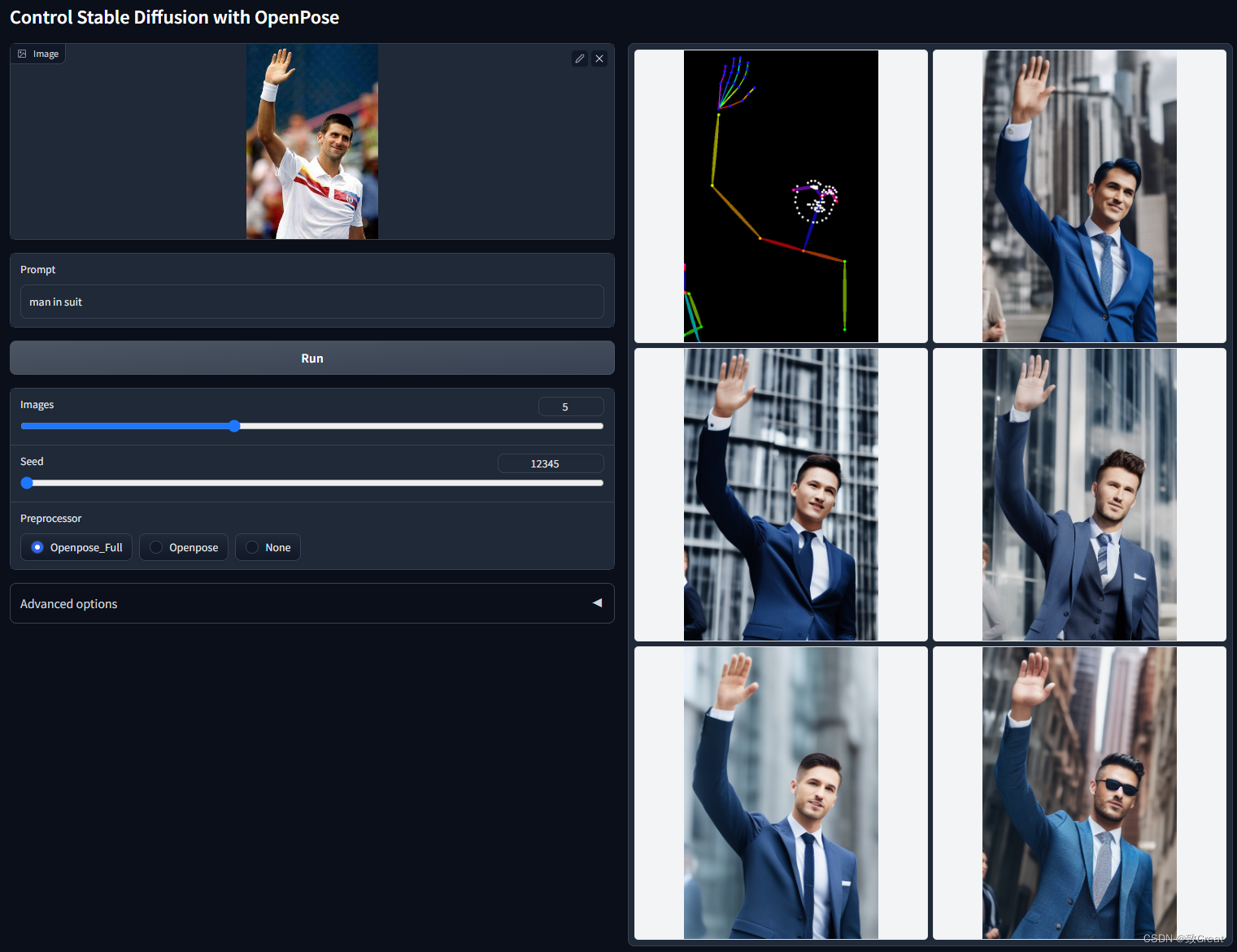

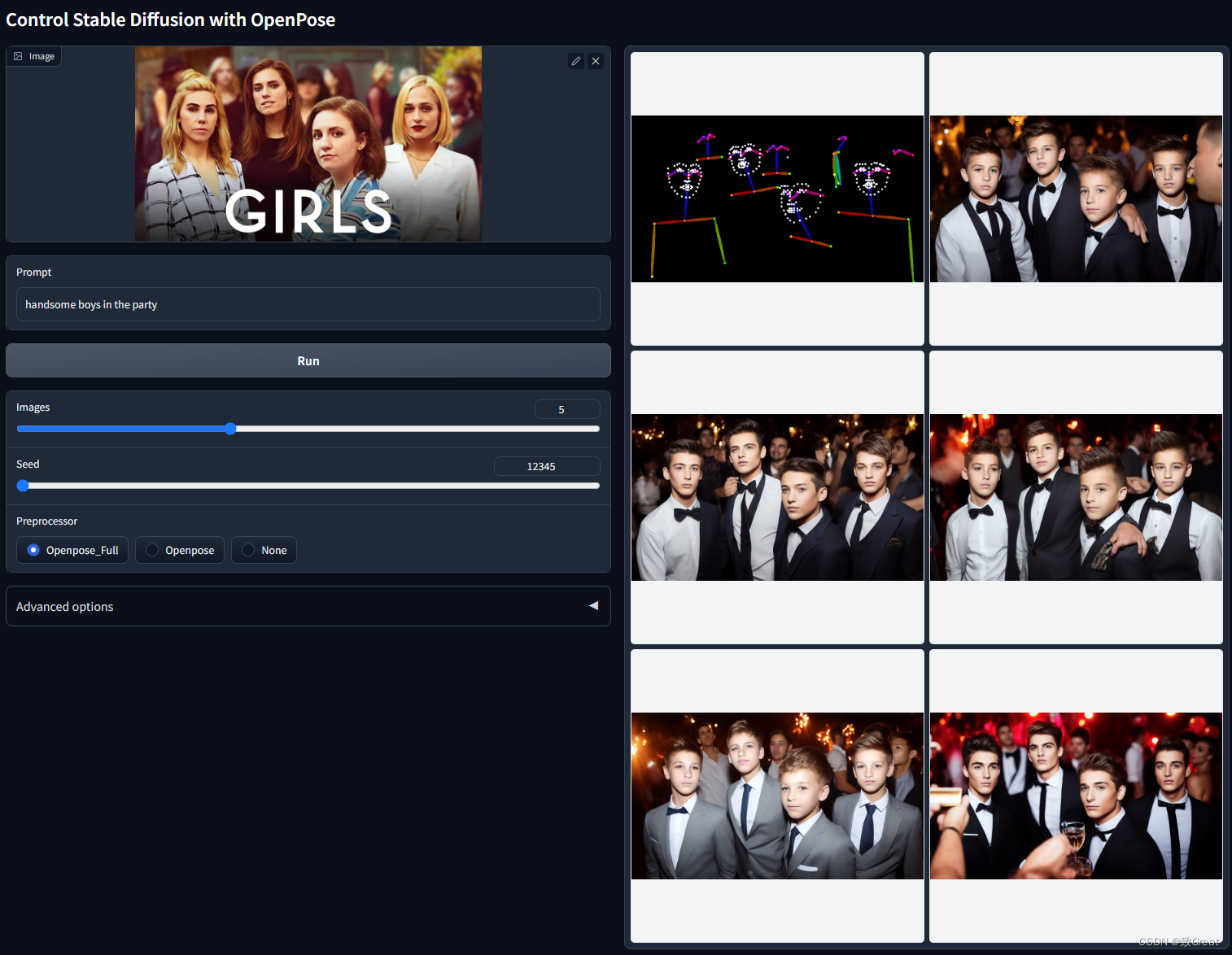

ControlNet 1.1 Openpose

模型文件:

Model file: control_v11p_sd15_openpose.pth

Config file: control_v11p_sd15_openpose.yaml

- 1

- 2

模型效果:

Openpose 1.1 的改进:

- 这个模型的改进主要是基于我们对OpenPose的改进实现。我们仔细回顾了pytorch的OpenPose和CMU的c++ openpose的区别。现在处理器应该更准确,尤其是手。处理器的改进导致了Openpose 1.1的改进。

- 支持更多输入(手和脸)。

- 之前cnet 1.0的训练数据集存在几个问题,包括(1)一小部分灰度人像被复制了数千次(!!),导致之前的模型有点可能生成灰度人像;(2) 某些图像质量低下、非常模糊或有明显的 JPEG 伪影;(3) 由于我们数据处理脚本的错误导致一小部分图片出现配对提示错误。新模型修复了训练数据集的所有问题,在很多情况下应该更合理。

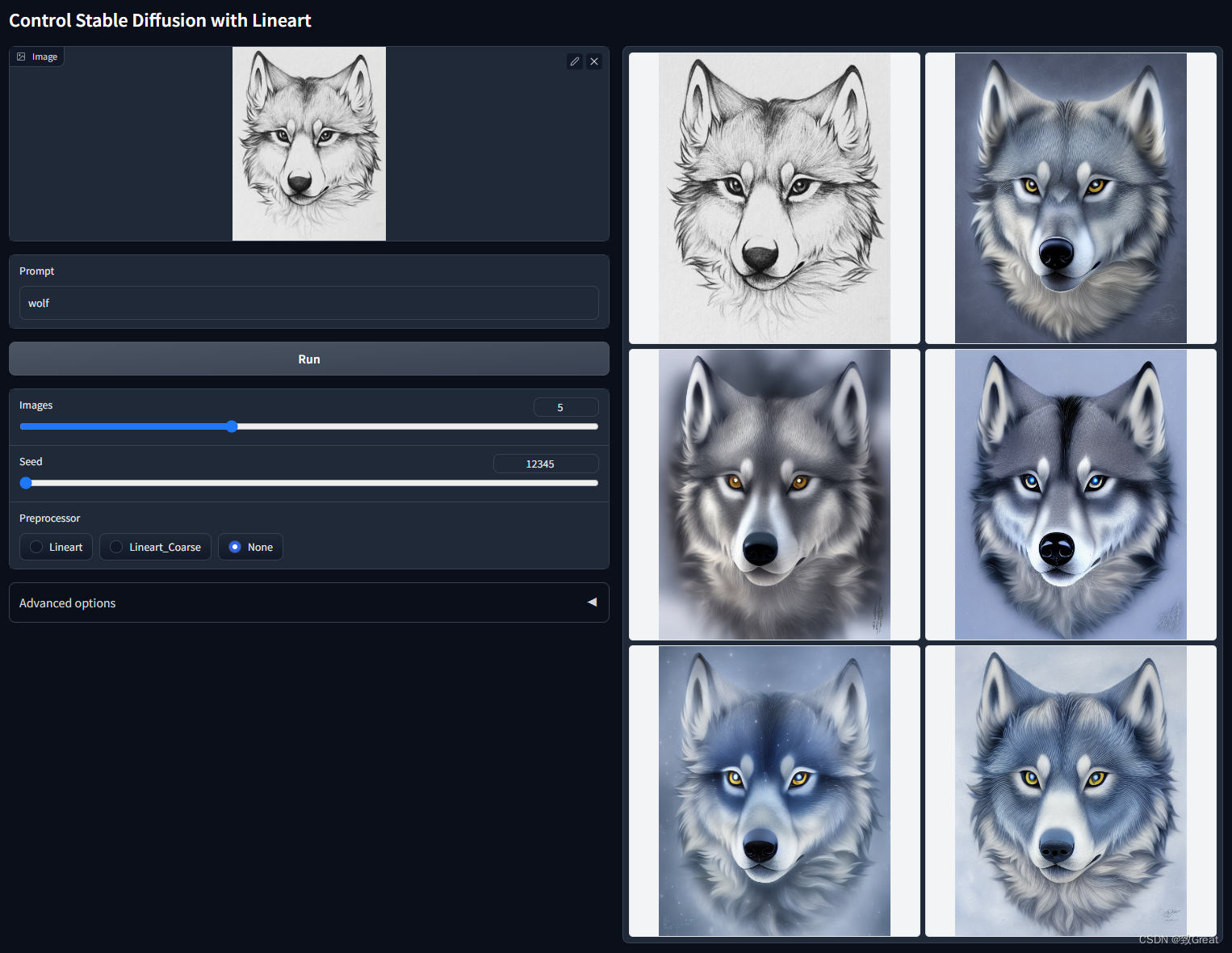

ControlNet 1.1 Lineart

模型文件

Model file: control_v11p_sd15_lineart.pth

Config file: control_v11p_sd15_lineart.yaml

- 1

- 2

模型效果:

ControlNet 1.1 Anime Lineart

模型文件

Model file: control_v11p_sd15s2_lineart_anime.pth

Config file: control_v11p_sd15s2_lineart_anime.yaml

- 1

- 2

模型效果:

ControlNet 1.1 Shuffle

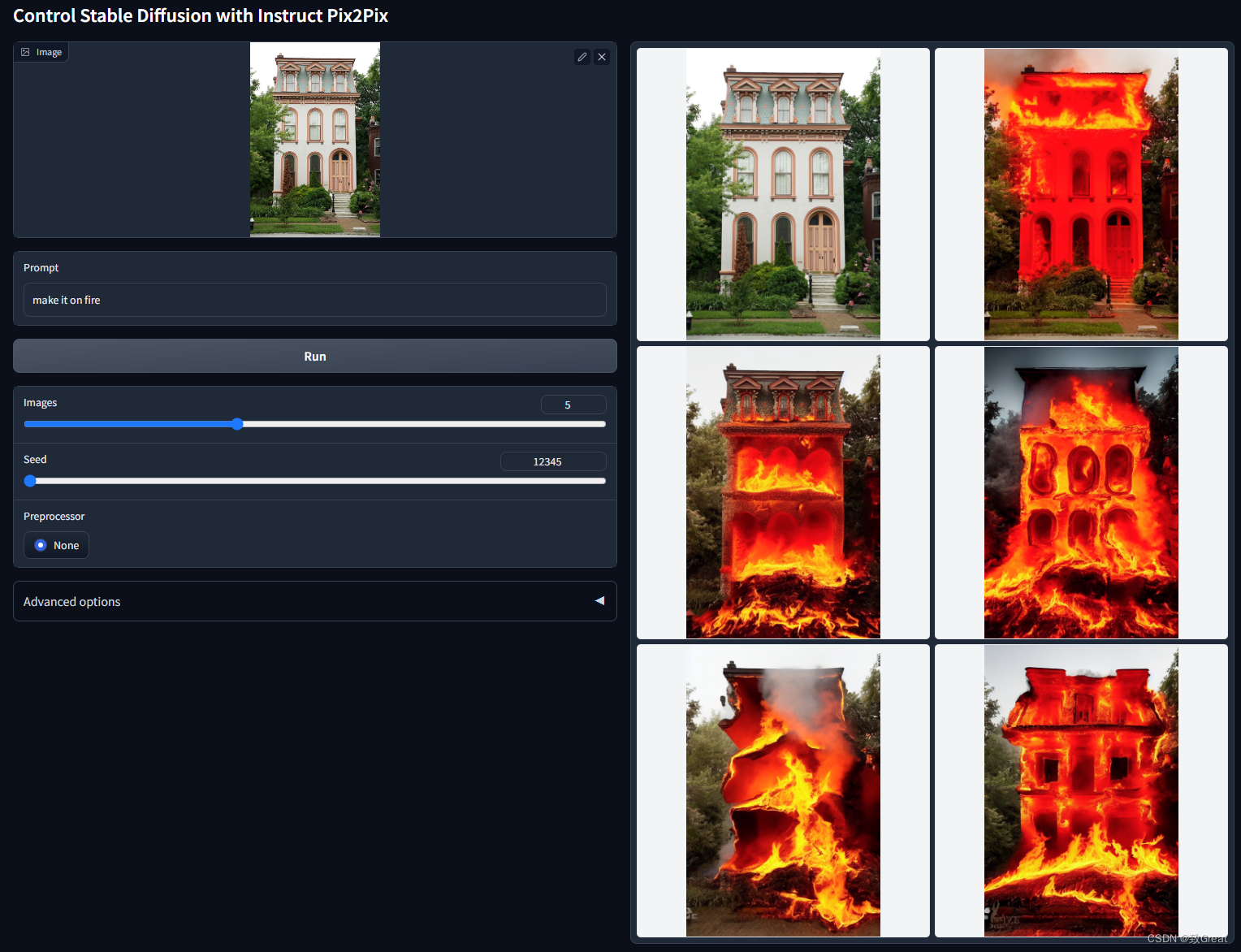

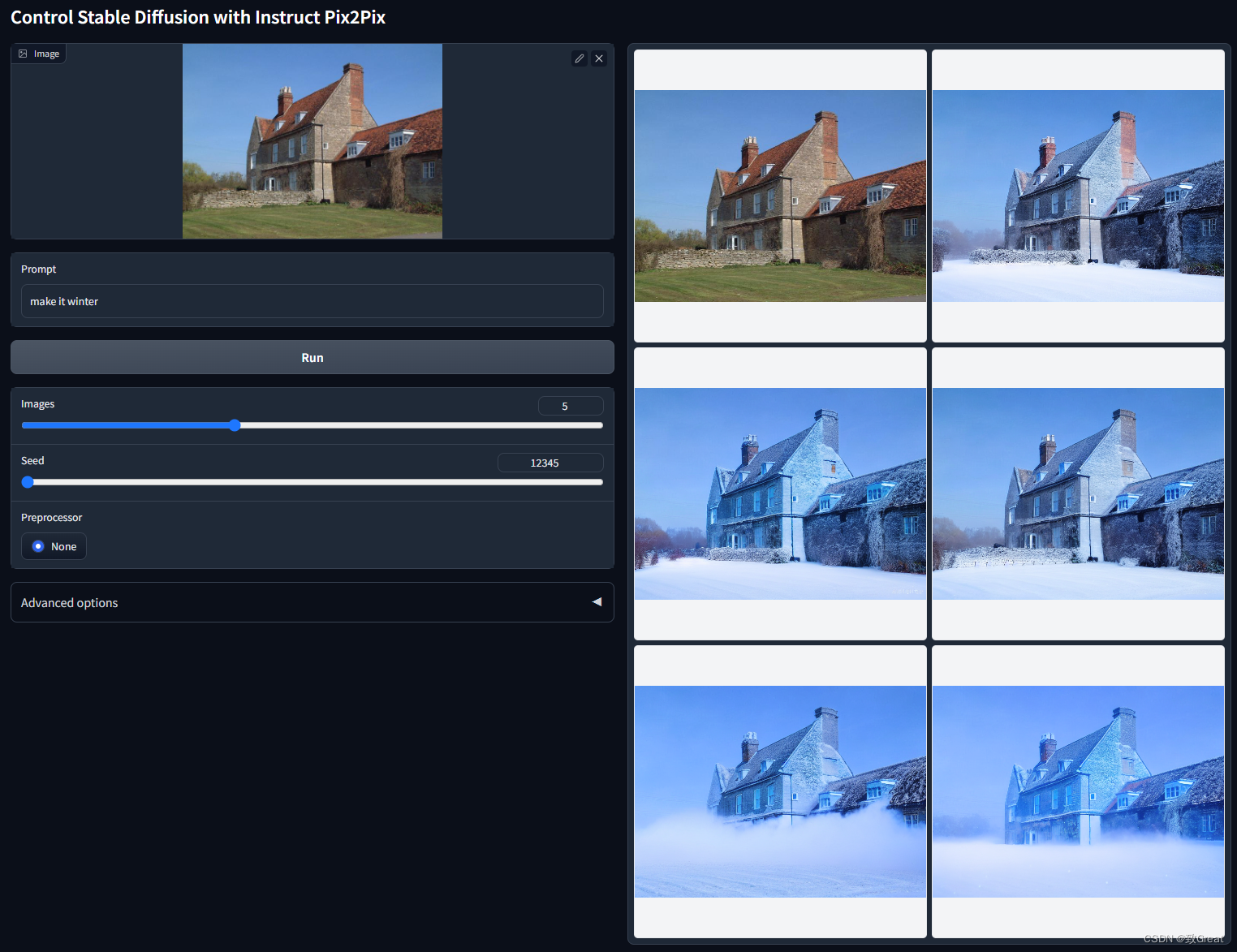

ControlNet 1.1 Instruct Pix2Pix

模型文件:

Model file: control_v11e_sd15_ip2p.pth

Config file: control_v11e_sd15_ip2p.yaml

- 1

- 2

模型效果:

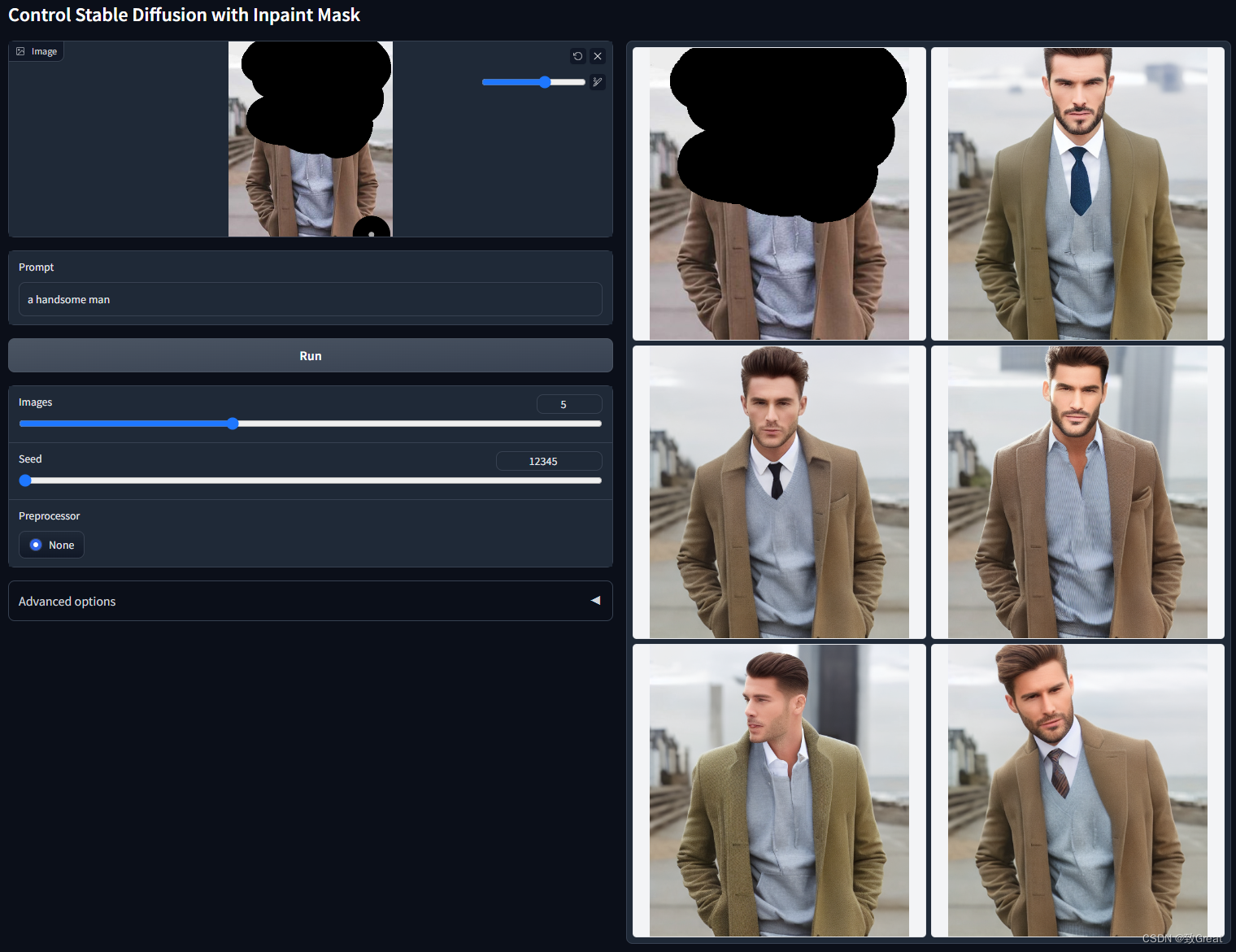

ControlNet 1.1 Inpaint

模型文件:

Model file: control_v11p_sd15_inpaint.pth

Config file: control_v11p_sd15_inpaint.yaml

- 1

- 2

模型效果:

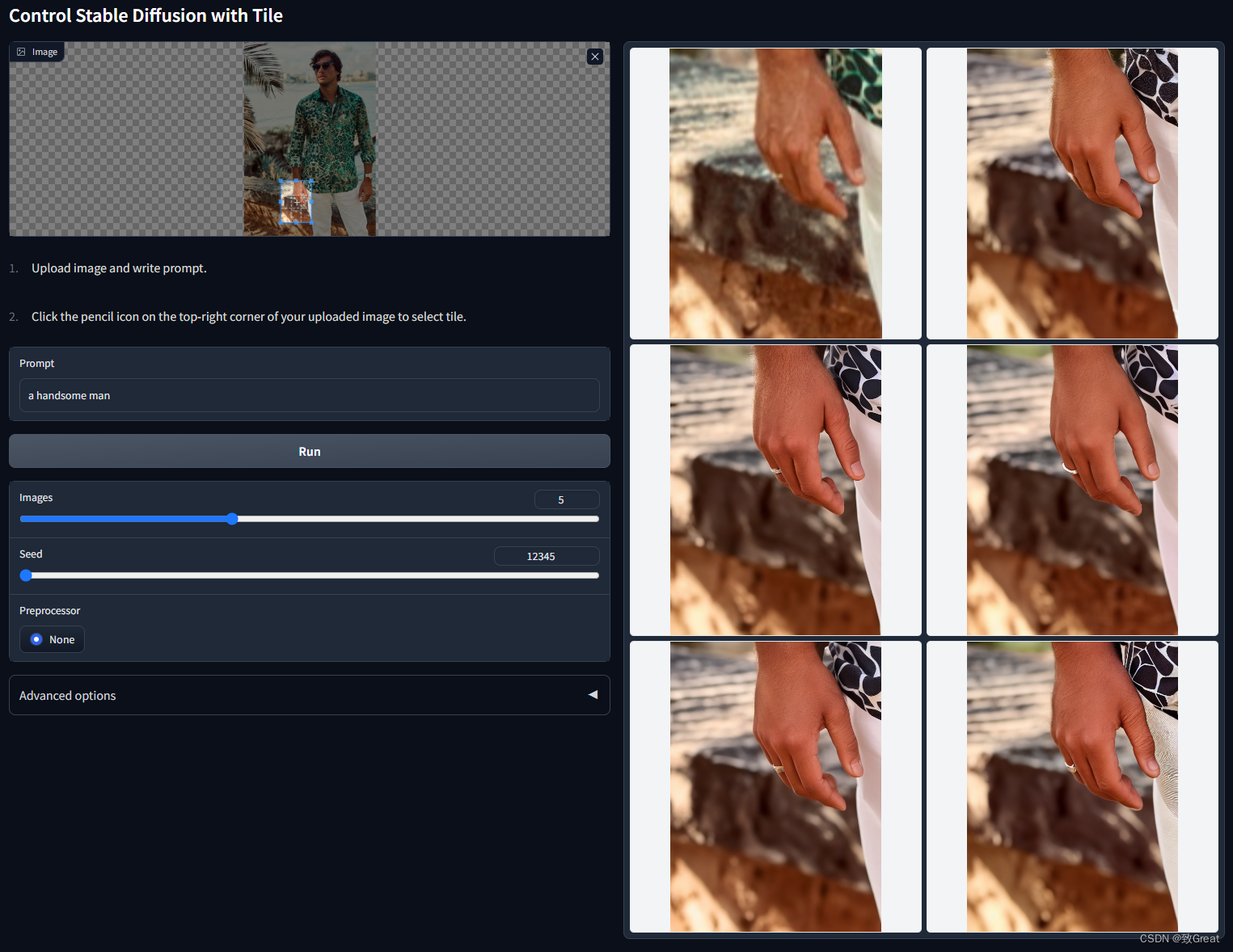

ControlNet 1.1 Tile (Unfinished)