- 1Linux中likely 函数的使用分析_if(lickly)

- 2linux centos7中使用 Postfix 和Dovecot搭建邮件系统

- 3Linux split分割xls或csv文件

- 4AMDET: Attention based Multiple Dimensions EEG Transformer for Emotion 论文精读_brainemotions

- 5【LLM GPT】李宏毅大型语言模型课程_李宏毅 llm

- 6GIS遥感专栏02:ENVI深度学习模块实现水质提取

- 7四种常见的Web攻击手段及其防御方式_web威胁防护四种技术

- 8前端js和react面试题及答案_react.js考试填空题

- 9kaggle比赛流程(转)

- 10shortcut icon地址栏显示个性图标_shortcut icon bookmark

CHATGLM3应用指南——本地部署_chatglm3-ggml-q4_0.bin 部署

赞

踩

写在前面:由于github仓库的代码会更新(GitHub - THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 开源双语对话语言模型),为了和本文保持一致,于是这里将2024/2/23日下载的代码存放在百度网盘:

链接:https://pan.baidu.com/s/10MeAoQgJmPJqDZFLBTubDQ

提取码:aeq1

将chatgalm3-6b模型放在ChatGLM3-main下:

链接:https://pan.baidu.com/s/1yJCQZbzsqqWDXfSytAftUA

提取码:8ncb

一、环境准备

(1)硬件要求:

Int4:

内存:>= 8GB 显存: >= 5GB(1060 6GB,2060 6GB)

FP16:

内存:>= 16GB 显存: >= 13GB(4080 16GB)

(2)软件环境

python 版本推荐3.10 - 3.11

transformers 库版本推荐为 4.36.2

torch 推荐使用 2.0 及以上的版本,以获得最佳的推理性能

(3)安装依赖

- cd ChatGLM3

- pip install -r requirements.txt

二、运行demo

ChatGLM3 提供了三种使用方式:命令行 Demo,网页版 Demo 和 API 部署;在启动模型之前,需要找到对应启动方式的 python 源码文件cli_demo.py,web_demo_gradio.py,web_demo_streamlit.py(前几个在basic_demo目录下) ,openai_api.py (在openai_api_demo目录下)中

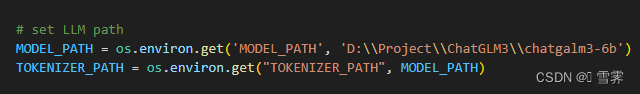

(1)修改MODEL_PATH为chatgalm3-6b模型的路径

MODEL_PATH = os.environ.get('MODEL_PATH', 'D:\\Project\\ChatGLM3\\chatgalm3-6b')注意!!!使用\\,不要使用/,否则会产生报错如下:

(2)本地运行

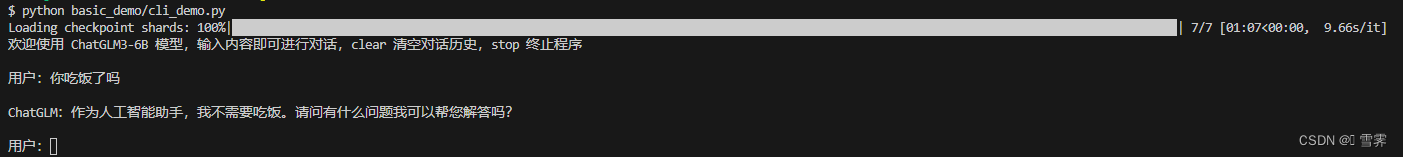

python basic_demo/cli_demo.py程序会在命令行中进行交互式的对话,在命令行中通过 用户: 进行输入指示,直接输入问题回车即可生成回复,输入 clear 可以清空对话历史,输入 stop 终止程序。

(3)网页运行

- python basic_demo/web_demo_gradio.py

- 或

- streamlit run basic_demo/web_demo_streamlit.py

Streamlit 的网页版 demo效果与Gradio相同,但是更加流畅。

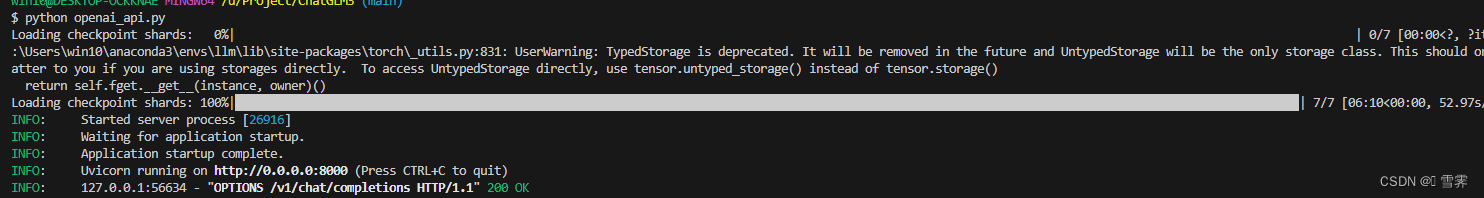

(3)API运行

在 Releases · ChatGPTNextWeb/ChatGPT-Next-Web · GitHub 下载 ChatGPT-Next-Web APP,用于交互。

&&&上个版本openai_api.py文件,修改模型地址:

运行:python openai_api.py

&&&这个版本api_server.py(在openai_api_demo目录下)

同理修改模型地址后运行

然后将日志打印出的接口地址 http://localhost:8000 ,注意不是http://0.0.0.0:8000 写入 ChatGPT-Next-Web 的设置中,并添加自定义模型 chatglm3