- 1一位腾讯在职7年测试工程师的心声...

- 2ThingsBoard入门实战(一):物联网平台 ThingsBoard 简介

- 3Flutter后台定时任务(BackgroundFetch)_flutter 定时任务

- 4Git学习笔记(一)--本地操作_`--repo-url`使用本地仓库

- 5Python之异常捕获try、except、else、finally语句使用方法详解_try else except函数

- 6电脑常见故障及解决方法_计算机硬件故障诊断原因和处理的常用方法

- 7vue-cli5.x 集成 cesium_vue5 cli集成cesium

- 8图解目标检测 之 【YOLOv9】 算法 最全原理详解

- 9事件抽取(and 检测)经典论文_事件抽取论文

- 10【HarmonyOS尝鲜课】- 前言

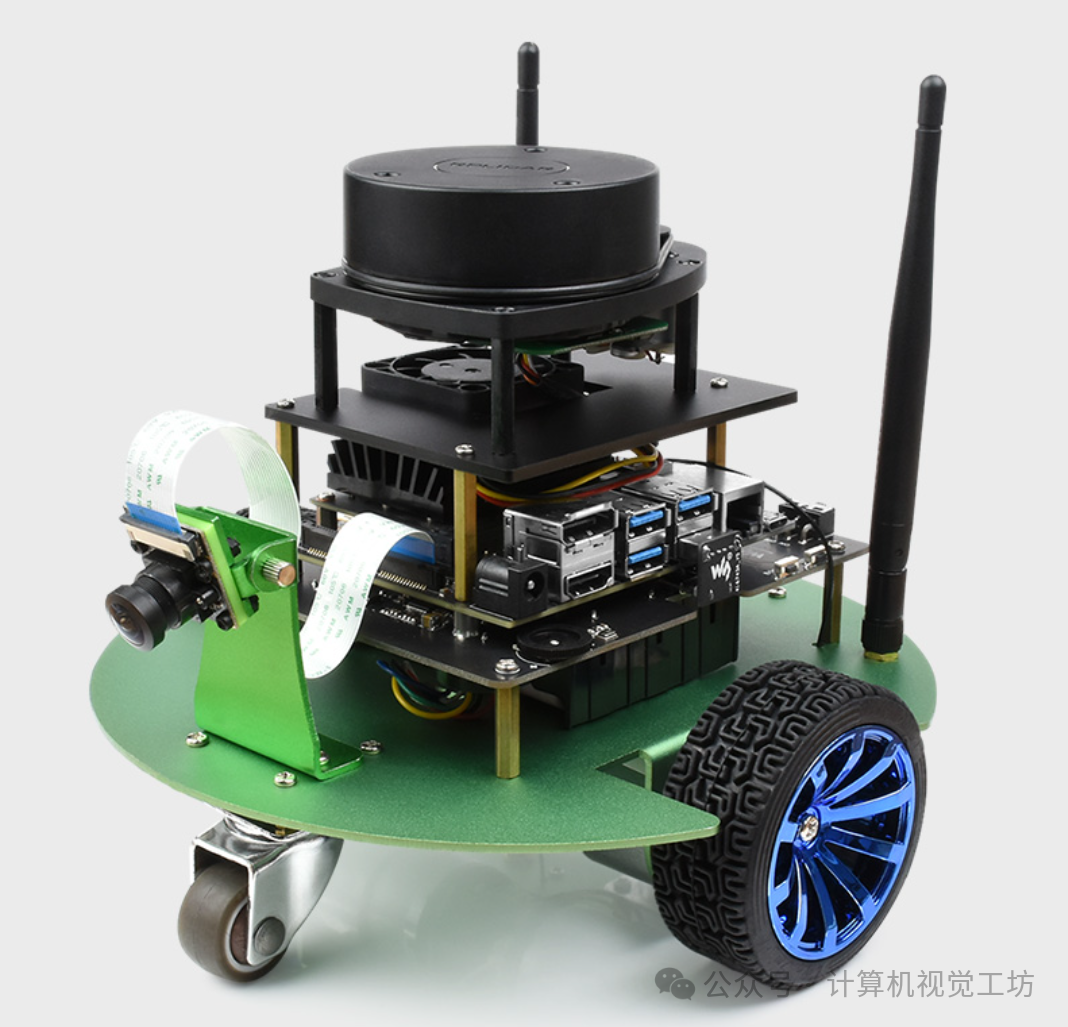

CVPR'24开源 | 波恩大学提出动态环境下的3D LiDAR建图新方案!

赞

踩

点击下方卡片,关注「计算机视觉工坊」公众号

选择星标,干货第一时间送达

作者:Xingguang Zhong | 编辑:计算机视觉工坊

添加小助理:dddvision,备注:方向+学校/公司+昵称,拉你入群。文末附行业细分群

扫描下方二维码,加入3D视觉知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门视频课程(星球成员免费学习)、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 读者个人理解

使用LiDAR或RGB-D摄像头进行建图,是计算机视觉和机器人技术中的基本任务。通常,我们希望获得准确的地图,以支持诸如定位、规划或导航等下游任务。为了实现对室外环境的准确重建,我们必须考虑由移动物体(如车辆或行人)引起的动态。此外,动态物体去除在自动驾驶和机器人应用中扮演着重要角色,用于创建数字双生体以进行逼真的模拟和高清地图绘制,其中静态地图与语义和任务相关信息相结合。

在动态环境中的映射和状态估计是机器人技术中的经典问题。同时定位与建图(SLAM)的方法可以采用不同的策略来处理动态。常见的方式包括:(1)从输入中滤除动态作为预处理步骤,这需要对场景进行语义解释;(2)对地图表示中的占用进行建模,在自由空间中回顾性地移除测量,从而可以隐式地去除动态;(3)将其包含在状态估计中,以模拟来自环境的动态和静态部分的测量的起源。我们提出的方法属于最后一类,并允许我们直接在地图表示中对动态进行建模,从而导致时空地图表示。

最近,隐式神经表示在计算机视觉中引起了越来越多的关注,用于新视角合成和3D形状重建。由于其紧凑性和连续性,一些方法探讨了在大规模3D LiDAR映射中使用神经表示,从而实现准确的地图同时显著减少内存消耗。然而,这些方法通常没有解决映射过程中处理动态的问题。动态NeRF和神经可变形物体重建的最新进展表明,神经表示也可以用于表示动态场景,这启发了我们从4D重建的角度解决动态环境中的映射问题。

在本文中,我们提出了一种新方法,通过将每个点的时间依赖截断有符号距离函数(TSDF)编码到隐式神经场景表示中来重建大型4D动态场景。我们将依次记录的LiDAR点云收集在动态环境中作为输入,并为每个时间帧生成一个TSDF,可以使用Marching Cubes提取网格。整个序列期间不变的背景TSDF可以很容易地从4D信号中提取。我们将其视为可以用于从原始点云中分割动态对象的静态地图。与传统的基于体素的映射方法相比,连续的神经表示允许去除动态对象同时保留丰富的地图细节。

2. 导读

构建准确地图是实现可靠定位、规划和自主车辆导航的关键构建模块。我们提出了一种新颖的方法,利用一系列LiDAR扫描来构建动态环境的准确地图。为此,我们提出将4D场景编码成一种新颖的时空隐式神经地图表示,通过对每个点拟合时间依赖的截断有符号距离函数来实现。使用我们的表示,我们通过过滤动态部分来提取静态地图。我们的神经表示基于稀疏特征网格、全局共享解码器和时间依赖基函数,这些基函数我们以非监督方式联合优化。为了从一系列LiDAR扫描中学习这种表示,我们设计了一个简单而高效的损失函数,以分段方式监督地图优化。我们评估了我们的方法在包含移动物体的各种场景中的性能,评价指标包括静态地图的重构质量和动态点云的分割。实验结果表明,我们的方法能够移除输入点云的动态部分,同时重建准确完整的3D地图,优于几种最先进的方法。

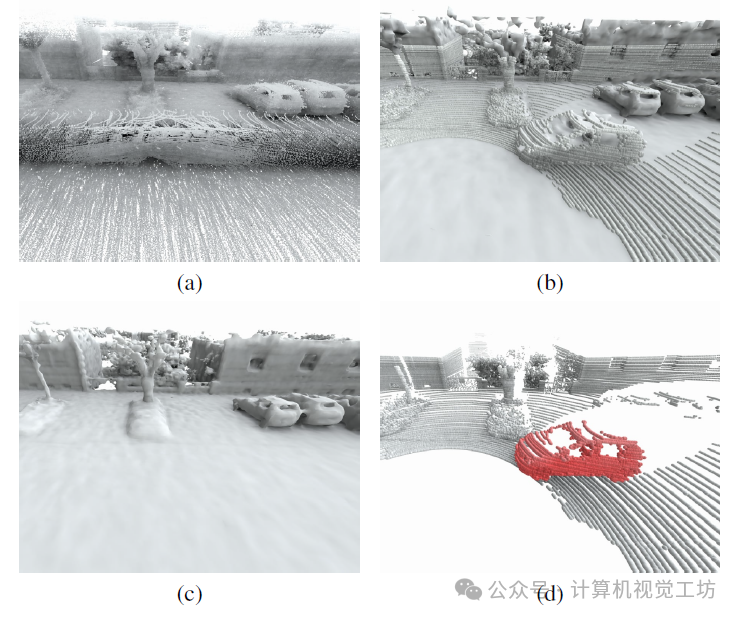

3. 效果展示

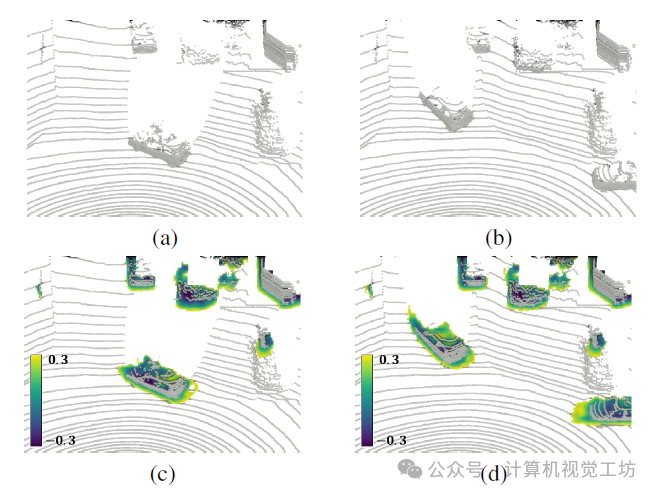

给定一系列点云,如图(a)所示,我们优化我们的四维神经表示,可以在任意位置查询特定时间的值。基于估计的时间相关TSDF值,我们可以在特定时间点提取网格。此外,我们的四维神经表示也可用于静态映射(c)和动态物体去除(c)。

针对KITTI数据集的重建TSDF:子图(a)和(b)是输入的相邻帧。相应地,(c)和(d)是从我们的4D地图中查询的水平TSDF切片。请注意,我们仅显示小于0.3m的TSDF值。

4. 主要贡献

我们提出了一种新的隐式神经表示,以序列LiDAR扫描作为输入,共同重建动态3D环境并保持静态地图。

我们采用分段训练数据采样策略,并设计了一个简单但有效的损失函数,通过梯度约束来保持静态点监督的一致性。

我们通过动态对象分割的准确性和重建静态地图的质量来评估映射结果,表现出优于几个基准的性能。我们提供了用于实验的代码和数据。

5. 基本原理是啥?

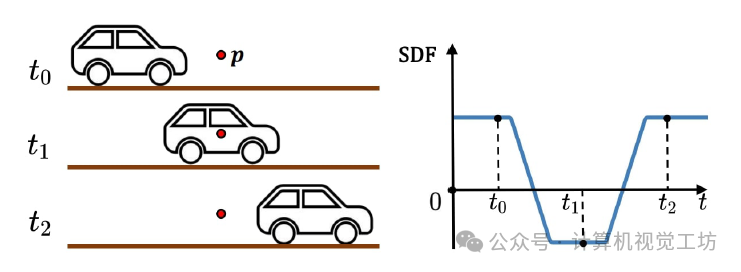

我们的四维TSDF表示原理:左图展示了一个移动物体和一个查询点p。右图描述了随时间变化在点p处的相应符号距离。在t0时刻,p的符号距离是一个正的截断值。当移动物体在t1时刻到达p时,p位于物体内部,其符号距离相应为负值。在t2时刻,移动物体经过p后,p的符号距离再次变为正值。

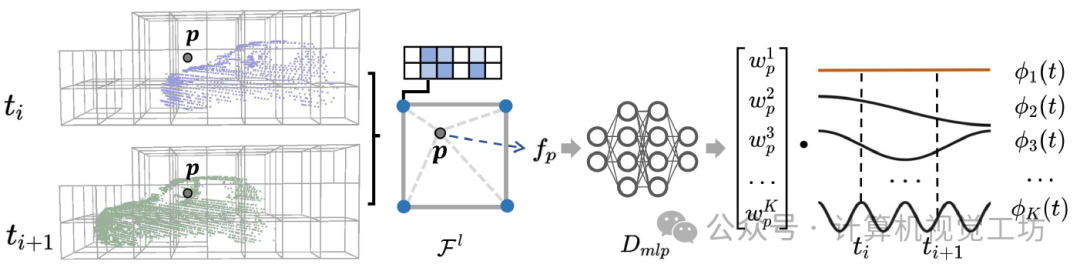

在我们的4D地图表示中查询TSDF值的概述。对于查询位于ti和ti+1处的点p,我们首先检索p所在的体素的Fl中每个角点的特征,并通过三线性插值获得融合特征fp。然后,我们将fp输入解码器Dmlp,并将输出作为不同基函数ϕ1(t),...,ϕK(t)的权重。最后,我们计算在ti和ti+1处基函数值的加权和,以获得它们各自的SDF结果。为简单起见,我们仅说明了一个级别的哈希特征网格。

6. 实验结果

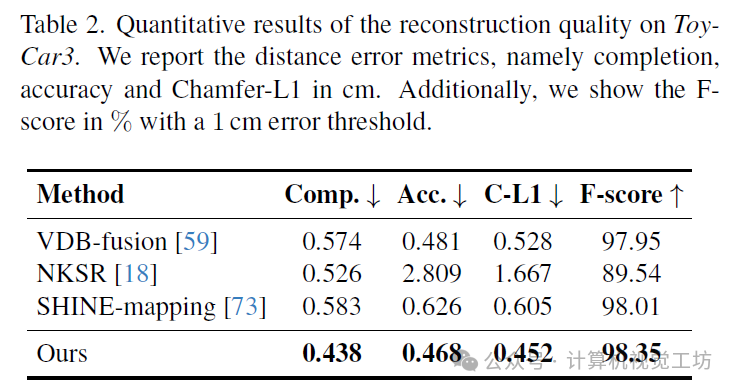

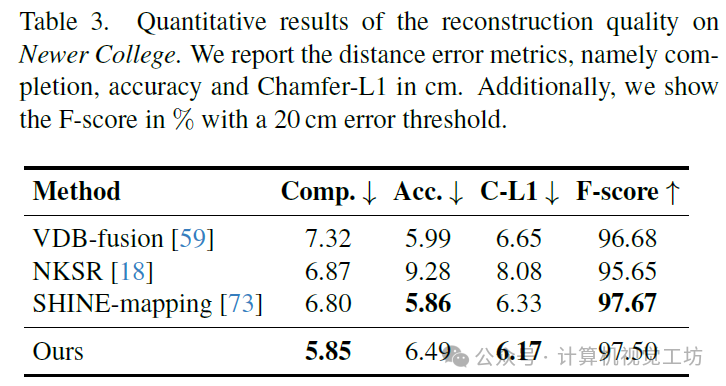

在 Tab. 2 和 Tab. 3 中分别呈现了 ToyCar3 合成数据集和现实世界数据集 Newer College 的定量结果。关于准确性,SHINE-mapping 和 VDB-Fusion 可以通过多帧融合滤除部分高频噪声,从而在嘈杂的 Newer College 数据集上表现更好。相比之下,我们的方法将每个扫描都视为准确的,以存储 4D 信息,这使其对测量噪声更为敏感。在 ToyCar3 数据集上,我们的方法和 VDB-Fusion 都成功消除了所有移动物体。然而,在 Newer College 数据集上,VDB-Fusion 错误地消除了静态树木和部分地面,导致 Tab. 3 中显示的完整性较差。SHINE-mapping 消除了 Newer College 数据集上的动态行人,但保留了 ToyCar3 数据集上的一部分动态点云,后者具有较大比例的动态对象,导致 Tab. 2 中的准确性较差。NKSR 的准确性最差,因为它无法消除动态对象,这意味着直接在动态实景中应用 NKSR 不适合。

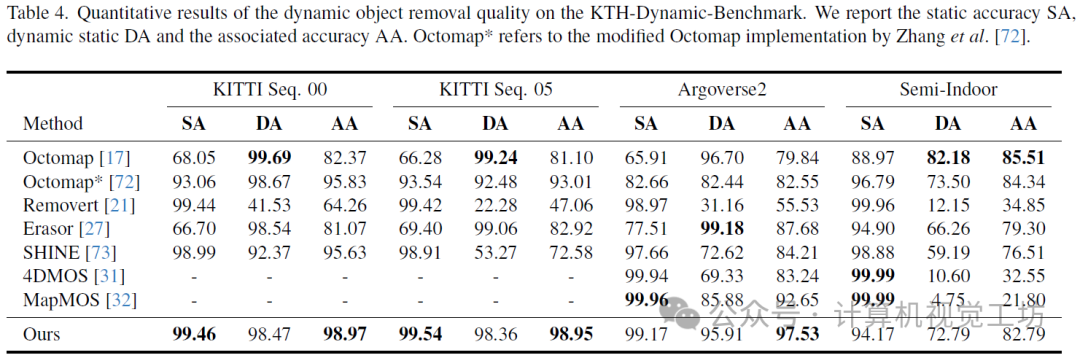

动态对象分割的定量结果显示在 Tab. 4 中。我们可以看到,我们的方法在三个自动驾驶序列(KITTI 00、KITTI 05、Argoverse2)中实现了最佳关联准确度(AA),远远优于基线。基于监督学习的方法 4DMOS 和 MapMOS 由于泛化能力有限而无法获得良好的动态准确度(DA)。Erasor 和 Octomap 倾向于过度分割动态对象,导致静态准确度(SA)较差。Removert 和 SHINE-mapping 过于保守,无法检测到所有动态对象。得益于 4D 神经表示的连续性和大容量,我们在保留静态背景点和移除动态对象之间取得了更好的平衡。值得再次提到的是,我们的方法不依赖于任何预处理或后处理算法,如地面拟合、离群值过滤和聚类,也不需要训练标签。

7. 总结 & 局限性

在本文中,我们提出了一种用于动态场景的 4D 隐式神经地图表示,使我们能够表示场景的静态部分和动态部分的 TSDF。为此,我们使用分层体素特征表示,然后将其解码为基函数的权重,以表示可以在任意位置查询的时变 TSDF。为了从 LiDAR 扫描序列中学习表示,我们设计了有效的数据采样策略和损失函数。配备了我们提出的表示,我们通过实验证明,我们能够解决静态映射和动态对象分割的挑战性问题。具体来说,我们的实验表明,我们的方法能够准确重建场景的静态部分的 3D 地图,并同时完全移除移动对象。

局限性。虽然我们的方法取得了令人信服的结果,但我们必须承认,我们目前依赖于由单独的 SLAM 方法估计的姿态,也不能以在线方式应用我们的方法。然而,我们认为这是未来研究联合增量映射和姿态估计的一条途径。

8. 参考

[1] 3D LiDAR Mapping in Dynamic Environments Using a 4D Implicit Neural Representation

计算机视觉工坊交流群

目前我们已经建立了3D视觉方向多个社群,包括2D计算机视觉、大模型、工业3D视觉、SLAM、自动驾驶、三维重建、无人机等方向,细分群包括:

2D计算机视觉:图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

大模型:NLP、CV、ASR、生成对抗大模型、强化学习大模型、对话大模型等

工业3D视觉:相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM:视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、自动驾驶综合群等、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、BEV感知、Occupancy、目标跟踪、端到端自动驾驶等。

三维重建:3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机:四旋翼建模、无人机飞控等

除了这些,还有求职、硬件选型、视觉产品落地、最新论文、3D视觉最新产品、3D视觉行业新闻等交流群

添加小助理: dddvision,备注:研究方向+学校/公司+昵称(如3D点云+清华+小草莓), 拉你入群。

3D视觉学习知识星球

3D视觉从入门到精通知识星球、国内成立最早、6000+成员交流学习。包括:星球视频课程近20门(价值超6000)、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步。

3DGS、NeRF、结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测、BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制、无人机仿真、三维视觉C++、三维视觉python、dToF、相机标定、ROS2、机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap、线面结构光、硬件结构光扫描仪,无人机等。