- 1nw_socket_set_common_sockopts setsockopt SO_NOAPNFALLBK failed: [42] Protocol not available, dumping_setsockopt - so_recv_anyif: protocol not available

- 2解决Nginx出现403 forbidden (13: Permission denied)报错的四种方法_nginx permission denied

- 3多线程操作 pthread_create pthread_join_pthread_create_joinable

- 4monaco脚本编辑器 在无界中使用 鼠标点击不到

- 5Linux文本编辑命令模式以及相对路径与绝对路径_linux用相对路径创建文件

- 6数字图像处理—Bayer初学(小记)_bayer图像

- 7Preference的使用(2) --- PreferenceCategory && PreferenceScreen

- 8Android 状态栏(SystemUI)下拉界面的自定义开发系列_android systemui里如何进行状态栏下拉判断

- 9内网渗透之Windows反弹shell(一)_windows命令行反弹shell

- 10循环

【妈妈级】清华ChatGLM2-6B本地部署搭建及测试运行,0基础小白也学得会_清华glm本地部署

赞

踩

部署只是开始,如果想继续微调个人/企业垂直能力的model

#1 高质量数据集

我搭建了一个数据共享交换平台,目前已收录中文对话、金融、医疗、教育、儿童故事五个领域优质数据集,还可以通过会员之间共享,工众后台:“数据集”下载。

#2 报错或问题解决

你可能像我们NLP学习群中的同学一样,遇到各种报错或问题,我每天挑选5条比较有代表性的问题及解决方法贴出来,供大家避坑;每天更新,工众后台:“问答3000条”获清单汇总。

#3 运算加速

还有同学是几年前的老爷机/笔记本,或者希望大幅提升部署/微调模型的速度,我们应用了动态技术框架,大幅提升其运算效率(约40%),节省显存资源(最低无显卡2g内存也能提升),工众后台:“加速框架”;

#4 微调训练教程

如果你还不知道该怎么微调训练模型,我系统更新了训练和微调的实战知识库,跟着一步步做,你也能把大模型的知识真正应用到实处,产生价值。

好啦!话不多说!开始今天主题!

(如果不想开始这个主题

,也有懒人一键包,工众后台:“chatglm一键包”)

清华开源项目 ChatGLM2-6B 已发布开源版本,这一项目可以直接部署在本地家用计算机上做测试,无需联网即可体验与 AI 聊天的乐趣。

项目地址:

GitHub:https://github.com/THUDM/ChatGLM2-6BHugging Face:https://huggingface.co/THUDM/chatglm2-6bChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性:

更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。

更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,我们会在后续迭代升级中着重进行优化。

更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

第一步,本地安装 Python

这一步暂略,可以自行下载安装 Python 环境。

#1 官网下载地址:https://www.python.org/downloads/#2 工众号后台:“Python”,安装时勾选:“Add Python 3.10 to PATH”

注意:安装 >9 以上版本,建议安装 10。

第二步,下载项目程序包

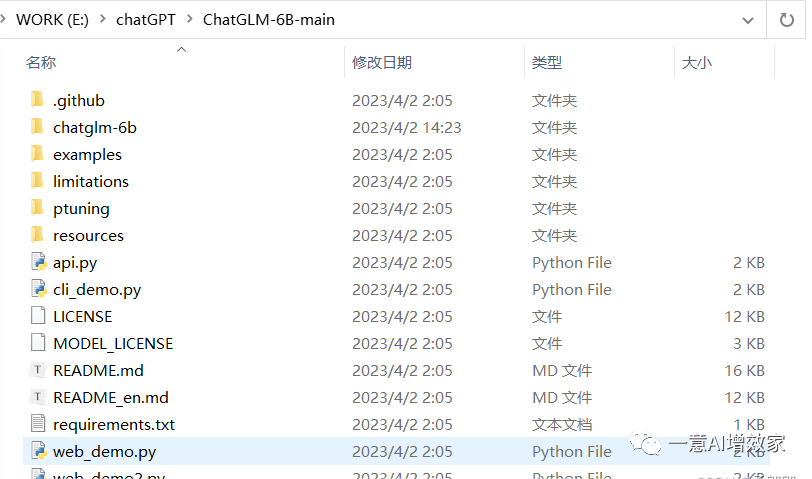

地址见上面的项目地址,直接下载下来并解压。我这里解压到 E:\chatGPT\ 下

因为清华官方项目地址,都是在国外平台上,如果你访问不了,在工众号后台:“chatglm”,在国内网盘下载。

第三步,下载模型包 chatglm

如果你第二步是在我上传国内网盘下载的,就已经包含模型包了,就不用再下载了,但为了让大家了解清楚整个过程,也一并贴上来。

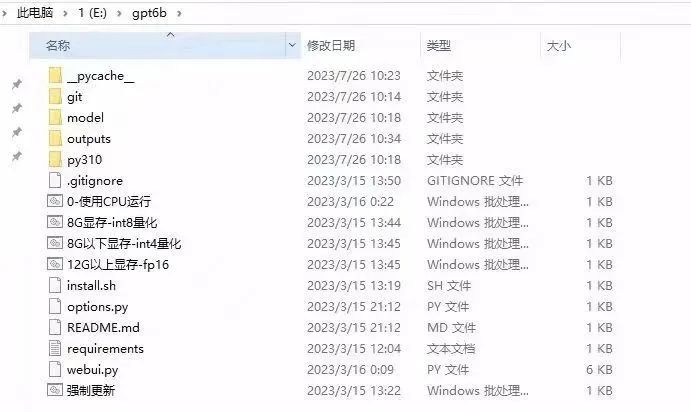

下载地址:https://huggingface.co/THUDM/chatglm-6b/tree/main注意:下载后放到第二步程序包下,自行创建目录chatglm-6b,如下:

第四步,下载依赖包

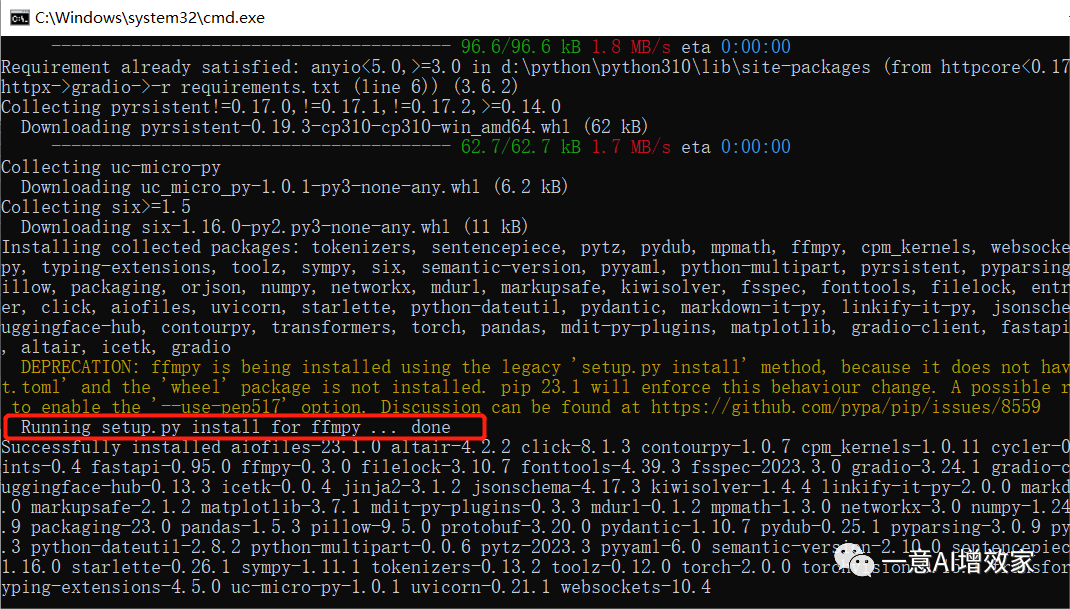

Window + R 快捷键打开运行窗口,输入 cmd 打开控制台命令行,进入到程序目录下(注意看图片我的命令行,跟着一步步输入,然后回车,注意要在英文输入法输入,否则无法识别)

分别执行如下两条命令:

pip install -r requirements.txtpip install gradio

等待依赖包下载成功,结果如下:

第五步,运行网页版 demo

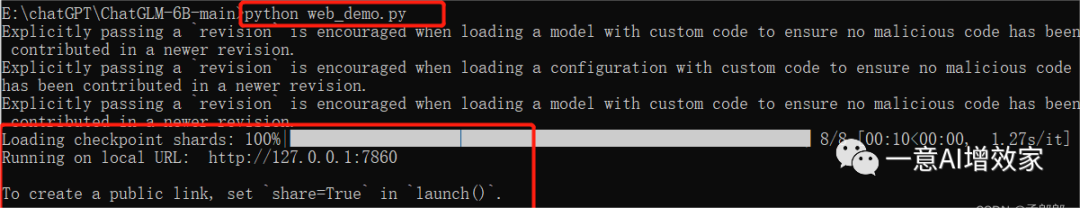

执行如下命令,运行网页版本的 demo,如下:

python web_demo.py程序会运行一个 Web Server,并输出地址。在浏览器中打开输出的地址即可使用。最新版 Demo 实现了打字机效果,速度体验大大提升。注意,由于国内Gradio 的网络访问较为缓慢,启用 demo.queue().launch(share=True, inbrowser=True) 时所有网络会经过 Gradio 服务器转发,导致打字机体验大幅下降,现在默认启动方式已经改为 share=False,如有需要公网访问的需求,可以重新修改为 share=True 启动。

执行结果如下:

第七步,测试网页版程序

浏览器打开地址 并访问,输入问题,可以看到 ChatGLM 会给予回复。

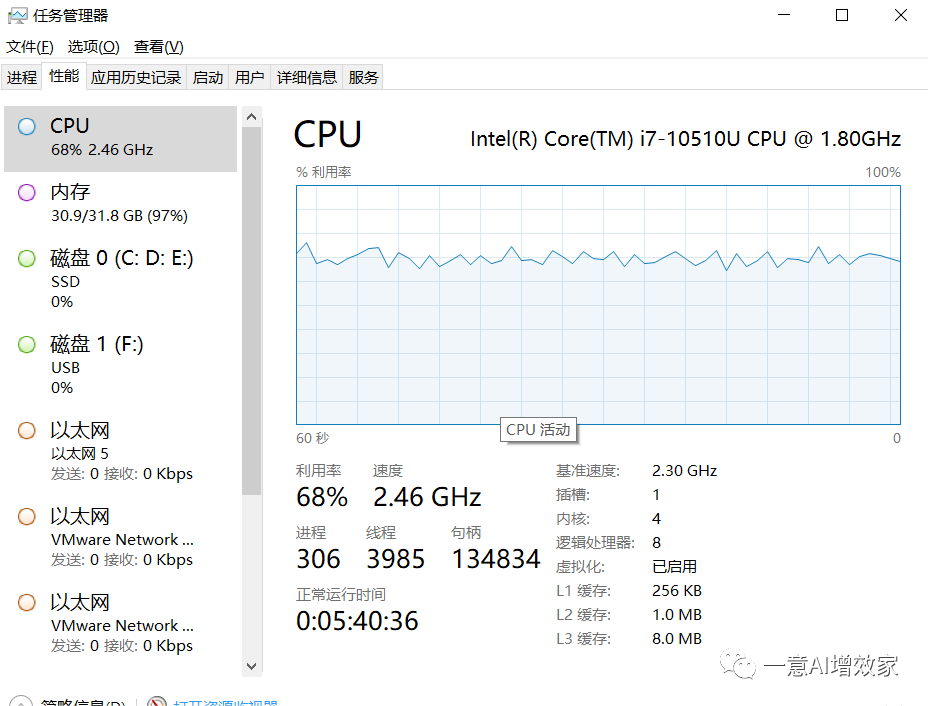

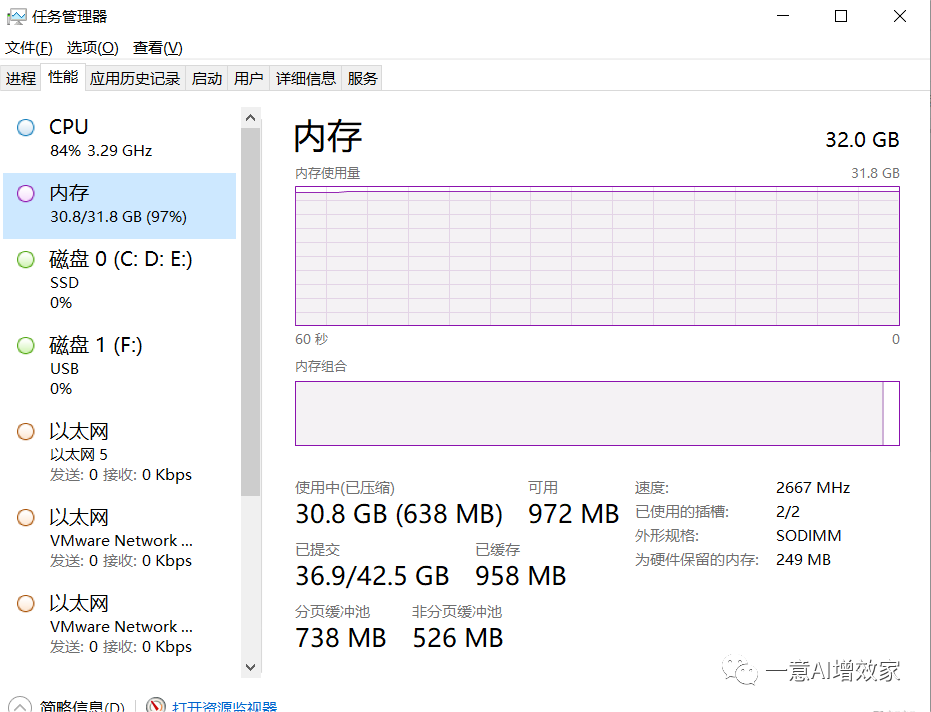

看电脑性能,感觉 CPU 和内存都要爆掉了!哈哈!

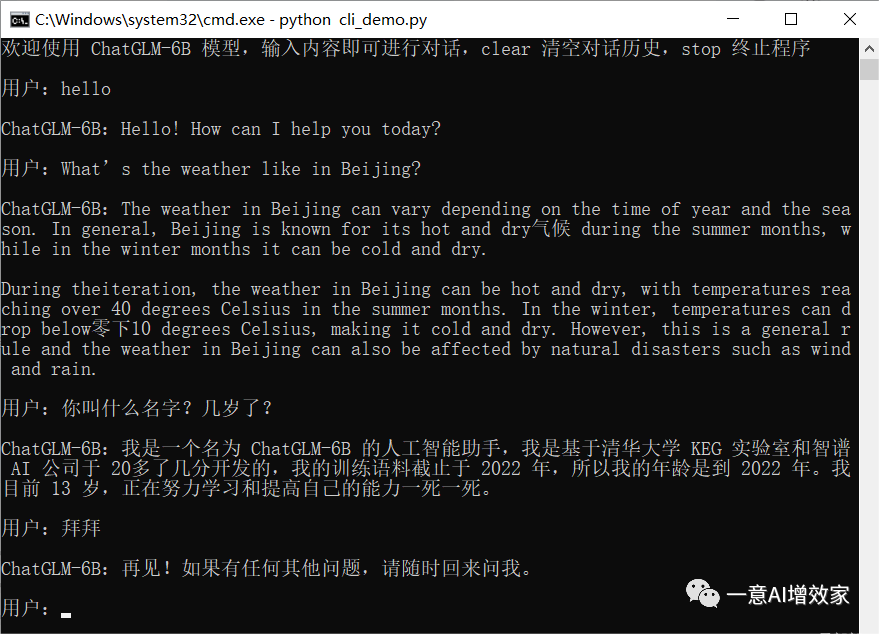

第八步,运行命令行 Demo

执行如下命令,运行命令行版本的 demo,如下:

python cli_demo.py程序会在命令行中进行交互式的对话,在命令行中输入指示并回车即可生成回复,输入clear 可以清空对话历史,输入 stop 终止程序。

好啦!教程就这么简单!如果你遇到问题,欢迎评论区留言!