- 1visio2010绘制思维导图方法_visio画思维导图

- 2使用F12调调伤眼睛的网页背景色_f12获取气泡背景色

- 3有什么事让你觉得在Linux上顺理成章,换到Windows上就令你费解?

- 4css3响应式布局核心(@media常用属性)_@media only

- 5关于对话机器人,你需要了解这些技术_task-bot

- 6C语言结构体与malloc_malloc 结构体

- 7多维数组的定义和存储_向量数据库 几列的数组

- 8HDD杭州站·HarmonyOS技术专家分享HUAWEI DevEco Studio特色功能_鸿蒙 dev-eco studio 可视化开发

- 9均值定理最大值最小值公式_数学均值定理怎么求不等式的最大值最小值,求教会(ฅ>ω<*ฅ)...

- 10Rust使用feature特性和条件编译,以及常用feature使用说明

如何在Colab中使用gpu资源(附使用MMdet推理示例)_colab中没有使用gpu

赞

踩

如何在Colab中“白嫖”gpu资源(附使用MMdet推理示例)

Google Colab简介

当今,深度学习已经成为许多人感兴趣的话题,Google Colab(全称为Google Colaboratory)是Google推出的一个强大的云端 notebook,为开发者提供了一个免费的、轻便的云端开发环境,无需安装任何软件,只需要一个浏览器就可以运行。

在Google Colab中,你可以轻松地创建、编辑和共享Jupyter notebook,其中包括Python代码和文本单元格。 Colab还提供了一个丰富的Python库,使得数据科学家和研究人员可以使用常见的数据科学工具和库,例如NumPy、Pandas、Matplotlib和TensorFlow等。

Colab的优点不仅在于其易用性,还在于其提供的GPU和TPU加速,这使得模型训练速度大大加快,尤其是在处理大规模数据集时,Colab的GPU和TPU支持将显著提高训练效率。此外,Colab还允许我们将 notebook与Google Drive集成,可以轻松地保存和共享notebook、数据集和训练模型。

除了这些功能,Colab还可以与GitHub集成,使我们可以直接从Colab加载GitHub存储库中的 notebook,这大大简化了GitHub上协作的流程。此外,Colab还支持与Google Cloud的连接,可以轻松地将notebook与Google Cloud Storage、BigQuery等云端服务进行集成,从而轻松地管理和共享数据集和模型。

总的来说,Google Colab是一个强大、灵活且易于使用的云端开发环境,为数据科学家和机器学习工程师提供了一个快速、高效的工具,使他们能够轻松地构建、测试和优化模型,以便更好地理解和应用机器学习技术。

如何白嫖GPU

在Google Colab中,可以通过以下步骤免费使用GPU:

-

打开一个新的Colab notebook或打开一个已有的 notebook。

-

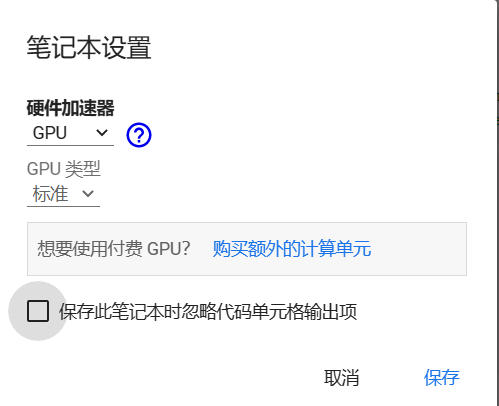

点击菜单栏中的“修改”(Edit)按钮,选择“ notebook设置”(Notebook settings)。

-

在弹出的窗口中,将“硬件加速器”(Hardware accelerator)的选项从“无”(None)改为“GPU”,然后点击“保存”(Save)按钮。

-

Colab会为你分配一个免费的GPU,并将其绑定到你的 notebook中。你可以在 notebook中使用以下代码来检查是否成功地连接到GPU:

import torch

if torch.cuda.is_available():

device = torch.device("cuda")

print("GPU is available")

else:

device = torch.device("cpu")

print("GPU is not available")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

如果你成功连接到了GPU,那么上述代码将输出“GPU is available”。

注意,在Colab中,每个用户都有一个配额限制,即每个用户每次只能使用12个小时的GPU时间。如果你使用的是免费账户,则你的GPU性能可能会受到一定的限制。如果你需要更多的GPU时间或更强的GPU性能,你可以考虑使用Google Cloud Platform或其他云服务提供商提供的云GPU实例。

除了上述方法,还可以在Colab中使用以下代码来查看可用的GPU资源:

!nvidia-smi

- 1

这将显示当前可用的GPU资源,包括GPU型号、内存使用情况等。

如果你想在Colab中使用PyTorch来训练模型,可以使用以下代码将模型转移到GPU上:

import torch # 检查GPU是否可用 if torch.cuda.is_available(): device = torch.device("cuda") else: device = torch.device("cpu") # 定义模型 model = MyModel() # 将模型转移到GPU上 model.to(device) # 定义优化器 optimizer = torch.optim.Adam(model.parameters(), lr=0.001) # 定义损失函数 criterion = nn.CrossEntropyLoss() # 训练模型 for epoch in range(num_epochs): for batch_idx, (data, target) in enumerate(train_loader): # 将数据转移到GPU上 data, target = data.to(device), target.to(device) # 将梯度归零 optimizer.zero_grad() # 前向传播 output = model(data) # 计算损失 loss = criterion(output, target) # 反向传播 loss.backward() # 更新参数 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

在上述代码中,我们首先检查GPU是否可用,然后将模型和数据转移到GPU上。我们还定义了优化器和损失函数,并使用GPU进行训练。注意,我们在每个迭代周期中都需要将数据转移到GPU上,并在优化器的step()方法中更新参数。

最后,当你完成训练后,记得将模型转移到CPU上进行推断或保存模型。你可以使用以下代码将模型转移到CPU上:

model.to("cpu")

- 1

试试MMDet

OpenMMLab是一个由香港中文大学推出的开源深度学习工具库,包含了许多现代计算机视觉领域的重要工具和模型,如物体检测、语义分割、人脸识别等。在Google Colab上使用OpenMMLab,可以方便地进行计算机视觉方面的研究和开发。

下面是在Colab上使用OpenMMLab中MMDet的步骤:

-

在Colab中创建一个新的Python 3笔记本。

-

安装必要的依赖项和OpenMMLab:

!pip install torch torchvision !pip install mmcv-full==latest+torch1.9.0+cu111 -f https://download.openmmlab.com/mmcv/dist/index.html !pip install mmdet- 1

- 2

- 3

-

导入OpenMMLab模块:

import mmcv from mmdet.apis import inference_detector, init_detector, show_result_pyplot- 1

- 2

-

下载并初始化预训练模型:

!wget https://download.openmmlab.com/mmdetection/v2.0/fcos/fcos_r50_caffe_fpn_gn-head_4x4_1x_coco/fcos_r50_caffe_fpn_gn-head_4x4_1x_coco_20200229-4c4fc3ad.pth config_file = 'https://github.com/open-mmlab/mmdetection/tree/master/configs/fcos/fcos_r50_caffe_fpn_gn-head_4x4_1x_coco.py' device = 'cuda:0' model = init_detector(config_file, 'fcos_r50_caffe_fpn_gn-head_4x4_1x_coco_20200229-4c4fc3ad.pth', device=device)- 1

- 2

- 3

- 4

-

加载图像并进行预测:

img = mmcv.imread('https://github.com/open-mmlab/mmdetection/blob/master/demo/demo.jpg') result = inference_detector(model, img) show_result_pyplot(model, img, result)- 1

- 2

- 3

通过上述步骤,我们就可以在Colab上轻松使用OpenMMLab进行计算机视觉研究和开发。在Colab的云端环境中,由于可以使用GPU或TPU加速,以及与Google Drive和Google Cloud的集成,使得处理大型数据集变得更加方便和高效。

, result)

通过上述步骤,我们就可以在Colab上轻松使用OpenMMLab进行计算机视觉研究和开发。在Colab的云端环境中,由于可以使用GPU或TPU加速,以及与Google Drive和Google Cloud的集成,使得处理大型数据集变得更加方便和高效。

让我们一起在Colab中充分“白嫖”GPU资源进行学习吧声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。