热门标签

热门文章

- 1softmax交叉熵的两种形式 + numpy 实现_numpy softmax

- 2最新扣子(Coze)实战案例:图像流工具之创建一个精美的LOGO,完全免费教程_coze怎么建立图像流

- 3JavaScript中常用的正则表达式日常整理(全)_js 正则匹配 s*

- 42024年大数据大作业(课程设计)(1),每个程序员都必须掌握的8种数据结构_大型数据库课程设计csdn

- 5数据库期末复习_同类实体的属性构成

- 6基于Java的智能城市解决方案

- 72024年最全【算法学习】1863,字节跳动外包测试面试题_字节外包面试算法题

- 8甲骨文首次将LLMs引入数据库,集成Llama 3和Mistral,和数据库高效对话_heatwave genai

- 9记录一个深度学习项目如何独立构建虚拟环境_在部署深度网络时如何开启一个新的虚拟环境

- 10社区版idea 最右侧没有Database怎么办_idea社区版右侧没有database

当前位置: article > 正文

在预训练语言模型主流架构_主流的结构 因果解码器、前缀解码器和编码器解码器

作者:寸_铁 | 2024-07-02 16:47:51

赞

踩

主流的结构 因果解码器、前缀解码器和编码器解码器

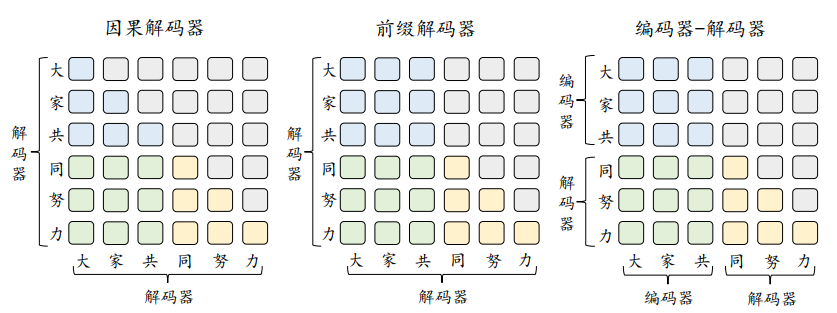

在预训练语言模型时代,自然语言处理领域广泛采用了预训练 + 微调的范式,并诞生了以 BERT 为代表的编码器(Encoder-only)架构、以 GPT 为代表的解码器(Decoder-only)架构和以 T5 为代表的编码器-解码器(Encoder-decoder)架构的大规模预训练语言模型。随着 GPT 系列模型的成功发展,当前自然语言处理领域走向了生成式大语言模型的道路,解码器架构已经成为了目前大语言模型的主流架构。进一步,解码器架构还可以细分为三个变种架构,包括因果解码器(Causal Decoder)架构和前缀解码器(Prefix Decoder)架构。值得注意的是,学术界所提 到解码器架构时,通常指的都是因果解码器架构。下图针对这三种架构进行了对比。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/寸_铁/article/detail/780262

推荐阅读

相关标签