热门标签

热门文章

- 1【设计模式学习笔记】模板模式、命令模式、责任链模式、策略模式案例详解(C++实现)_开发 模板 责任链

- 2mysql双层not exists查询执行流程_mysql not exist

- 3net472无法建立到信任_信任危机:一旦感情破裂,6种修复信任的方法

- 4(leetcode学习)236. 二叉树的最近公共祖先

- 5蓝桥杯——3.矩阵按键仿真实验_矩阵键盘蓝桥杯

- 6MAC 电脑里面的“其他”文件是什么占用了_archives文件夹可以删除吗

- 7使用idea的git将多次commit合并为一条_idea squash commit

- 8无线通信设计秘密一:跳频技术_跳频通信

- 9【微信小程序】自己的小程序跳转到京东小程序商品详情页_京东小程序怎么跳转京东app

- 1020220413力扣每日一题_力扣每日一题在哪里

当前位置: article > 正文

DeepSeek发布全新开源大模型,GPT-4级别能力 价格仅百分之一_deepseek-v2 开源

作者:寸_铁 | 2024-07-25 06:08:03

赞

踩

deepseek-v2 开源

最新国产开源MoE大模型,刚刚亮相就火了。

DeepSeek-V2性能达GPT-4级别,但开源、可免费商用、API价格仅为GPT-4-Turbo的百分之一。

因此一经发布,立马引发不小讨论。

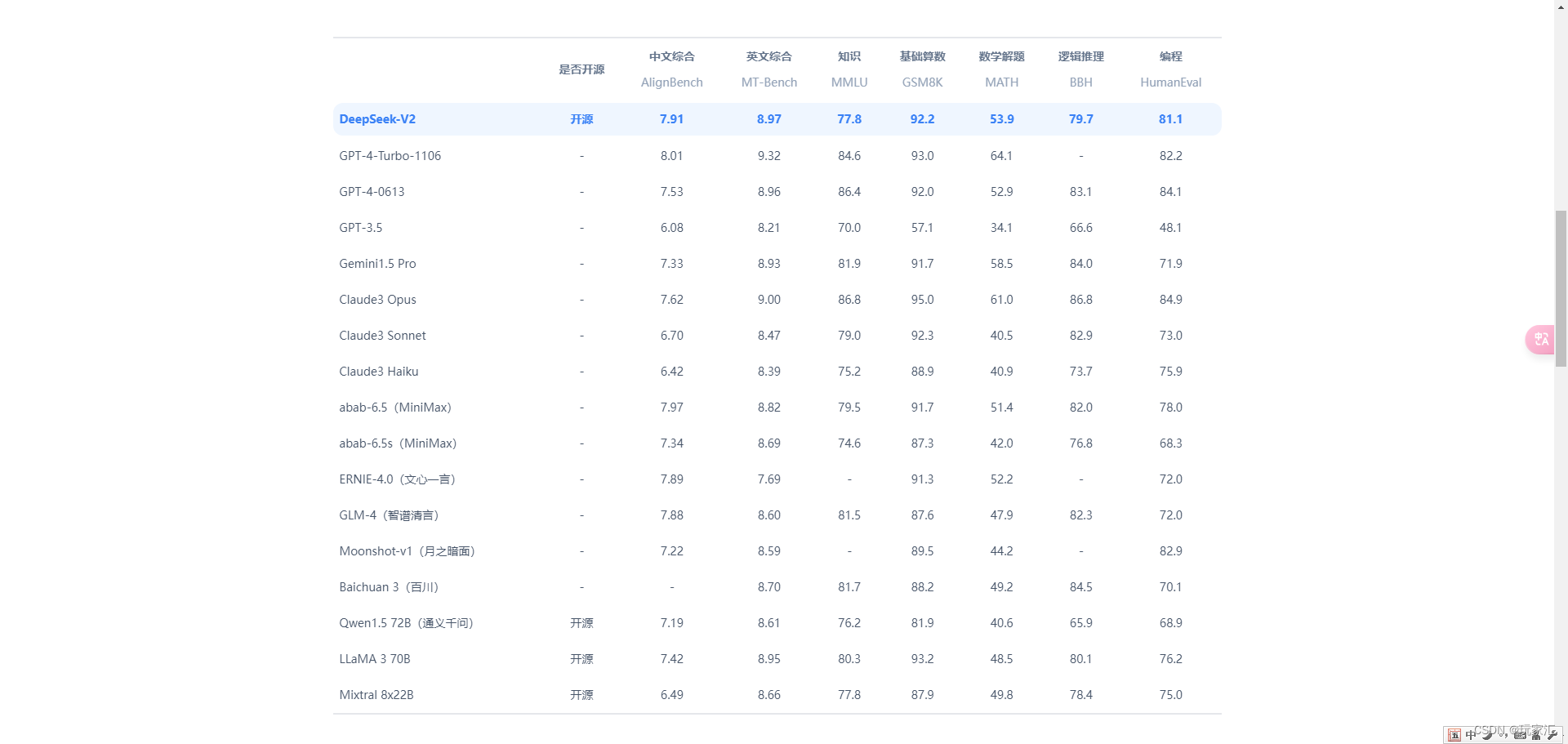

从公布的性能指标来看,DeepSeek-V2的中文综合能力超越一众开源模型,并和GPT-4-Turbo、文心4.0等闭源模型同处第一梯队。

英文综合能力也和LLaMA3-70B同处第一梯队,并且超过了同是MoE的Mixtral 8x22B。

在知识、数学、推理、编程等方面也表现出不错性能。并支持128K上下文。

这些能力,普通用户都能直接免费使用。现在内测已开启,注册后立马就能体验。

API更是是骨折价:每百万tokens输入1元、输出2元(32K上下文)。价格仅为GPT-4-Turbo的近百分之一。

同时在模型架构也进行创新,采用了自研的MLA(Multi-head Latent Attention)和Sparse结构,可大幅减少模型计算量、推理显存。

网友感叹:DeepSeek总是给人带来惊喜!

使用方法:

1.进入官网:DeepSeek

注册帐户,目前V2内测版可以体验通用对话和代码助手。

在通用对话中可以测试大模型的逻辑、知识、生成、数学等能力。

2.通过GoMaxAI系统,也可以直接调用DeepSeek V2模型

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/寸_铁/article/detail/878705

推荐阅读

相关标签